存储磁盘故障预测和性能容量预测技术

描述

随着“新基建”的逐步发展落地,现代数据中心迅速崛起,数据量呈指数级增长,同时各种新存储介质和技术的应用,使得存储系统变得越来越复杂。用户需要一套稳定、高性能且简单易用的存储系统。 AI技术可以解决存储系统使用的复杂性问题,提供简单易用、智能化的存储系统。AI会不断地从存储及其运行环境中采集存储的各种状态信息和性能数据,用机器学习算法分析,学习用户的存储使用情况,进而自动化的调整并优化存储系统,使存储服务能更好地适应用户的需求。有AI加持的智能化存储可以增强系统的可靠性,降低存储的复杂性和维护成本。 因此,在前期的文章中,我们提出”客户的未来,从AI加持的新存储开始”的观点,并介绍了存储AIOps的五大关键技术:监控、学习、预测、推荐、实施。 今天我们来具体探讨一下被客户重点关注的存储磁盘故障预测和性能容量预测技术。

1

磁盘故障预测和性能容量预测

给复杂的存储管理做“减法”

存储本身很复杂,数据中心环境和客户应用也很复杂,预测性分析技术是准确预测存储风险和故障,解决存储的复杂性的重要一部分。预测性分析技术是通过分析历史的日志、告警、报错等信息,AI算法可以自动分析出问题出现前的频繁出现的数据模式,之后在从正常存储系统上匹配这些AI学习到模式就能形成预测。 对于一个复杂的存储系统来说,用户关注最多的是硬盘、性能和容量的预测分析,磁盘故障预测和性能容量预测则成为两大关键功能。 为什么关注硬盘故障预测?

公开数据显示百度数据中心4年29万次硬件故障中,硬盘故障占比高达81.84%。对于传统的存储厂商来说,虽然磁盘的绝对故障率不高,但是在所有的存储部件中,如CPU、内存、主板、网卡、HBA卡、电源等,磁盘的故障率是最高的。

虽然传统存储有RAID、副本等机制,但是数据重建过程中使用了大量IO资源,这导致存储性能严重下降,而且重建时间很长往往以天计。因此,数据重建对客户的业务影响很大。如果我们可以提前预测磁盘故障,用户可以选择业务不繁忙的时间来重建数据,那么重建带来的影响可以忽略不计。同时,预测可以把突发事件变为计划事件,也降低了存储的维护成本。

为什么关注容量性能预测?

除故障外,用户在日常使用存储的过程中关注最多的就是容量和性能。系统容量不足会导致系统不可用,客户业务中断。性能指标主要指时延、带宽、IOPS,随着用户业务的发展,给存储带来的性能压力越来越大,性能不足会让客户的应用变慢甚至无响应。

利用AI技术,对存储的性能、容量变化趋势进行准确预测,一方面可以告知客户进行扩容、软硬件升级的时间点,另一方面也能提供存储规划的具体参考指标。

2

存储磁盘故障预测技术 同典型的AI系统一样,先对历史数据进行训练,生成AI模型,最后在新的数据到来时形成预测。具体说包括以下五个部分:输入数据、预处理、模型训练、优化集成和预测。对于软件系统来说关键点有:数据来源、算法选择和评估指标。

磁盘故障预测系统整体架构 数据来源

硬盘本身提供了SMART数据(Self-Monitoring Analysis andReporting Technology)。SMART是90年代定义的硬盘状态检测和预警系统的规范,提供了磁头、磁盘、电机、电路等硬盘硬件的运行数据。目前几乎所有的硬盘厂商都已经支持了该规范。下表列出了与故障相关的SMART值。

表1:故障相关的SMART值

绝大多数的厂商和科研院校都是基于SMART数据进行磁盘故障预测,且都取得了不错的效果。但是在2020年2月的存储顶会FAST(USENIXConference on File and Storage Technologies)上发表的最新论文表明,SMART再加上存储性能数据可以进一步提升预测准确率。作者采用了12个磁盘IO性能指标、18个服务器性能指标、4个位置信息,基于CNN和LSTM的AI算法实现了提前10天故障预测误报率0.5%、漏报率5.1%。我们期待着存储产品上能应用最新的技术来进一步提高预测的准确性。

算法选择

可用于磁盘故障预测的AI算法有很多,如传统算法决策树、经典的SVM(Support Vector Machine)、在各种竞赛上大放异彩的XGBoost(Gradient Tree Boosting)以及深度学习算法CNN和LSTM。实际效果及顶级会议KDD、ATC、FAST的论文实验结果都表明,XGBoost、CNN、LSTM的效果比传统算法有明显优势。

评价指标在完成了历史数据训练,故障预测之后,我们需要对预测的效果进行评估。表2描述了机器学习中标准的评价指标。

表2:机器学习模型评价指标

基于表2中的定义,评价磁盘故障预测的主要有准确率、漏报率和误报率:

准确率=:判定正确的盘(含好盘和坏盘)占所有盘的比例

误报率=:好盘被误判成坏盘占所有好盘的比例

漏报率=:没有识别出的坏盘占所有坏盘的比例

准确率高,误报和漏报低,是我们追求的目标。这相当于我们在发现几乎坏盘的同时没有把好盘误判成坏盘。但是从算法调优的角度看,误报率和漏报率是一对矛盾,误报率的降低会引起漏报率的上升,漏报率的降低会引起误报率的上升。对于同一个算法来说,如果误报和漏洞同时降低,很可能发生了过拟合现象,当换一类盘后,误报和漏报都会大幅上升。

3

存储性能容量预测技术 对于存储来说,性能和容量预测是两件不同的事情,都为客户带来不同的价值。但是站在技术角度,两者都属于数据挖掘中时间序列预测问题(Time Series Prediction)。时间序列,也叫时间数列、历史复数或动态数列。它是将某种统计指标的数值,按时间先后顺序排到所形成的数列。预测的基本原理是:统计分析过去的时间序列数据,形成拟合函数或者AI算法模型,以拟合的函数结果或模型来预测未来的趋势。

时间序列预测法可用于短期、中期和长期预测。造成时间序列数据发生变化的因素主要有以下四个:

趋势性:时间序列曲线呈现出一种缓慢而长期的持续上升、下降、不变的整体趋势。

周期性:由于外部的影响,随季节的交替,时间序列曲线有明显的周期性的高峰、低谷。

随机性:个别的数据变化为随机变动,但整体呈现出统计规律。

综合性:以上几种变化因素的叠加或组合。预测时可以过滤除去不规则的随机因素,最终展现出趋势性和周期性变动。

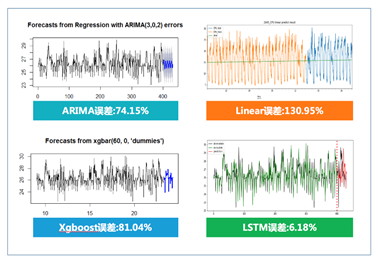

经典的时间序列预测算法有ARIMA、线性回归、深度学习算法等。这些算法有各自的优劣势,产品会根据不同的客户应用场景来选择不同的算法。下图展示了各个算法的实际效果。

时间序列算法效果比较

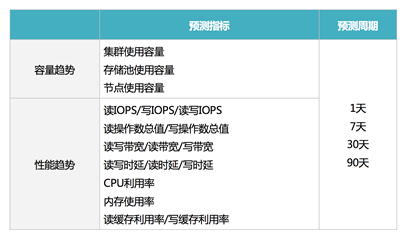

对于存储来说,除核心算法外,存储还有自身的容量和性能指标。表3列出了浪潮智能存储管理平台InView支持的未来1天、7天、30天、90天的3个容量趋势指标,15个性能趋势指标。

表3:浪潮存储性能容量预测指标

4

存储AIOps的产业落地浪潮智能存储管理平台InView 存储产业界中,作为新数据时代“新存储”引领者,浪潮存储推出了领先且独具特色的智能存储管理平台InView,提供了预测性分析、端到端的故障定位、性能洞察等一系列的智能化功能,帮助用户分析复杂应用环境下从虚拟机到后端存储端到端的性能瓶颈,确定影响性能瓶颈的主要因素,并最终给出可行的优化或解决问题的建议。 其中磁盘故障预测、性能容量预测的智能化功能,可以帮助客户预防硬件故障带来的损失,并给出具体的扩容建议,为客户提供更稳定、高性能、智能化的存储服务,使存储服务能更好地适应用户需求,同时降低存储的复杂性和维护成本。 注:感谢我的同事叶毓睿对本篇文章提供启发。

原文标题:【科技放大镜】AI加持,给复杂存储管理做“减法”

文章出处:【微信公众号:浪潮存储】欢迎添加关注!文章转载请注明出处。

-

Labview如何实现预测2016-05-03 0

-

预测2017-08-03 0

-

2019云计算七个预测2019-01-03 0

-

PaddlePaddle使用预测模型预测图片报错及解决方法2019-05-31 0

-

预测性养护让家电运行更长久2019-08-07 0

-

深度学习在预测和健康管理中的应用2021-07-12 0

-

智能电网预测负荷波动的影响2021-07-12 0

-

关于电机的深度学习故障预测简析2021-09-13 0

-

一种复合故障预测动态建模方法2009-12-14 727

-

多尺度混沌时间序列在载流故障预测中的应用_孟垚2017-01-08 631

-

支持向量机的故障预测模型2017-12-29 851

-

IDC预测2023年全球存储装机容量或达到11.7 ZB2019-02-23 1459

-

基于RNN的GIS故障预测算法及系统设计2021-07-01 516

-

磁盘存储器的存储容量怎么算2022-01-29 11969

-

详谈SSD故障预测技术2023-01-03 876

全部0条评论

快来发表一下你的评论吧 !