大数据分析中Spark,Hadoop,Hive框架该用哪种开源分布式系统

描述

众所周知,大数据开发和分析、机器学习、数据挖掘中,都离不开各种开源分布式系统。最常见的就是 Hadoop、Hive、Spark这三个框架了。最近不少朋友有问到关于这些的问题:

大厂里还有在用 Hadoop 吗?感觉都在用 Spark,有些慌!

SQL boy 大厂面试都问什么?Hadoop、Spark、Flink 都搞过!

听说百度只用 Hadoop,为什么不用业界都在用的 Spark !

为什么百度不用SQL支持数据处理,还在写一堆 Hadoop 脚本!

Java 开发需要对大数据了解多少,Hbase、Hive、Spark 这些吗?

不同的业务场景决定了不同的系统架构选型。Hadoop 用于分布式存储和 Map-Reduce 计算,Spark 用于分布式机器学习,Hive 则是分布式数据库。Hive 和 Spark 是大数据领域内为不同目的而构建的不同产品。二者都有不可替代的优势。Hive 是一个基于Hadoop 的分布式数据库,Spark 则是一个用于数据分析的框架。

这就要求技术人不得不掌握各种开源的技术框架。这就会造成顾此失彼,学完易忘、易混淆的情况。为了解决这个问题,这里推荐给大家一个高效学习和开发的宝藏:一份大数据/分布式开发速查表。内容涵盖:Spark、Hadoop 及 Hive 等日常工作中几乎所有的技术知识点。

对比详细却冗长的技术文档,速查表要显得更加便捷与直观。 可以帮大家很轻松的从上面找到具体某项技术的快捷命令与语法,相信能大幅提升开发效率,同时,一些遗忘的知识点也都能通过速查表来快速获取。

由于篇幅原因,下面只展示了速查表的部分内容。无论你是学习进阶,还是日后温习,这套速查表资料都值得好好珍藏。

1.大数据内存计算框架之Spark 必知必会

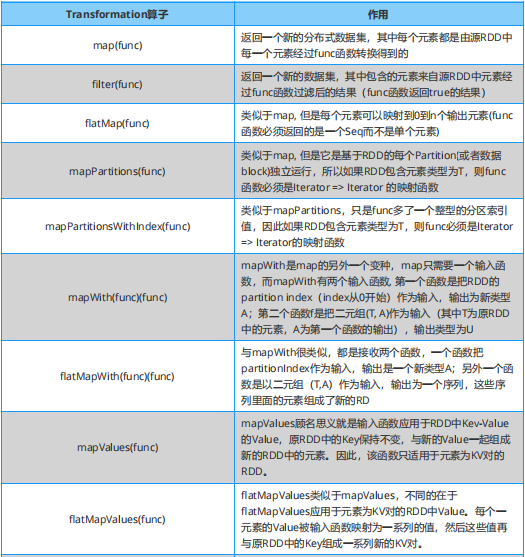

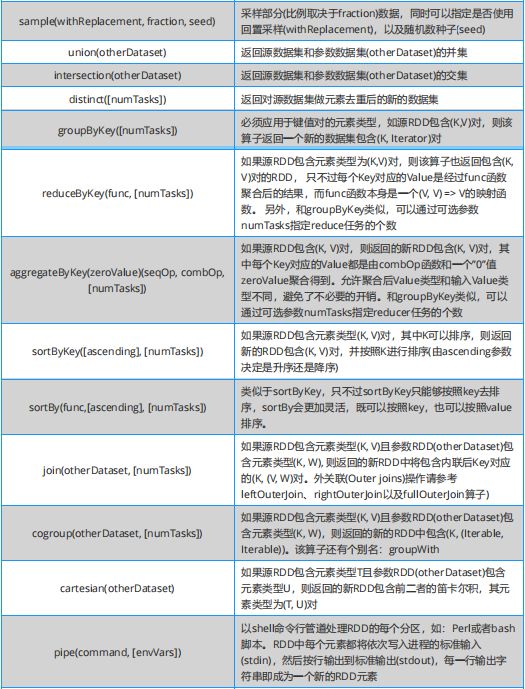

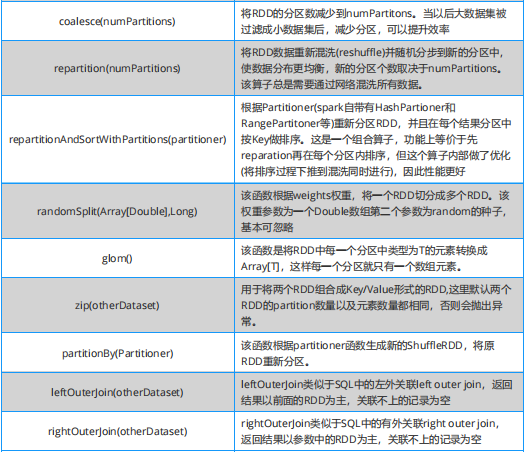

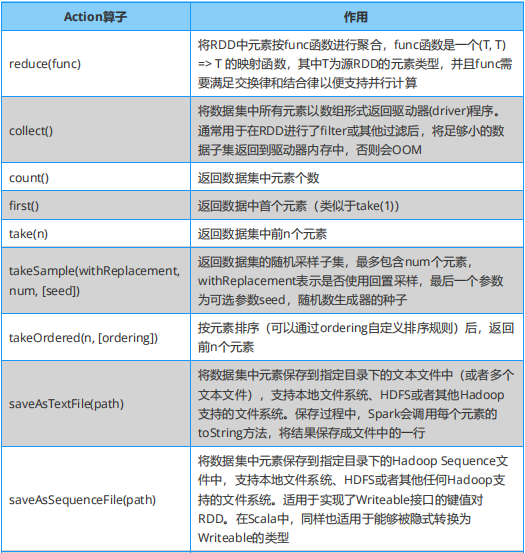

学习 Spark ,从大方向说,算子大致可以分为以下两类: (1)Transformation 变换 / 转换算子:这种变换并不触发提交作业,这种算子是延迟执行的,也就是说从一个 RDD 转换生成另一个 RDD 的转换操作不是马上执行,需要等到有 Action 操作的时候才会真正触发。 (2)Action 行动算子:这类算子会触发 SparkContext 提交 job 作业,并将数据输出到 Spark 系统。

Spark 必知必会:Transformation 算子

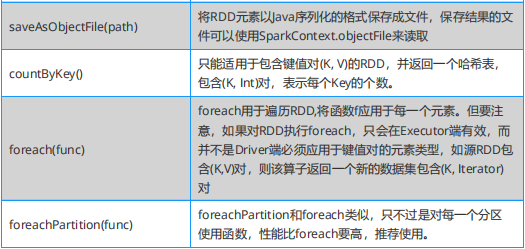

Spark 必知必会:Action算子

2.大数据分布式文件系统之Hadoop 必知必会

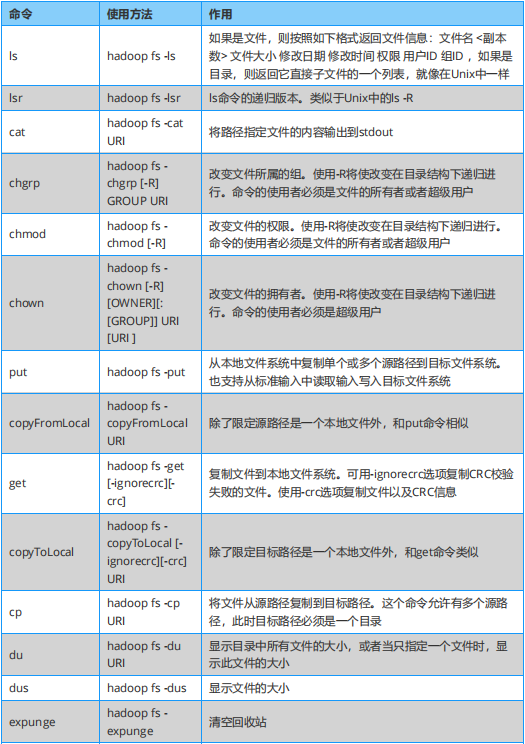

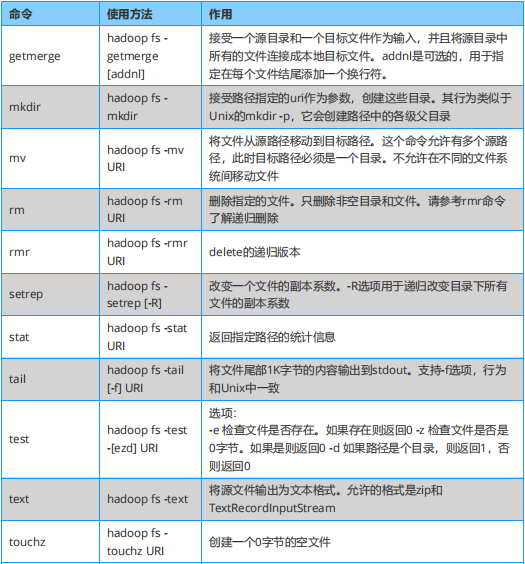

内容包括:Hadoop Shell ,HDFS 命令有 hadoop fs 和 hdfs dfs 两种风格,都可使用,效果相同。

Hadoop 必知必会:Hadoop Shell

3.大数据分布式数据库之Hive 必知必会

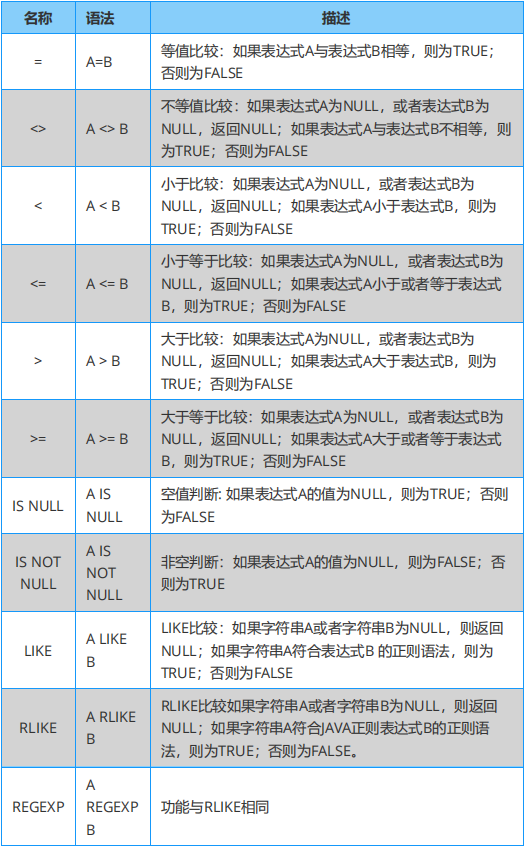

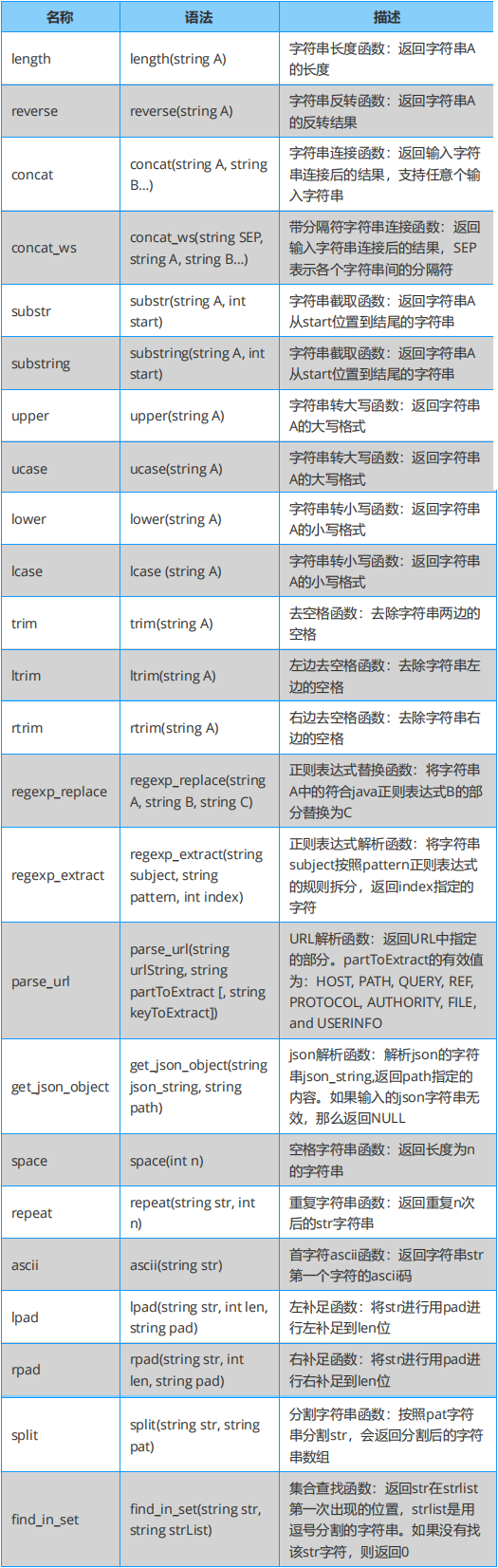

Hive 的本质是将 SQL 语句转换为 MapReduce 或者 spark 等任务执行,并可以针对数据仓库进行分布式交互查询。 内容包括:Hive 内置函数速查表 ,具体有关系、数学及逻辑运算符、数值计算、日期函数、条件函数、字符串函数、聚合函数、高级函数及窗口函数等。

Hive 必知必会:关系运算符

Hive 必知必会:数值计算

Hive 必知必会:字符串函数

原文标题:在百度,Spark,Hadoop,Hive ,哪个更香?

文章出处:【微信公众号:算法与数据结构】欢迎添加关注!文章转载请注明出处。

-

如何从零学大数据?2018-03-01 0

-

从零开始学习hadoop?hadoop快速入门2018-03-13 0

-

大数据运用的技术2018-04-08 0

-

大数据开发之spark应用场景2018-04-10 0

-

容器开启数据服务之旅系列(二):Kubernetes如何助力Spark大数据分析2018-04-17 0

-

大数据分析工具开发平台汇总2018-04-24 0

-

Hadoop的整体框架组成2018-05-11 0

-

大数据专业技术学习之大数据处理流程2018-06-11 0

-

hadoop不同版本有哪些2018-09-18 0

-

hadoop框架结构的说明介绍2018-10-15 0

-

DKHadoop大数据平台架构详解2018-10-17 0

-

DKHadoop大数据开发框架的构成模块2018-10-19 0

-

hadoop和spark的区别2018-11-30 0

-

大数据hadoop入门之hadoop家族产品详解2018-12-26 0

-

浅析hadoop集群集成Hive2019-07-15 0

全部0条评论

快来发表一下你的评论吧 !