神经网络技术解析:手写数字识别项目解读

描述

手写数字识别是很多人入门神经网络时用来练手的一个项目,但就是这么简单的一个项目,最近在 reddit 上又火了一把,因为在 MIT 计算机科学和人工智能实验室,有人挖到了一个「祖师爷」级别的视频……

这段视频录制于 1993 年,主人公是图灵奖得主 Yann LeCun(杨立昆)。彼时 LeCun 才 32 岁,刚刚进入贝尔实验室工作,而视频里机器学习识别的第一段数字 201-949-4038,是 LeCun 在贝尔实验室里的电话号码。 从这段视频中我们可以看到,LeCun 在 90 年代初创造的文本识别系统已经达到了惊人的速度和准确率,这在当时的条件下是非常难能可贵的。

这段视频由贝尔实验室自适应系统研究部门主任 Larry Jackel 拍摄(Larry 当时是 LeCun 的 boss,现任英伟达自动驾驶顾问)。视频中出镜的还有实验室负责人 Rich Howard(Larry 的 boss)和研究工程师 Donnie Henderson。Yann LeCun 本人表示:「Donnie Henderson 将整个演示系统整合在了一起…… 整套系统在算力为 20MFLOPS 的 DSP 版上运行。」

几位工程师在视频中洋溢的笑容也颇具感染力。

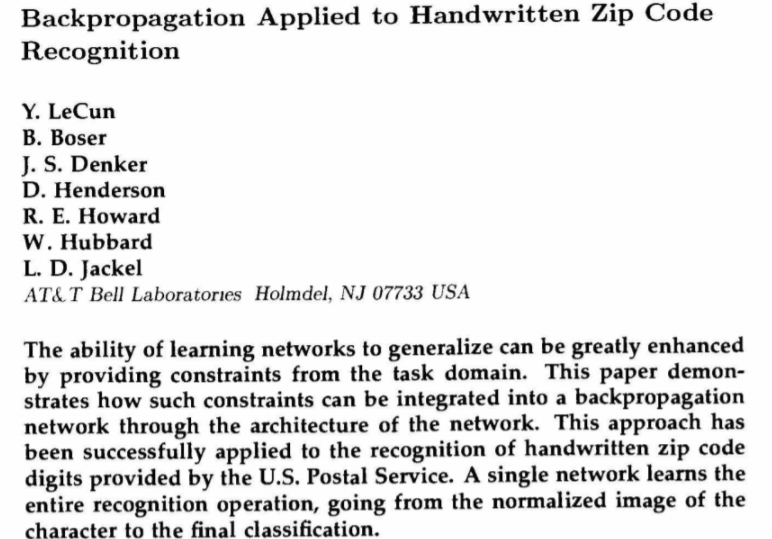

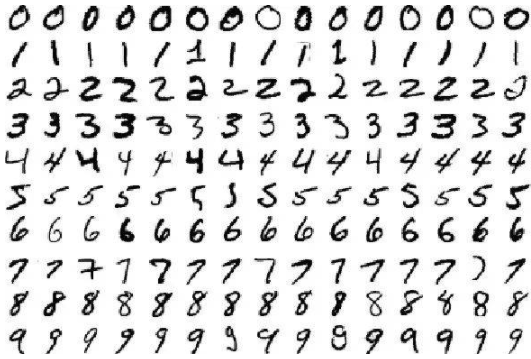

LeCun 表示,1993 年的文字识别系统已经用上了卷积神经网络(CNN),自己在这套系统中编写了一种网络数据结构的编译器,并生成了可编译的 C 语言代码,在源代码中以权重和网表(netlist)代表文字。 这段视频的惊艳之处还在于,它比经典手写数字数据集 MNIST 的问世还要早 6 年。

其实,早在 1989 年,LeCun 就已经发表了「将反向传播用于手写邮政编码识别」的相关研究,而且已经在美国的邮政系统中成功应用。随后,这一系统的应用范围扩展至银行支票。90 年代末期,该系统已经处理了美国 10%-20%的支票识别。

1999 年,LeCun 等人联合发表了「MNIST」手写数字数据集。这一数据集包含数万个样本,被称为「计算机视觉领域的 hello world 数据集」、「机器学习界的果蝇」,如今已经作为基准被使用了二十余年。

在看了这段视频之后,有研究者感叹,「不要再抱怨 GPU 算力不够了」。

深度学习先驱 Yann LeCun 说起 Yann LeCun,熟悉人工智能领域的人肯定不会陌生,Yann LeCun 现在是纽约大学教授、美国工程院院士、Facebook 副总裁和首席 AI 科学家。 在深度学习还未流行的 20 世纪八九十年代,LeCun 与另两位先驱者 Yoshua Bengio、Geoffrey Hinton 一道探索了深度学习领域的概念基础,并通过实验向人们展示了新方法的前景。此外,他们还贡献了一系列工程进展,展示了深度神经网络的实用优势。 虽然在二十世纪八十年代,研究者就开始试用人工神经网络帮助计算机识别模式、模拟人类智能,但直到二十一世纪的前几年,这种方式仍未获得广泛认同,LeCun 等研究者试图重燃 AI 社区对神经网络兴趣的努力曾经一直被人们质疑,但如今他们的想法带来了重大的技术进步,他们的方法也已成为该领域的主导范式。 自 2012 年以来,深度学习方法促进计算机视觉、语音识别、自然语言处理和机器人技术等应用领域取得极大突破。 在 2019 年,美国计算机协会 ACM 公布了上一年度的图灵奖,Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun 三位深度学习巨头同时获奖。

从左至右:Yoshua Bengio、Geoffrey Hinton、Yann LeCun。 ACM 表示,Yann LeCun 主要作出了三大贡献:

- 提出卷积神经网络

- 改进反向传播算法

- 拓宽神经网络的视角

20 世纪 80 年代后期,LeCun 就职于多伦多大学和贝尔实验室,也是在这一时期,他利用手写数字图像训练了第一个卷积神经网络系统。如今,卷积神经网络已成为计算机视觉、语音识别、语音合成、图像合成和自然语言处理领域的行业标准。卷积神经网络有着广泛的应用,如自动驾驶、医学图像分析、语音助手和信息过滤等。 这可不是搞定 MNIST 那么简单 与我们通常为 MINIST 数据集构建文字识别系统不同,Yann LeCun 在 1993 年展示的技术可是用摄像头直接拍摄的,还需要搞定文字缩放、位置等问题,后来也确实在邮政系统里获得了应用。 如此看来在当年就能实现这样的效果确实不容易,更何况在 20 世纪 90 年代,研究者们是没有 TensorFlow 可用的,全靠 C 语言手写,这个问题求解的非机器学习部分与其说是困难,不如说是繁琐。 在社交网络中,人们对 LeCun 展示的算法除了感兴趣,还有赞誉和膜拜,有人说道:「这并不是说他们在 1993 年就解决了 MNIST 上的问题,比那还要更进一步。」 在深度学习被 GPU 带动开展大规模应用以前,人工智能算法其实已经实现了相当的聪明程度。在 1993 年的文字识别之后,昨天,人们又挖出了 LeCun 参与的另一项研究:人脸检测。

在 2003 年,一个视频展示了 Rita Osadchy、Matt Miller 以及 Yann LeCun 等人在 NEC 实验室的研究,使用卷积神经网络进行人脸检测研究。 虽然只是人脸检测而不是人脸识别,但这种技术的意义不言而喻,如今自动驾驶汽车上的障碍物检测方法使用的就是和它相同的技术。在推特上,LeCun 也点赞了这段视频。

看来,如今我们在机器学习领域广泛使用的方法,早在几十年前就已完成了整体架构。 不过与此同时,也有网友发出了直击灵魂的提问:「既然 LeCun 在 1993 年就可以让 AI 这样识别文字了,为啥直到今天大多数网站仍然认为文字验证码是识别机器人的好办法?」

编辑:hfy

-

基于BP神经网络的手势识别系统2018-11-13 0

-

【PYNQ-Z2申请】基于PYNQ的神经网络自动驾驶小车2018-12-19 0

-

【PYNQ-Z2申请】基于PYNQ-Z2的神经网络图形识别2019-01-09 0

-

【PYNQ-Z2试用体验】基于PYNQ的神经网络自动驾驶小车 - 项目规划2019-03-02 0

-

【PYNQ-Z2试用体验】神经网络基础知识2019-03-03 0

-

【PYNQ-Z2试用体验】基于PYNQ-Z2的神经网络图形识别[结项]2019-03-18 0

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 0

-

解析深度学习:卷积神经网络原理与视觉实践2020-06-14 0

-

基于光学芯片的神经网络训练解析,不看肯定后悔2021-06-21 0

-

基于深度神经网络的激光雷达物体识别系统2021-12-21 0

-

人工神经网络手写数字识别系统的详细资料概述2019-05-27 956

-

谷歌向神经网络手写数字识别发起挑战,竟用量子计算识别2020-08-17 1435

-

使用PyhonFluxJulia实现手写数字识别的神经网络入门教程2020-12-08 571

-

手写数字识别神经网络的实现(1)2023-06-23 339

-

手写数字识别神经网络的实现(2)2023-06-23 489

全部0条评论

快来发表一下你的评论吧 !