云计算三大神器来了!

电子说

描述

最近又读了阿里巴巴的技术委员会的新书《弹性计算》,从序上看的确很新,2020年7月。在疫情这个年代,短时间内出版再次证明了中国人民的伟大。关于书中的内容,不想再多说。俺几个小时读下来,挑了几个错别字,以后找各位大佬领赏了。

其中印象深刻的是,为什么有神龙裸金属服务器,对RDMA的支持是一个关键的场景。在云计算中引入RDMA,目的也很明确-HPC。HPC是老黄的老巢,也是老黄现在整合网络,计算和存储的试验田。有了Mellanox,ARM加持,老黄提出了自己的口号:

CPU,做业务的编排,框架

GPU,做计算

DPU,数据的搬运和服务

不得不讲,老黄的市场部很强大,DPU就这样横空出世了。对比我司万能的P2P[1]的功能,我们就是简单说P2P,不知道的人以为我们就是个金融片子,悲催的我司没赶上匹凸匹的好时光。人家老黄不对称的P2P实现就有一个响亮的名字,GPUDirect。同样,老黄的Tensor Core也有一个土鳖的名字,DSP。

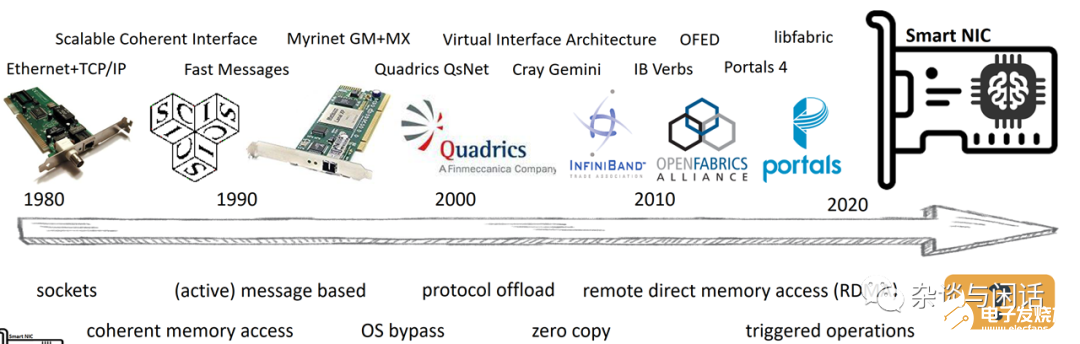

这里就来谈谈这个RDMA,RDMA的优势和劣势都很清楚。在过去的10几年中,mellanox作为另类的以色列公司持续投入了很多年。(大部分以色列公司的套路是第一代产品创新,卖公司。公司卖不掉,第二代产品就SoSo了,如果有第三代产品,可以真接pass了)。

在Flash刚刚进入数据中心的时候,大家都在考虑DAS到SANder问题,什么样的网络最合适。

其中试过PCIE 外接,AMD的HT,等等。就像一位做HPC出身的朋友讲的一样:“没几年就会冒出了一堆硬件公司,然后大家就上一把,然后大部分公司都死掉了”

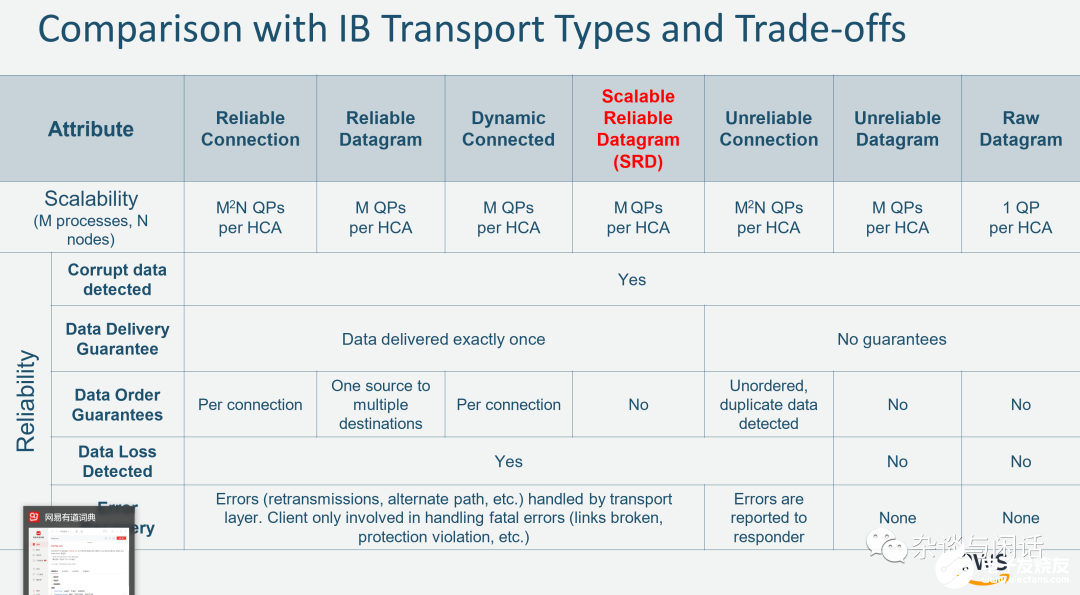

因此,可以看到IB versb在2010年成为主流,在HPC中目前已经已有疲态了,正是把这个HPC的专用技术用到hyperscale数据中心的好时机。

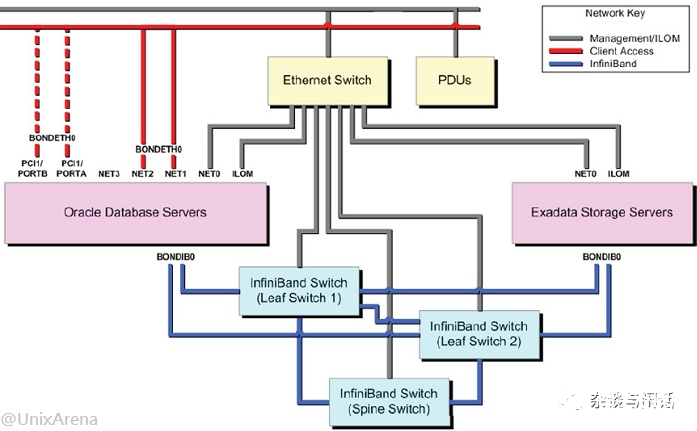

第一个规模使用IB而成功的案例是Oracle 的Exadata[1]

之后就是大量的SDS存储的公司起来了。Flash+RDMA是大家的标配。直到Microsoft在数据中心中规模部署。其实之前的RoCE本质上还是一个channel的协议,和之前的FCOE类似,只是在RoCEv2的时候,因为Microsoft的加持,从真正成就了Mellanox,同时把原来最擅长存储的Iwarp打进了小众市场,但是目前IBM和Netapp依然在坚守。

原来一个Intel的网卡大佬就很不服气,“我们做网卡快20年了,Mellanox的ethernet 网卡到现在都有很多功能不支持,但是他们咋就成了先进技术了,成了Smartnic呢?”。这样的话,当年EMC也说过Fusion-io这样的startup。

不管结果如何,Microsoft和Mellanox在Data Center Network的深度合作,让Mellanox在25G成功上位。取代了Intel和Broadcom在高端网卡的江湖地位。

当年在见识了Annapuna的EBS性能之后,我在加入新公司时就对大佬说要做RDMA,要做RoCEv2。但是大佬就是大佬,他们认为lossless的网络一直就是一个传说。而且,那个时候AI正在风口上。总之,这个事情也让我看清了一个事实,就是Hyperscale用RDMA,只会有两种配置:Mellanox的RDMA,以及他们自己的RDMA。

这个微软是最先这么考虑的,他们就是认为RDMA只有两种。微软内部实现的RDMA的细节很少有透露,知道的大佬欢迎分享。

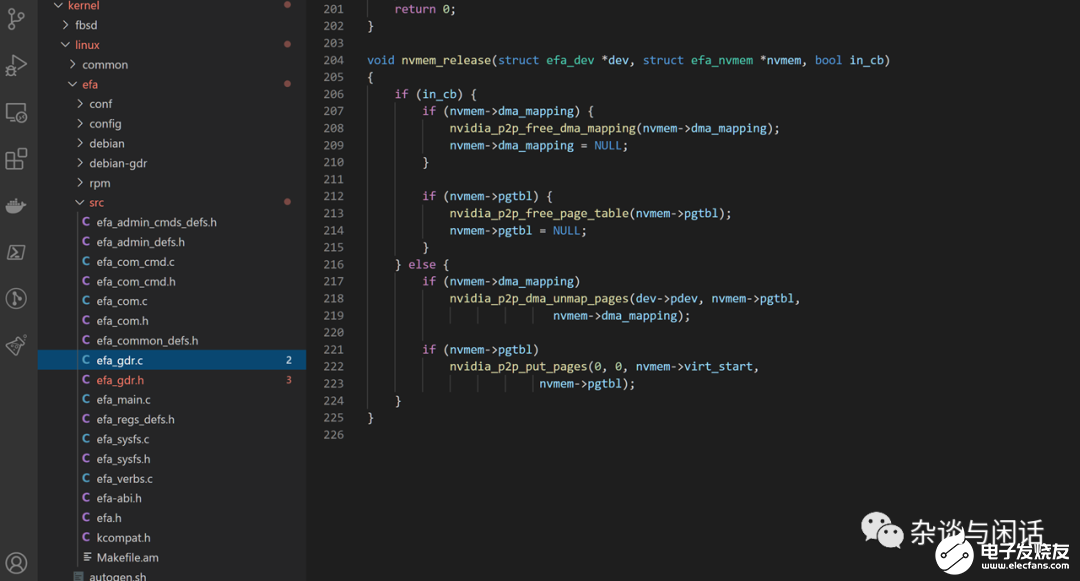

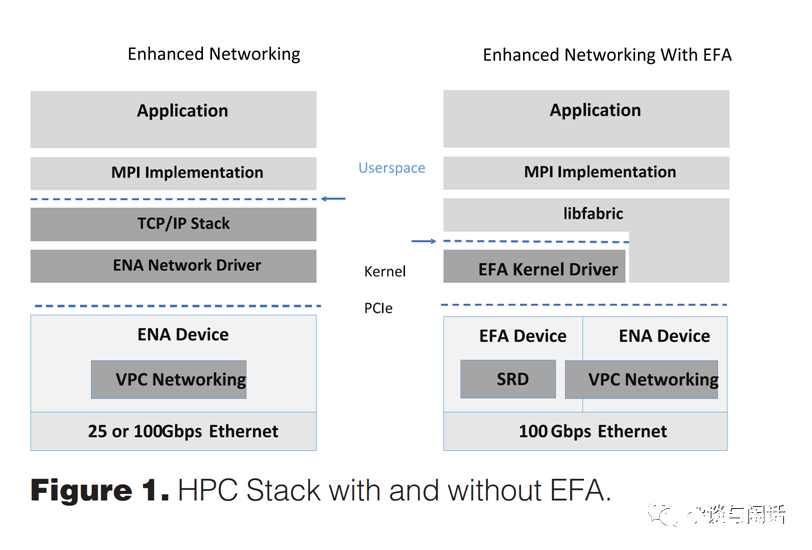

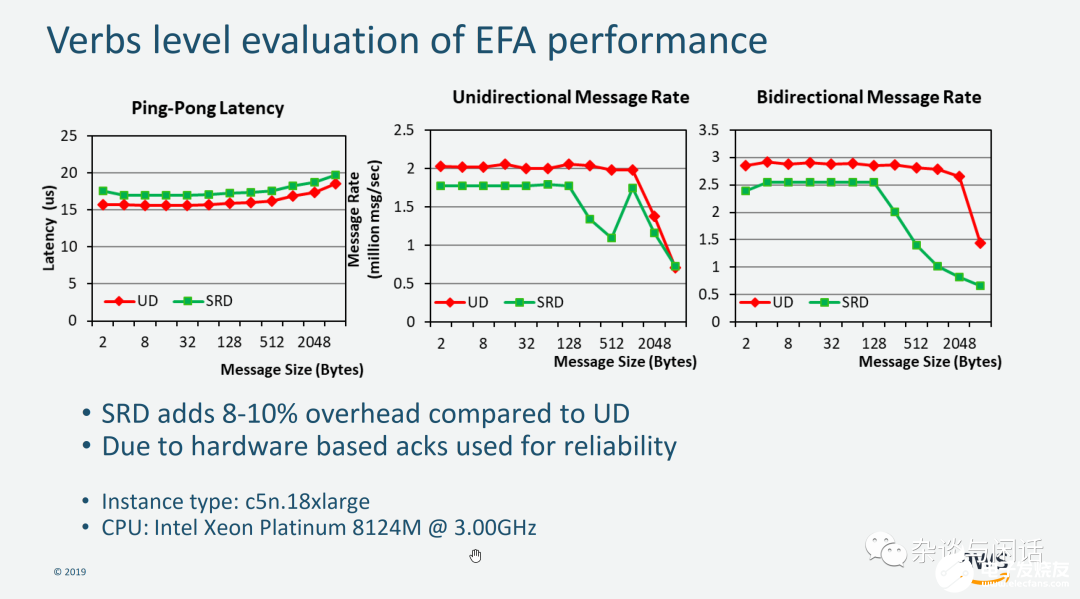

但是另一个大佬的AWS的RDMA就有很多细节。拿另一个常常教育我的大佬的话:“ 他们想做什么都在EFA的驱动里写着!!!“。在火焰图流行的这个时代,静态分析的确有点反人类。

比较好的是,作为HPC RDMA权威的熊猫教授率先被AWS的EFA招安,他们在SC19以及今年发表很多关于EFA的详细信息[2]。当然还有Annapurna CTO Nafea 同学的软文[3]

熊猫教授的一个学生做了Azure和AWS的RDMA性能的分析,因为过于敏感,自己关心的人可以去了解。但是以后估计每家大厂炫耀的资本里面会很快有一个:“我的RDMA是自研的,是XXXCloud特色的RDMA!”

--”老黄你怎么办呢?“

”DPU,DPU+GPU,DPU+GPU+CPU。。。。。。。“

--”Chiplets 要不要考虑一下?“

责任编辑:haq

-

什么是云计算 云计算的定义2009-11-18 0

-

云计算之:云计算的20个定义2011-07-13 0

-

云计算数据挖掘2016-04-19 0

-

别再提什么云计算,你需要的只是云服务2016-05-23 0

-

人云亦云?什么才是云计算2016-06-20 0

-

云计算未来的三个预测2017-07-05 0

-

什么是云计算?2017-08-09 0

-

有一种微信营销神器叫云控系统,有它吸粉引流不会累!2017-08-15 0

-

云计算的未来趋势及入门云计算介绍2019-06-19 0

-

什么是云计算,云计算的基本原理是什么2021-06-30 0

-

什么是云计算2023-04-21 0

-

北斗在列 中国八大神器震惊全球2016-07-11 2883

-

PCB参数计算神器分享2022-09-09 1066

全部0条评论

快来发表一下你的评论吧 !