为了到2025年实现采用AI的实时同声传译,日本正推进研究

电子说

描述

为了到2025年实现采用人工智能(AI)的实时同声传译,日本正推进研究。目前已完全可以实现语音识别,以后的目标是提高翻译准确率和速度。世界上有很多和日语具有相同特征的语言,如果能实现日语的同声传译,就有望推进国际性普及。

演讲者用英语做大约1分钟的演讲,背后的屏幕上显示出基于AI的日语同声传译。这是日本情报通信研究机构(NICT,注:日语的“情报”有“信息”之意)2020年11月举行的发布会上的一幕。从演讲者发言到出现译文大约需要10秒,但几乎没有翻译错误。

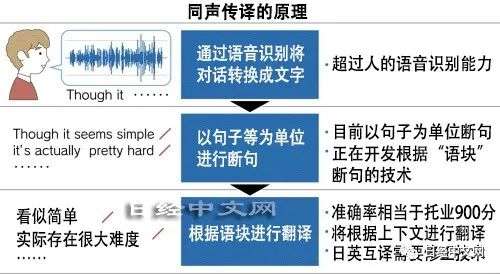

同声传译一般是对说话内容进行语音识别,然后由使用AI的翻译软件将其转换成其他语言。现有的服务大多是从说完话才开始翻译。因此,语速快的对话很难翻译,表达相同的内容时,同声传译所用时间是母语会话时间的2倍。按这样的水平很难用于商务用途,亟需可以克服这一缺点的技术。

现在同声传译的翻译准确率提高,但存在延时

日本情报通信研究机构通过2019年度之前的日本国家研究项目,已在语音识别方面实现了充分的性能。该机构的目标是从2020年度开始兼顾翻译准确率和速度。发布会上有10秒的延时,但今后有望缩小到跟同声传译人员相当的2、3秒。

日本情报通信研究机构开发的是在发言过程中就可以开始翻译的AI。断句的预处理技术是其中的关键。

翻译软件由断句的预处理和对句子进行翻译的翻译引擎构成。现有技术要想顺畅翻译,只能以句子单位进行断句,因此会有延时。如果在说完话之前就开始翻译,则可以缩短时差。

日本情报通信研究机构在预处理中采用按“语块”(chunk,或称:语义块)断句的方法,比以句子为单位断句翻译得更精准。专业的同声传译人员也使用这种方法。这样可以保证翻译准确度,并减少延时。

日本情报通信研究机构在开发中将使用大量的数据。该机构在2021年度末之前,将从同声传译人员等手中收集划分语义的位置及其译文的数据。2022年度将开发按照语义断句并翻译的AI。

与英译日相比,日译英的同声传译难度更高。因为断句的预处理比较难。

在日语中,动词及表示否定等的重要词语出现在句尾,因此需要预读,然后进行翻译。而动词等关键词语在句子前半部分出现的英语等更好翻译。在日语中,句子省略主语的情况也很多,AI要补充完整句子以后再翻译,因此容易出错。

为了防止误译,需要进行修正的技术。比如提前给AI提供演讲内容相关数据,让它进行学习,它就能够读懂后面要说的话,从而更准确地完成同声传译。

日本情报通信研究机构还将改进翻译引擎。通过日英、英日及所有语言翻译都使用的技术来控制翻译准确度。如果这项性能不高,即使预处理速度再快、修正功能出色,也起不到作用。

日本情报通信研究机构的翻译引擎除了市售的便携式翻译机以外,还被松下、NTT docomo及NEC等的语音翻译服务采用。该机构的研究员隅田英一郎自信地说“英日翻译准确率换算成托业考试(TOEIC)分数的话,相当于900分左右”。

在提高翻译准确率方面值得期待的是,得到美国特斯拉首席执行官(CEO)马斯克等人资助的研究企业OpenAI在2020年6月公布了语言AI“GPT-3”。这款AI可以写出跟人水平接近的比较自然的文章。

GPT-3利用巨大的“大脑”学习大量文件,获得了很强的能力。开发中使用的数据相当于数千亿词汇量。如果能在翻译引擎中应用GPT-3的系统,就有可能大幅提高性能。

围绕同声传译,全球的大型IT企业都在竞争,不过日本情报通信研究机构仍有胜算。隅田研究员指出“美国微软、中国百度及美国谷歌都是以句子为单位进行断句,以语块断句的方法尚未取得成果。都在同一水平上”。各公司都在下力气开发的中英语同声传译也跟日本情报通信研究机构开发一样,存在10秒左右的延时。

如果能实现日语翻成其他主要语言的同声传译,在国际上就会占据优势。

英语、中文及法语等使用人数较多的语言都是动词跟在名词后面的类型。占到全球语言的约4成。其实,世界上有一半语言和日语一样,把动词放在句尾。同类型的语言之间更容易实现同声传译。如果在不同类型语言之间的同声传译方面,能开发出优异的技术,则有可能应用于9成的语言。

责任编辑:xj

-

基于模式的实时音频流分割与控制系统2011-03-05 0

-

基于nRF24E1的无线同声传译系统的设计与实现2009-08-18 718

-

科大讯飞的AI同传造假行为遭曝光!2018-09-25 4203

-

百度推出AI即时翻译 同声传译要失业了?2019-02-26 1754

-

声智科技推出的同声转写技术,提升了各个行业的专业术语识别能力2020-06-28 3320

-

搜狗AI录音笔S1不仅仅是录音笔,它还是一位翻译大师?2020-07-31 586

-

讯维同声传译会议系统成功应用,采用全数字红外音频处理技术2020-10-12 1992

-

讯维同声传译系统的组成与分类2022-11-16 653

-

讯维红外同声传译系统的设备要求2022-11-16 638

-

同声传译会议系统成功应用于成都某国际会议中心!2023-08-09 338

全部0条评论

快来发表一下你的评论吧 !