最新HBM3内存技术,速率可达8.4Gbps,Rambus从IP到系统再到封装的全面优化

最新HBM3内存技术,速率可达8.4Gbps,Rambus从IP到系统再到封装的全面优化

描述

电子发烧友网报道(文/黄晶晶)近几年,数据中心、云服务以及物联网设备保持需求的高速增长。在大数据的处理方面,人工智能和机器学习(AI/ML)的使用率也将日益提升,预计到2025年,超过25%的服务器出货将会专供于人工智能领域。在AI/ML当中,内存和I/O带宽是影响系统性能至关重要的因素,这又促进业界不断提供最新的技术,去满足内存和I/O的带宽性能需求。

在英伟达、AMD的GPU/CPU芯片封装中,已经应用到了HBM内存技术,通过在一个2.5D封装中将GPU/CPU与HBM内存进行整合能够提升内存带宽、加速数据存储的速度,从而应对神经网络、AI训练等的内存带宽需求。据了解,燧原科技也在其GPU芯片中使用了HBM2技术,由Rambus提供IP支持。

现在,Rambus公司率先在业界推出支持HBM3的内存子系统,速率可达8.4Gbps,能够提供超过1TB/s的内存带宽,它的参数指标较HBM2实现了大幅的提升。

日前,Rambus IP核产品营销高级总监Frank Ferro,以及Rambus大中华区总经理苏雷接受包括电子发烧友网在内的媒体采访时,详解了Rambus HBM3-Ready内存子系统的亮点和市场。

Rambus于2016年进入HBM的市场,得益于之前在行业领域长期的专业知识累积,提供包括高速接口、芯片以及2.5D等复杂IP,从而在HBM市场保持领先。

Rambus HBM3的数据传输速率高达8.4Gbps/pin,带宽超过1TB/s,采用标准的16通道设置,可以达到1024位宽接口。能够支持市面上所有主流的供应商所提供的DRAM,并大幅提高整个产品的密度。除了针对AI/ML训练的市场之外,HBM3还可用于高性能计算及其他数据中心相关的主要应用场景、图形应用程序和具体网络应用。

HBM3达到8.4Gbps,提供更宽的设计裕度

从HBM性能的历史演进来看,最开始的HBM1,数据传输速率大概可以达到1Gbps左右; 2016年的HBM2,最高数据传输速率可以达到2Gbps;接下来是2018年的HBM2E,最高数据传输速率可以达到3.6Gbps。

今年海力士发布了HBM3产品,公开的最高数据传输速率达到5.2Gbps。尽管JEDEC尚未发布HBM3相关的标准,但是Rambus也推出了HBM3产品,并将最高的数据传输速率提升到8.4Gbps。

Frank Ferro表示,Rambus与美光、海力士、三星等厂商有着非常密切的合作,为这些DRAM厂商提供HBM PHY以及其他相关方面的支持。我们推出HBM3产品,目前为止在数据传输速率上比海力士更高,8.4Gbps的速率选择是出于未来产品规划的考量,同时也可以为客户和设计师提供更高的设计裕度,为未来的产品开发做好后续准备。

HBM3内存子系统的主要架构

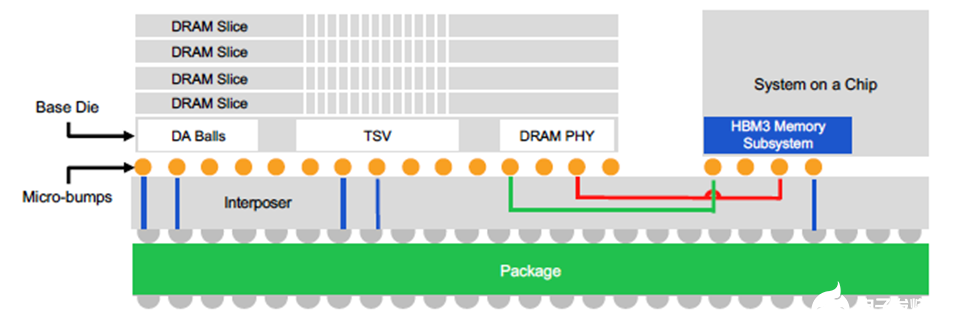

如下图所示,最上面有4块DRAM内存条,通过TSV堆叠的方式叠加在一起,下面是SoC,再往下是中介层,在中介层下面就是绿色的封装。这些部分组成了整个2.5D的系统架构。

作为一个完整的内存子系统产品,Rambus提供的并不仅仅是IP,同时也提供泛IP,以及整个系统的具体设计,包括经过验证的PHY以及数字控制器。此外,还会在中介层和封装上给客户提供更好的参考设计支持和框架,因为这些也是整个内存子系统领域非常重要的环节。

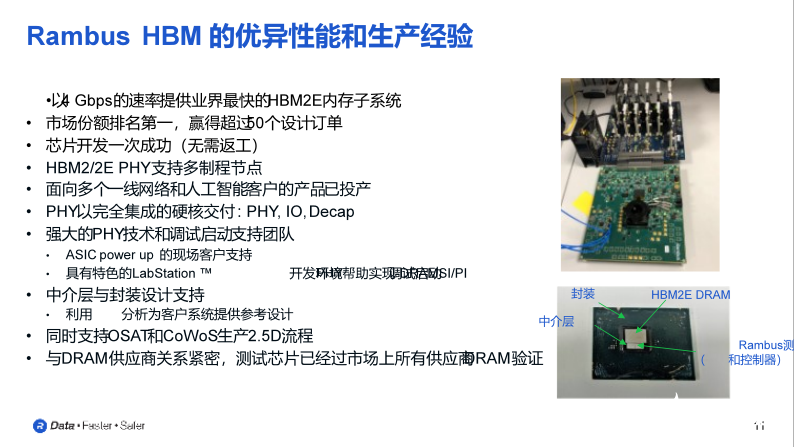

Frank Ferro表示,得益于在HBM领域多年的经验和专业知识,Rambus在市场份额上排名第一,同时已经赢得了超过50个设计订单,这些订单来自数据中心、ASIC的设计方等。目前为止,我们的控制器已经应用在了HBM市场超过85%的产品当中。

Rambus生产经验的支持

Rambus有着对HBM生产经验的支持,这里展示的一款测试芯片,集成了PHY和控制器,基于HBM2E的DRAM,数据传输速率可以达到4Gbps,到目前为止依旧是行业的最高水平。芯片开发一次成功,无需返工,支持台积电等晶圆代工厂的多制程节点。

Rambus的PHY产品通过完全集成的硬核方式进行交付,在交付之时已经包括了完整的PHY、I/O以及Decap,方便客户进行系统集成。

对于I/O设备产品来说,客户也需要厂商提供非常强大的技术以及相关的调试纠错支持,Rambus不仅可以将产品提供给客户,还可提供针对ASIC power up的现场客户支持,帮助客户进行现场纠错,实现更好的设备调试启动。

不同的提供商的生产2.5D流程本身也不一样,是一个非常复杂的过程,不仅需要提供用于生产中介层的硅产品,还有根据厂商各有差异的封装以及最后组装。而Rambus可以同时支持OSAT和CoWoS生产2.5D流程。

此外,Rambus与各大DRAM供应商有着非常密切的合作关系,测试芯片已经过充分的双向验证以及测试。

2.5D封装的挑战

当前HBM采用2.5D封装需要考虑两个主要的挑战:

Frank Ferro分析,第一,确保信号的完整性,包括与中介层之间信号的互联,这是非常重要的环节,也是我们首要考虑的挑战,这同时要求在整个封装系统上具备非常良好的控制程序。

第二, 2.5D封装整体的尺寸非常小,所以必须考虑可能产生的散热问题。不过HBM本身就是一个低功耗的解决方案,可以支持很大范围内的工作温度。

另外,Frank Ferro还指出,尽管目前HBM3的速率已经可以达到8.4Gbps,但对比GDDR DRAM已经达到16或者18Gbps的速率,还是有差距的。简单来讲,HBM发展的限制目前集中在中介层上。在HBM2的时代,中介层本身的技术是有限制的,即一代和二代的中介层最高只能做到两层,它设计的线宽、金属层的厚度都是非常有限的。HBM3的速率达到8.4Gbps,为此需要在中介层的设计上实现进一步优化。随着中介层技术的发展,其本身的厚度、金属层和线宽都有了一定的增加,这也推动了HBM未来的发展。

HBM3面向哪些应用领域

Frank Ferro解析,数据中心是HBM3最主要的应用场景,但随着设备越来越多的边缘化,HBM3也可能被应用在5G设备上,特别是那些对带宽有更高要求的5G设备。

另一个应用场景是AI/ML,现在AI/ML的数据很多时候需要上传到云端进行处理,然后再重新回到本地。所以HBM3未来在这个领域也有一定的应用前景。

最后是HPC,它也可以充分发挥HBM在功耗以及性能上的强大优势。目前为止,已经有一些客户开始与Rambus进行早期接洽,在这个领域展开具体的应用尝试。

Rambus在中国市场的动作

当前,中国在数据中心、云计算以及AI等领域都走在了世界前列,因此许多国外厂商更加重视中国市场。Rambus也不例外,苏雷表示,从去年开始,Rambus年度的Design Summit除了总部以外,中国是全球唯一单独举办的区域。围绕中国市场,Rambus已经规划了一系列的活动。例如,Rambus今年在全球范围内发布了CXL内存互联计划,将和中国的云服务商、数据中心、服务器OEM、ODM和内存公司等整个生态系统展开合作,以加快CXL内存互联计划的开发和应用、落地和发展。

据透露,Rambus的IP产品特别是HBM和GDDR6系列被业界广泛采用,覆盖一线的AI客户。另外缓冲芯片、DDR5市场也会和内存生态系统的合作伙伴开展合作。

Rambus在中国拥有强大的销售、市场、FAE和AE团队,并且还将持续扩大,做好长期耕耘,未来将用更好的产品和服务来践行Rambus“In China,for China”的承诺。

小结:

虽然目前JEDEC还没有正式发布HBM3标准,也很难去推测下一代HBM(例如HBM4)的性能,不过,Frank Ferro表示,整个行业对带宽的需求几乎是无止境、并且快速上升的。这也是Rambus将要持续进行的技术突破,以始终保持领先,从而不断满足市场的新需求。

本文为电子发烧友网原创文章,作者黄晶晶,微信号kittyhjj,转载请注明以上来源。如需入群交流,请添加微信elecfans999,投稿发邮件到huangjingjing@elecfans.com。

-

基于7nm打造的HBM3/DDR5内存技术参数公布2017-12-07 1570

-

Rambus GDDR6 PHY内存达18 Gbps 延续了公司长期开发领先产品的传统2019-11-15 919

-

高带宽内存突破4Gbps!Rambus独家内存接口方案发力AI和HPC市场2020-10-23 7620

-

Rambus推出支持HBM3的内存子系统,速率可达8.4Gbps,助力AI/ML性能提升2021-08-25 802

-

最新HBM3内存技术速率可达8.4Gbps2021-09-06 4461

-

HBM3万事俱备,只欠标准定稿2021-10-12 3621

-

HBM3万事俱备 只欠标准定稿2021-10-12 1439

-

新思科技推出业界首个完整HBM3 IP和验证解决方案,加速多裸晶芯片设计2021-10-22 3162

-

什么是HBM3 为什么HBM很重要2021-11-01 6899

-

SK海力士推全球最高性能HBM3E内存2023-08-22 660

-

创意电子宣布5nm HBM3 PHY和控制器经过硅验证,速度为8.4Gbps2023-09-07 326

-

Rambus通过9.6 Gbps HBM3内存控制器IP大幅提升AI性能2023-12-07 151

-

Rambus通过9.6 Gbps HBM3内存控制器IP大幅提升AI性能2023-12-07 412

-

AI大模型不断拉高上限,内存控制器IP提早部署,力拱HBM3E的到来2023-12-13 1047

-

什么是HBM3E内存?Rambus HBM3E/3内存控制器内核2024-03-20 897

全部0条评论

快来发表一下你的评论吧 !