MLPerf 3.0最新发榜,戴尔AI和边缘服务器拿下历史最好成绩

描述

北美时间4月5日,全球权威 AI 基准测试 MLPerf 3.0 最新结果正式公布,戴尔新一代AI与边缘计算服务器取得有史以来最好成绩:

数据中心赛道,戴尔新一代GPU服务器PowerEdge XE9680斩获3项第一、9项第二;

边缘计算赛道,戴尔PowerEdge XR系列边缘计算服务器拿下10项第一。

恭喜戴尔!

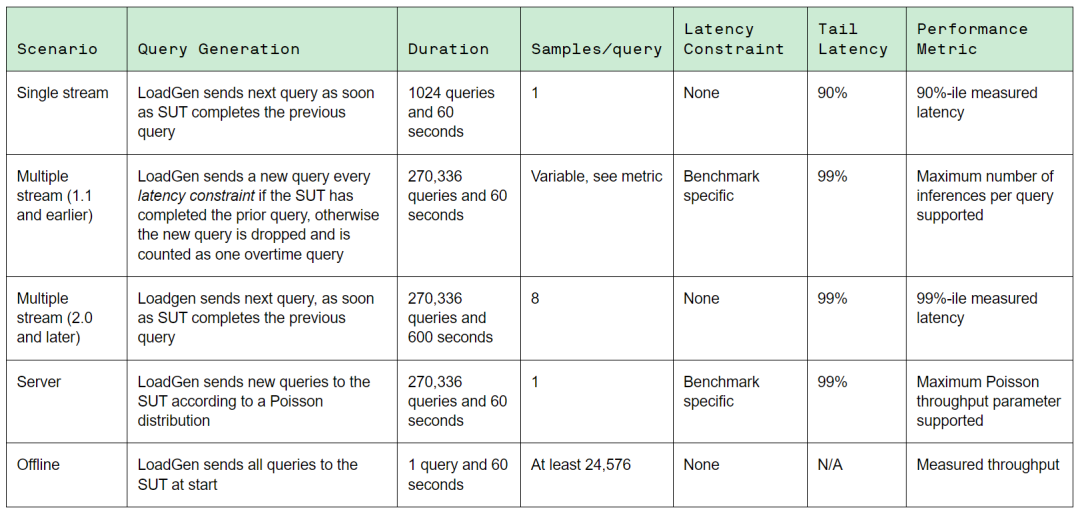

MLPerf由ML Commons联盟组织,是全球最知名、参与度最高的AI计算基准测试,包含Training(训练)和Inference(推理)两大领域。MLPerf选择AI各个热门领域的经典模型,在满足技术规范前提下(如训练精度、延迟等),对各大厂商的硬件、软件和服务的训练和推理性能提供公平的评估。

最新公布的AI推理基准测试MLPerf Inference v3.0,包含图像分类ResNet-50、目标检测RetinaNet、医疗图像3D U-Net、语音识别RNN-T、自然语言处理BERT-Large、推荐系统DLRM等6个模型赛道,汇集了来自全球25个厂商超过6700条性能数据,以及2400条性能功耗数据。

MLPerf Inference v3.0的AI业务场景

在此次MLPerf Inference v3.0测试中,戴尔提交了27种不同的服务器配置,共计255项测试数据。产品涵盖PowerEdge XE9680、R750xa、XR7620、XR5610等型号,参测的GPU型号包括NVIDIA H100、A100、A30、L4、T4、A2以及高通AI加速卡等,具有广泛的选型参考性。

数据中心赛道表现

在MLPerf Inference最受关注的数据中心基准测试(Datacenter closed)中,戴尔16G PowerEdge服务器XE9680首次亮相便斩获优异成绩。

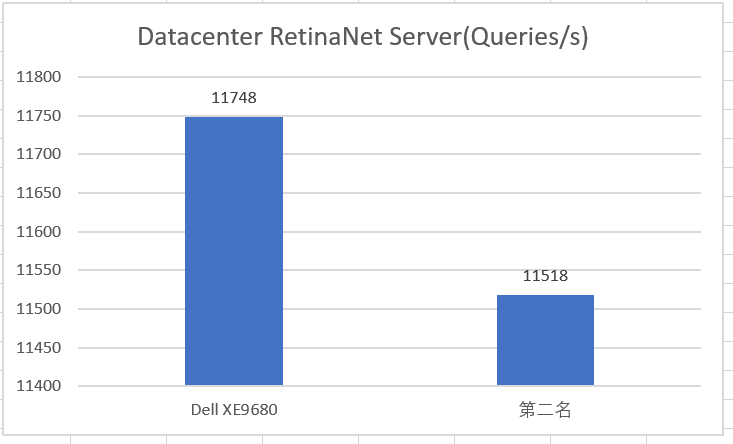

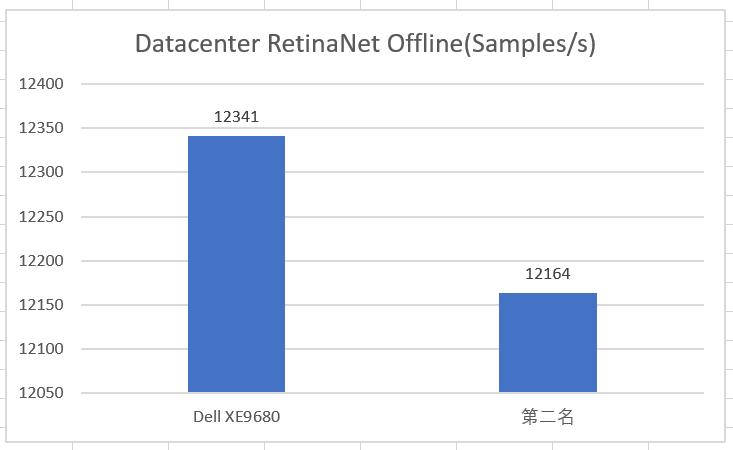

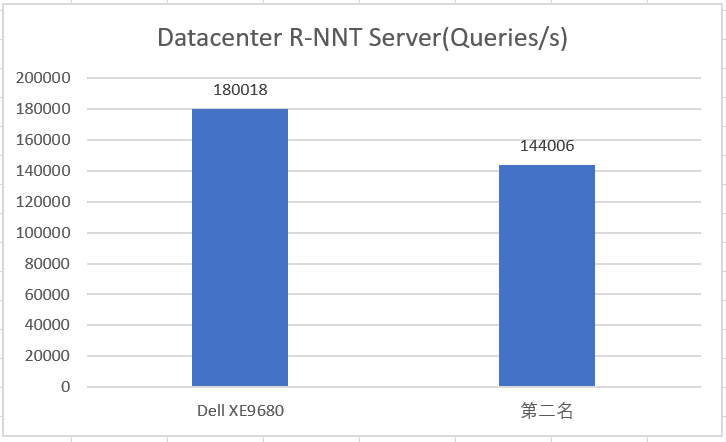

8卡H100配置的PowerEdge XE9680参加了12项测试,所有测试成绩均位居前2,其中在RetinaNet Server(目标检测)、RetinaNet Offine(目标检测)和RNN-T Server(语音识别)三个项目赛道皆拿下第1名的最优成绩。

Datacenter RetinaNet Server测试数据

Datacenter RetinaNet Offline测试数据

Datacenter R-NNT Server测试数据

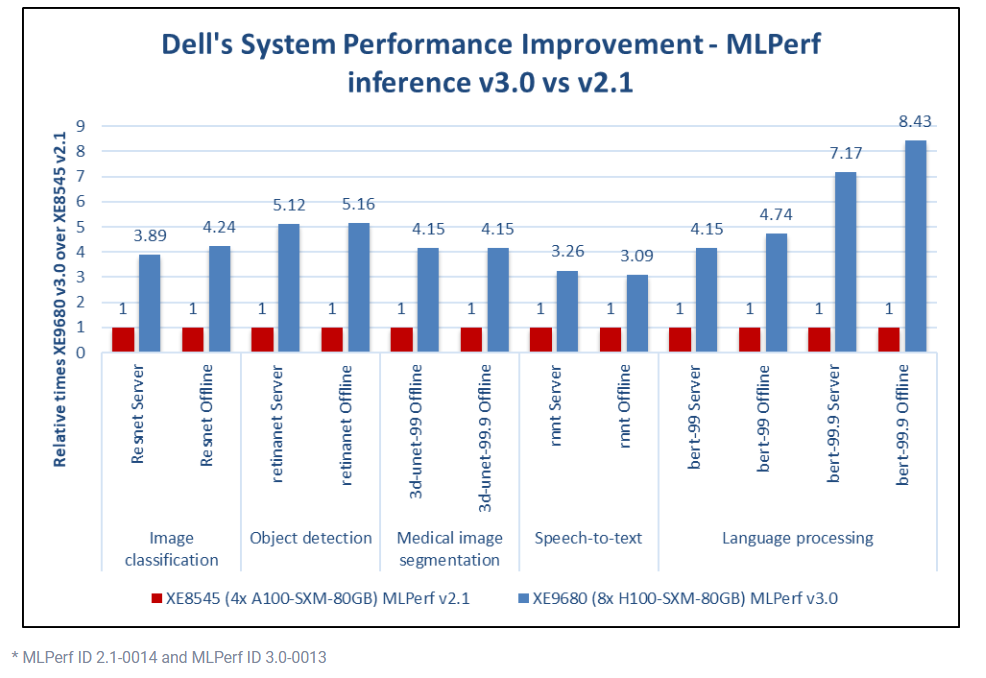

同上一期的MLPerf Inference v2.1相比,PowerEdge XE9680将Dell在各个项目的最好成绩分别提升了3倍-8.4倍。

戴尔的MLPerf Inference v3.0

与Inference v2.1成绩对比

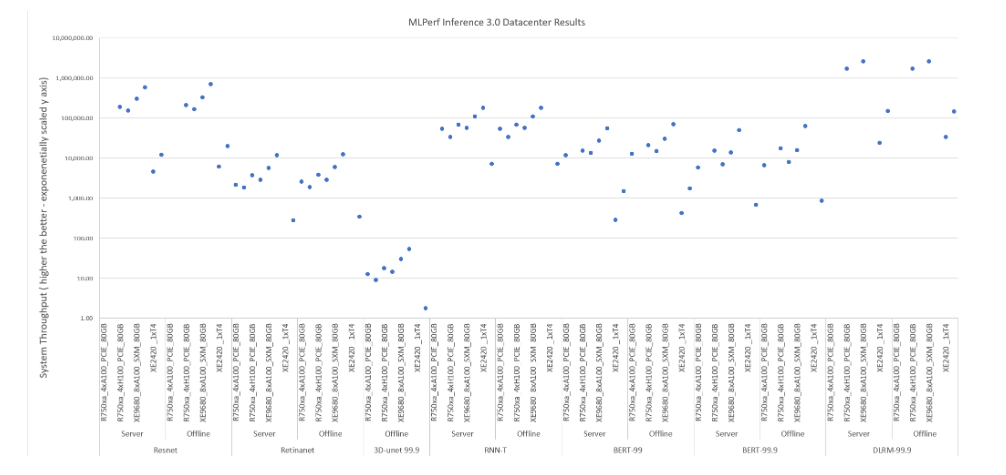

MLPerf Inference v3.0 Datacenter

全部Dell机型测试数据

边缘计算赛道表现

边缘计算是MLPerf关注的另一类AI推理的应用场景,有别于数据中心对极致算力的最求,边缘计算场景对于计算设备部署的环境要求更加多元化,也更加看重计算设备的功耗与成本。因此,在满足AI计算吞吐和延迟性能要求的前提下,提供更高性价比以及性能功耗比的AI计算解决方案,是戴尔在边缘AI计算重点关注的内容。

在此次MLPerf Inference v3.0 Edge closed power测试中(主要衡量边缘AI计算的性能功耗比),戴尔XR系列边缘计算优化服务器在全部14项测试中取得了10个项目的最佳成绩。其中, PowerEdge XR5610边缘计算优化服务器搭配NVIDIA最新发布的L4 GPU,取得9个项目第一,PowerEdge XR4000搭配NVIDIA A2 GPU,在BERT 99 Offline项目中取得了最佳成绩。

* Dell XR5610参加的9个项目分别是ResNet Single Stream、Resnet Multi Stream、RetinaNet Single Stream,、RetinaNet Offline、3D-UNet 99 Single Stream、3D-UNet 99 Offline、3D-UNet 99.9 Offline、RNN-T Single Stream、BERT-99 Single Stream。

PowerEdge XR5610

PowerEdge XR4000

NVIDIA L4是一款单宽GPU加速卡,专为AI视频和生成式AI用例而设计,较上一代GPU实现了2.7倍的生成式AI性能提升。Dell PowerEdge服务器在今年一季度开始提供对L4的选型支持。

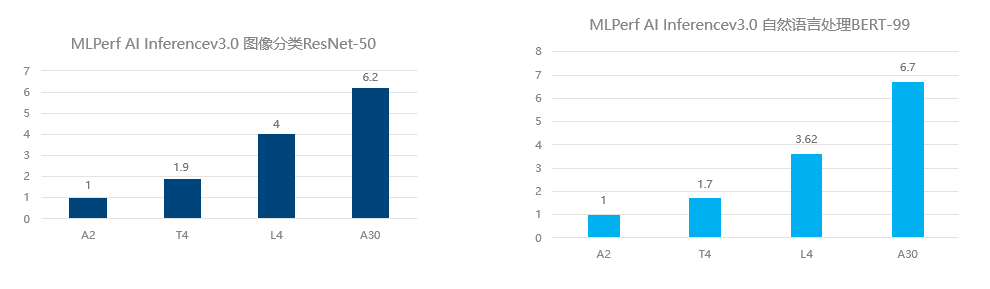

以此次AI Inference v3.0 Edge的测试项目中的图像分类ResNet-50与自然语言处理BERT-99为例,L4的推理计算性能分别达到T4的2.1倍和2.13倍。而同A10相比,L4绝大多数的规格指标与A10非常接近,功耗却不到其一半,同时实现了大量成本节约。L4的发布,将成为未来AI推理计算具备高竞争力的GPU选型。

L4与T4 AI推理性能对比

当下,ChatGPT带动了全球对AI大模型以及基于AI大模型的AIGC(人工智能内容生成)的关注与投资热潮。与之前的AI小模型相比,以ChatGPT为代表的大规模预训练模型,参数规模增加了100倍-1000倍。训练如此庞大的AI大模型需要更大的AI计算集群,以及更多的训练数据集。

以OpenAI的GPT为例,GPT-3拥有1750亿参数,2020年GPT-3发布时训练该模型使用了超过10000张NVIDIA GPU卡。而根据第三方测算,如果使用1024张A100/A800 GPU训练GPT-3,仍然需要超过一个月的时间。

随着AIGC时代的带来,人工智能产业化对于AI算力的需求将被带到一个新的高度。在本次MLPerf Inference v3.0测试中取得优异成绩的PowerEdge XE9680戴尔专为复杂计算和 AI/ML/DL 以及 HPC 密集型工作负载而构建,可以快速开发、训练及部署像ChatGPT这样的大型机器学习模型,助推更多AIGC场景快速落地。

PowerEdge XE9680

此外,AI与边缘的融合是未来AI计算的趋势之一,越来越多的AI计算负载特别是AI推理计算将会出现在边缘侧。边缘端IT设备的部署环境千差万别,有的时候很难像核心数据中心拥有同样完备的机房环境,可能会面临更加复杂、恶劣的设备运行环境。

戴尔XR系列服务器对于高温、低温、海拔、防尘、抗震的运行环境有更强的适应能力,通过了电信和海事行业标准。机箱深度通常只有通用机架服务器的一半左右,机器外形更加精巧紧凑。

此次参加AI Inference v3.0 Edge项目测试的XR系列服务器,是戴尔科技专为面向边缘计算场景设计与优化的服务器,此前已发布了XE2420、XR12、XR11、XR4000等产品,今年陆续会有更多新品发布,请大家拭目以待!

-

NVIDIA 在首个AI推理基准测试中大放异彩2019-11-08 0

-

软硬件协同优化,平头哥玄铁斩获MLPerf四项第一2022-04-08 0

-

戴尔推出PowerEdge服务器2010-03-23 694

-

随着AI的兴起 服务器市场也将迎来挑战2019-12-27 647

-

浪潮AI服务器NF5488A5一举创造18项性能纪录2020-10-23 1834

-

浪潮AI服务器2020年上半年的销售额达6.88亿美元2020-11-05 2399

-

大华股份AI刷新了Cityscapes数据集中语义分割任务的全球最好成绩2020-11-05 4155

-

进入容器,即开即用:NVIDIA和VMware为企业提供大规模AI服务2021-10-08 1587

-

戴尔新一代PowerEdge边缘服务器2023-05-06 455

-

AI服务器与传统服务器的区别是什么?2023-06-21 1772

-

什么是边缘服务器?边缘计算的未来如何?2023-07-31 916

-

中文大模型测评基准SuperCLUE:商汤日日新5.0,刷新国内最好成绩2024-05-21 658

-

耐能推出最新的边缘AI服务器及内置耐能AI芯片的PC设备2024-06-05 530

-

戴尔上调年度业绩预期,AI服务器需求强劲推动股价上涨2024-08-30 764

-

戴尔科技VS惠与科技:谁是美股AI服务器领域更好的投资选择?2024-09-23 179

全部0条评论

快来发表一下你的评论吧 !