英伟达的破绽

描述

看到夏core写了篇 夏晶晶:谈一下英伟达帝国的破腚(来源:知乎),决定蹭个热度,讲点不一样的看法。LLM的出现以及NVidia暴涨的股价和销量确实让很多人重新思考AI芯片的机会。夏core提到了很多个点都很有道理,比如关于GPU成本的分析,再比如最后战略视角去看,产业利润分配的不均是最大的破绽。不过战术层面的想法还是有些问题的。

比如LPDDR和HBM卷成本,如果考虑的是$/GB,那LPDDR确实有优势,但如果考虑的是$/GBps,HBM还是最具性价比的选择。而LLM虽然对内存容量有比较大的需求,但对于内存带宽同样有巨大的需求。单纯容量的话,CPU内存可以轻轻松松堆好几TB,比GPU便宜多了。LLM的参数和kv缓存都是实打实的内存容量占用大头,而这些参数在每一轮forward的过程都全部要用一遍,这也就意味着你把内存里的数据都读出来一遍要多久(即内存的容量和带宽比)反而是最重要的。而扩内存带宽一定需要增加DRAM bank数量从而等比扩内存容量,但扩内存容量可以把多个bank挂到一个通道上不增加内存带宽,所以算成本的时候关键要看$/GBps,这方面HBM是最具性价比的选择。

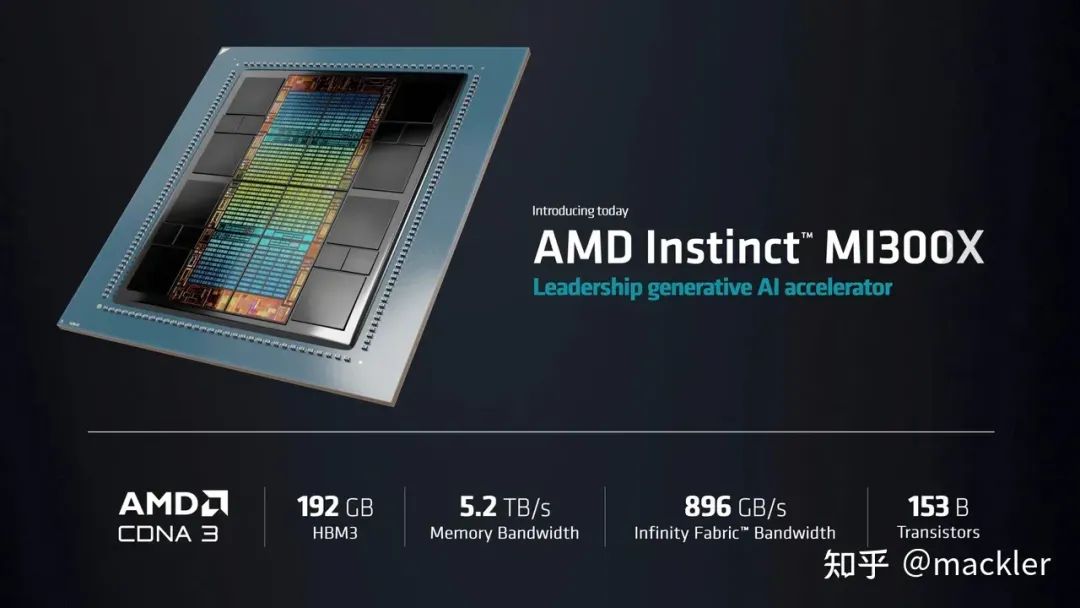

至于夏core提到的扩互联带宽,利用NVidia被美国出口管制卡带宽的机会,确实是一个好的路子,但我觉得更重要的点在于,在LLM的游戏规则下,内存容量、内存带宽以及互联带宽成了最核心的竞争力,而算力的重要性下降了,这才是NVidia战术层面最大的破绽。你看,AMD发布MI300X可是对算力指标提都不提,只提内存容量、内存带宽以及互联带宽。放在之前的AI芯片发布会上是完全不可能的事情,去年的时候大家都还在拼命吹算力指标。

Intel规划的2025年的Falcon Shores GPU也规划了288GB内存容量和9.8TB/s带宽,我们先不考虑Intel会不会继续跳票的问题,至少内存容量、内存带宽以及互联带宽成了最核心的竞争力这一点,几家半导体头部大厂都是达成共识的。

那这为什么又是NVidia的破绽呢?因为内存容量、内存带宽以及互联带宽都是标准化的,而算力是非标准化的。算力的非标准化是NVidia在过去十年最大的护城河,因为TOPS和TFLOPS是不一样的,SIMT算力和DSA算力也是不一样的,甚至AMD算力和NVidia算力也是不一样的。过去AI芯片的核心竞争力在于算力,为了卷算力指标,有些厂商在TOPS和TFLOPS上玩花活,有些厂商在SIMT和DSA上玩花活,即使SIMT厂商,也需要在SIMT算力的具体实现上玩花活,不然难以对NVidia的算力指标产生竞争力。而这些花活的代价就是算力的非标准化,从而形成了CUDA深厚的护城河。

看过我之前文章的朋友都直到我在过去好多年都是在探讨如何构建一个有竞争力的DSA算力范式,因为要在算力上竞争过NVidia,一方面要有对算力指标的需求来覆盖算力迁移成本,这个在过去是成立的。另一方面需要有一个和NVidia的CUDA算力相比有竞争力的算力范式,而算力的显性指标是TFLOPS,隐性指标是达到TFLOPS的开发时间成本(也就是易用性),我过去很多关于SIMT算力和DSA算力在编译器层面的探讨都是围绕解决最后一环展开的,因为这是在过去的需求和市场条件下干老黄的唯一途径。

但现在算力指标的重要性下降,前面这种干老黄的路径的基础逻辑崩塌了,对算力指标的需求下降了,覆盖算力迁移成本的动力是更不足的,但一个更有潜力的干老黄的路径出现了。

算力指标重要性的下降使得大家可以放弃在算力范式层面玩花活搞竞争力,转而去追求内存容量、内存带宽以及互联带宽的花活,这个层面玩花活的好处是他最后的指标是标准化的,只要你的花活真的能把这些指标怼上去,没有太多隐性的护城河卡着你。而算力方面则可以尽量做到标准化,照着事实标准去做就行了,哪怕指标差一点,但堆到几十TFLOPS的CUDA算力和几百TFLOPS的矩阵算力其实都是可以做到的。

这时候通过市场对于大内存带宽、大互联带宽的需求来覆盖算力迁移成本,同时又通过算力标准化来降低这个迁移成本。更进一步,现在大模型训练、推理、部署的系统软件也正处于蓬勃造轮子的时期,处于大量新增代码的积累阶段,一系列全新的生态位正处于形成过程中,一个超大容量和带宽的准标准化算力是有足够卡这些全新生态位潜力的。

此外,夏core文章最后讲的战略层面的破绽产业利润分配的不均也是蕴含在这背后的。

天下财共一石,老黄独占八斗。

这是对全天下IT产业的伤害,包括TSMC,一个健康的产业,其整个环节是需要一个合理的分配比例的,你要说Logic制造的技术含量最高,但是分成的收益却不到1%,这种分配关系不足以长期维系,tsmc的工艺演进是需要钱的(靠的就是大家共筹,利益均分),如果全世界IT就这么多钱,英伟达你是可以通过系统优势拿走更多,但产业链中tsmc及其他各个环节就会更加艰难。三星的HBM其实同理,操了白粉的心,卖个白菜的价,不值得。

在LLM重新创建的边界条件下,最大的需求HBM却卖了个白菜价,只因老黄提供了事实标准的算力把这些内存带宽连起来就吞了九成以上的利润,这种不健康的产业利润分配其实给广大造反者提供了巨大的机会,毕竟一个准标准化的算力谁不会造(chao)呢?

当然了,鸡血打完也还是要泼点冷水。首先这些道理老黄肯定比我们都有更深刻的认识,处于守势的老黄其实有很多见招拆招的手段。夏core提的通过美帝的出口管制反向卡老黄的互联带宽,其实AMD的形态就是老黄可以破解的方法。如果老黄能在一张卡里就把大模型全部塞进去,大互联带宽最主要的需求就破解了,剩下的都可以靠其他并行模式以及广大程序员优化出来,你互联带宽大任你大,我一堆“超大卡”之间卡着出口管制的带宽也能把系统跑满。

老黄最大的优势就在于只要老黄还能满足大家的需求,甚至只要大家有预期老黄还能在短时间内解决大家主要的需求,迁移算力的需求势能就难以积累到足够高度,比如AMD虽然现在拿出了一个核心指标压NVidia一倍的大杀器,但只要大家仍然预期老黄明年也能掏出这样一个大家伙,等等不香吗?毕竟一年时间算力迁移都不一定搞得完的,到时候NVidia来一个差不多指标的,可不就是迁移了个寂寞。玩弄预期方面,老黄可是老手,前有算力增长的黄氏定律取代摩尔定律,老黄明年必然也会给大家塑造带宽增长的新黄氏曲线,建立大家的预期。可以说,干老黄不光要干老黄当代产品,更要去干老黄给市场塑造的预期曲线。

此外,堆带宽没有秘密,老黄在NVLink和HBM上的布局也仍然是行业领先水平。

不过干老黄虽然不容易,但至少标准化的核心指标竞争终归是把老黄和各家拉到了一个层面进行竞争,相比前几年靠DSA在非标算力层面进行不对称竞争相比,难度还是降低了非常多的。最后引用夏core文章结尾来收尾,与各位同僚共勉。

AI这个行业,也终将,昔日王榭堂前燕 飞入寻常百姓家。这是大势。

-

267.英伟达对中俄出口高端GPU芯片受新限制小凡 2022-10-04

-

00032 Jetson TX2 NX开发者套件!TX2的性能,NANO的尺寸! #英伟达 #jetson学习电子知识 2023-07-02

-

全新一代Jetson Orin Nano来袭,40TOPS超强算力,刷新你的想象! #Jetson #英伟达学习电子知识 2023-07-02

-

#消费级显示被禁止出口 英伟达RTX 4090显卡遭遇下架风波深圳市浮思特科技有限公司 2023-10-19

-

#英伟达 #显卡 英伟达全新旗舰显卡RTX 5090性能暴涨70%深圳市浮思特科技有限公司 2023-11-20

-

英伟达为何放不下中国?深圳市浮思特科技有限公司 2023-11-27

-

英伟达HBM4预计2026年推出深圳市浮思特科技有限公司 2023-11-27

-

英伟达将在越南设法人实体深圳市浮思特科技有限公司 2023-12-12

-

英伟达新显卡起售近1.3万元深圳市浮思特科技有限公司 2023-12-29

-

高端VR设备起量,英伟达称今年1500万,明年翻倍2016-12-13 0

-

英伟达TX2手册2018-01-07 0

-

英伟达发布新一代 GPU 架构图灵和 GPU 系列 Quadro RTX2018-08-15 0

-

英伟达GPU惨遭专业矿机碾压,黄仁勋宣布砍掉加密货币业务!2018-08-24 0

-

英伟达DPU的过“芯”之处2022-03-29 0

-

联发科回应结盟英伟达合攻 Arm 架构芯片传闻2023-05-28 0

全部0条评论

快来发表一下你的评论吧 !