如何在手持设备上安装庞大的transformer网络

描述

Siri和OK Google是最早实现语音控制的应用程序,这着实为我们带来了很多乐趣;但很快我们便意识到,必须仔细说出请求才能获得实用回答。

就现在所见,ChatGPT理解程度高,使用起来更容易,但直到最近,其功能还仅限于通过基于云的应用程序进行文本互动。现如今,ChatGPT是大势所趋,手机几乎人人必备,促使着针对ChatGPT(手机版)的transformer网络尽快推出,让每个拥有手机的人都能感受到大语言模型的威力。

在此方面面临的一个明显挑战是,我们所知的 ChatGPT依赖于数万亿个参数。而这种规模的transformer网络只能在云端运行。有人建议采用混合模式,即先由手机或其他应用程序负责完成部分简单工作,再连接到云端进行更为繁重的推理。然而,普通手机用户可能无法接受混合解决方案与生俱来的长时间延迟和隐私风险问题。因此,更好的方法是,直接在手机上处理大部分或全部transformer网络工作,只在需要时将偶尔出现的匿名搜索请求转至云端处理。

缩减网络大小

如何在手持设备上安装庞大的transformer网络?Google DeepMind在检索transformer方面取得了重大突破。其RETRO transformer网络运行时的大小只有 LLM transformer的百分之几,因为前者的模型参数中不包含具体数据。只保留了基本的语言对话技能,但在理解水平上仍可与GPT3相媲美。如此将网络大小缩减到了约80亿个参数。

CEVA在预处理时进一步缩减此网络大小,将对感兴趣领域提示的准确度几乎没有影响的参数归零,进行再训练。仔细利用这一功能可以大大加快transformer网络分析的速度。

准备边缘模型的第二步是压缩,CEVA对此非常熟悉,并在支持检索transformer方面做得更好。我们充分利用NeuPro-M架构进行再训练,大力推进此步骤,促使广泛的混合定点精度和低精度选项降到4位,未来甚至还能降到2位。

通过使用这些技术,我们可以将现有检索transformer压缩至最低1/20(较现在而言),尽管其相较LLM而言已经压缩了很多。将这种压缩剪枝应用于RETRO模型缩减后,可以产生巨大缩减,将万亿参数模型转换为十亿参数模型,进而有望实现ChatGPT(移动版)。

NeuPro-M AI核心

当然,仅仅适合的transformer网络是不够的。它还需要运行得足够快,才能满足用户对响应时间的期望。而这一点可以通过专为LLM应用程序优化的NeuPro-M NPU IP多引擎架构实现。在此流程中,首先要做到的是由真正的稀疏引擎来进行管理,且这一步举足轻重。稀疏引擎管理可跳过权重或数据为零的冗余操作,提高吞吐量,这是需要注意的一点。而在预处理时缩减之后,会出现大量归零参数,尽管这些参数分布不均匀。对于这种非结构化稀疏引擎,每个NeuPro-M处理器内核中的专用稀疏引擎可发挥4倍性能优势(与传统稀疏引擎相比),并相应地降低功耗。

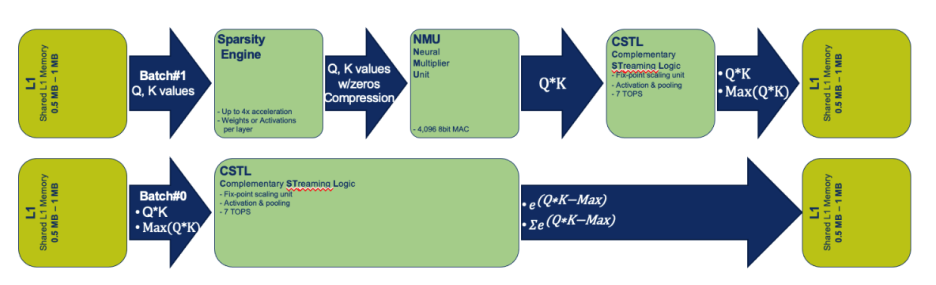

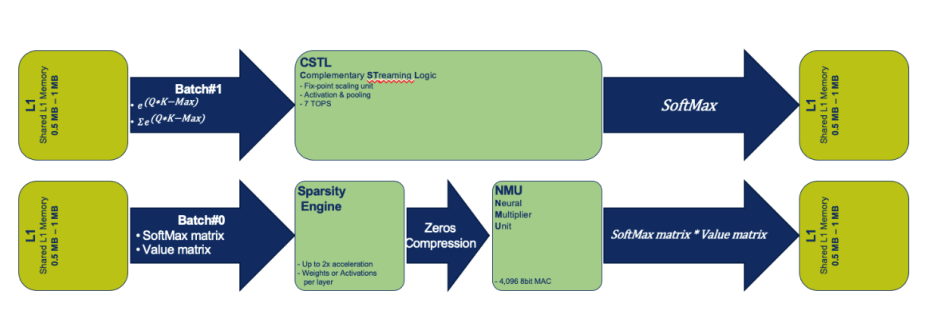

鉴于transformer架构可以分解为可并行实现的离散正交运算,下一优化应运而生。此时,可以利用 NeuPro-M多核架构支持多达8个内核。transformer中 query、key和value三个向量的计算会在引擎中分批进行,在共享公共二级缓存的多个内核并行处理。并行处理不仅有利于attention步骤,还有利于softmax步骤,以及计算attention函数之后的归一化函数。在传统的人工智能系统中,softmax可能是遏制性能提升的重大瓶颈。在NeuPro-M中,attention和softmax可以并行实现,因此softmax对于吞吐时间的增加几乎可以忽略不计。NeuPro-M在transformer计算中实现大规模并行处理如下图所示。

▲transformer计算中的可扩展并行化

NeuPro-M架构包括特殊支持,最大限度地提高芯片吞吐量,线程之间几乎没有停滞,进一步简化这些流中的高度并行性以及线程之间的数据共享。

为ChatGPT(移动版)构建语音界面

完成最难的部分后,在前端添加语音识别和在后端添加文本转语音,便可以通过额外相对简单的transformer网络实现。将我们的ClearVox语音处理前端软件连接到语音识别transformer,以输入提示,并接受引导,确定主transformer应执行哪一组精炼提示。必要时,可从互联网上检索查询相关文档。最后,使用文本转语音transformer对下载的回复或文件进行语音处理。现在来说,完全在手机上运行,且具有完全基于语音的 ChatGPT功能界面便是ChatGPT(移动版)的不同之处。

更广泛的应用

NeuPro-M平台并不局限于ChatGPT(移动版)这样的GPT类应用。它可以同样应用于任何生成式方法。例如,您可以使用稳定的扩散transformer生成图像、视频或任何其他人工生成或修改的体验。NeuPro-M解决方案在transformer网络建模方面非常通用。

审核编辑:彭菁

-

如何更改ABBYY PDF Transformer+界面语言2017-10-11 0

-

手持监控设备的优点2018-10-24 0

-

可重构天线在手持移动终端应用中有什么用?2019-07-31 0

-

如何在手持信息终端嵌入式系统平台上实现MIDI的播放?2021-05-28 0

-

如何在RK3288上安装Opencv?2022-03-10 0

-

数字签名技术在手持式设备上的应用2009-04-15 398

-

电量计在手持快充设备中的应用及特性介绍2018-08-13 2635

-

基于STM32单片机在手持设备中的应用设计2018-10-29 2391

-

大彩串口屏在手持设备行业中的应用综述2021-05-12 481

-

如何在Raspberry Pi上安装TensorFlow2022-09-01 1740

-

如何在手机应用的高通平台上使用TAS25602022-11-01 169

-

Transformer结构及其应用详解2023-06-08 1448

-

串口屏解决方案:大彩串口屏在手持设备行业的应用2021-07-12 793

-

浅谈网络变压器(Network Transformer)2023-11-24 511

全部0条评论

快来发表一下你的评论吧 !