即插即用!百度提出S3IM:用于NeRF提点的Magic Loss

描述

本文介绍一下我组在ICCV2023的论文“S3IM: Stochastic Structural SIMilarity and Its Unreasonable Effectiveness for Neural Fields”。

S3IM这个工作背后的想法实际上很简洁,从这个idea在脑海里形成到最后提交到ICCV2023不过2个月时间。

S3IM: Stochastic Structural SIMilarity and Its Unreasonable Effectiveness for Neural Fields

论文:arxiv.org/abs/2308.07032

代码:github.com/Madaoer/S3IM-Neural-Fields

用一句话来总结这个工作就是——我们提出了一种即插即用的loss S3IM(随机结构相似性),可以近乎零成本地显著提升现存NeRF类方法的性能指标。在几个场景里,我们甚至可以把TensoRF和DVGO这些经典模型的Test MSE Loss下降99%,同时把NeuS的几何重建指标(比如Chamfer L1 Distance)改善超过60%。

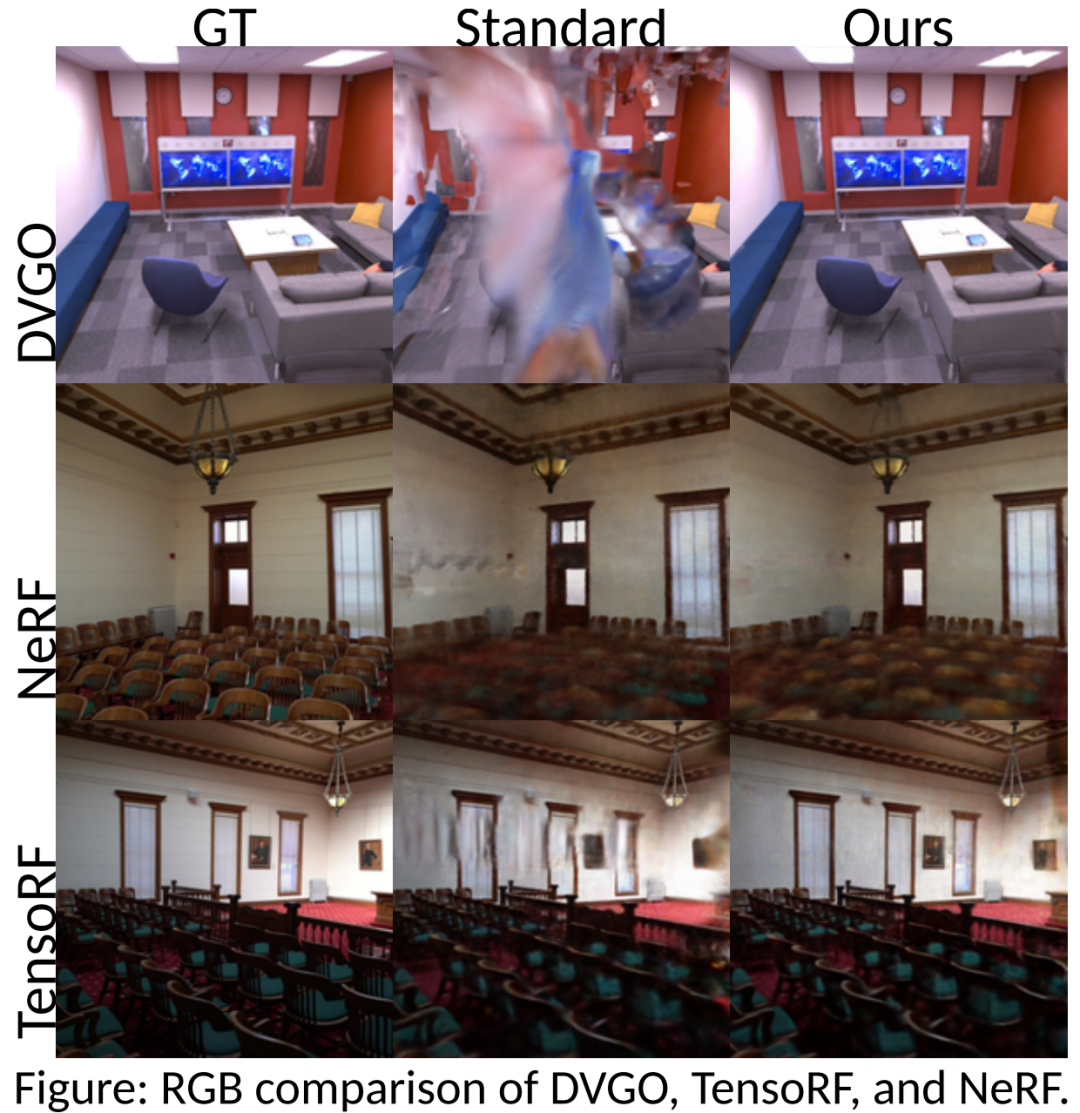

这里我们先看几组RGB和几何重建的可视化结果。

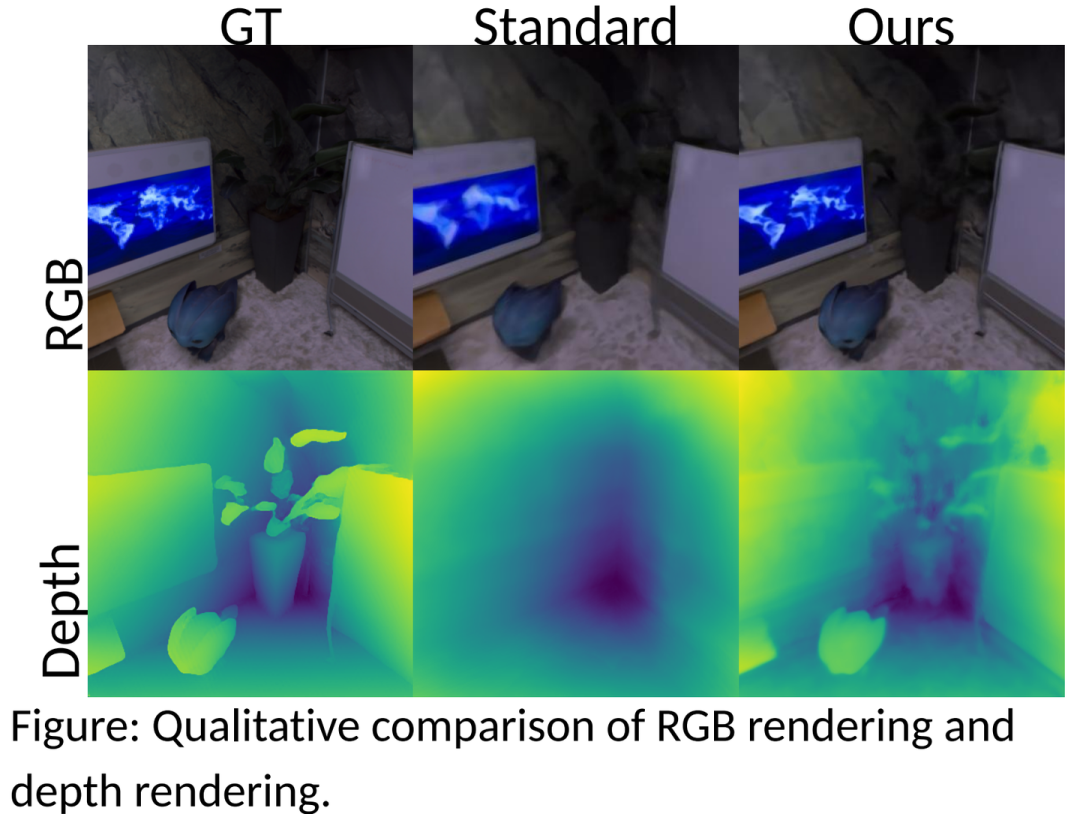

不仅如此,还可以提高对图像噪音的鲁棒性。如下图所示,S3IM的渲染结果明显去掉了图像里灰蒙蒙的噪音。

毫无疑问,S3IM极大地增强了现有的NeRF类方法。

S3IM的精髓在于以两个像素集合之间的相似性作为训练损失;像素集合一般包含数千个像素,这些像素一起贡献了互相关联的、全局的结构信息。

而NeRF传统的MSE是一种以两个独立像素之间的point-wise error作为训练损失;所以MSE只包含了像素点孤立的信息、完全没有远距离或者全局的信息。

上面这两段话就是S3IM的motivation。

为什么有结构信息更好?

这是一个很好的问题。

但我们先回答另一个相关的问题,为什么NeRF的性能指标要有3个——PSNR、SSIM和LPIPS?

PSNR就是像素之间point-wise的度量。很早大家就发现,PSNR好不代表真的就好。

SSIM(结构相似性)作为一种和人类视觉感知相关性更高的度量在2004年图像评估领域应运而生。

LPIPS则是一种通过预训练神经网络提取特征计算特征距离的指标(一般叫做感知指标)。

SSIM和LPIPS其实都具备衡量两个像素集合之间相似性的能力,而且与人类视觉感知相关性都比PSNR高。

熟悉NeRF的读者都知道,传统NeRF训练时是用MSE Loss。而PSNR和MSE其实就是一个简单的对数关系。

MSE和PSNR这类point-wise指标都是不够好的。一方面是和人类视觉感知相关性低,另一方面则是无法捕捉多个像素(像素集合)的整体信息。

那么SSIM和LPIPS可不可以直接作为NeRF的loss训练呢?

其实也可以,但仍然不够好。

因为SSIM和LPIPS都是基于卷积核的相似性度量,它们只能捕捉相近像素的局部信息,不能捕捉更远的像素包含的结构信息。

我们的ICCV工作就是把SSIM(Structural SIMilarity)这个经典图像质量评估指标升级,变为S3IM(Stochastic Structural SIMilarity)。

这个升级方式也很简单。SSIM只能在图像local patch用卷积核对吧。

那我们把NeRF训练时每个minibatch的像素随机拼接成一个patch(叫做stochastic patch),然后再用SSIM处理这些stochastic patch就行了。

有时候,真理就是这么朴实无华啊...

知名3D几何重建开源框架SDFStudio也已经把S3IM方法合并进去了。

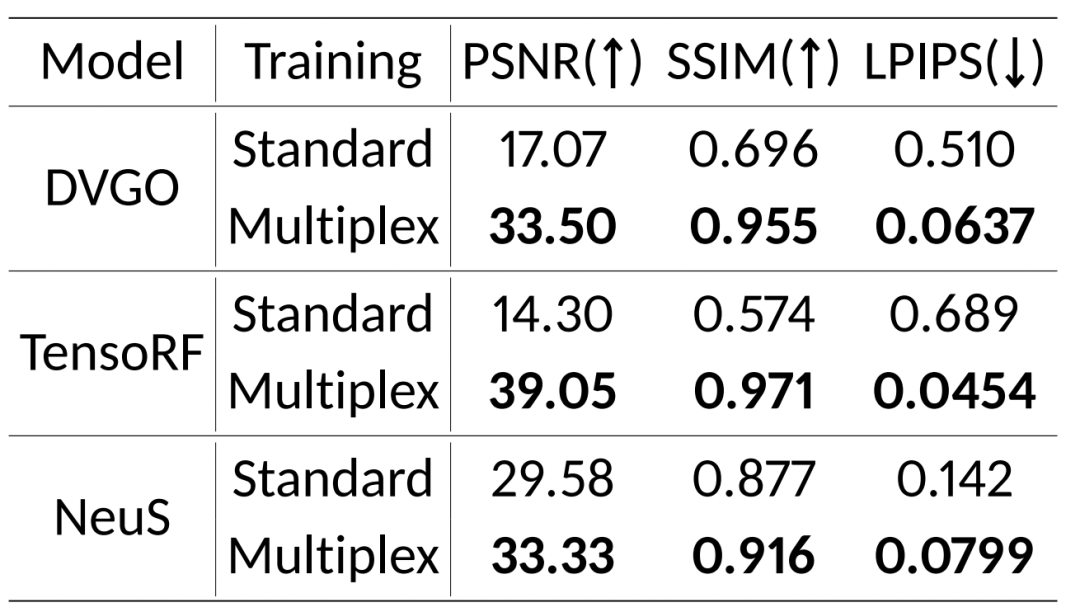

最后再放一个量化的实验结果。表里Multiplex即是我们的S3IM方法。

S3IM这个工作是我们Machine Learning for Fields系列工作的一环。我们在从机器学习的角度考虑场的问题。

无论是神经辐射场还是其他什么场,广义来说都是某个coordinate-wise的物理量。NeRF只是把辐射场的物理先验知识(空间中包含发光气体)嵌入了sampling的部分而已。这对3D场景表示不是完美的,但确实非常有用,也掀起了热潮。

-

[灌水]如何提升网站在百度的排名2010-11-09 0

-

下载百度到桌面_把百度下载到桌面2011-10-26 0

-

即插即用和热插拔的区别2012-10-23 0

-

百度发布影棒3:盒子硬件同质化时代到来2014-05-05 0

-

即插即用移动电源管理芯片2015-11-25 0

-

百度地图离线API调用教程2016-01-24 0

-

百度云和百度开放云是什么关系?愚人节不能不说的秘密。2016-03-29 0

-

百度总裁:百度在人工智能领域已有重大突破2016-07-01 0

-

LABVIEW如何调用百度地图?2018-05-14 0

-

谷歌地图、百度地图,离线+在线2018-07-19 0

-

seo优化的百度算法笔记2019-05-27 0

-

什么是即插即用用于Xilinx入门套件的micro-SD适配器?2019-09-03 0

-

PCI与即插即用2008-12-09 2022

-

什么是即插即用2009-12-28 2058

-

电源系统设计:非完全“即插即用”2022-11-07 269

全部0条评论

快来发表一下你的评论吧 !