AI时代,HBM掀起存储芯片新浪潮

描述

AI时代,HBM掀起存储芯片新浪潮

2022年末,ChatGPT的面世无疑成为了引领人工智能浪潮的标志性事件,宣告着新一轮科技革命的到来。

从ChatGPT掀起的一片浪花,到无数大模型席卷全球浪潮,再到今年的Sora火爆全网,人工智能的浪潮一浪高过一浪。

在这波浪潮中,伴随着人才、数据、算力的不断跃级,人工智能产业正展现出巨大的潜力和应用前景,正在多个领域展现出重要作用。

AI的快速发展对算力的需求呈现井喷的态势,全球算力规模超高速增长。国际数据公司IDC、浪潮信息等联合发布的《2022-2023全球计算力指数评估报告》预测,全球AI计算市场规模将从2022年的195亿美元增长到2026年的346.6亿美元。

巨大的生产潜力下,以GPU为代表的AI芯片供应商在市场上独孤求败,无论是股票市值还是公司业绩,头部AI企业涨幅领跑全球市场,迎来了有史以来最强劲的增长态势。

GPU繁荣背后,HBM同样炙手可热

AI热潮造就GPU繁荣的同时,也让扮演关键角色的HBM热度高居不下,成为当前AI赛道的新兴爆发风口。

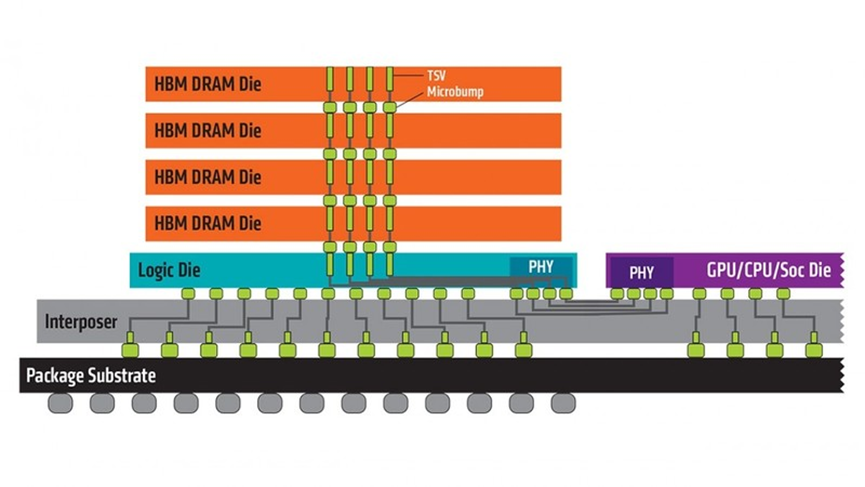

HBM,全称为High Bandwidth Memory,即高带宽存储器,是一款新型基于3D堆栈工艺的高性能DRAM,其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量,高位宽的DDR组合阵列。

图:AMD官网

与传统DRAM芯片相比,HBM具有高带宽、高容量、低延时与低功耗等优势,可以加快AI数据处理速度。

凭借这些优势,HBM能够实现大模型时代的高算力、大存储的现实需求,在所有存储芯片中,HBM被看作是最适用于AI训练、推理的存储芯片,是AI性能提升的关键。

据了解,HBM主要是通过硅通孔(TSV)工艺进行芯片堆叠,以增加吞吐量并克服单一封装内带宽的限制,将数个DRAM裸片像楼层一样垂直堆叠。相较传统封装方式,TSV技术能够缩减30%体积,并降低50%能耗。

同时,也正是基于Interposer中介层互联实现了近存计算,以及TSV工艺的堆叠技术,也让更大的模型,更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案带来的延迟。

从技术角度看,HBM使得DRAM从传统2D转变为立体3D,充分利用空间、缩小面积,正契合半导体行业小型化、集成化的发展趋势。HBM突破了内存容量与带宽瓶颈,被视为新一代DRAM解决方案,业界认为这是DRAM通过存储器层次结构的多样化开辟一条新的道路,革命性提升DRAM的性能。

随着存储数据量激增,市场对于HBM的需求将有望大幅提升。

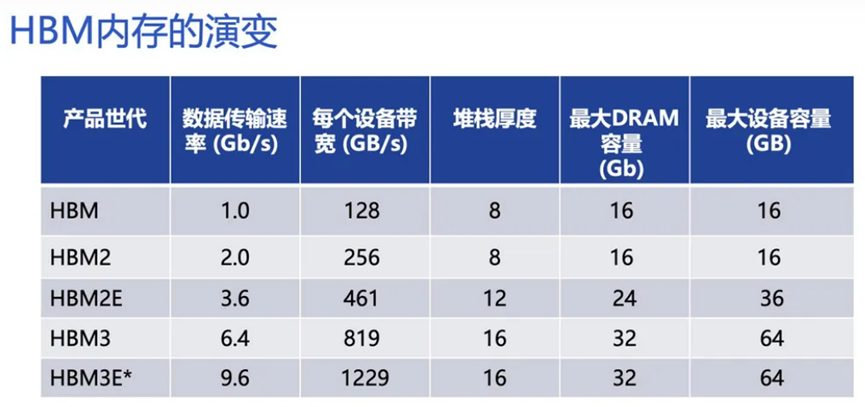

从技术迭代上看,自2014年全球首款硅通孔HBM产品问世以来,HBM已经从HBM1、HBM2、HBM2E,发展至目前被业界认为成为市场主流的HBM3,甚至HBM3E。

最初的HBM1为4层die堆叠,提供128GB/s带宽,4GB内存,显著优于同期GDDR5;

HBM2于2016年发布,2018年正式推出,为4层DRAM die,现在多为8层die,提供256GB/s带宽,2.4Gbps传输速度和8GB内存;

HBM2E于2018年发布,于2020年正式提出,在传输速度和内存等方面均有较大提升,提供3.6Gbps传输速度和16GB内存;

HBM3于2020年发布,2022年正式推出,堆叠层数及管理通道数均有增加,提供6.4Gbps传输速度和16GB内存;

第五产品HBM3E,提供供高达8Gbps的传输速度和24GB容量,计划于2024年大规模量产。

图源:Rambus

近段时间来,全球多个科技巨头都在竞购第五代高带宽内存HBM3E。自2024年起,市场关注焦点即由HBM3转向HBM3e,预计下半年将逐季放量,并逐步成为HBM市场主流。

对于接下来的规划和技术发展方向,业界旨在突破目前HBM在速度、密度、功耗、占板空间等方面的极限。

过去几年来,HBM产品带宽增加了数倍,目前已接近或达到1TB/秒的里程碑节点。相较于同期内其他产品仅增加两三倍的带宽增速,HBM的快速发展归功于存储器制造商之间的竞争和比拼。

下一代HBM4有望于2025-2026年推出。随着客户对运算效能要求的提升,HBM4在堆栈的层数上,除了现有的12hi(12层)外,也将再往16hi(16层)发展,更高层数也预估带动新堆栈方式hybrid bonding的需求。HBM4 12hi产品将于2026年推出,而16hi产品则预计于2027年问世。

HBM芯片,AI时代的“金矿”

HBM突破了内存容量与带宽瓶颈,可以为GPU提供更快的并行数据处理速度,打破“内存墙”对算力提升的桎梏。

凭借诸多优势,HBM成为AI时代的“新宠”,受到各大厂商的追捧,市场需求强劲。

首先,AI服务器的需求会在近两年爆增,如今在市场上已经出现了快速的增长。AI服务器可以在短时间内处理大量数据,GPU可以让数据处理量和传输速率的大幅提升,让AI服务器对带宽提出了更高的要求,HBM基本成为了AI服务器的标配。比如,AMD的MI300X、MI300A、MI250、MI250X等系列GPU已成为AI服务器市场的主流产品,这些GPU基本都配备了HBM。

并且AI浪潮还在愈演愈烈,HBM今后的存在感或许会越来越强。据semiconductor-digest预测,到2031年,全球HBM市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。

这样的市场表现,无疑证明了HBM在市场上的巨大潜力。它不仅仅是一种存储芯片,更是AI时代的“金矿”。

除了AI服务器,汽车也是HBM值得关注的应用领域。汽车中的摄像头数量,所有这些摄像头的数据速率和处理所有信息的速度都是天文数字,想要在车辆周围快速传输大量数据,HBM具有很大的带宽优势。

另外,AR和VR也是HBM未来将发力的领域。因为VR和AR系统需要高分辨率的显示器,这些显示器需要更多的带宽来在 GPU 和内存之间传输数据。而且,VR和AR也需要实时处理大量数据,这都需要HBM的超强带宽来助力。

此外,智能手机、平板电脑、游戏机和可穿戴设备的需求也在不断增长,这些设备需要更先进的内存解决方案来支持其不断增长的计算需求,HBM也有望在这些领域得到增长。并且,5G 和物联网 (IoT) 等新技术的出现也进一步推动了对HBM的需求。

整体来看,随着人工智能、机器学习、高性能计算、数据中心、自动驾驶、AR/VR等应用市场的兴起,内存产品设计的复杂性正在快速上升,并对带宽提出了更高的要求,不断上升的宽带需求持续驱动HBM发展。相信未来,存储巨头们将会持续发力、上下游厂商相继入局,让HBM得到更快的发展和更多的关注。

据市场研究机构TrendForce预测,2023年全球搭载HBM总容量将达2.9亿GB,同比增长近60%。到2027年,HBM市场预计将以82%的复合年增长率保持增长,未来市场前景非常广阔。

在2023年的市场风云中,存储芯片市场持续低迷,HBM如同一股清流逆流而上,照亮了存储行业的前行之路,成为存储巨头在下行行情中对业绩的重要扭转力量,也是产业链上常提及的高频词。

当以AI GPU为代表的相关各类需求如潮水般汹涌而至,由于英伟达和AMD等AI芯片制造商的需求激增,HBM价格逆势上扬,成为了行业的“香饽饽”。

方正证券报告指出,从成本端来看,HBM平均售价至少是DRAM三倍;而此前受ChatGPT的拉动同时受限产能不足,供不应求成为现状,HBM价格一路上涨。

2023年,HBM平均售价“逆势暴涨”500%。2024年,HBM依旧“状态火热”。

扩产,HBM厂商的主旋律

受生成式AI大模型等领域的驱动,HBM逐渐发展成为新兴热门产业之一,随着上游客户不断发出新的需求,目前HBM市场正释放出供不应求的信号。

在此现状和趋势下,HBM产能紧张的问题日益凸显,正释放出供不应求的信号。很多高性能GPU的产能上不来,很大程度上就是因为HBM不够用了。

日前,美光科技CEO Sanjay Mehrotra 在财报电话会议上表示,AI 服务器需求正推动 HBM DDR5 和数据中心 SSD 快速成长,这使得高阶 DRAM、NAND 供给变得吃紧,进而对储存终端市场报价带来正面连锁效应。同时强调道:“美光今年HBM产能已销售一空,且2025年绝大多数产能已被预订。”

不难猜测,在此情形下,其他HBM供应商例如SK海力士和三星电子的产能估计也会变得紧张。

对此,生产和扩产成了HBM提供商的主旋律。

据报道,包括美光科技在内的头部存储原厂正在追加投资HBM产线,扩大HBM目标产能,以应对市场的旺盛需求。同时,大厂们继续埋头攻破技术壁垒,以迅速抓住市场新机遇,力求在下一代标准中掌握主导权。

预计今年各大制造商在HBM领域将会有更多举措,属于HBM市场的一场争夺战正式开启。

然而,即便是在这样的扩产计划下,HBM的供应仍然难以满足市场的需求。市场研究公司Yole表示,受到生产扩张难度和需求激增的双重影响,2023-2028年间,HBM供应的年复合增长率将达到45%。这意味着,在相当长的一段时间内,HBM的价格都将保持高位。

从性能来看,HBM无疑是出色的,其在数据传输的速率、带宽以及密度上都有着巨大的优势。不过,目前HBM仍主要应用于服务器、数据中心等应用领域,其最大的限制条件在于成本,对成本比较敏感的消费领域而言,HBM的使用门槛仍较高。因此HBM当前市场份额还比较低,但随着多领域需求的提升,未来HBM市场将会呈现爆发式的增长。

根据TrendForce预估,2024年全球HBM的位元供给有望增长105%,市场规模也有望于今年达89亿美元,同比增长127%,预计至2026年市场规模将达127.4亿美元,对应CAGR约37%。

以规格而言,伴随AI芯片需要更高的效能,HBM主流也将在2024年移转至HBM3与HBM3E。整体而言,在需求位元提高以及HBM3与HBM3E平均销售价格高于前代产品的情形下,2024年HBM营收可望有显著的成长。

存储回暖,HBM加速

目前消费电子已出现复苏信号,行业新的转机正在孕育生成,AI催生存力新需求,2024年存储市场有望迎来新的转机。

在供应链库存水位已大幅改善和需求回温的态势下, 客户为避免供货短缺及成本垫高的风险, 持续增加采购订单。

据TrendForce数据预测,2024年一季度受惠订单规模持续放大,激励DRAM合约价季涨幅约13~18%,NAND Flash则是18-23%。

NAND Flash合约价平均涨幅高达25%;观察2024年第一季DRAM市场趋势,原厂目标仍为改善获利,涨价意图强烈,促使DRAM合约价季涨幅近两成。

展望第二季度,虽然目前市场对整体需求看法仍属保守,但DRAM与NAND Flash供应商已分别在2023年第四季下旬,以及2024年第一季调升产能利用率,加上NAND Flash买方也早在第一季将陆续完成库存回补。因此,DRAM、NAND Flash第二季合约价季涨幅皆收敛至3~8%。

存储芯片市场价格的反弹信号,让行业人士看到了“曙光”。

而随着HBM的兴起,将成为半导体和算力行业未来新的增长点,HBM无疑将继续引领存储行业的新篇章。而那些能够在这个领域立足并不断创新的公司,也将会迎来更加广阔的发展空间和机遇。

据WSTS预测,2024年存储芯片市场涨幅达44.8%。

过去两年来,在存储市场下行时期,HBM作为行业的中流砥柱异军突起,为行业疲态“雪中送炭”;而如今,随着存储行业触底反弹,优势傍身的HBM在产业抢购与扩产声中,再次掀起存储芯片的发展新浪潮,为其增势“锦上添花”。

展望未来,随着AI技术的不断进步和应用场景的拓展,HBM的需求将会持续增长。而国际存储芯片大厂们也在积极布局,加大产能扩张力度,以应对市场的挑战。同时,随着HBM技术的不断成熟和应用领域的拓展,其成本也有望逐渐降低,从而进一步推动其在市场上的普及和应用。

审核编辑:刘清

-

DSP技术的三波创新浪潮2019-07-01 0

-

XMOS掀起可编程系统级芯片产品新浪潮2013-11-07 1249

-

三星投产2.4Gbps的HBM2存储芯片:号称是业界最快的DRAM2018-07-02 1812

-

三星推出第三代HBM2存储芯片,适用于高性能计算系统2020-02-05 3224

-

三星新发布HBM2E存储芯片,其代号Flashbolt2020-02-05 3292

-

中国高新技术论坛抢先看:新时代、新技术、新经济--“新基建”引领发展新浪潮2020-11-03 1867

-

建设招标采购管理系统,看广东高校如何掀起“阳光采购”新浪潮2022-03-08 1932

-

亚信电子与安勤科技携手共创TSN技术新浪潮2023-07-19 667

-

ai芯片和存储芯片的区别2023-08-09 2472

-

存储芯片减产,AI芯片暴增!2023-09-08 490

-

2023进博会 | 爱立信“5G新浪潮”获多家媒体报道2023-11-10 359

-

大模型时代必备存储之HBM进入汽车领域2023-12-12 283

-

中国移动董事长杨杰在MWC2024上探讨AI创新浪潮2024-02-27 424

-

护肤市场新浪潮来了!绿展科技用一片抗衰电子面膜撬动千亿“她经济”?2024-03-28 1120

全部0条评论

快来发表一下你的评论吧 !