AI服务器异构计算深度解读

人工智能

描述

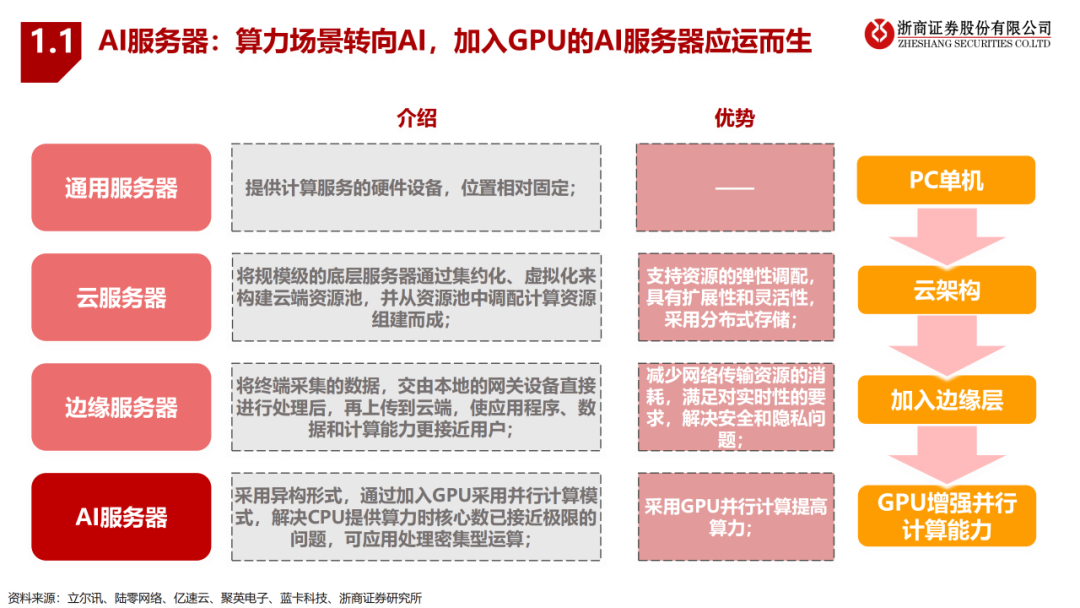

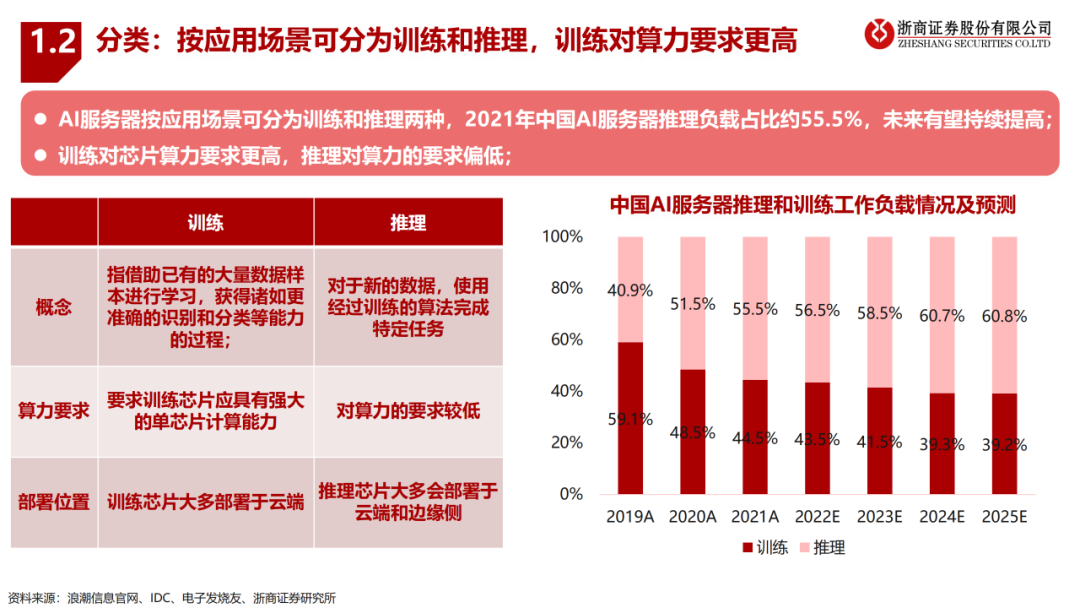

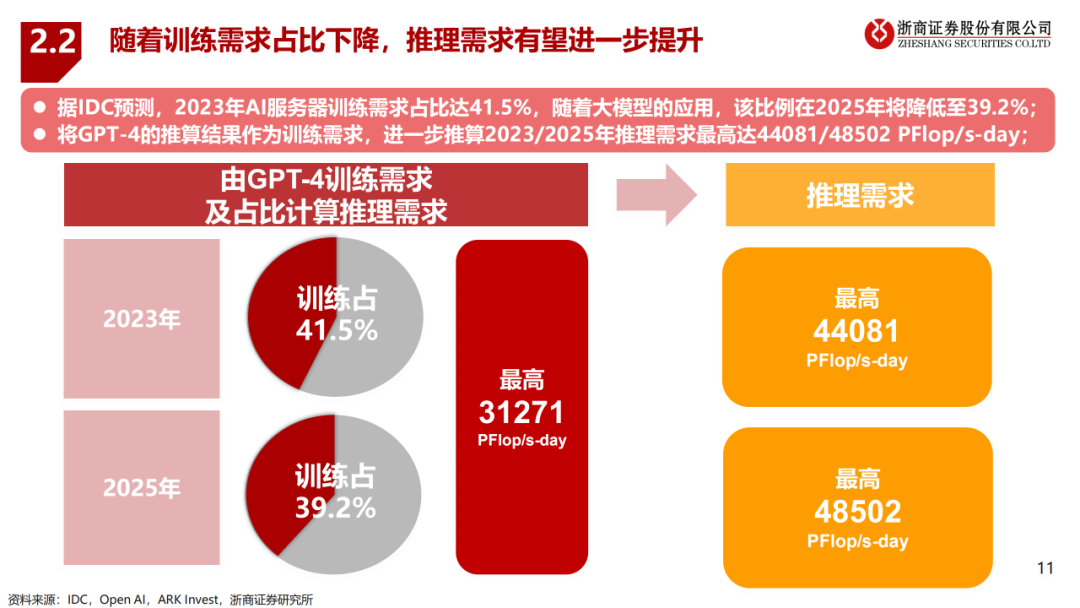

服务器随着场景需求经历通用服务器-云服务器-边缘服务器-AI服务器四种模式,AI服务器采用GPU增强其并行计算能力;AI服务器按应用场景可分为训练和推理,训练对芯片算力的要求更高,根据IDC,随着大模型的应用,2025年推理算力需求占比有望提升至60.8%;

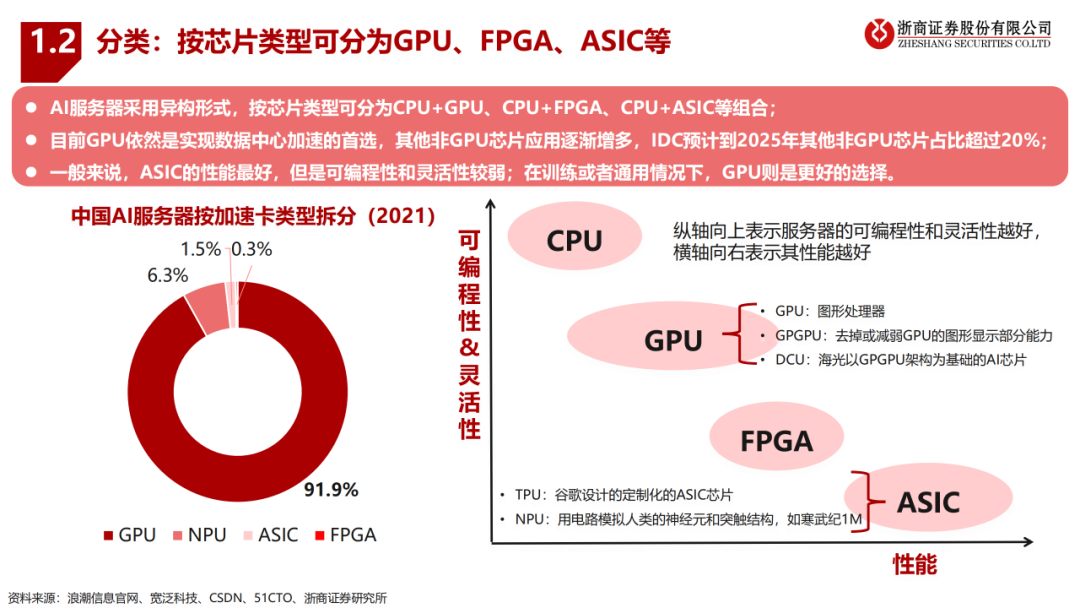

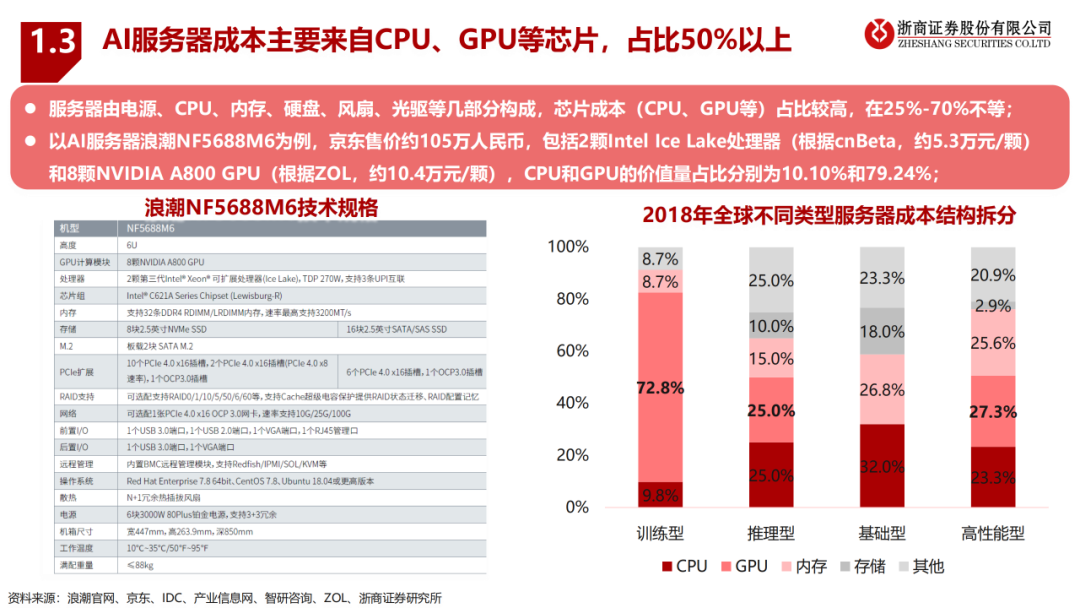

AI服务器按芯片类型可分为CPU+GPU、CPU+FPGA、CPU+ASIC等组合形式,CPU+GPU是目前国内的主要选择(占比91.9%);AI服务器的成本主要来自CPU、GPU等芯片,占比25%-70%不等,对于训练型服务器其80%以上的成本来源于CPU和GPU。

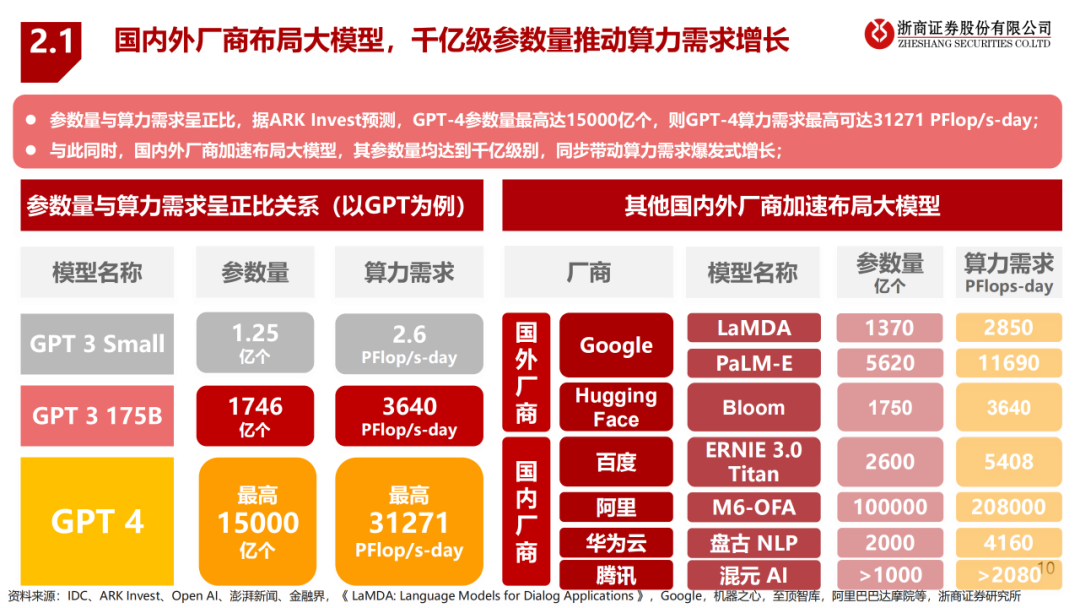

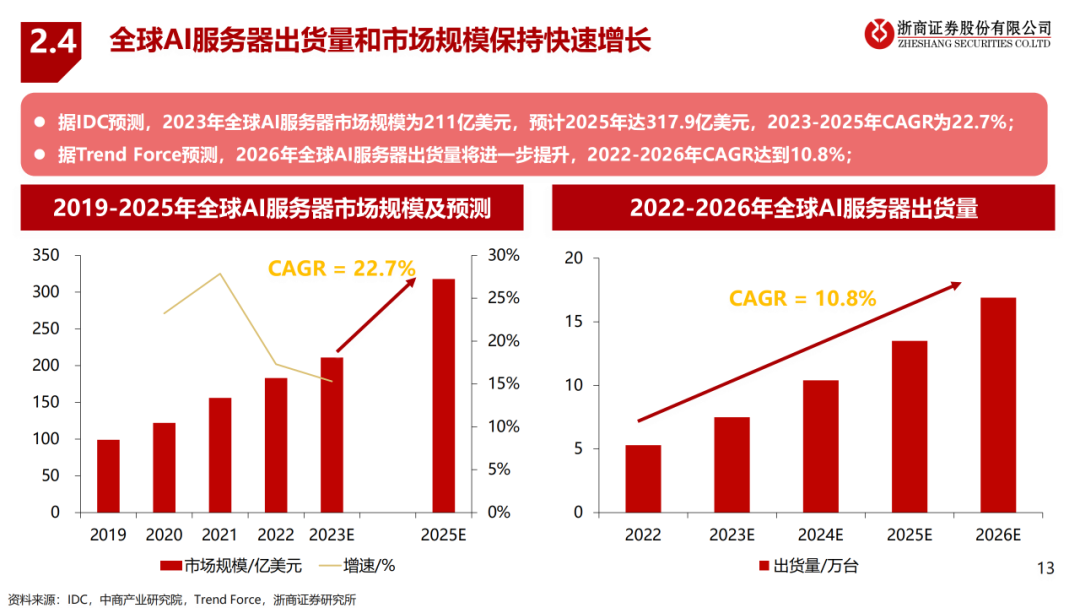

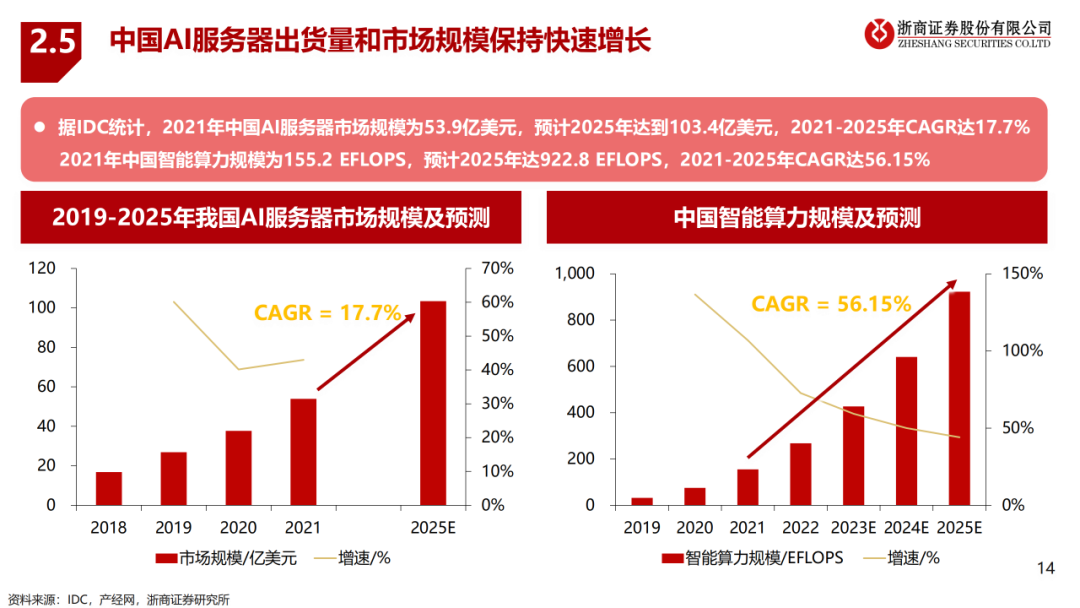

据ARK Invest预测,Chat GPT-4参数量最高达15000亿个,由于参数量与算力需求间存在正比关系,所以可推算GPT-4算力需求最高达到31271 PFlop/s-day。随着国内外厂商加速布局千亿级参数量的大模型,训练需求有望进一步增长,叠加大模型落地应用带动推理需求高速增长,共同驱动算力革命并助推AI服务器市场及出货量高速增长。

美国对中国禁售英伟达高性能芯片A100和H100,英伟达特供中国的削弱互联带宽的版本A800或为当前可替代方案;

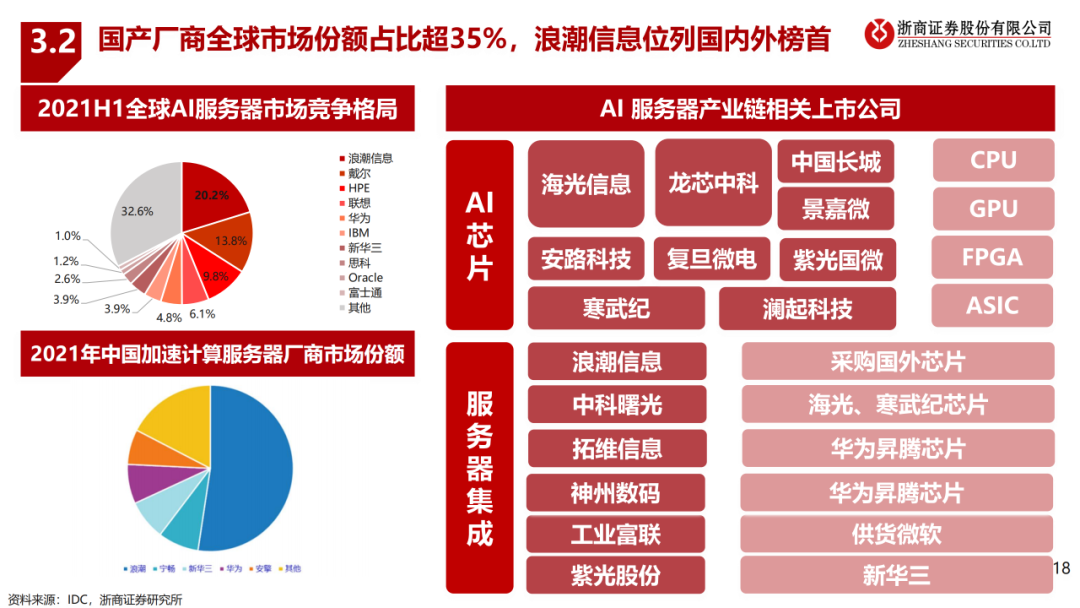

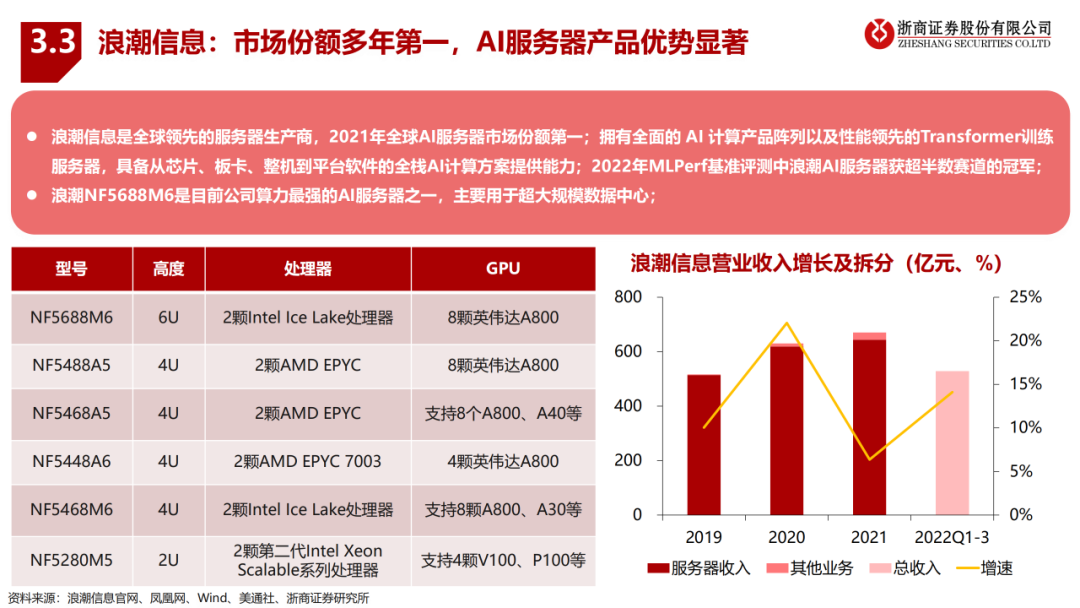

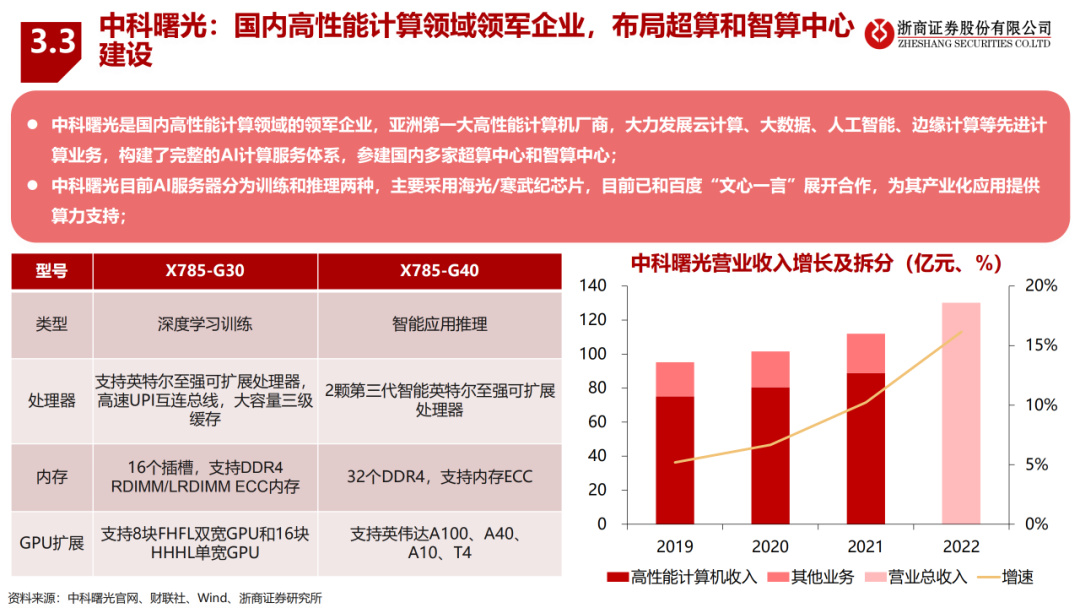

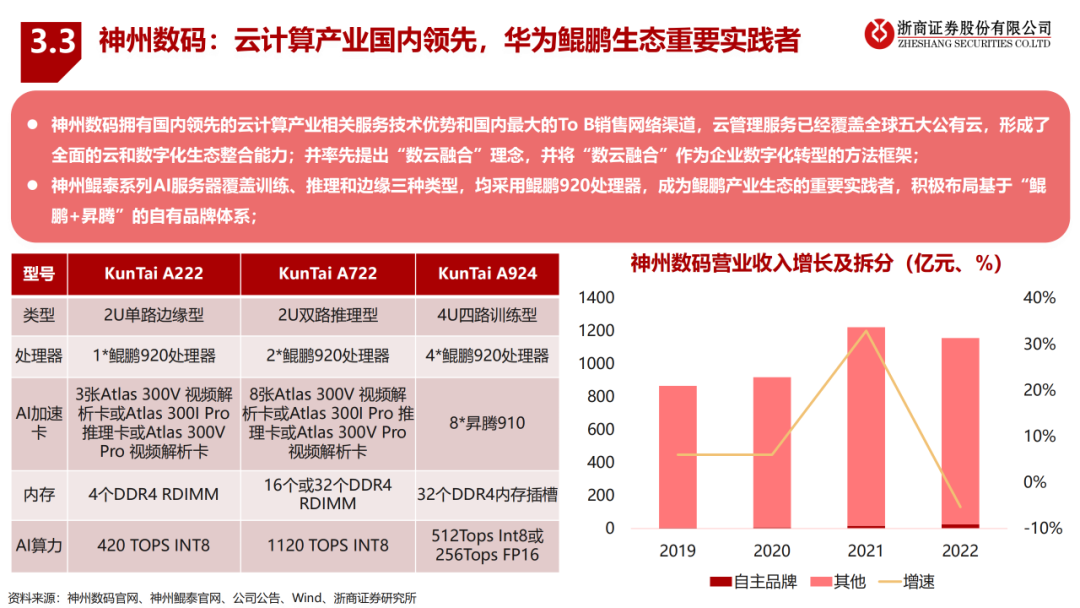

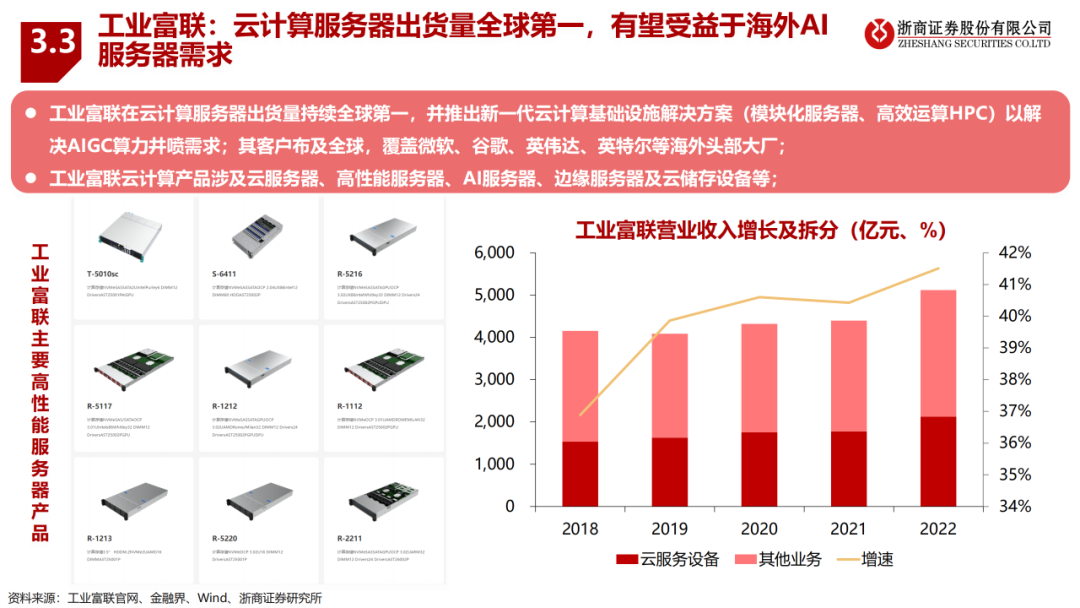

以海光信息、壁仞科技等为代表的国产GPU部分单卡指标接近英伟达,在推理场景中具有一定竞争力;国产AI服务器厂商全球份额超35%,浪潮信息位列榜首;国产AI服务器厂商各具优势,有望受到下游需求拉动。

本文来自“大模型算力:AI服务器行业(2023)”。关于CPU、服务器和存储详细技术,请参考“更新下载:存储系统基础知识全解(终极版)”、“存储芯片技术基础知识介绍(2023)”等等。

审核编辑:黄飞

-

【产品活动】阿里云GPU云服务器年付5折!阿里云异构计算助推行业发展!2017-12-26 0

-

「深圳云栖大会」大数据时代以及人工智能推动下的阿里云异构计算2018-04-04 0

-

异构计算在人工智能什么作用?2019-08-07 0

-

什么是异构并行计算2021-07-19 0

-

异构计算场景下构建可信执行环境2023-08-15 0

-

异构计算芯片的机遇与挑战2017-09-27 999

-

深度解析FPGA异构计算芯片的技术特性2017-10-24 5834

-

基于FPGA的异构计算是趋势2018-04-25 10677

-

异构计算的两大派别 为什么需要异构计算?2018-04-28 22714

-

异构计算,你准备好了么?2018-09-25 370

-

异构计算的前世今生2021-12-17 3955

-

异构计算真就完美无缺吗2021-12-21 1684

-

物理服务器对ai发展的应用2023-12-22 222

-

高通NPU和异构计算提升生成式AI性能2024-03-06 243

全部0条评论

快来发表一下你的评论吧 !