Arm推动生成式AI落地边缘!全新Ethos-U85 AI加速器支持Transformer 架构,性能提升四倍

Arm推动生成式AI落地边缘!全新Ethos-U85 AI加速器支持Transformer 架构,性能提升四倍

描述

电子发烧友网报道(文/黄晶晶)在嵌入式领域,边缘与端侧AI推理需求不断增长,Arm既有Helium 技术使 CPU 能够执行更多计算密集型的 AI 推理算法,也有Ethos 系列 AI 加速器,以满足更高性能和更复杂的 AI 工作负载。Ethos-U NPU系列是业界首款 AI 微加速器,英飞凌、恩智浦半导体、奇景光电 (Himax)、Alif Semiconductor 和 Synaptics 等领先企业均已推出搭载 Ethos-U 的量产芯片。最近,Arm发布Arm Ethos-U85 AI加速器,这款加速器在性能、算力、应用场景方面进一步拓展,着眼于未来几年的边缘AI的应用所需。

全新Arm Ethos-U85 AI加速器

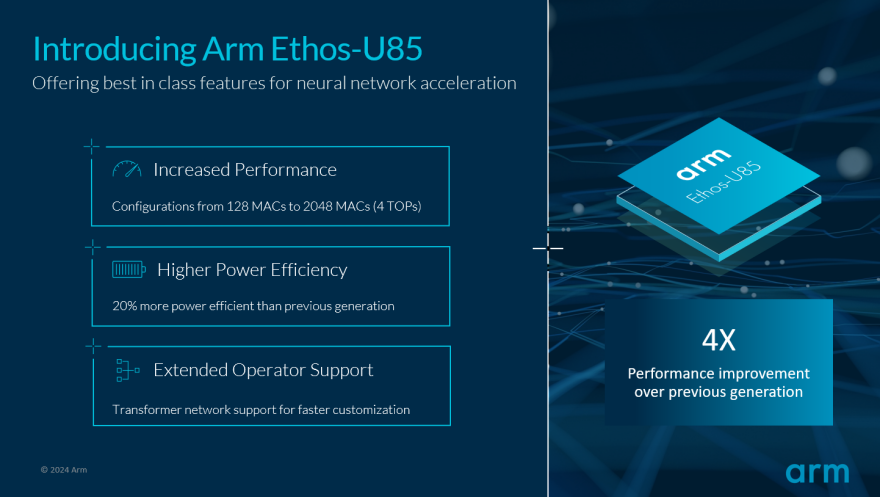

与上一代产品相比,Ethos-U85 性能提升四倍,能效提高 20%,它支持MAC 单元从 128 个扩展到 2048 个(在 1GHz 时,算力实现 4 TOPs)。Ethos-U85 提供了相同的一致工具链,实现无缝的开发者体验。全新 Ethos-U85 NPU 支持TensorFlow Lite 和 PyTorch 等 AI 框架。Ethos-U85可满足于智能家居、零售、工业等新兴的边缘 AI 场景对更高性能计算的需求。

图:Arm Ethos-U85 提供卓越的神经网络加速功能

Ethos-U85支持Transformer 架构和卷积神经网络 (CNN) 以实现 AI 推理。Arm 物联网事业部业务拓展副总裁马健Chloe Ma分析,Ethos-U85 不仅仅提供卷积神经网络 (CNN) 所需的权重矩阵乘的运算,还支持矩阵相乘,这是 Transformer 架构网络的一个基本组成部分。Ethos-U85 增加对Transformer 架构网络的支持,这是优化大模型边缘落地微调时间、提升模型泛化的一个关键特性。

马健表示:“基于 Transformer 的模型具有优异的泛化功能,它将更快地驱动新 AI 应用的发展。Transformer 在视觉和生成式 AI 用例中,比如视频理解、图文结合,图像增强与生成、图像分类和目标检测等方面都极有价值。Transformer 架构网络的注意力机制容易利用并行计算来实现,提高硬件使用效率,使得这些模型能够部署在计算资源有限的边缘设备上。开发者可以通过选用针对 Transformer 架构网络优化的设计,发掘边缘 AI 的新机遇,使这些应用享有更快的推理、更优化的模型性能和可扩展性。”

Ethos-U85 不仅支持低功耗MCU的AI加速。在高性能边缘计算系统中,Ethos-U85与Armv9 Cortex-A CPU相结合,为基于应用处理器的智能物联网平台上运行的AI任务实现加速。这将使 Ethos-U85 能够在工业机器视觉、边缘网关、可穿戴设备和消费类机器人等应用中,带来高效能的边缘推理。

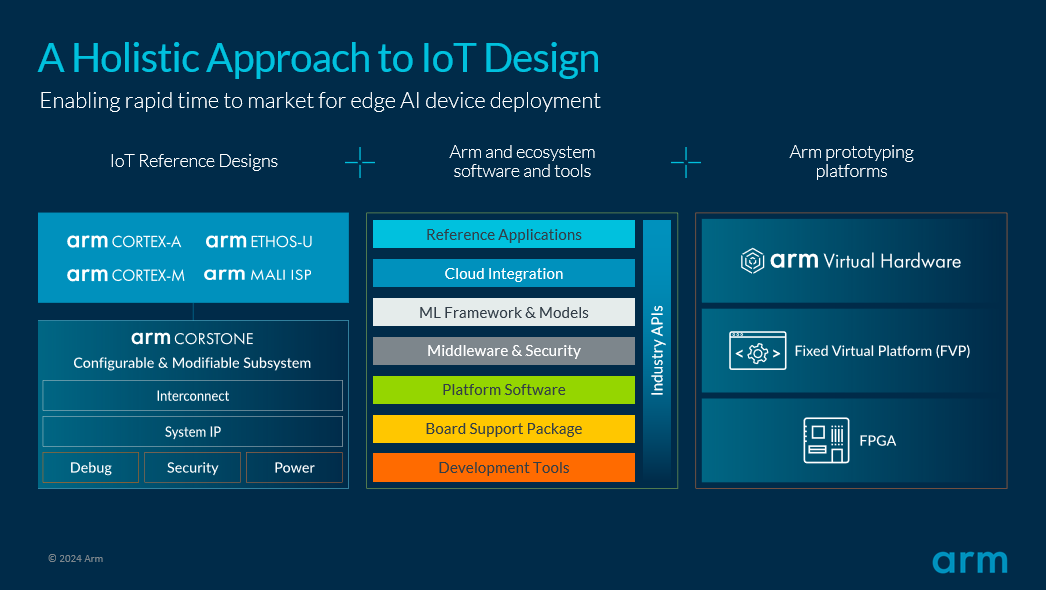

全新Arm Corstone-320智能物联网参考设计平台

Corstone-320 包含了 Cortex-M 系列最高性能的嵌入式处理器 Cortex-M85,Ethos-U85 NPU AI 加速器以及Arm Mali-C55 ISP等,以实现为视觉应用优化的低功耗系统。与此前推出的Arm物联网参考设计一致,Corstone-320 不仅仅提供芯片计算子系统 IP 组合,还附带了软件、AI 模型库和开发工具,以实现软件的复用,同时也利用了 Arm 强大的生态系统。它还附带了仿真 Corstone-320 完整系统的 Arm 虚拟硬件,以及单独的 CPU 和 NPU 的固定虚拟平台 (FVP) 模型,以简化开发并加速产品设计,支持软硬件并行协同开发。这种提供边缘 AI 和智能物联网计算子系统全套软硬件和工具链的方法,使得合作伙伴能够在一系列性能点上快速开发,并聚焦于打造差异化价值。

图:Arm 助力加速边缘 AI 设备部署进程

马健介绍,全新的参考设计是针对实际工作负载开发的,参考用例包括部署在智能家居中的电池供电摄像系统,以及在工业和零售系统中的低帧率网络摄像头。同时,Corstone-320 参考设计提供了有安全保证的软硬件组合,使得在此参考设计基础上开发的合作伙伴们能够顺利地通过 PSA Certified Level 2 认证,实现对区域和全球安全标准的合规。总之,通过 Corstone-320 预先集成、预先验证的参考设计模版,Arm 能帮助合作伙伴减少边缘智能芯片开发的成本和时间。

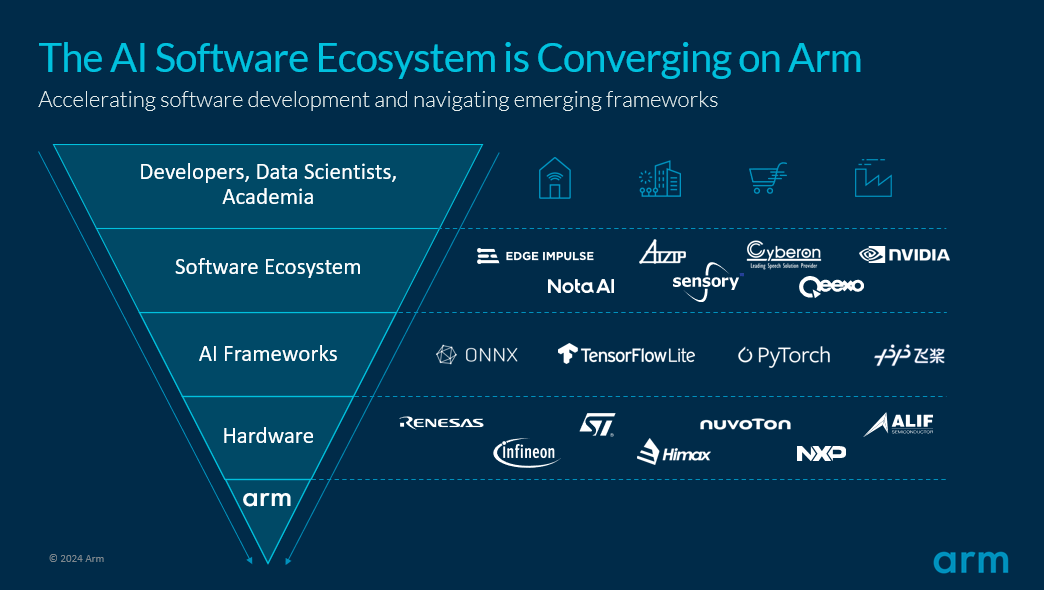

基于 Arm 平台的 AI 软件生态系统

“只有 Arm 计算平台才能提供 AI 从云到端、现代敏捷开发和部署流程中所需的特性和功能,实现基于量产验证的一致架构,并采用统一工具链完成AI 转型。”马健说道。实际上,一致性的工具链和平台对于开发者而言非常重要,尤其是面对物联网碎片化,加上AI功能引入的复杂性,如果缺少一个良好的生态、工具支持,将耗费开发者大量的开发时间。

随着边缘 AI 的持续扩展,简单易用才更适于普及推广,因此物联网生态链上下游的芯片与系统供应商、算法软件开发者与集成商们汇聚在Arm计算平台。目前,包括开发者、数据科学家、学术界在内的 AI 研究开发社区,不仅持续受益于 Arm 生态系统与合作伙伴提供的丰富信息与知识,也围绕 Arm 计算平台构建日益增长的软件和工具生态系统,以及开源软件库和 AI 框架,以更简化的开发流程,扩展边缘 AI 的部署。

图:基于 Arm 平台的 AI 软件生态系统

马健举例说:“大家熟知的 PyTorch 开源 ML 框架,广泛用于构建和训练神经网络模型,而我们也很高兴看到 PyTorch 基金会投资边缘 AI,发布针对移动和边缘设备推理工具包 ExecuTorch,提供了轻量级运行时 (Runtime) 和算子注册表,覆盖了PyTorch生态系统中的各类模型。此外,由于 Arm 特有的 IP 授权许可模式和开放生态,OEM 和 ODM 可以有多种基于 Arm 架构和计算平台的芯片与模组选择,更灵活地开发适于最终应用的系统方案。”

小结:

随着边缘 AI 的持续发展,Arm 始终处于推动市场和技术进步的核心地位,从 Cortex-M 嵌入式处理器的 Helium 矢量增强指令集,到 Cortex-A 应用处理器的 SVE、SVE2、SME 对矢量和矩阵运算的优化,再到 Ethos-U AI 加速器,Arm 不断丰富产品线并拉高性能。

马健表示,Arm 不会止步于此。随着大模型持续通过量化、剪枝和聚类技术来缩减优化模型,使大模型适于在边缘和超级终端设备部署,Arm认为大小模型云边端结合成为未来 AI 产品的重要发展趋势,也是 AI 应用赋能行业发展的重要方向。而 Arm 已经为此做好准备,来挑战物联网与大模型、多模态 AI 结合的性能与效率极限。

-

中国企业的崛起!全球AI芯片Top24榜单7家中国公司上榜2018-05-07 0

-

Firefly支持AI引擎Tengine,性能提升,轻松搭建AI计算框架2018-08-13 0

-

EdgeBoard FZ5 边缘AI计算盒及计算卡2020-08-31 0

-

MLU220-M.2边缘端智能加速卡支持相关资料介绍2022-08-08 0

-

嵌入式边缘AI应用开发指南2022-11-03 0

-

ST MCU边缘AI开发者云 - STM32Cube.AI2023-02-02 0

-

恩智浦最新的应用处理器 i.MX 95采用专有NPU IP进行片上AI加速2023-02-16 0

-

【书籍评测活动NO.18】 AI加速器架构设计与实现2023-07-28 0

-

《 AI加速器架构设计与实现》+第2章的阅读概括2023-09-17 0

-

高通交付首批CloudAI100加速器和边缘方案开发套件:从终端到云端AI的联合2020-10-28 2461

-

AI边缘计算盒子是如何推动边缘AI应用落地的2023-05-26 704

-

Arm推出新一代Ethos-U AI加速器及全新物联网参考设计平台2024-04-09 537

-

Arm推第三代边缘AI加速器:Arm Ethos-U852024-04-16 121

-

Arm发布新一代Ethos-U AI加速器 Arm旨在瞄准国产CPU市场2024-04-18 305

-

Arm平台赋能移动端生成式AI2024-04-26 354

全部0条评论

快来发表一下你的评论吧 !