网络爬虫教程(2):迷你框架设计

嵌入式技术

描述

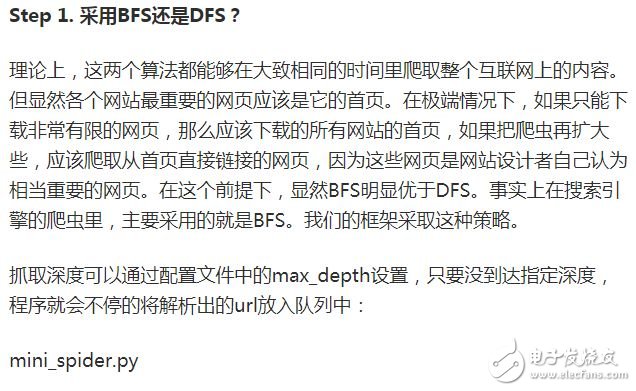

回顾上一期,我们在介绍了爬虫的基本概念之后,就利用各种工具横冲直撞的完成了一个小爬虫,目的就是猛、糙、快,方便初学者上手,建立信心。对于有一定基础的读者,请不要着急,以后我们会学习主流的开源框架,打造出一个强大专业的爬虫系统!不过在此之前,要继续打好基础,本期我们先介绍爬虫的种类,然后选取最典型的通用网络爬虫,为其设计一个迷你框架。有了自己对框架的思考后,再学习复杂的开源框架就有头绪了。

今天我们会把更多的时间用在思考上,而不是一根筋的coding。用80%的时间思考,20%的时间敲键盘,这样更有利于进步。

语言&环境

语言:带足弹药,继续用Python开路!

一个迷你框架

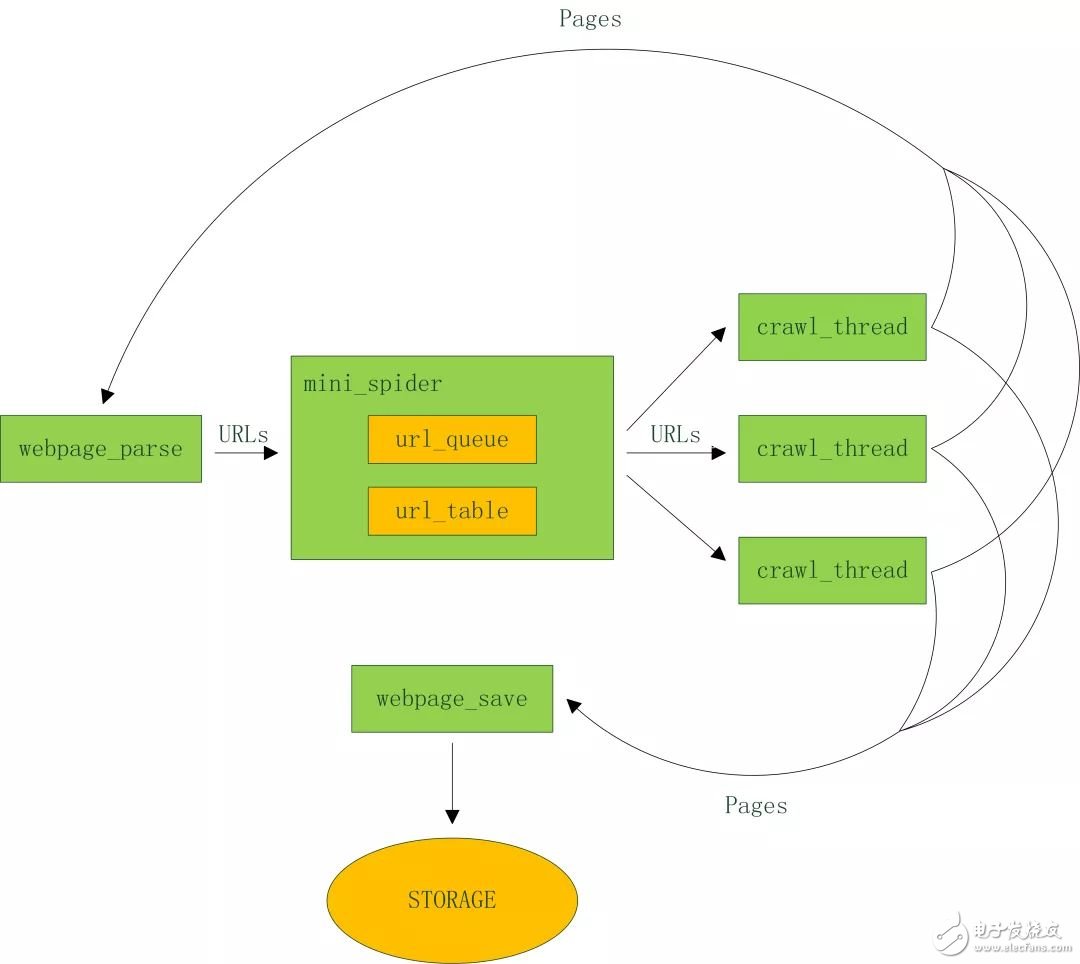

下面以比较典型的通用爬虫为例,分析其工程要点,设计并实现一个迷你框架。架构图如下:

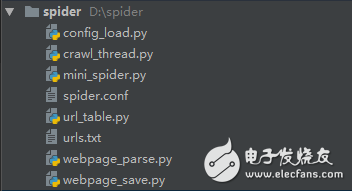

代码结构:

config_load.py 配置文件加载

crawl_thread.py 爬取线程

mini_spider.py 主线程

spider.conf 配置文件

url_table.py url队列、url表

urls.txt 种子url集合

webpage_parse.py 网页分析

webpage_save.py 网页存储

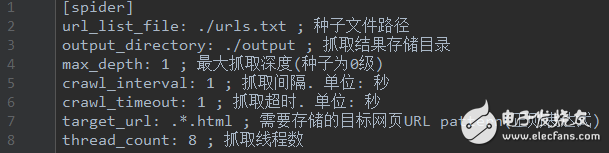

看看配置文件里有什么内容:

spider.conf

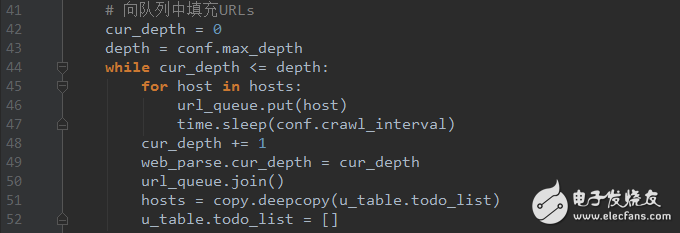

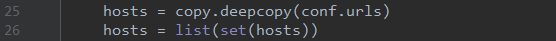

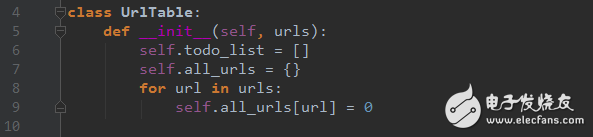

url_table.py

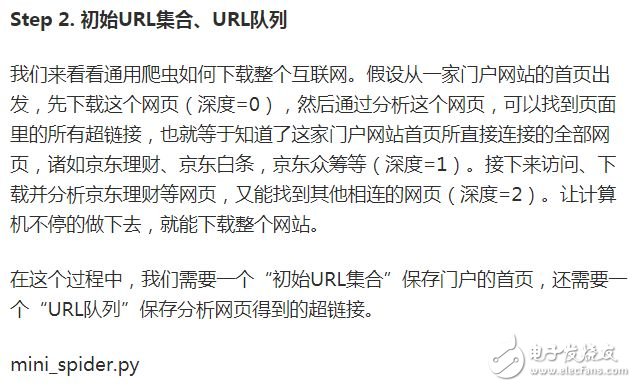

Step 3. 记录哪些网页已经下载过的小本本——URL表。

在互联网上,一个网页可能被多个网页中的超链接所指向。这样在遍历互联网这张图的时候,这个网页可能被多次访问到。为了防止一个网页被下载和解析多次,需要一个URL表记录哪些网页已经下载过。再遇到这个网页的时候,我们就可以跳过它。

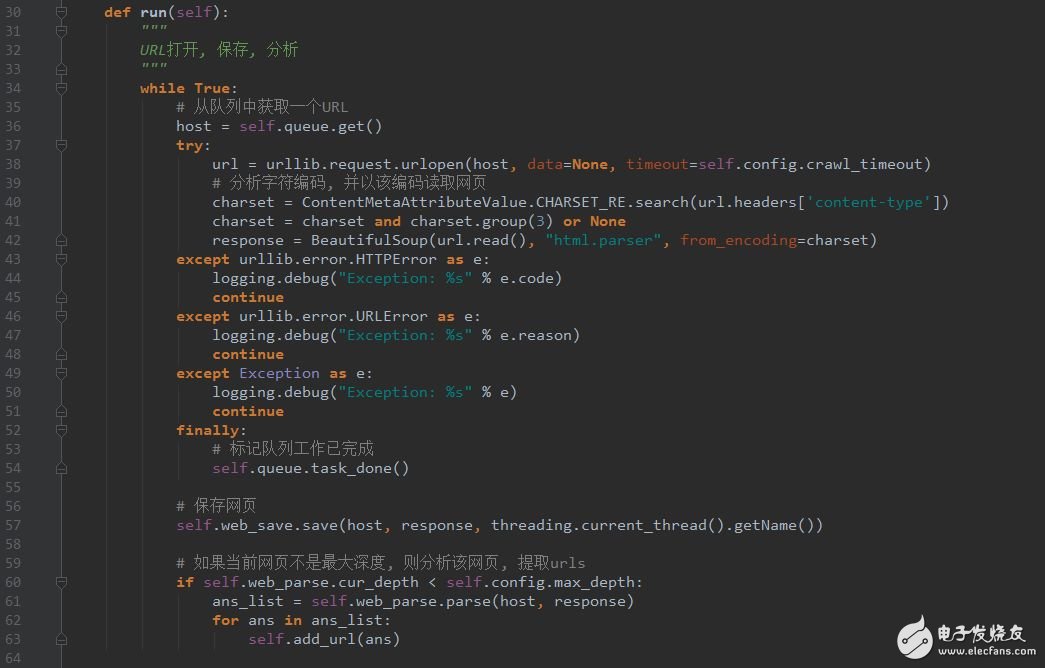

crawl_thread.py

Step 5. 页面分析模块

从网页中解析出URLs或者其他有用的数据。这个是上期重点介绍的,可以参考之前的代码。

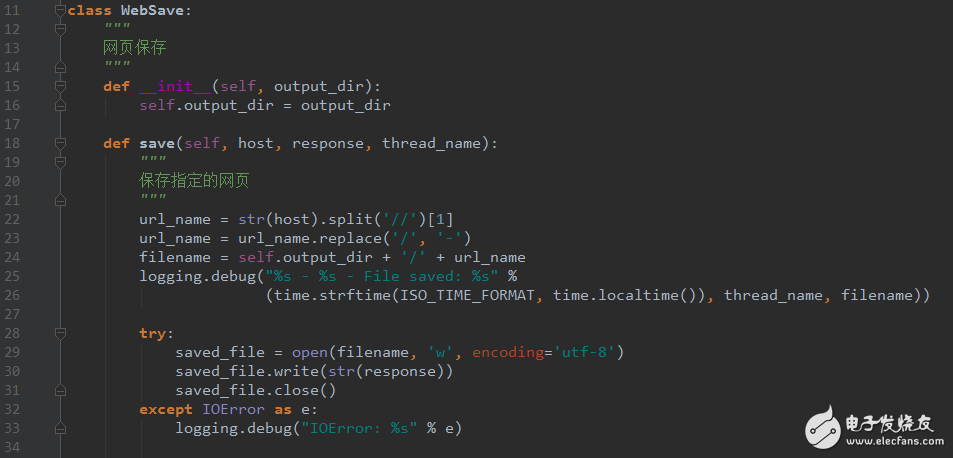

Step 6. 页面存储模块

保存页面的模块,目前将文件保存为文件,以后可以扩展出多种存储方式,如mysql,mongodb,hbase等等。

webpage_save.py

写到这里,整个框架已经清晰的呈现在大家眼前了,千万不要小看它,不管多么复杂的框架都是在这些基本要素上扩展出来的。

-

Python爬虫与Web开发库盘点2018-05-10 0

-

爬虫框架scrapy包括了以下组件2019-04-03 0

-

什么语言适合写爬虫2020-02-03 0

-

网络爬虫之关于爬虫http代理的常见使用方式2020-04-26 0

-

网络爬虫nodejs爬虫代理配置2020-09-01 0

-

Golang爬虫语言接入代理?2020-09-09 0

-

STM32F407的HAL库框架设计2021-08-10 0

-

怎么实现ThreadX内核模板框架设计?2021-11-29 0

-

详细用Python写网络爬虫2017-09-07 715

-

网络爬虫是否合法2019-03-21 11589

-

python爬虫框架有哪些2019-03-22 6453

-

用Python写网络爬虫2021-06-01 588

-

python网络爬虫概述2022-03-21 1664

-

feapder:一款功能强大的爬虫框架2023-11-01 623

全部0条评论

快来发表一下你的评论吧 !