三星新专利公开,显示出将AR Emoji应用到视频聊天的可能

电子说

描述

今年年初三星正式发布了Galaxy S9,同时推出和iPhone X的Animoji非常相似的AR Emoji,它们的功能相差不多,都是用人脸的表情制作出一个动画表情,由此通过社交软件分享给朋友和家人,让聊天变的更有趣。

最近,三星的一份专利公开,显示出将AR Emoji应用到视频聊天的可能。

专利中表示, 现有的视频通信系统和服务, 如 Skype 和 Google 网络, 在运行播放器应用程序的设备之间传输2D 视频流。这种视频通信系统通常将压缩序列图像的视频流传输与设备之间的音频流配对。大多数通信系统都是供单个用户使用, 需要在包含照相机和显示器的计算机设备上运行播放机应用程序。

但这样的视频通信系统在为用户提供视频功能的同时, 也存在一些弊端。例如, 现有的视频通信系统通常需要较高的带宽, 并且在将信号传输到另一个设备之前需要生成和压缩整个图像序列时, 其固有的高滞后时间。所以, 对于低滞后时间和高质量的应用程序, 现有的视频通信系统要求通信设备最好通过 wi-fi、3G 或4G 移动通信技术进行传输。

因此, 需要有一个可视化的通信系统, 能够显示用户的实际肖像, 面部表情和实时的运动, 同时减少带宽。

根据专利的说明, 发送3D 网格模型更新数据比一般传输方式发送图像序列需要的带宽要少得多, 从而允许在带宽较小的环境中进行流畅的通信,可以解决前述问题。

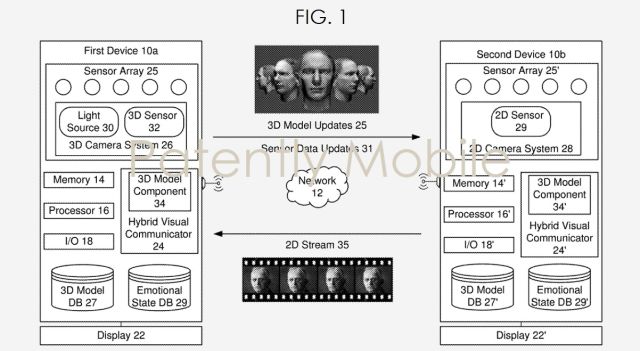

这项专利主要是两个设备之间视觉通信的方法和系统。包括创建第一个设备用户的3D 网格模型;在二个设备之间的可视通信会话期间接收传感器阵列中的传感器数据, 其中图像数据包括第一个设备用户的运动方式,第二个设备由图像数据确定3D 网格模型的变化,将3D 网格模型更新显示出来。

具体来说, 在第一个设备上, 记录对3D 网格模型的更改和发送更新数据比获得新图像并且将图像压缩到图像序列中的滞后时间更低。

在第二个设备上, 不需要等待整个图像的传输和解压缩循环,可以一次更新3D 网格模型。即使第二个设备不支持3D 视频通信的情况下, 第二个设备仍然可以通过对3D 网格模型的分析,显示出2D的图像,同时通过传统的2D 视频传输方案将图像传输给第一个设备。

在专利的一个案例中, 视频模式的可能由用户手动选择。例如, 系统确认第一个设备包含3D摄像头系统, 那么据可以允许用户在3D视频模式或2D视频模式之间选择。如果混合视觉通信器发现该设备仅包括2D 摄像头系统, 则混合视觉通信可能默认为2D 视频模式,系统也可以根据可用带宽自动向用户建议2D 视频模式或3D 视觉模式, 并在可视化过程中根据带宽的变化动态更改视频模式。

这个图片用于说明创建出的用户的脸部和头部的3D 网格模型

三星的专利规定, 新的视觉通信应用将能够与各种操作系统, 如 Android, 黑莓, 窗口和 iOS。

另一个有趣的点是,除了从摄像头和深度传感器接收图像数据外, 它还可能接收与可视化通讯会话上下文相关的其他传感器数据, 比如环境条件数据和用户的身体数据,用户的身体数据包括位置传感器(加速度计、陀螺仪等) 和生物识别传感器(如心率传感器、电偶皮肤传感器、瞳孔膨胀传感器等),将此用于确定用户位置的移动和情绪状态。同时,3D 模型组件还可以存储不同的面部表情, 以及不同可选姿势供用户选择。

必须说明,三星在2013年就开始了这方面的研究,2016年就第一次提交这份专利,最开始的时候,专利只是为了减少对视频时带宽的需求,提出一种用于进行视频聊天的 "3D 网格模型"。这个3D 模型只会对用户的面部表情作出反应, 只有这些表情的变化会被传送。相对于一般的传输方案, 这样对带宽的要求更少。

巧合的是, 这个专利在三星推出AR emoji之后通过,但三星只是有可能会应用这个技术,到现在为止也并没有官方在这方面的说明。但至少,这项专利可以说明三星一直都在探索增强现实模型的应用。

-

定制开发俄罗斯轮盘视频聊天chatroulette聊天轮盘2010-03-19 0

-

高清端在线视频聊天插件软件平台2010-12-16 0

-

三星半导体发展面临巨大挑战2012-09-21 0

-

三星发言人否认将终止同苹果LCD面板合作关系2012-10-23 0

-

三星液晶显示器拆卸2012-12-06 0

-

三星韩国主场告苹果 矛头指向通知中心2012-12-22 0

-

夏普将沦为三星OEM代工厂?2013-08-05 0

-

三星专利战惨败 苹果十天后获$5.4亿赔款2015-12-07 0

-

局域网的在线视频聊天,如何将其结合起来完成局域网内的远程的视频聊天2018-01-05 0

-

三星曝光3种保护膜专利:唯一具有UTG功能的设备2020-05-23 0

-

三星新LED液晶电视加入视频聊天功能2010-03-04 1093

-

Snapchat移动应用再添功能,新群组视频聊天中强调AR2018-04-06 5390

-

三星公布新专利,能够让用户通过3D面部模型同好友进行视频聊天2018-06-15 2717

-

Facebook推出智能视频聊天设备2018-10-21 539

-

三星电子继苹果之后也宣布推出迪士尼AR Emoji角色2019-06-22 2539

全部0条评论

快来发表一下你的评论吧 !