Arm已经主宰了CPU的IP领域也接管了GPU

电子说

描述

目前约有十几种加速用户端机器学习(machine learning)任务的处理器核心正在角逐系统SoC市场,其中一些已经被设计于智能手机中。其目标在于取得比处理器IP巨擘Arm更早进入市场的先发优势,但预计Arm很快就会发布自家的产品。

市场观察家The Linley Group的首席分析师Linley Gwennap在Linley处理器大会(Linley Processor Conference)发表专题演讲之前接受《EE Times》的访问。他表示,这场竞争态势显示机器学习芯片的许多举动正开始转向低功耗的用户端区块(block)。然而,在高性能的资料中心芯片之间,竞争仍处于初期阶段。

Gwennap说:「Arm已经主宰了CPU的IP领域,也接管了GPU,但人工智能(AI)引擎为核心芯片创造了一个全新的市场,让其它公司也能取得一个好的开始。」

这一市场中值得关注的新竞争对手与产品包括:

苹果(Apple) iPhone智能手机中,A11 SoC内建的Bionic生物神经网路引擎

三星(Samsung )Galaxy S9手机中,Exynos 9810处理器内建的DeePhi区块

华为(Huawei)麒麟970 (Kirin 970)手机中的寒武纪(Cambricon)神经引擎

联发科(MediaTek) P30 SoC中用于视觉和AI加速的Cadence P5 DSP

英特尔(Intel)未来PC芯片组中可能使用Movidius加速芯片

现有的AI芯片设计订单已经锁定了在整个手机市场中约占三分之一的高阶智能手机应用。Gwennap并预计,AI加速将在未来2~3年内渗透到手机市场的其它部份。

除了智能手机,汽车对AI芯片来说也是一个越来越大的市场。还有个人电脑(PC)、平板电脑和物联网(IoT)装置很快地也将充斥整个市场。

为了跟上步伐,Arm在今年二月宣布了一项名为'Project Trillium'的完整平台。但是,Gwennap说:「他们必须在一些最佳化电源效率的特定硬体加速器方面更具有竞争力。」

「Arm目前正着手开发这一类加速器,并计画在今年夏天发布其首款产品…但事实上,他们的进度已经落后了,这让一些新公司有机会尽快卡位。」

去年10月,Arm宣布组建了一个机器学习小组。今年2月更进一步提供该计画的若干细节。

Arm可能会在今年10月份于矽谷举行的年度活动中发表产品详情。但这并不能保证Arm将收复失地,因为神经网路引擎和CPU之间并不一定存在密切关系。

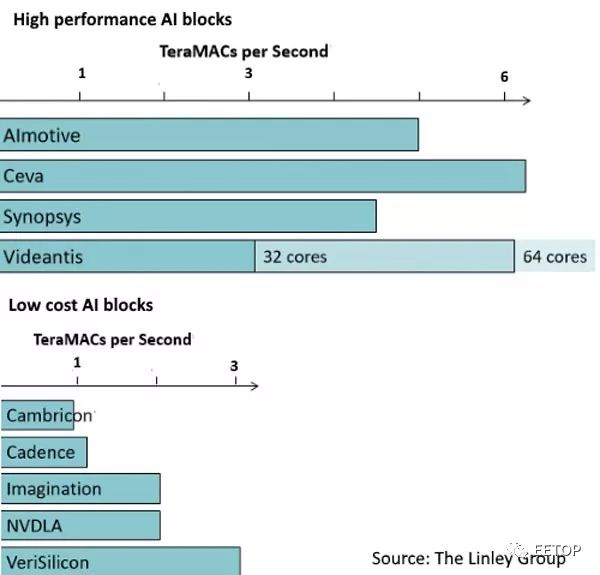

迄今所宣布的用户端推论加速器之原始性能数据,仅能反映部份现实(来源:The Linley Group)

基准和资料中心的竞争

最终,能在这场仍算是新战场中获胜的芯片将是集性能、功耗和芯片尺寸等优势于一的最佳组合。

Gwennap说:「问题在于我们看到了原始性能,但它实际上可归纳为在神经网路上提供的性能。所以,我们需要的是一个良好的基准,例如每秒钟可分类多少影像等。」

百度(Baidu)率先将AI基准作为开放来源发布,但尚未被广泛采用。交易处理委员会(Transaction Processing Council)去年底成立了一个工作小组来处理这个问题,但尚未提报任何进展。

他说:「提出基准并不难,但要让各家公司同意并比较结果可不简单…如今事情正在改观,所以,任何基准都必须发展,才能与时俱进。」。

目前为止,Gwennap的报告称,Videantis的多核心v-MP6000表现较其最接近的竞争对手Ceva NeuPro略具有原始性能优势。Ceva NeuPro将SIMD DSP与脉动MAC阵列相结合。

其它厂商还包括新思科技(Synopsys)的EV64,它结合了SIMD DSP与用于启动和池化(pooling)的客制逻辑。如同Videantis一样,AImotive AIware也使用了许多客制硬体区块。

在低成本的区块中,芯原微电子(VeriSilicon)的VIP8000-O采用具有多达8个深度学习引擎的GPU提供大部份的原始性能。令人不解的是,在所发布的芯片中,寒武纪的CPU采用小型矩阵引擎所提供的性能最低,但仍取得华为智能手机应用的重要订单。

英国芯片公司Imagination也携其PowerVR 2NX入局,PowerVR 2NX采用支援MAC阵列的客制非GPU架构。Nvidia则为其Xavier处理器的深度学习加速器(NVDLA)核心架构提供免费且开放的IP,并获得Arm的支持。

整体而言,Gwennap表示有多达40家公司都在设计客制的AI芯片。其中许多都锁定了资料中心应用,但在这个领域,Nvidia Volta GPU的地位稳固,并成为亚马逊(Amazon)等巨擘所选择的训练引擎。

Gwennap说:「我们现在看到的竞争对手是Google TPU和微软(Microsoft)基于FPGA的Brainwave——目前正被广泛部署,但至今还没有许多商用替代方案可供选择。」

「今年,在将新的AI资料中心架构投入生产方面,Wave Computing似乎领先一步。」

Wave Computing销售完整系统的决定显示其目标放在二线和三线(tier)业者,而不是喜欢制造自家最佳化产品的大型资料中心。

英特尔旗下的Nervana最近明确表示,要到2019年才会投产芯片。深度学习新创公司Graphcore声称将在今年稍晚发布新芯片。另一家新创公司Cerebrus则仍保持缄默,而比特币ASIC制造商比特大陆(BitMain)已在去年底宣布用于资料中心的AI芯片计画。

Gwennap说:「业界多家公司正一窝蜂地投入AI芯片领域,他们将其视为下一波淘金热,因而竞相抢搭这班列车。」

-

谈GPU的作用、原理及与CPU、DSP的区别2015-11-04 0

-

大数据和云计算领域将替代CPU+GPU2017-01-12 0

-

GPU,RISC-V的长痛2022-03-24 0

-

Intel即将推出的GPU将与Arm兼容2022-03-29 0

-

联芯科技将在基带芯片上集成基于ARM CPU和GPU的应用处理器2011-05-01 1774

-

无惧Intel,ARM誓言成微晶片主宰2012-03-18 601

-

ARM发布新的高性能CPU和GPU设计2018-06-08 4309

-

Arm即将推出新一代的旗舰CPU、GPU和NPU2020-05-28 3919

-

Arm十年最大升级的V9架构,剑指全面计算,CPU、GPU、系统IP三连发!2021-05-27 7156

-

Arm公布旗下首批采用v9架构的CPU、GPU设计方案2021-06-01 2474

-

新思科技设计、验证和IP解决方案助力Arm全面计算战略2022-07-13 1051

-

安谋科技与此芯科技携手推动Arm CPU产业发展2022-09-21 712

-

封杀自研CPU、GPU 高通指控ARM赶尽杀绝:回应来了2022-10-31 444

-

下一代天玑旗舰移动芯片将采用 Arm 最新 CPU 与 GPU IP2023-05-29 451

-

gpu是什么和cpu的区别2024-02-20 910

全部0条评论

快来发表一下你的评论吧 !