一款基准测量工具的雏形——MLPerf

电子说

描述

AI基准大战已经开始。

5月2日,由各大领先的科技公司和大学组成的团队发布了一款基准测量工具的雏形——MLPerf,其目的是测量各种AI框架和芯片中不同机器学习任务的训练速度和推理时间。

在这一任务的参与者中,有许多知名公司和大学,其中既有谷歌、英特尔、百度、AMD这样的巨头,也有一些AI硬件创企,例如SambaNova和Wave Computing。同时还有世界顶尖大学:斯坦福大学、哈佛大学、加州大学伯克利分校、明尼苏达大学和多伦多大学。

MLPerf的诞生是小部分公司自我组织进行产品对比的结果。上周,RiseML的博客对比了谷歌的TPUv2和NVIDIA V100的性能。5月4日,英特尔发表博客,展示了为机器翻译所用的RNN的数据,题目称“英特尔Xeon大规模处理器表现出令人惊讶的推理性能”。这种对比会给人一些参考,但通常也会让人觉得供应商自认为比其他厂商优越。而一个标准化的基准可以让测试简单化,得到人们想要的结果。

除此之外,想要跟踪记录各大公司和创企的芯片制造以及软件更新是非常困难的,更不要说在市场的夸大作用下还能进行真实评估了。某些芯片厂商经常承诺达到了革命性的提速,但从来不透露产品规格(咳咳,英特尔注意)。

在很长一段时间内,人们都在讨论是否有必要设立一个有意义的AI基准。支持者认为,标准的缺失限制了AI的应用。MLPerf的推动者之一吴恩达表示:“AI正在改变多个行业,但是为了发挥它最大的潜能,我们仍需要更快的硬件和软件。”支持者们希望基准的确立能帮助AI开发者创造出更好的产品,让使用者充分了解所需产品。

MLPerf声明它的基础目标是:

用公平、有帮助的测量方法加速机器学习的发展

对各竞争系统进行公平对比,以鼓励机器学习的发展

保证让所有人都能参与基准评比

既服务于商业群体,也服务于研究领域

基准要可复制,确保结果的可靠

MLPerf是仿效过去其他的基准测试,例如SPEC(The Standard Performance Evaluation Corporation)。该基准于1988年由一家计算公司的财团提出,它有效提高了通用计算的速度。而MLPerf结合了此前许多基准的标准,例如SPEC的程序,SORT用于对比和培育新思想的方法,DeepBench对软件应用的评估,以及DAWNBench的精确度标准。

Intersect360的CEO Addison Snell注意到:“现在许多企业都想部署AI,所以推出一套中立的基准非常重要,尤其在多种技术争相竞争的时代。但是,AI领域多种多样,我不禁怀疑是否最后只剩一种标准。想想五年前人们对大数据和分析的热情,尽管人人都想定义它,但是至今也没有一个通用的衡量标准。我认为AI也会面临这种情况。”

Hyperion研究公司的高级研究副总裁Steve Conway认为:“MLPerf是一款有用、优秀的工具。因为近些年一直缺少针对买卖双方的真正标准。这个基准似乎是针对人工智能早期问题指定的,大多都是有边界问题。后来我们需要其他标准,因为人工智能开始出现了无边界的问题。有边界的问题比较简单,如语音、图像识别或游戏。而无界线问题包括癌症诊断和阅读磁核共振报告;现在,人工智能能为复杂问题提出推荐方案了。“

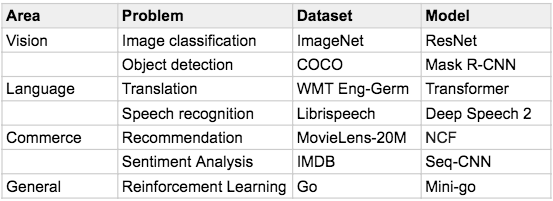

MLPerf现已在GitHub上发布,但仍处于初期阶段,为α版本,未来将在许多方面得到改进。目前,MLPerf套件上能进行测试的有七个方面:

每个参考都提供了以下内容:至少在一个框架中实现模型的代码;一个可在container中运行基准测试的Dockerfile;一个可下载适当数据集的脚本;一个可以运行并计时模型训练的脚本;数据集、模型和机器设置的文档记录。

根据GitHub上的记录,基准测试已经在以下配置中进行测试:

16个CPU,一个NVIDIA P100

Ubuntu 16.04,包括具有NVIDIA支持的docker

600GB的硬盘(尽管很多基准要求的硬盘更小)

在这样一个年轻的市场,如果有更多的AI基准出现,那将变得很有趣。例如,斯坦福大学是MLPerf的其中一个成员,他最近运行了第一个DAWNBenchv1深度学习结果。

斯坦福报道说:“2018年4月20日表示第一个衡量深度学习端到端性能的基准和竞争的开始:测量深度学习任务达到最佳精确度时所需要的时间和成本是多少,以及在这个最先进的精确度水平下进行推理的成本是多少。对端到端性能的关注提供了一种客观的方法,用于对计算框架、硬件、优化算法、超参数设置以及影响性能的其他因素进行标准化。”

DAWN的一个竞争对手——fast.ai(一家提供人工智能培训和开发人工智能软件工具的初创公司)在HPCwire上宣传它的产品性能。所以这些基准很重要,应该认真对待,像MLPerf这样的工具能帮助清除AI产品对比中的干扰因素。

“基准提高了产品可信度,并展示了更好的性能或能带来更多益处的地方。如果你正在考虑为一个数百万美元的项目使用硬件加速器或软件框架,那么你会不会更喜欢’榜上有名’的产品?”谷歌工程师Peter Mattson表示。

MLPerf希望用可复制的、公平可靠的基准测量方法来推动机器学习行业和研究的发展。产品之间的对比还应促进供应商和学者之间的竞争。同时还应该为没人提供做实验的条件,让更多人参与其中。

Mattson补充道:“基准在短期内很重要,因为不管是对研发公司还是想要购买产品的公司来说,硬件是一项巨大的投资。长期来看,基准有助于研究者和供应商将性能作为共同的发展目标,这样才能解锁更多机器学习的能量,造福更多人。”

-

使用LTC6655系列作为基准源设计一款采集器,如何测量设计后基准源的1/f噪声?2024-01-08 0

-

使用LTC6655系列作为基准源设计一款采集器,请教关于基准源1/f噪声测量方法的疑问2018-07-24 0

-

求推荐一款能测量RSSI值的WiFi模块2019-02-14 0

-

请问有人能帮忙推荐一款TI的电压基准芯片吗?2019-06-12 0

-

AD7793 24位Σ-Δ模数转换器是一款低功耗,低噪声,完整的模拟前端,适用于高精度测量应用2019-08-23 0

-

求一款用于通信硬件的开发工具2019-10-22 0

-

一款通用的半导体参数测量工具软件分享2020-07-01 0

-

怎么设计一款温度测量处理变送器?2021-04-14 0

-

分享一款不错的WSN无线测量网络的解决方案2021-05-27 0

-

软硬件协同优化,平头哥玄铁斩获MLPerf四项第一2022-04-08 0

-

英伟达再次称霸MLPerf AI基准竞赛2020-10-28 1597

-

机器学习记录:NVIDIA再次打破MLPerf基准测试的性能记录2020-11-17 1700

-

NVIDIA AI平台在MLPerf基准测试实现飞跃2022-07-01 775

-

MLPerf 扩展 AI 推理基准测试,Nvidia 在所有测试中名列前茅2022-08-18 603

-

NVIDIA 在 MLPerf 测试中将推理带到新高度2023-04-08 402

全部0条评论

快来发表一下你的评论吧 !