谷歌近日发明了一款能自动捕捉精彩时刻的相机

电子说

描述

想记录美好瞬间,手机还没掏出来就结束了,怎么办!不要慌,谷歌近日发明了一款能自动捕捉精彩时刻的相机,它能识别出那些有意义、值得记录的场景,并在博客上公开了这一技术。以下是论智的编译。

对我来说,照相就是在一瞬间,对某件事的本质和组织形式进行同步记录的过程。——Henri Cartier-Bresson

过去几年,AI产品呈现爆炸式增长,深度学习算法让计算机视觉技术能认得一幅好照片满足的各种元素:人物、微笑、宠物、落日、著名地标等等。但是,除了最近的进步,自动拍照仍然是一个非常具有挑战性的问题,即相机能否自动捕捉到一个完美的瞬间呢?

最近,我们发布了Google Clips,这款相机无需手动操作,就能自动捕捉你生活中有趣的时刻。在设计它时,我们遵循了三条重要的原则:

我们想将计算设计成置于移动端的。除了延长电池的寿命并减少延迟,在移动设备中进行处理意味着你所有的照片都不会自动从设备上删除,除非你想保存或分享它们,这是有关隐私控制的关键。

我们想让设备捕捉短视频,而非单一的照片。有动作的时刻才是真正的回忆,并且录像比拍照要容易得多。

我们想捕捉人或宠物随意自然的时刻,而不想拍出一张抽象的艺术照。也就是说,我们不会教Clips考虑构图、色彩平衡、光线等因素,而是要注意选择拍摄的时间,其中要包含人或动物有趣的瞬间。

学习辨认美好瞬间

如何训练一套算法学会辨认有趣的时刻呢?和众多机器学习问题一样,我们先从数据集开始。我们创建了一个含有上千段视频的数据集,视频展示的是不同场景,假设这是用Clips制作出来的。同时,还要保证视频涵盖了不同种族、性别和年龄阶段的人。之后,我们招募了一些专业摄影师和视频编辑师,对这些视频加注并选出最佳短视频片段。筛选之后,剩余的视频让我们对算法最后达到的目标有了概念。但是,只靠这些由人类挑选出来的视频训练算法仍然很困难,我们还需要得到一个平滑的标签梯度,从“perfect”到“terrible”,让算法学会辨认照片的质量。

为了解决这个问题,我们又加入了一种数据收集方法,目的是让模型生成连续高质量的视频。我们吧每段视频分割成一小段一小段的(就像Clips捕捉到的那样),然后随机选取两段作为一组,让人们从中选出他们认为更好地一段。

我们之所以选用这种比较法而不直接让人打分,正是因为二选一比打出具体的分数更容易。我们发现,大家在做二选一时的意见是比较一致的,如果打分的话就不那么统一了。如果某段视频经过足够多的小片段对比,我们就能计算出整段视频的连续质量分数。在这一过程中,我们从超过1000段视频中一共收集了5000万个对比片段,工作量真的非常大!

训练视频片段质量模型

有了上述的质量分数作为训练数据,下一步我们就要训练神经网络模型预测设备所拍摄的照片质量。首先,我们假设:模型如果能知道照片里有什么(人物、狗狗或者大树等等),将有助于提高视频的趣味性。如果这个假设是对的,我们可以学习一个方程,通过辨认照片上的内容预测短视频的质量分数。

为了辨认我们训练数据中的内容标签,我们用了谷歌图像搜索中的机器学习技术,它可以辨认超过27000种不同的标签,包括描述物体、概念和动作等标签。当然,我们不会用到所有的标签,专业的摄影师只从中挑选了几百个他们认为“有趣的”标签。我们还添加了其他能描述照片质量的标签。

标签集建立好之后,我们就需要设计一个紧凑高效的模型,可以预测任意提供的照片。由于计算机视觉技术背后都需要强大的GPU支持,想让算法在移动设备上运行很可能会使速度降低许多。为了训练这个移动设备模型,我们首先建立了大型照片数据集,然后用谷歌的图像识别模型预测每个被打上“有趣”标签的照片可信度。然后训练一个MobileNet图像内容模型(ICM),模仿谷歌模型的预测结果。这样这一紧凑的模型就能够辨认出照片中最有趣的元素了,同时还能忽略不相关的内容。

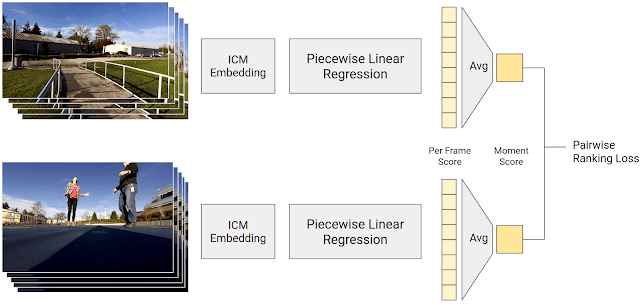

最后一步,就是要根据ICM判断的内容预测单张照片的质量分数。这一分数是由一个分段线性回归模型计算出来的,它结合了ICM的输出和帧质量分数。这个帧质量分数是由视频片段组合成摸个静止时刻的分数再取平均数得来的。通过让人们对两个视频片段进行对比,我们的模型应该会计算出比人类更高的分数。这一模型经过训练,所以它的预测尽可能地和人类的选择相似。

生成帧质量分数的训练过程。分段线性回归将ICM的嵌入映射到一个分数

这一过程训练出的模型既有谷歌图像识别技术,又加入了人类打分员的评分。虽然由数据生成的结果很好地定义了哪些是“有趣时刻”,但我们仍然在某些情境中加入了额外分数,因为我们希望能让Clips捕捉到,包括人脸、微笑、宠物等。在最近的版本中,我们还加入了例如拥抱、亲吻、跳跃、跳舞等特殊的动作。分辨这些活动需要扩展ICM模型。

拍照控制器

有了预测场景趣味性的模型,Clips相机可以实时决定该捕捉哪些镜头。模型的拍照控制算法遵循了以下三个原则:

分别供能 & 热成像:我们想让Clips的电池续航大致达到3个小时,并且不想让设备过热。Clips大部分都在捕捉帧的速度是每秒一帧,这是不怎么耗电的。如果捕捉的帧的质量超过了Clips最近设立的范围,它就会编程每秒捕捉15帧,这是非常耗电的模式。Clips会在之后保存第一个质量最高的图片。

避免重复:我们不想让Clips一次捕捉所有的动作,同时忽略其他部分。我们的算法会将看起来相似的视频集合起来,然后限制其中的数量。

后见之明:当你检查捕捉到的全部片段后,才能决定哪一片段更好。所以,Clips会收集比预定要多的片段。当这些视频要被转换到设备上前,Clips会再次检查,将最佳的、最独特的视频传到设备上。

机器学习的公平性

为了保证我们的视频数据集具有多样性,我们还创建了一些其他的测试,保证算法的公平性。我们创建了一个控制变量数据集,其中的样本对象拥有着不同的性别和肤色,保证其他因素(视频类型、时长、环境条件)相同。然后,我们用这一数据集测试我们的算法,结果表明虽然对象不同,但性能相似。为了检测出当改进视频质量模型时所出现的公平性减弱,我们在自动系统中加入了公平性检测。软件中的任何改变都会经过这一测试。需要注意的是,这一方法并不能保证绝对的公平,因为我们不可能测试任何可能的产经和输出。然而,我们相信这些步骤对于达到机器学习的公平是很有帮助的。

-

谷歌的自动驾驶汽车是酱紫实现的吗?2011-06-14 0

-

求一款能安装的PCBlayout软件啊!2012-05-17 0

-

名校学生逃课四月发明自动种树机器人2016-03-09 0

-

求教工业相机的哪一款性价比高?2016-03-30 0

-

求大神推荐一款能控制CCD相机自动拍照的芯片2016-10-19 0

-

能介绍一款2MHz的功放芯片吗2016-10-31 0

-

编程语言简史:有人讨厌花括号,于是他发明了Python2018-02-01 0

-

SuperEye一款内置CPU的相机--mangotree出品2018-03-31 0

-

苹果正开发一款平价版HomePod智能音箱 将挂旗下Beats商标2018-05-30 0

-

驴友强烈推荐的一款4K运动相机,用过都说好!2018-12-20 0

-

如何设计一款基于高性能DSP芯片的同步可调式双筒望远数码相机?2021-06-04 0

-

基于语音识别做一款能识别语音的App2022-03-01 0

-

Yi Halo是一款不一样的VR相机,可在谷歌的Jump平台上运行2018-09-03 3435

-

基于多相机捕捉系统下的通用物体运动捕捉方法2021-06-25 489

-

GM系列动作捕捉相机阐述2022-09-05 780

全部0条评论

快来发表一下你的评论吧 !