FPGA的瓶颈被突破,双目的大规模应用即将到来!

描述

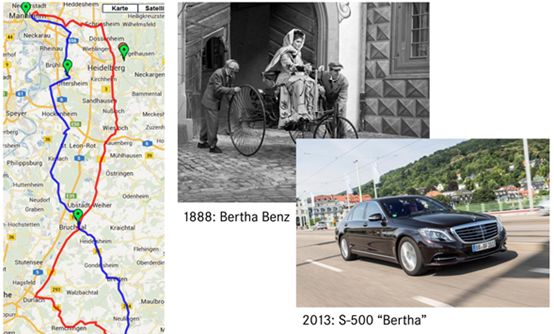

在1888年8月,奔驰创始人卡尔奔驰的妻子Bertha Benz开着丈夫发明的三轮内燃汽车从德国Mannheim到达Pforzheim,这次大约100公里的历程标志着现代汽车的诞生。

125年后,2013年8月,奔驰沿着当年的路程,又走了一遍,不过这次是无人驾驶,为了向前辈以及前辈的贤内助致敬,奔驰将这辆基本没改装过的奔驰S500亲切地称之为Bertha。

Bertha的核心传感器是一个1024*440像素的FOV为45度的双目,奔驰将双目基线长加大到35厘米,主要为了覆盖更远的距离,标准版S级双目为30厘米。双目的SGM和棒状像素计算都使用FPGA完成,每帧图像可以做到40万个独立深度测量。剩下的计算奔驰用一个FOV为90度的单目识别红绿灯,用一个FOV为90度的单目做基于特征的辅助定位。另外还有4个120度的中距离毫米波雷达,KIT提供了高精度地图,地图包括限速、斑马线位置、停止线、道路曲率等。由于是郊区行驶,奔驰只用了GPS,并未用外置惯性导航系统。这也是最接近量产的L4级无人车。

双目相比单目有着压倒性的绝对优势,单目能做到的,双目都能做到,单目却做不到双目的3D立体视觉。以红绿灯检测为例,Mobileye闯红灯的视频想必大家都看过了,识别红绿灯是感知环节最难的技术点之一,百度和谷歌都是利用各自拥有的街景图片库资源,利用先验信息,设定好ROI,以此提高识别红绿灯的准确率。然而街景的更新速度很慢,在快速发展的中国或许不合适,在美国就比较合适。即便如此,Waymo也出现过闯红灯的视频,如果没有街景配合,单纯单目的红绿灯识别率相当低。更致命的是,我国的红绿灯千奇百怪,尤其是天津,一条路上有五种红绿灯,简直是无人车的噩梦。而V2X还遥遥无期。

目前有三种双目识别红绿灯方法,第一种是用目标候选区滤波法,在目标候选区分析视差值,将前景与背景分离,无需先验知识。

第二种是关联位置滤波法,这种方法需要先验知识,就是统计红绿灯的3维位置信息,特别是红绿灯的高度,还有与斑马线的直线距离,与路沿的直线距离。当无人车上线行驶时可以获得目标的三维距离信息,与先验知识库做滤波。这种方法可以大幅度提高红绿灯识别率。有时只需要红绿灯的高度信息,相对街景,这个先验知识可以轻松获得。

第三种方法,即再投影法。将真实世界的红绿灯建模,同时增加深度测量数据,将红绿灯假想再投影到红绿灯模型内,再配合深度测量数据判断是不是红绿灯。无论那一种,都要比单目好得多。

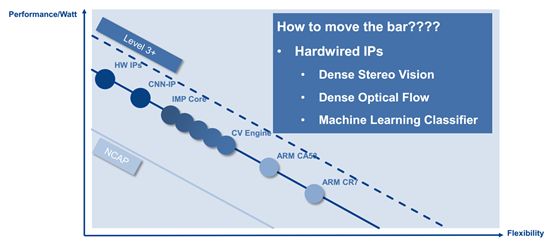

双目的立体匹配几乎都要用FPGA完成,懂算法又懂FPGA的人才非常罕见,FPGA价格也比较高,这限制了双目的应用。加上FPGA厂家都位于美国,中国企业对此是有所顾虑的。美国对FPGA的销售是睁一只眼闭一只眼,一旦较真起来,很可能买不到计算单元超过10万的FPGA。单目的应用几乎不用考虑硬件,价格低廉,因此应用远比双目广泛。

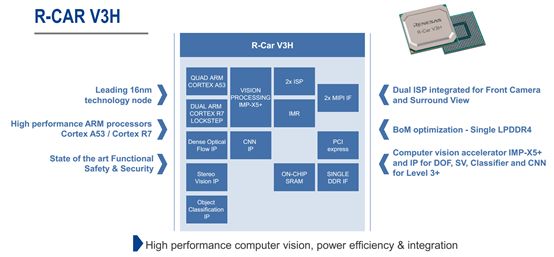

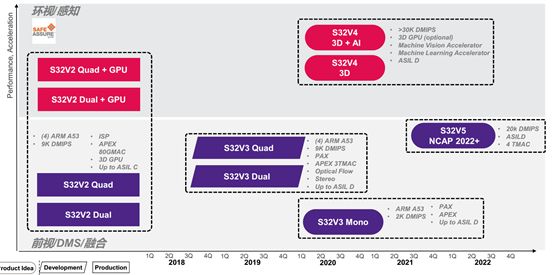

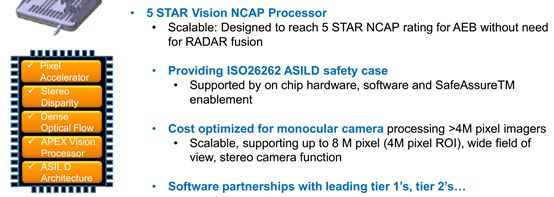

不过这种现象将在未来几年有大幅度改观。全球前三大汽车处理器厂家的两大都推出了专用双目设计的处理器,这就是瑞萨的R-CAR V3H和NXP的S32V3系列。两者都是在2018年3季度有样片。双目可以不用FPGA了。

先来看瑞萨的R-CARV3H。

R-CAR V3H目前已确定获得日产和丰田的订单,日产将全线使用R-CAR V3H,包括高速公路自动驾驶,遥控泊车,全自动泊车,塞车辅助,无限制条件的AEB(L2阶段的限制条件极多)。

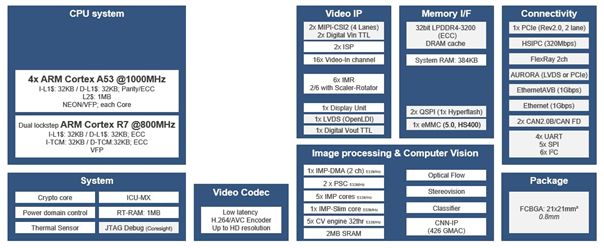

R-CAR V3H的运算能力达到4.2TFLOPS,超过Mobileye EyeQ4的3TFLOPS,制造工艺上R-CAR V3H拥有绝对优势,台积电的16纳米FinFET工艺完胜意法半导体的28纳米FD-SOI工艺。当然Mobileye EyeQ4比R-CAR V3H要早两年,但R-CAR V3H还有强大的CPU系统,包含4个A53和一个拥有锁步功能的R7,这就意味着R-CAR V3H应该能满足ISO 26262 ASIL-A或B级标准而不是Mobileye那样只能通过AECQ-100 1级标准。

上图为R-CAR V3H的内部框架图

R-CAR V3H针对L3+级车辆,包含了立体视差和光流硬核IP,效率与FPGA相当,或许比FPGA略好。

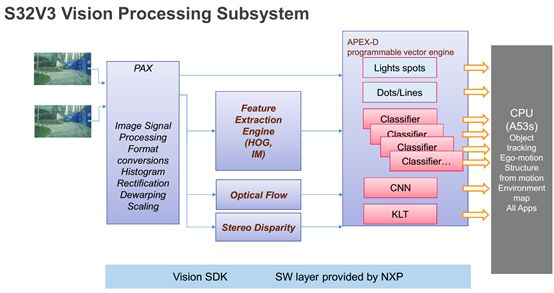

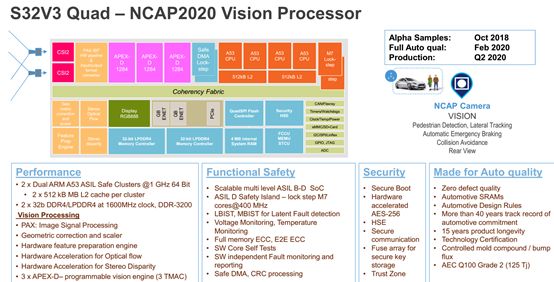

NXP计划在2018年3季度推出S32V3的样片,和V3H一样也是立体视差和光流硬核IP。

S32V3最高可达ASIL-D级,安全等级远超Mobileye。

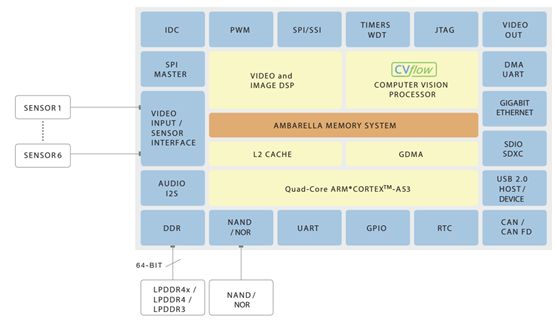

S32V3内部框架图

除了NXP和瑞萨这两家顶级企业,还有行车记录仪芯片巨头安霸的产品,运算性能比Mobileye即将在2018年3季度问世的EyeQ5还要强。安霸在2015年以3000万美元的价格收购了意大利初创公司VisLab,这家公司由意大利帕尔马大学团队创立。目前,其创始人Alberto Broggi教授担任安霸自动驾驶业务的负责人。

安霸第一代自动驾驶用芯片CV1能够对应两个800万像素的双目立体视觉,运算力达到2TFLOPS。采用索尼的IMX317图像传感器,像素精度可达3840*1728,如此高的像素,即使在FOV为75度30厘米基线的情况下也可以达到300米的有效距离,远超大部分激光雷达的有效距离。

激光雷达的有效距离与物体反射率关系极为密切,通常厂家只给反射率为80%时的有效距离,对于白色车辆,反射率可能只有10%,有效距离会缩短到80%时的1/3甚至更少。一般MEMS激光雷达在10%反射率下有效距离只有30到70米,机械旋转型的略好。

CV1可以直接输出一张视差图,帧率每秒一帧。同时还内含路障或隔离栅检测,路沿与车道线检测,交通信号检测,一般障碍物检测。

CV1只是安霸试水作品,安霸在2018年初推出CV2AQ,运算性能提高10倍,大约为14TFLOPS,三星的10纳米工艺制造,通过了AEC-Q100 2级标准。

这款芯片异常强大,可以同时处理3200万像素的数据,可以同时对应6个双目,包括两个800万像素的双目和4个200万像素的双目。而CV1仅能对应1个800万像素的单目。

随着FPGA的瓶颈被突破,双目的大规模应用即将到来!

-

Veloce平台在大规模SOC仿真验证中的应用2010-05-28 0

-

物理网时代即将到来了2014-07-23 0

-

【经验分享】大规模FPGA设计中的C/C++解决方案2015-01-13 0

-

FPGA系统功耗瓶颈的突破2018-10-23 0

-

大规模MIMO的利弊2019-06-18 0

-

大规模MIMO的性能2019-07-17 0

-

真正虚拟化的测控时代即将到来2019-07-22 0

-

解读全球十大公司物联网战略,一个万物智能的世界即将到来 精选资料分享2021-07-28 0

-

大规模FPGA设计中的多点综合技术2012-01-17 689

-

2020年即将到来,关于Linux和开源给出的五个预测2019-12-26 3419

-

vivo S6即将到来,零界全面屏与升降摄像头设计2020-03-11 3568

-

无人机送货的“人在家中坐,货从天上来”场景或即将到来2020-09-01 2429

-

能量收集和物联网发展的转折点即将到来2021-03-19 453

全部0条评论

快来发表一下你的评论吧 !