详细分析网络、存储、RAM和缓存的融合

电子说

描述

自文明的曙光乍现以来,磁盘驱动器和RAM(随机存取存储器)之间不堪的I/O关系一直是计算瓶颈。SSD(固态硬盘)的出现松缓但却并没有改变这一I/O瓶颈。有三项进展正在密谋将这个瓶颈推向CPU(中央处理器)。

首先,近十年,访问速率和联网速率分别登顶25Gb/s和58Gb/s,且在向100Gb/s逼近。计算机可以像访问自己的磁盘一样快地将数据从远程系统移动到自己的磁盘上。其次,磁盘和RAM之间的I/O屏障即将消失;在这之后,RAM和缓存之间的障碍也就随之土崩瓦解。

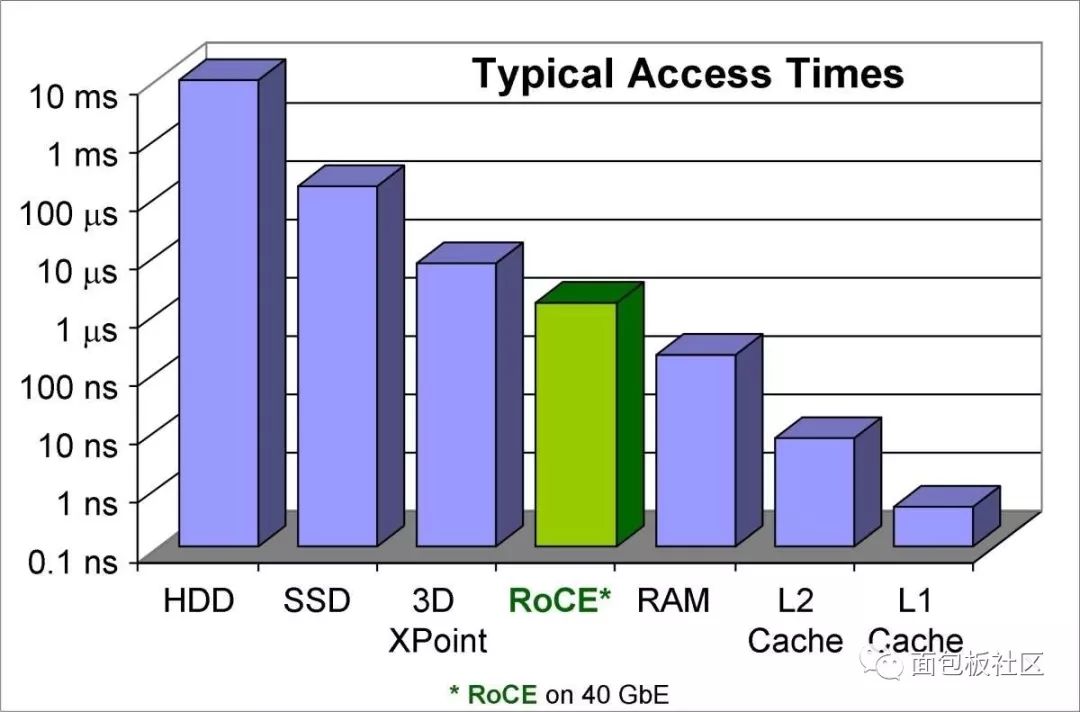

想象一下你所有的内容都在RAM硬盘中,但不仅仅在RAM中,还在L1缓存内。你可花不到2000美元买一台带64GB RAM的上好电脑,但想象一下艾字节(EB)大的缓存容量。这是个很大的数,只需5EB就可装下人类所说过的所有话。来看下图1中的图表。

图1:HDD(硬盘驱动器)、SSD、新型超高速存储器、融合以太网上的RDMA(RoCE)、L2缓存和L1缓存的访问时间。(图片来自Infiniband 行业协会。)

硬盘和固态硬盘的磁盘访问时间在左侧,RAM和高速缓存访问时间在右侧。美光(Micron)公司的3D Xpoint NVM(非易失性存储器)技术凸显了这一趋势:新的数据存储技术在朝着RAM存取时间的方向发展。

绿色的RoCE(发音为“Rocky”)列是该难题的第二部分:将网络上的许多NVM“磁盘”直接连接到RAM。 (我给“磁盘”加个引号,是因为固态硬盘与旋转磁盘驱动器的差别就像手机上的按键与 “拨号盘”一样大。)可以肯定的是,RoCE并不是唯一能够实现这个的技术,它只是我所了解的一个。(免责声明:我为Infiniband行业协会撰写过一篇关于RoCE的白皮书《RoCE Accelerates Data Center Performance, Cost Efficiency, and Scalability(RoCE可加速数据中心的性能、成本效率和可扩展性)》;还有其他技术声称可以实现相同的奇迹,其中包括Infiniband本身和iWARP。)

RoCE是个复合缩写词——RDMA over converged Ethernet(融合以太网上的RDMA),其中RDMA代表远程直接存储器访问。DMA(直接存储器访问)一直内置于个人电脑中。它使内部外围器件(磁盘驱动器控制器、声卡、图形卡、网卡等)得以读写系统存储器而不会麻烦到处理器。RDMA将DMA推广到了网络适配器,以便数据可以在不通过CPU或TCP/IP(传输控制协议)的主存储器路径的情况下,在不同服务器上的应用之间传输。也就是说,RDMA使网络接口控制器(NIC)可以直接访问RAM,从而绕过操作系统并且完全没有TCP/IP开销。

这一难题的另一个关键部分是新的NVM技术,如3D XPoint,它是由英特尔与美光合作开发的基于相变的固态NVM,速度会比闪存快1,000倍。该想法是在具有垂直线连接亚微观柱体的三维设计中创建随机存取技术——这些柱体的密度要比传统存储器高10倍。XPoint(crosspoint,交叉点)裸片(图2)具有两个层和一个交叉开关矩阵设计。NAND数据是按数kB的块寻址的,而3D XPoint NVM可以逐字节寻址,延迟时间不超过7µs。由于XPoint芯片可以安装在DIMM上——就在存储器总线上,因此可以消除“磁盘”与RAM之间的差异。

图2:3D Xpoint设计使用堆叠裸片来增加密度。

当3D XPoint和其他新的持久性存储器技术(如3D Super-NOR)将RAM存储器与我们所认为的磁盘存储技术结合在一起时,一切都会改变。在3D XPoint等技术实现其承诺的同时,RoCE将在400Gb/s网络上运行,到那时,磁盘和RAM之间的区别将不复存在。

我们将不再遵循从远程磁盘到本地磁盘、到RAM、到缓存、再到数据处理的供应链,而是直接从“磁盘”到数据处理。我们不仅会将“磁盘”视作甚至比“拨号盘”更过时,而且随着全球的数据都高效存储在RAM中,数据处理将不再受主板和物理位置所限制。本地和云计算之间的区别将会消失,光速将成为设备可做可为的决定性因素,而CPU本身会成为处理瓶颈,摩尔定律也将继续起支配作用。

-

DVI接口详细分析2012-08-11 0

-

工程师应该掌握的20个模拟电路(详细分析及参考答案).pdf2013-04-07 0

-

三极管特性曲线详细分析2015-06-29 0

-

uboot代码详细分析2016-01-29 0

-

详细分析一下USB协议2021-05-24 0

-

详细分析stm32f10x.h2021-08-05 0

-

详细分析了VTIM和VMIN的功能2021-11-05 0

-

请问一下怎样对stm32的启动代码进行详细分析呢2021-11-26 0

-

电子工程师必须掌握的20个模拟电路详细分析2023-09-27 0

-

电子工程师需要掌握的20个模拟电路的详细分析2023-09-28 0

-

uboot1-1-6代码详细分析2015-11-02 817

-

二端口网络的详细分析2015-12-23 837

-

Buck变换器原理详细分析2017-09-15 1156

-

正激有源钳位的详细分析2021-06-16 1214

全部0条评论

快来发表一下你的评论吧 !