Facebook在F8上公布了一项名为3D照片的新功能

电子说

描述

在AR/VR技术逐渐普及的当下,其中3D模型的使用给我们带来了许多便利。但是现今3D模型的制作方法还是掌握在专业人士手中,用户没有任何切实可行的方式来充分利用AR/VR捕捉并分享他们的真实生活。

在刚过去的五月,Facebook在F8上公布了一项名为3D照片的新功能,通过倾斜手机、就能实现3D视角的变化。

适用于人物、动植物还有风景的拍摄,在室内外和不同光线条件下都可使用。而且只需要一个普通的双摄像头智能手机就能够拍摄,而近两年的智能手机,有几家不是双摄像头呢?

近日,Facebook公布了该功能的相关论文,那就让我们一起来看看他们是如何实现的吧。

双摄本身的存在就是能够感知景深,从而进行虚化突出中心,比如人物。(此处仅代表实验所采用的iPhone 7 Plus的长焦摄像头配置,而这也是大多数厂商的配置),这是因为两个摄像头所拍摄到的照片是有差别的,两者间的差别就能提供深度信息,这与我们人眼能够获取深度信息的视网膜差机理一致。

先通过全景拍摄获取图像,也可以只是简单的拍照来获取图像。

再通过卷积神经网络(深度学习)我们就能获得一个较为明确的深度信息图像了。

然后将深度信息图像按照距离分为多层,并用网格表示各个图像。

再按照不同的深度将各个网格不同程度的撕扯变形,最后再拼接在一起就成为了一个3D照片。

原理上这样子一个3D照片就处理完成了,但在实际上的过程问题确是不断出现的。

首先是设备本身的问题,双摄的基线太短了。基线是指拍摄同一位置的两个摄像机之间的距离,最先开始是航拍上的概念,在双摄上我们可以理解为两个摄像头之间的距离。

理论上基线越大越有利于深度信息的获取,短基线会使得测量结果充满不确定性。同时,在拍摄全景时我们的双手肯定会进行抖动,即使防抖功能也不能完全消除。拍摄期间的移动和旋转将会造成误差。

下图是iPhone 7plus的深度图像与其它深度图的对比。a为iPhone 7plus的深度图像。

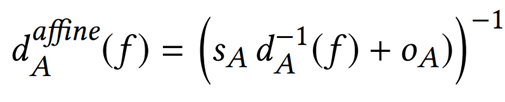

通过他们的全球仿射模型则可以良好的解决这个问题。

将图a变为图b,最后再进行拼接就有了图c了。

同时加上其它的算法,极大的简化了系统。系统所需要考虑的变量只有用户拍摄时手机的姿势,而且降低了短基线所造成的误差。

另外一个问题还是设备造成的,长焦摄像头本身视野就相当窄(垂直37°),所以需要捕捉的图像相较于其他设备也更多,一般场景需要20~200张图像。研究人员使用自动曝光模式来捕捉更多动态范围的场景。

接下来的问题就是怎样把分开的图像再无缝缝合起来。首先,跟踪并计算全景的投影中心,然后找到3D点,最大限度的减少图像之间的距离。

传统方法的拼接会拉伸图像,如果不想形成这样拉伸的三角形,可以选择不将网格撕得那么大,不过这样子就会形成空隙。通过算法的改良,研究人得出了一个较为折中的方案,还存在一些拉伸,但减轻了许多。

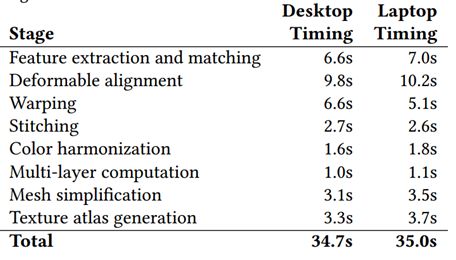

Facebook的3D照片技术,处理一张照片仅仅只需要不到一分钟时间。

技术的限制还是很明显的,就是相机的视野太窄了。如果两个镜头都是广角镜头,只需要捕获少得多的图像就能达到相同的效果,但是双摄是为普通照相而服务的存在,都是广角镜头的手机并不会成为主流。

-

什么?智能手机都能用于3D打印了?2015-12-28 0

-

Facebook 最新推出的虚拟现实世界,简直好玩到炸裂2017-04-21 0

-

为何PCB设计需要3D功能?2017-11-01 0

-

Facebook智能音箱可能先在国际市场推出 隐私问题受到关注2018-05-09 0

-

如何利用3D打印技术做发光字2018-10-14 0

-

NUC8I7BE的3D功能会影响什么吗?2018-10-26 0

-

Intel Q33 express芯片组如何启用2D和3D?2018-11-21 0

-

请问win7系统按f8后没有进入安全模式怎么办呢?2020-09-10 0

-

AD的3D模型绘制功能介绍2021-01-14 0

-

3D建模软件中阵列设计功能如何使用?2021-03-02 0

-

Facebook 新功能:让盲人也能“看见”照片内容2017-01-06 567

-

Facebook推出支持VR模式浏览的新3D图片功能2018-10-12 1336

-

Facebook的焦点2019 F8大会现已开放注册2019-02-25 854

-

Facebook正在测试一项名为“校园”的新功能2020-04-22 1595

-

Google带来一项新功能,用户可以将照片内容通知互联网巨头2020-11-13 1269

全部0条评论

快来发表一下你的评论吧 !