LSTM隐层神经元结构分析,及应用的程序详细概述

描述

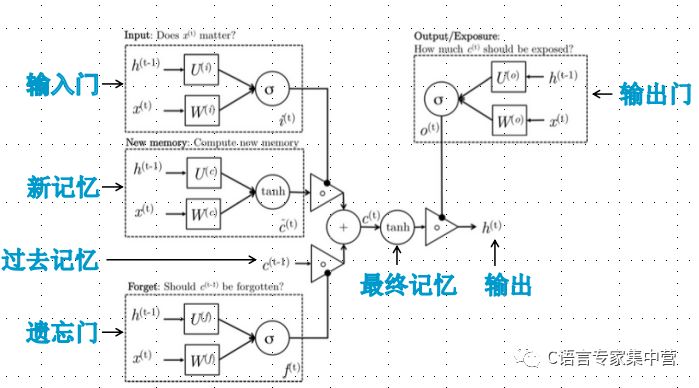

C语言LSTM隐层神经元结构:

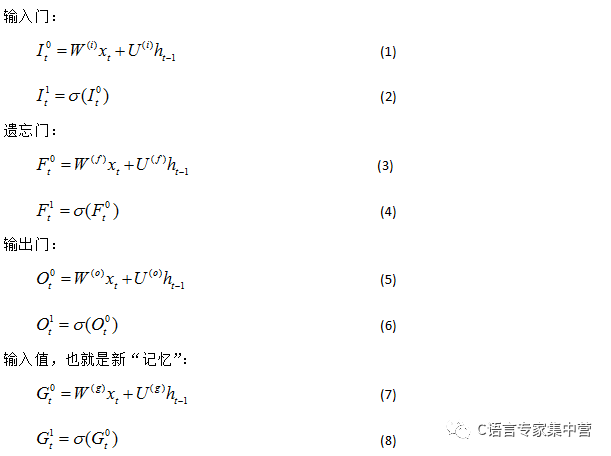

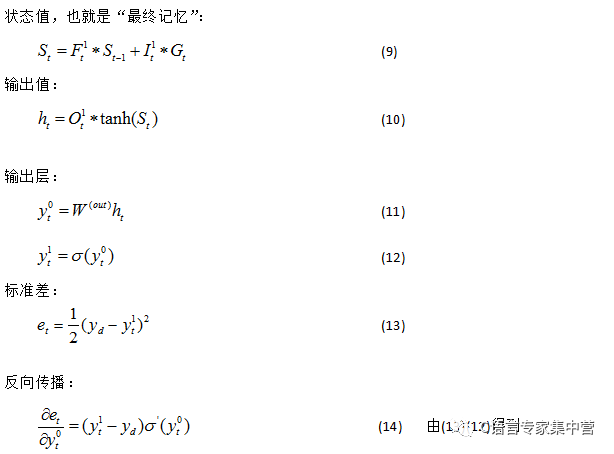

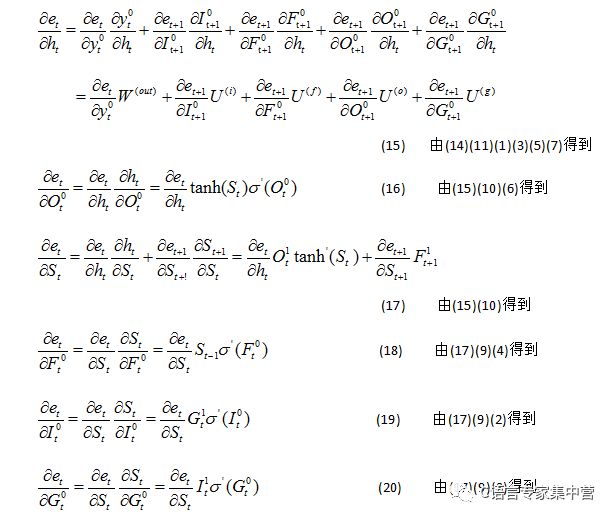

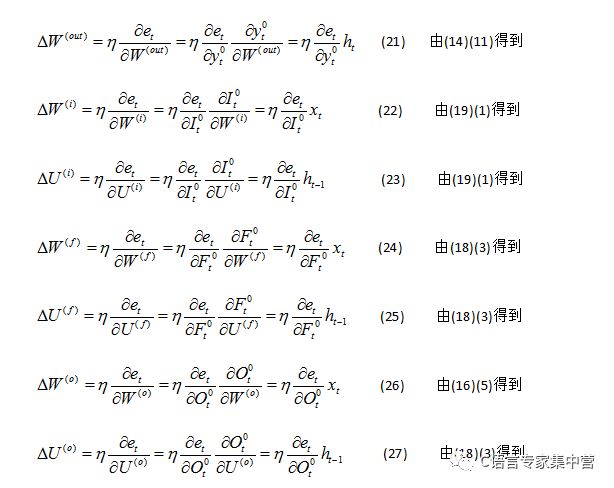

LSTM隐层神经元详细结构:

//让程序自己学会是否需要进位,从而学会加法#include "iostream"#include "math.h"#include "stdlib.h"#include "time.h"#include "vector"#include "assert.h"using namespace std;#define innode 2 //输入结点数,将输入2个加数#define hidenode 26 //隐藏结点数,存储“携带位”#define outnode 1 //输出结点数,将输出一个预测数字#define alpha 0.1 //学习速率#define binary_dim 8 //二进制数的最大长度#define randval(high) ( (double)rand() / RAND_MAX * high )#define uniform_plus_minus_one ( (double)( 2.0 * rand() ) / ((double)RAND_MAX + 1.0) - 1.0 ) //均匀随机分布int largest_number = ( pow(2, binary_dim) ); //跟二进制最大长度对应的可以表示的最大十进制数//激活函数double sigmoid(double x) { return 1.0 / (1.0 + exp(-x)); }//激活函数的导数,y为激活函数值double dsigmoid(double y) { return y * (1.0 - y); } //tanh的导数,y为tanh值double dtanh(double y) { y = tanh(y); return 1.0 - y * y; }//将一个10进制整数转换为2进制数void int2binary(int n, int *arr) { int i = 0; while(n) { arr[i++] = n % 2; n /= 2; } while(i < binary_dim) arr[i++] = 0; }class RNN {public: RNN(); virtual ~RNN(); void train();public: double W_I[innode][hidenode]; //连接输入与隐含层单元中输入门的权值矩阵 double U_I[hidenode][hidenode]; //连接上一隐层输出与本隐含层单元中输入门的权值矩阵 double W_F[innode][hidenode]; //连接输入与隐含层单元中遗忘门的权值矩阵 double U_F[hidenode][hidenode]; //连接上一隐含层与本隐含层单元中遗忘门的权值矩阵 double W_O[innode][hidenode]; //连接输入与隐含层单元中遗忘门的权值矩阵 double U_O[hidenode][hidenode]; //连接上一隐含层与现在时刻的隐含层的权值矩阵 double W_G[innode][hidenode]; //用于产生新记忆的权值矩阵 double U_G[hidenode][hidenode]; //用于产生新记忆的权值矩阵 double W_out[hidenode][outnode]; //连接隐层与输出层的权值矩阵 double *x; //layer 0 输出值,由输入向量直接设定 //double *layer_1; //layer 1 输出值 double *y; //layer 2 输出值};void winit(double w[], int n) //权值初始化{ for(int i=0; i

-

采用单神经元自适应控制高精度空调系统仿真2010-03-18 0

-

神经网络教程(李亚非)2012-03-20 0

-

0028《PID神经元网络及其控制系统》国防工业出版社-2006.pdf2012-12-02 0

-

人工神经网络算法的学习方法与应用实例(pdf彩版)2018-10-23 0

-

神经模糊控制在SAW压力传感器温度补偿中的应用2018-10-24 0

-

基于BP神经网络的手势识别系统2018-11-13 0

-

I2C总线在神经元芯片中的应用2018-12-20 0

-

【PYNQ-Z2试用体验】神经网络基础知识2019-03-03 0

-

【案例分享】基于BP算法的前馈神经网络2019-07-21 0

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 0

-

什么是LSTM神经网络2021-01-28 0

-

径向基函数神经网络芯片ZISC78电子资料2021-04-07 0

-

如何去设计一种自适应神经元控制器?求过程2021-05-17 0

-

卷积神经网络简介:什么是机器学习?2023-02-23 0

全部0条评论

快来发表一下你的评论吧 !