用Python爬去百度贴吧图片并保存到本地

描述

描述:用Python爬去百度贴吧图片并保存到本地。 本人刚学爬虫还不是很熟练,其中难点在于正则表达式的理解;

说明

01

获取整个页面数据

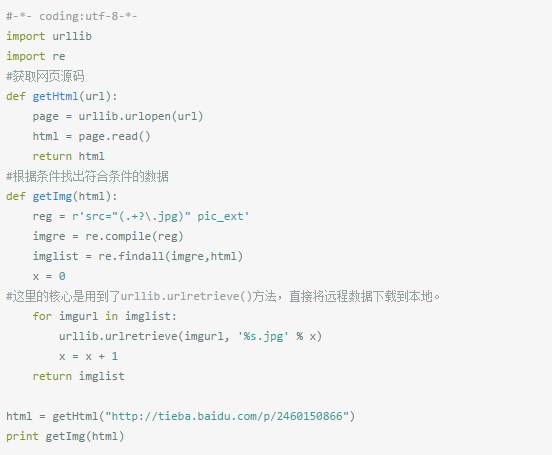

Urllib 模块提供了读取web页面数据的接口,我们可以像读取本地文件一样读取www和ftp上的数据。首先,我们定义了一个getHtml()函数:

urllib.urlopen()方法用于打开一个URL地址。

read()方法用于读取URL上的数据,向getHtml()函数传递一个网址,并把整个页面下载下来。执行程序就会把整个网页打印输出。

02

筛选页面中想要的数据

Python 提供了非常强大的正则表达式,我们需要先要了解一点python 正则表达式的知识才行。 假如我们百度贴吧找到了几张漂亮的壁纸,通过到前段查看工具。找到了图片的地址,如:src=”http://imgsrc.baidu.com/forum……jpg”pic_ext=”jpeg”

我们又创建了getImg()函数,用于在获取的整个页面中筛选需要的图片连接。re模块主要包含了正则表达式:

re.compile() 可以把正则表达式编译成一个正则表达式对象.

re.findall() 方法读取html 中包含 imgre(正则表达式)的数据。

运行脚本将得到整个页面中包含图片的URL地址。

03

将页面筛选的数据保存到本地

通过一个for循环对获取的图片连接进行遍历,为了使图片的文件名看上去更规范,对其进行重命名,命名规则通过x变量加1。保存的位置默认为程序的存放目录。

程序运行完成,将在目录下看到下载到本地的文件。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

[灌水]如何提升网站在百度的排名2010-11-09 0

-

百度浏览器1.2 beta版发布2011-07-19 0

-

下载百度到桌面_把百度下载到桌面2011-10-26 0

-

怎样用Labview将AVI视频转换成图片序列并保存到指定文件夹2014-11-05 0

-

百度地图离线API调用教程2016-01-24 0

-

python实现网页爬虫爬取图片2016-04-05 0

-

百度竞价排名这件事你怎么看?2016-05-03 0

-

Python助力百度无人车 人工智能时代到来2017-12-13 0

-

使用Python爬虫实现百度图片自动下载的方法2019-05-23 0

-

百度UEditor_解决图片在手机端的自适应问题2020-06-16 0

-

4412开发板图像识别项目-通过QT制作图形界面并调用百度AI进行图像识别(二)2020-11-17 0

-

百度API调用(三)——语音识别 精选资料推荐2021-08-18 0

-

怎么开通百度语音技术接口服务?2021-11-22 0

-

Python将二维数组输出为图片2023-01-11 1018

-

Python将图片输出为二维数组并保存到txt中2023-01-11 1357

全部0条评论

快来发表一下你的评论吧 !