GANs领域值得深入研究的七个问题,让我们得以窥视GANs未来的发展走向

电子说

描述

生成对抗网络GANs自从诞生以来就得到了各界的广泛关注,在图像领域的发展成果更是目不暇接,飞速的发展让人眼花缭乱。但我们从另一个角度来审视GAN会发现这一领域还有很多问题没有公认的理解,例如对如何评价GANs的表现人们还没有达成共识。

最近,来自Google Brain的研究人员就GANs目前的研究状况进行了详细深入的梳理,提出了GANs领域值得深入研究的七个问题,让我们得以窥视GANs未来的发展走向。

一、GANs与其他生成模型间的利弊权衡

除了GANs外,目前还包括流模型Flow Models和自动回归模型Autoregressive Models 两种主要的生成模型。简单来说,流模型主要讲一系列不可逆的变化转换为从先验中的采样,使模型可以计算精确的对数似然,而自回归模型则将观测的分布分解到了条件分布上,一次观测只处理其中的一个(对于图像来说,一次处理一个像素)。

最近的研究表明这几种模型有着不同的表现特点和平衡方式,对这些平衡的特点及模型的内禀属性进行精确的研究是十分有意义的方向。下面将从计算量上来分析模型间的差异。流模型可以计算出精确的对数似然和推理,看起来会让GANs没有用武之地。训练GANs是一项复杂的工作,需要很大的努力,Flow模型的出现让我们不禁担心起GANs的发展,也许在训练中加入最大似然是不错的方法。

但计算量成为了一个无法回避的问题。对于流模型的代表Glow来说,训练一张256*256的图像生成器需要40个GPU耗时两个星期训练200M参数,而GANs训练1024*1024的生成器只需要在8GPU上用4天时间训练46M参数。这意味着流模型需要用17倍的时间才能训练出生成1/16大小的图像。那么是什么造成了流模型的低效呢?研究人员认为有两个主要的原因,其一是极大似然估计比对抗样本的训练更为复杂。

如果样本中的元素被模型设置了0概率,那么惩罚将会变成无穷大!而GANs则通过间接的方式设置0概率,惩罚将会缓和的多。另一个方法来自于归一化流(normalized flows),研究人员认为这是对于特定函数的一种低效表达,但目前对于这一领域还没有深入的研究。讨论完流模型后我们再来看看自回归模型。

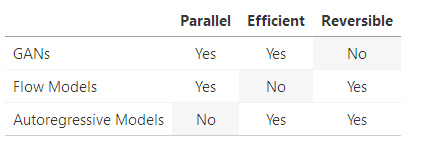

有研究表明自回归模型可以被表示为非并行化的流模型。从流模型中采样必须是串行的过程,每次只能进行一次观测。同时也有研究表明,自回归模型比流模型具有更高的运行和参数效率。综上所述,GANs是并行高效的计算模型,但是不具有回溯性;流模型具有回溯性和并行性,但是效率很低;自回归模型虽然高效和回溯,但却无法并行化处理。

到这里我们可以进一步总结第一个问题:

GANs和其他生成模型间最基本的trade-offs到底是什么?

我们能不能在这个领域建立起类似CAP利用的方法来描述可逆性、并行性和参数/时间效率呢?

其中一个可能的方向是研究更多的混合模型,但混合的流模型/GAN模型目前的研究还很少。研究人员认为极大似然训练比GAN训练更为困难,流模型参数的表达能力很很可能比任意编码器函数低,但需要一定的假设来进行证明。

二、GANs可以为什么样的分布建模呢?

目前绝大多数的GANs集中在图像领域,研究人员们常常在MNIST, CIFAR-10, STL-10, CelebA,和Imagenet上进行训练。通常来讲,MNIST和CelebA上的训练比Imagenet, CIFAR-10,STL-10上的训练更为容易,很多人都注意到类别数的上升是GANs难以训练ImageNet的原因。这也使得先进的网络在CelebA上的生成结果比ImageNet上的结果更。然而我们需要对这些在大数据集上训练所观察到的结果进行科学的解释,研究人员希望在未来能够有一定的理论和标准来判断一个数据集是否适合用GANs训练。这一领域的研究已经开始,但未来还有广泛的发展空间。所以我们可以将第二个问题表示为下面的陈述:

对于给定数据集,我们可以给出用GANs构建其分布的难以程度吗?

那么一系列新的问题随之而来:为分布建模的定义是什么?我们需要的是一个下界表示还是真实的稠密模型?是不是存在GANs无法建模的分布?是不是存在一些可以学习但建模效率很低的分布?针对上述问题的答案,与其他生成模型相比GANs是不是具有独特的性质?针对上述问题,研究人员提出了两个策略:1.合成数据集。可以通过对合成数据集的研究探索影响可学习性的因素;2.改进现有的理论结果。可以修改现有理论的假设来对数据集的不同特性进行研究,例如我们可以观察GANs对于单模数据和多模数据的表现差异来进行探索。

三、GANs如何实现超越图像合成的广泛应用?

除了图像和合成、风格迁移等域适应的应用,在图像领域外GANs的应用主要集中于以下三个方面:1.文本。文字天然的离散特性对于GANs的处理来说十分困难,这主要由于GANs的训练需要将判别器的信号输入生成器进行反向传播。目前主要有两种方法来解决这一问题,一方面将GANs应用于离散数据的连续表达上,另一方面则利用实际的离散模型基于梯度估计来训练GAN,但目前这些方法的表现都还低于基于似然的语言模型。2.结构化数据。那么对于像图这类非欧式的结构化数据该如何应用GANs呢?虽然像图卷积等模型已经取得了一定的成绩,但GANs在这方面的探索十分有限,目前研究人员正尝试利用生成器得到随机游走来重组来自原始图中的结构化信息。3.音频。GANs在音频领域很有希望获得与图像领域一样的成功,在非监督音频合成等方面取得了一系列结果。最新的研究甚至可以在某些感知指标上超过自动回归模型的表现。那么对于在非图像数据上的第三个问题就归结为下面的表述:

如何使GANs在非图像数据上取得良好的结果?将GANs用于这些不同的域上是否需要新的训练技术、或者更为完善的先验呢?

我们需要思考怎样才能让GANs在这些域中实现有效的训练和学习。特别对于离散的结构化数据来说,未来也许会引入强化学习对生成器和判别器进行训练,这需要强大计算资源的支撑和基础研究的帮助。

四、GANs在训练中的全局收敛性是怎样的?

GANs的训练的特殊性在于我们需要同时优化生成器和判别器,目前的论文在严格的假设下已经证明同时优化时局域渐进稳定的。但我们却难以证明训练过程具有全局的通用性。这主要是由于生成器/判别器的损失是参数的非凸函数,那么问题来了:

我们如何才能证明GANs是全局收敛的?哪一种神经网络的收敛结果可以应用于GANs上呢?

目前有三个方面的探索在致力于解决这一问题:1.简化假设。例如可以使用LGQ GAN来简化假设,利用线性生成器、高斯分布的数据和二次判别器的假设,可以利用特殊的优化技术得到全局收敛的证明;2.利用归一化神经网络。当网络变大时低质量的局域极小值出现的可能将会指数下降,这种特性也许对GANs同样有效;3.博弈论 。利用纳什均衡等理论来解决全局收敛性的问题。

五、如何评测GANs?

目前在GANs中流行的评价指标主要包括感知分数(IS)和弗雷歇感知距离(FID)、多层级结构相似性(MS-SSIM),几何评分(Geometry Score),精度和召回率(Precision and Recall ),AIS和Skill Rating等。目前广泛采用的是感知类指标,但人们对于GANs评价更多的疑惑却也同时来自于合适该使用GAN,那么第五个问题就将这一疑问归结为:

何时我们该使用GANs?我们该如何评测GANs在这些任务上的表现?

我们应该明确使用GANs的目的,如果你想得到真实的稠密模型GANs并不是一个很好的选择.GANs适用于感知偏好的任务,例如图像合成、风格迁移等都是GANs可以大展身手的场景。对于感知任务,目前主要使用分类器(C2STs)来进行评测,但生成器的缺陷会对评价造成系统性的影响。一种不依赖于单因素的全局评价方法是未来的发展方向。最后,人类评价虽然昂贵但是必不可少的。未来可能会通过预测人类的感知情况来代替评价,但出现较大不确定度时才需要人类的介入。

六、如何使用较大的批次训练GANs呢?

提升分类网络训练速度的大规模minibatches是否能加速GANs的训练呢?但GANs中存在一系列会导致训练发散的瓶颈,使得提高批量大小的方法并不容易达到,我们需要探索下面的问题:

如何通过批量大小提升GANs的训练效率?梯度噪声在GANs训练中扮演着多重要的角色?是否可以对GANs进行一系列改进来适应更大的批大小呢?

有迹象表明增加批大小可以改善结果并减少训练时间,但还缺乏系统的研究。研究人员目前从优化输运GANs和异步SGD等方面探索了增大批的可能性,但这个方向仍然有很多的问题等待我们去探索。

七、GANs和对抗样本的关系如何?

众所周知分类器很容易受到对抗样本的影响,鲁棒性不强。考虑到判别器通常也基于图像分类器而构建,针对GANs的对抗样本研究具有重要的意义,但关注GANs与对抗样本间关系的文章却很少,所以最后一个问题就是:

判别器的对抗鲁棒性如何影响GAN的训练过程?

我们可以假设存在一个固定的判别器D,存在这样一个生成样本G(z),判别器判别G(z)为假但却将加了扰动的生成样本G(z)+p判定为真。我们似乎可以更新生成器来获得更鲁棒的结果G’=G(z)+p.但由于每次训练梯度只能进行一次更新、同时每个批次各不相同,这样的方法在现实中不太可能存在。但如果可以寻找到一种方式研究这一相关性并提升模型的精度与稳定性将是充满前景的研究方向!GANs是AI研究中最为前沿和活跃的领域之一,这篇文章从生成对抗的本质、数据、收敛、应用和评测等方面给出了一系列尚未解决的问题,这些存在问题和挑战的地方也是未来将发展的前进的方向,希望这些问题和方向能够启发各位小伙伴研究的新思路。

-

[分享]超级经典的JAVA基础视频推荐,还有很多牛人写的学习感受!值得深入研究2009-08-28 0

-

浅谈LED驱动芯片行业的处境和未来发展2014-09-18 0

-

【Landzo C1试用体验】+第六篇 超声波之深入研究2016-07-12 0

-

从入门到研究,人工智能领域最值得一读的10本资料(附下载)2017-10-12 0

-

无线智能家居控制装置的深入研究2019-07-25 0

-

Python数据可视化专家的七个秘密2020-05-15 0

-

恒兴隆机电:深圳高速电机电工领域有什么研究热点?2021-12-02 0

-

深入研究USBType-C技术的细节2021-12-16 0

-

深入研究彻底掌握设备树2022-02-17 0

-

linux的深入研究2009-03-28 290

-

模式匹配算法的深入研究2009-10-25 491

-

深入研究精密数据采集信号链的总噪声贡献2018-11-26 2617

-

“GANs之父”被爆已从Google离职,不知 GoodFellow下一站又将转投何处?2019-04-04 5543

-

谷歌采用GANs与神经网络打造图像压缩新算法2020-09-14 1801

-

1.6设备树的引进与体验——只想使用设备树不想深入研究怎么办2021-12-22 235

全部0条评论

快来发表一下你的评论吧 !