病理领域的AI研究也有了新的进展

电子说

描述

深度卷积神经网络(CNNs)已在实践中被证明是一种可以辅助生物医学图像诊断的技术,并已广泛运用于肺结节、眼底等放射影像识别。近日,病理领域的AI研究也有了新的进展。

2019年5月,将门投资企业——迪英加科技CEO杨林带领团队发表的论文《Pathologist-level Interpretable Whole-slide Cancer Diagnosis with Deep Learning》被《Nature Machine Intelligence》收录,该论文提出了一项用于AI病理诊断解释的方案。

在文章所描述的实验之中,研究人员运用AI技术对病理切片进行分析处理,并同时给出AI分析的依据。这是全球首篇发表在自然子刊上的关于讨论病理图像分析中的人工智能可解释性问题的专著。

通过实验所设计的方法,人工智能开始“理解”医生的逻辑,并尝试模仿人类医生,给出诊断依据。对此,动脉网采访了论文通讯作者杨林教授,并结合论文内容,尝试梳理出论文的逻辑及背后的深刻价值。

病理痛局推动科研发展

病理科被“现代医学之父”威廉·奥斯勒称为“医学之本”,而病理医生被认为是医生的医生。病理科的含金量自然不言而喻,其诊断的准确与否直接影响患者的健康和命运。

然而,据国家卫生和计划生育委员会2015年数据显示,全国仅有9841名有资质的病理医生。这个数字与我国人口总量之比约为1:140000,与注册医师之比约为1:250。简单的说:每个病理医生都承担了 5-10 倍的常规工作量,许多病理医生都在超负荷地进行日趋复杂的高强度工作,误诊、漏诊时有发生。

制约病理医生资源发展的因素不仅仅是庞大的工作量、工作环境差、收入待遇低、培养周期长等因素严重影响了病理教学师资。病理医师新生力量呈现“断崖式”短缺。

AI技术的出现或许可以解决这个问题。有深度学习支撑的人工智能能够以迅速、标准化的方式处理医学影像,对可疑影像进行勾画、渲染,并以结构化的语言提出建议。

这些工作精力消耗大,重复性高,而AI不受制于工作性质。实践证明,在AI的帮助下,病理医生不仅可以提高诊断效率、减轻工作量;还能提高工作强度,改善病理医生工作环境,最终降低误诊、漏诊率。

痛点确乎推进了科学研究的发展,但在AI辅助诊断被真正施于应用时,种种问题随之而来。

质疑之声中最为清晰而难以回答的便是以下两个问题:AI是如何完成判读?它对于切片的分析是否有依据?事实也是如此,如果这个问题得不到解决,病理医生与CFDA监管部门难以认可AI的判读结果——概率云并非一个合理的依据。鉴于此,杨林团队开始了本次研究,用以解决AI病理诊断的可行性与可解释性。

实验条件下,AI可大幅度提升CAD准确率

为了探寻AI辅助诊断过程中的可解释性问题,研究团队以膀胱癌患者的病理切片为研究对象,在保证AI分析切片准确率的同时,通过构建全新网络架构,达到令该系统能针对诊断区域自动输出文字的效果,而这些文字可表明系统的诊断依据。

对此,研究团队设计了一个包含扫描器网络(s-net),诊断器网络(d-net)和聚合器网络(a-net)三个模块的神经网络系统。这三个模块分别在系统之中起到分析图像、文字表达、信息整合输出的作用,共同发挥了肿瘤检测与细胞表征提取的作用。

扫描器网络(s-net)的核心是多模态CNN,这是一种特殊的深层的神经网络模型,它的特殊性体现在两个方面,一方面它的神经元的连接是非全连接的,另一方面同一层中某些神经元之间的连接的权重是共享的。它的非全连接和权值共享的网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。

诊断器网络(d-net)作用于每个勾画ROI(感兴趣区域,region of interest,AI框选出的需要关注的区域),分析病理特征并显示特征感知网络,以尝试解释每个ROI的勾画原理,以及解释诊断器网络在描述观察时所看到的内容,最终将分析流程及结果转化为文字。

简而言之,d-net的作用就是生成解释性的内容,告诉人类AI为什么框选出这些ROI,以及AI对单个ROI如何做的判断。

聚合器网络(a-net)则将扫描器网络与诊断器网络生成的信息进行集合处理,集成所有特征,并生成与影像相匹配的诊断结果。

通过逐块扫描病理图片,三个模块从图片像素中提取与数据库对应的有效像素并进行识别,最后转化为可处理文本数据,再使系统建立起文本与图像之间的直接联系。

诊断器网络在数据格式转化的同时,系统将运用NLP生成包含诊断组织细胞和细胞核特征的语言描述,匹配病理学家的操作方式,其生成的表述结构符合临床病理学报告标准。因此,这种方式可视为对人工智能诊断过程的解释。

病理学家在实验之中起到了重要的作用。当病理学家对病理切片进行处理时,系统将捕获病理学家的操作过程,如点击图像的位置,并将操作、医学语言与系统语言相结合,这构成了系统的运行和分析的逻辑的基础。

最终,系统能够通过其文本和视觉输出明确地解释其分析过程,并向病理学家提供直接证据(即第二意见)以供审查和目视检查,从而帮助降低病理学家临床决策中的主观性差异。

本次实验用了怎样的样本?

本次实验总计采用了近千名膀胱癌患者的尿路上皮癌切片数据,整个数据集分为620个用于训练的病理切片,193个用于验证的病理切片和100个用于测试的病理片。

从形态上看,该数据集包括102例非侵入性低级别乳头状尿路上皮癌以及811例非侵入性或侵入性高级别乳头状尿路上皮癌。这些数据经过了多位病理学家的严格诊断,且去除了低质量的切片。

为了评估神经网络系统的效果,21名泌尿生殖病理学家参与了数据注释和诊断性能评估。经过大约近两年的努力,病理学家使用研究人员开发的基于Web的注释程序对数据进行了集体清理和手动注释。

通过将该系统的测试结果与病理学家的常规检查进行了比较,结果显示,该系统实现了97%的曲线下面积(AUC)评分,其表现优于大多数进行比较的病理学家。

此外,当使用混淆矩阵进行比较(图e,f)时,结果显示系统的平均准确度为94.6%,而病理学家的平均准确度为84.3%。

实际上,统计结果还表明,病理医生对于部分类型的前列腺癌的诊断一致率不足50%。因此仅从数据上看的话,此次论文中所提出的AI系统,在准确率和一致性上都有较好的表现。

AI可解释性的研究

正如前文所示,该系统通过扫描器网络、诊断器网络、聚合器网络,对AI辅助诊断的可解释性进行了探索,最终会产生说明文字同ROI同步输出。

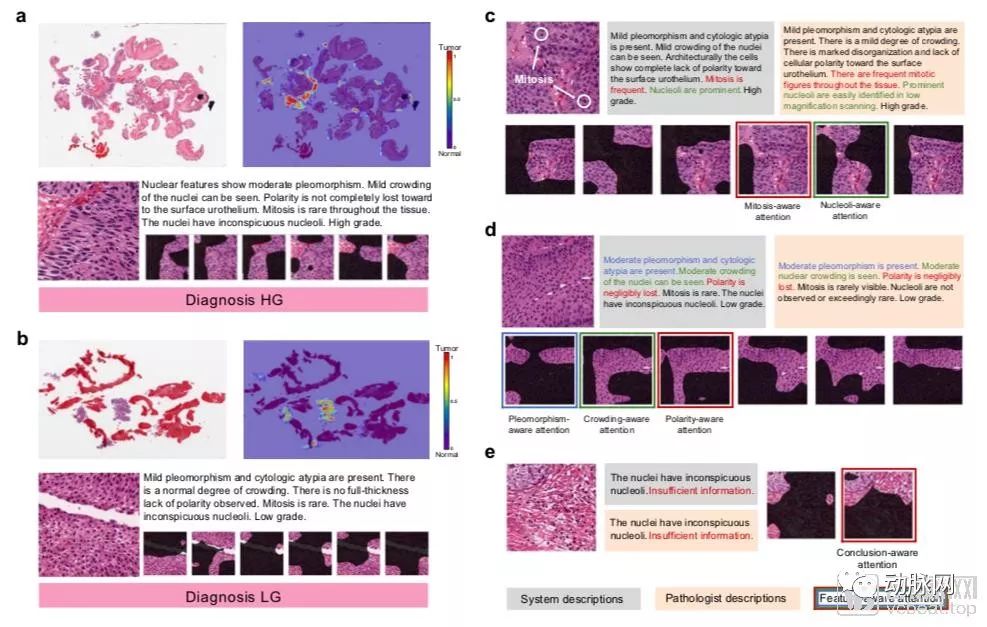

可解释性图示

如上图,a、b显示的为全片肿瘤检测结果,c、d、e则为生成的“特征感知注意图”,对诊断细节进行描述。我们可以看到,针对每一张切片,系统在判读后,除了常规地将ROI区域框选出来,还针对不同区域生成了解释性文字。

其中,不同特征的文字被使用不同颜色加以区分,而该描述所对应的ROI,都被加以相同颜色的框表示,便于病理医生查看时一一对应。

该系统描述了观察到的一定数量的细胞特征以及特征感知注意图,注意图对网络观察到的视觉信息的类型给出了强有力的解释(图c-e)。实际上,注意图包含了框选区域中每一个像素的权重,用以确定不同像素对于给定的特征观察的重要程度,但输出的内容却并不是令人费解的数值,而是类似于病理医生的判读依据。

这样专业化的文字表述加强了AI分析病理切片的可信度,当人类医生与机器诊断结果不符时,医生们也能够更容易地对比自己与机器的诊断意见到底在何处有所区别,了解产生区别的原因,在很大程度上能够提高诊断准确度。

系统网络组件的评估

在算法结构方面,算法的各部分性能在完成后均被予以验证。

首先,研究人员评估肿瘤和非肿瘤图像的s-net的肿瘤检测召回率(非肿瘤图像表示内部没有突出肿瘤的裁剪的滑动组织区域)。s-net达到94%的高真阳性(检测到的肿瘤像素数/总注释肿瘤像素)并同时维持95.3%的阴性召回率。

其次,研究人员使用了两个评估指标验证了生成的诊断描述的质量:双语评估Understudy(BLEU)和基于共识的图像描述评估(CIDEr)。而这些验证结果显示,该算法已经具备了一定的优越性。

此项实验突破了AI病理三类证审批的关键难点

囿于其决策流程的不可解释性,“深度学习”一直被遵循循证医学指南的临床医生拒之门外,成为了制约医学影像人工智能发展,特别是获得三类证审批的关键。

而本次实验则为人工智能的审批提供新的思路:虽然现阶段的人工智能仍不具备推理能力,但我们能将医生的推理步骤模块化,从而模拟推理的过程。此外,本次实验中的文字匹配过程是按照WHO标准并具有严格依据的,这与许多基于多样本深度学习生成的勾画不同,实验的每一个步骤都可由AI提供决策依据,并非单纯概率云下的黑箱运算。

杨林教授现任职于迪英加CEO,这是迪英加科技在三类证申报过程中的一步坚实工作,用于解决CFDA三类证申报中广泛要求的可解释行提供了关键的核心技术解决方案。

在采访过程之中,杨林教授也对本次实验的不足之处进行了总结。首先,由于时间的原因,样本的选择检测本身具有一定的封闭性,随着持续数据收集的广度和深度的提升,论文中的工作也一定会有改进之处。

其次,推理流程的划分是否足够细致,以及推理过程是否存在偶然性可以进一步论证。

最后,这项研究没有控制参与病理医师的疲劳程度,这可能是影响AUC的独立因素,需要进一步研究这一系统对不同疲劳水平医生的有效性。

总的来说,无论是人工智能技术,还是本次实验的病理本身,我们都能看到很多突破的可能。目前的人工智能影像产品仍聚集于放射科,当他们尝试进一步进入临床相关科室时,这项技术同样需要新的标准对其进行验证。

此外,AI于病理的运用也远不局限于切片识别,机体组织样本中内部特征的量化分析与临床评价;细胞和动物组织样本的量化分析与药效关系;细胞识别与分选;特殊染色结果的量化分析和临床治疗与预后也均有AI介入研究。病理于AI是一片看不见的深海。

-

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感2024-10-14 2256

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+可期之变:从AI硬件到AI湿件2025-09-06 2165

-

薄膜锂电池的研究进展2011-03-11 2967

-

如何加速电信领域AI开发?2021-02-25 2950

-

病理嗓音发声系统的非对称建模研究2017-01-07 559

-

归纳AI领域一些方向的重要技术进展2018-01-11 4810

-

Paige.AI将机器学习引进癌症病理研究2018-02-26 1172

-

腾讯联合华银健康研发AI病理诊断 开放合作推动医学AI不断创新2018-12-25 2187

-

AI指数报告 看几大国AI领域的研究进展和趋势大比拼2019-03-01 954

-

SMILY:一个以人为中心,相似图像的病理搜索工具2019-07-30 5844

-

百亿市场风口,“AI+病理”有机会也有挑战2020-08-26 2444

-

微电子领域中陶瓷劈刀研究与应用进展2023-09-07 1772

-

AI大模型的最新研究进展2024-10-23 2700

-

百度在AI领域的最新进展2025-04-30 1191

-

上海瑞金医院携手华为以AI技术重塑病理诊断未来2025-12-17 1017

全部0条评论

快来发表一下你的评论吧 !