AI的三种专用芯片 GPU和FPGA以及ASIC

可编程逻辑

描述

人工智能的三大支撑是硬件、算法和数据,其中硬件指的是运行 AI 算法的芯片与相对应的计算平台。在硬件方面,目前主要是使用 GPU 并行计算神经网络,同时,还有 FPGA 和 ASIC 也具有未来异军突起的潜能。GPU (Graphics Processing Unit)称为图形处理器,它是显卡的“心脏”,与 CPU 类似,只不过是一种专门进行图像运算工作的微处理器。

GPU 是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU 在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于 CPU 的性能。英伟达公司从 2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。

GPU 对海量数据并行运算的能力与深度学习需求不谋而合,因此,被最先引入深度学习。2011 年吴恩达教授率先将其应用于谷歌大脑中便取得惊人效果,结果表明,12 颗英伟达的 GPU 可以提供相当于 2000颗 CPU 的深度学习性能。

GPU 作为图像处理器,设计初衷是为了应对图像处理中需要大规模并行计算。因此,其在应用于深度学习算法时,有三个方面的局限性:1.应用过程中无法充分发挥并行计算优势。2.硬件结构固定不具备可编程性。3.运行深度学习算法能效远低于 ASIC 及 FPGA。

FPGA(Field-Programmable Gate Array)称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。与 GPU、CPU 相比,具有性能高、能耗低、可硬件编程的特点。

FPGA 比GPU 具有更低的功耗,比 ASIC 具有更短的开发时间和更低的成本。自 Xilinx 在 1984 年创造出 FPGA 以来,在通信、医疗、工控和安防等领域占有一席之地,在过去几年也有极高的增长率。而进入了最近两年,由于云计算、高性能计算和人工智能的繁荣,拥有先天优势的 FPGA 的关注度更是到达了前所未有的高度。

就目前市场而言,英特尔、IBM、德州仪器、摩托罗拉、飞利浦、东芝、三星等巨头纷纷涉足 FPGA,但最成功的是 Xilinx 与 Altera。这两家公司共占有近 90%的市场份额,专利达到 6000 余项。Intel 在 2015 年以 161 亿美元收购了 Altera,也是看中 FPGA 专用计算能力在人工智能领域的发展。从行业巨头巨头的动作可以看出,由于 FPGA 在计算能力和灵活性上大大弥补了 CPU 的短板,未来在深度学习领域,CPU+FPGA 的组合将成为重要的发展方向。

FPGA也有三类局限:1、基本单元的计算能力有限;2、速度和功耗有待提升;3、FPGA 价格较为昂贵。ASIC(Application Specific Integrated Circuit)是一种为专门目的而设计的集成电路。无法重新编程,效能高功耗低,但价格昂贵。

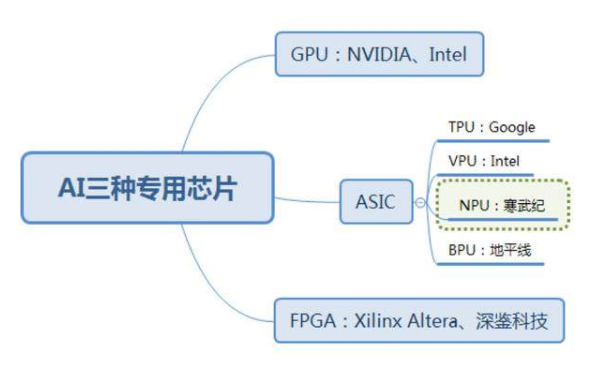

近年来涌现出的类似TPU、NPU、VPU、BPU等令人眼花缭乱的各种芯片,本质上都属于ASIC。ASIC不同于 GPU 和 FPGA 的灵活性,定制化的 ASIC 一旦制造完成将不能更改,所以初期成本高、开发周期长的使得进入门槛高。目前,大多是具备 AI 算法又擅长芯片研发的巨头参与,如 Google 的 TPU。由于完美适用于神经网络相关算法,ASIC 在性能和功耗上都要优于 GPU 和 FPGA,TPU1 是传统 GPU 性能的 14-16 倍,NPU 是 GPU 的 118 倍。寒武纪已发布对外应用指令集,预计 ASIC 将是未来 AI 芯片的核心。

ASIC 的另一个未来发展是类脑芯片。类脑芯片是基于神经形态工程、借鉴人脑信息处理方式,适于实时处理非结构化信息、具有学习能力的超低功耗芯片,更接近人工智能目标,力图在基本架构上模仿人脑的原理,用神经元和突触的方式替代传统“冯诺依曼”架构体系,使芯片能进行异步、并行、低速和分布式处理的能力,同时具备自主感知、识别和学习能力。IBM 的 NorthTrue 即属于类脑芯片。目前类脑芯片尚处于初期,距离商业化还存在一段距离,这也是各国正在积极布局的地方。

-

自动驾驶主流架构方案对比:GPU、FPGA、ASIC2023-02-14 4692

-

到底什么是ASIC和FPGA?2024-01-23 1595

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战2025-09-12 3294

-

从CPU、GPU再到TPU,Google的AI芯片是如何一步步进化过来的?2017-03-15 3560

-

ai芯片和gpu的区别2021-07-27 2675

-

对FPGA与ASIC/GPU NN实现进行定性的比较2023-02-08 1946

-

深度学习方案ASIC、FPGA、GPU比较 哪种更有潜力2018-02-02 10929

-

什么是ASIC芯片?与CPU、GPU、FPGA相比如何?2018-05-04 255489

-

车载芯片的发展趋势(CPU-GPU-FPGA-ASIC)2018-08-09 24420

-

浅析GPU、FPGA、ASIC三种主流AI芯片的区别2019-03-07 31221

-

自动驾驶主流芯片:GPU、FPGA、ASIC2023-03-17 2807

-

FPGA、ASIC等AI芯片特性及对比2023-03-21 3566

-

安防领域典型AI芯片有三种,为何偏偏是FPGA称雄?2023-06-17 1468

-

FPGA、ASIC、GPU谁是最合适的AI芯片?2024-01-06 2760

-

ASIC和GPU的原理和优势2025-01-06 3306

全部0条评论

快来发表一下你的评论吧 !