基于半监督学习的多示例多标签改进算法

电子说

描述

摘要:多示例多标签学习框架是一种针对解决多义性问题而提出的新型机器学习框架,在多示例多标签学习框架中,一个对象是用一组示例集合来表示,并且和一组类别标签相关联。E-MIMLSVM+算法是多示例多标签学习框架中利用退化思想的经典分类算法,针对其无法利用无标签样本进行学习从而造成泛化能力差等问题,使用半监督支持向量机对该算法进行改进。改进后的算法可以利用少量有标签样本和大量没有标签的样本进行学习,有助于发现样本集内部隐藏的结构信息,了解样本集的真实分布情况。通过对比实验可以看出,改进后的算法有效提高了分类器的泛化性能。

0 引言

对于监督学习,通过训练集中已知类样本学习构造一个判决边界,并设定临阈值,来实现对未知样本的预测[1]。通常使用一个示例描述单个对象并与其类别相关联。但是,实际上每个对象都可能不止有一个语义,如一幅含有狮子、大象、草原的图,可以将其归为“大象”类别,也可以将其归为“狮子”类别,甚至可以因为动物和草原的存在将其归为“非洲”的类别。因此,当仅通过一个示例来表示一个对象时,显然难以获得期望的效果。为了处理这个难题,相关学者提出了多示例多标签(Multi-Instance Multi-Label,MIML)[2]机器学习模型,最大特点是:在该框架中是用一组示例集合来表示一个对象,同时该对象与多个标签相关联。对于真实世界中对象的表示能力更强,其他的机器学习框架可以看作是多示例多标签框架的一种简化表示形式。支持向量机(Support Vector Machine,SVM)是建立在统计学习理论基础上的一种机器学习方法,其泛化准确率高,计算效率高,结果易解释[3]。传统的SVM多为监督学习,然而在实际中,有标签的样本数据是稀少的,无标签的样本数据的获取相对较易。半监督学习即通过将无标签样本数据加入训练集中,对其学习建模来增强模型的泛化性能。因此,出现了将半监督学习和SVM方法进行结合来训练分类函数的研究。

1 相关工作

传统监督学习是一种单示例单标记学习框架。学习任务是学得一个映射函数:f:X→Y。在多示例学习问题中[2],用包含一组示例的集合来表示训练集中的每个对象,同时将该对象归属于单个类别标签中。该模型主要学习一个分类器(即映射函数fMIL:2x→Y)来标记未知的示例包的标签。代表性的多示例学习算法有多示例最近邻算法Citation-kNN、多示例神经网络算法BP-MIP等[4]。在多标签学习问题中[2],对象仅由单个示例表示,并属于一组标签。该框架模型的任务是学习fMIL:x→2Y函数的映射,然后使用此映射来预测未知集合中的标签类别。代表性的多标签学习算法有二元相关(BR)算法和分类器链(CC)算法[5]等。

在MIML框架下,有两种解决问题的方式,一种是应用退化的方式,以多示例学习或多标签学习作为桥梁,对MIML问题进行退化,如MIMLSVM[6]和MIMLSVM+[7]等。但是在退化时,有时标签间的关联信息会被忽视,进而影响到实际的分类效果。为了避免信息丢失,另一种思路是改造算法找到适应MIML框架的机器学习算法。代表性算法主要有D-MIMLSVM算法、M3MIML算法[8]等。

2 改进的算法

2.1 E-MIMLSVM+算法

2.2 E-MIMLSVM+算法中引入半监督

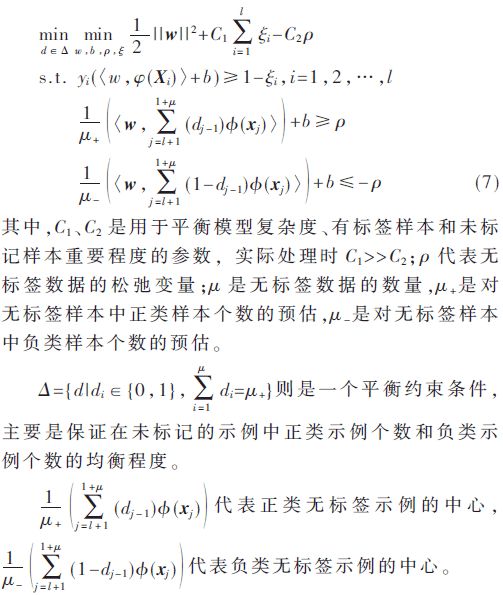

半监督学习即把大量无标记的数据和少量有标记的数据一块训练,构建起泛化性能强的分类器,有标签的数据和无标签的数据的空间结构分布相似,应用无标签的样本来训练,有助于提高训练出模型的性能。半监督SVM属于半监督领域中的学习算法,它基于SVM和半监督学习的聚类假设,尝试寻找能将两类有标签样本分隔,并且通过穿过低密度区域来划分超平面,如此一来就能同时利用有标签的数据和无标签的数据。半监督SVM中最经典的是TSVM和S3VM[13]。通过文献[13]对类中心的有效性分析可以获得基于类中心估计的半监督支持向量机meanS3VM。它只需要最大化两个类的类别平均值,来代替之前对所有的未标记样本进行标记的方式。这很大程度上提升了半监督SVM的求解速度。假设存在有标记的样本集Dl={(x1,y1),(x2,y2),…,(xi,yi)},未标记的样本集Du={xl+1,xl+2,…,xl+u},meanS3VM算法[13]可形式化定义为:

通过分析可以得到,式(7)只需要估计无标签样本的类别平均值即可。与S3VM相比,meanS3VM避免了对所有未标记样本类别标签的估计。实际上,meanS3VM算法最大化了两个类的类别平均值。由于meanS3VM算法大量减少了约束条件的个数,因此,对半监督SVM的求解速度更快了,从而使得半监督SVM的时间开销变少。可以证明[14],当给定样本集可分时,meanS3VM的损失函数与标准SVM一致;当给定样本集不可分时,meanS3VM的损失函数不会超过标准支持向量机hinge损失的两倍。为了充分利用未标记样本的空间分布信息,来进一步提升分类器的泛化性能,在本文中,使用半监督SVM算法——meanS3VM对E-MIMLSVM+算法进行了改进。由于meanS3VM算法适用于传统的半监督学习问题,本文改进了meanS3VM算法中核函数的计算方式,用多示例核函数进行替代。使得meanS3VM算法能够适用于多示例多标签学习中,从而得到改进算法SE-MIMLSVM+。令给定有标签样本集S={(Xi,Yi)|1≤i≤l},无标签样本集U={(Xi,Yi)|l+1≤i≤l+μ},测试样本集T={(Xi,Yi)|1≤i≤M},则SE-MIMLSVM+算法的优化问题变为:

其中,ξiy和ρ分别代表的是有标签数据和无标签数据的松弛变量,W0反映了不同任务间的共同特征,vy反映了不同任务间的区别,参数μ用于协调不同任务间的相似程度。从式(4)建立的模型可以看出,每一个分类模型fy都有一个共同的参数w0,也就是说分类模型假设每一个标签相互都是有关联关系的。但是实际的情况是,并非所有标签都存在关联关系。因此可以先在标签空间中聚类,从而将标签空间划分成许多具有标签相关性的子集,每一个示例包和标签之间的标签指示阵表示为Y。为了衡量标签之间的联系信息,在聚类的过程中使用的是Y列上的皮尔逊相关系数。

2.3 改进算法步骤

因为ω和d的双线性约束,所以式(7)是一个非凸优化模型。可以使用凸松弛算法或交替优化算法得到未标记样本估计好的类中心然后带入式(7)将其变为凸优化问题,使用凸优化软件包求解。这里选择使用求解速度更快的交替优化算法来处理相关问题。SE-MIMLSVM+的算法流程如下:

①使用有标签的样本Sk训练SVM分类器。②使用训练出来的SVM分类器对未标记的样本集U进行预测,利用预测值初始化d的值。③在本轮迭代中,固定d的取值来优化变量α,然后再固定α的值来优化d的值。④重复步骤③的迭代过程,直至达到训练所指定的迭代次数,得到未标记样本集U的类别平均值估计。⑤根据得到的类别估计平均值和有标签样本集求解式(8)得到一个SVM分类器。(5)对于未知标签的样本集X,使用T-Criterion[15]准则的最终预测函数为:

3 实验

3.1 实验设置

在本文中,用半监督算法meanS3VM来优化改进E-MIMLSVM+算法,并将对比MIMLSVM+、MIMLSVM、E-MIMLSVM+这3个MIML算法,以此来验证改进算法的分类性能。其中3个对比算法中的参数分别根据文献[6]-[7]中的实验设置为最优。根据参考文献[13]将meanS3VM算法中的参数调整为最优。实验同样应用十折交叉法,将数据集分成训练集和测试集两份,各1 000个数据。实验期间,从训练集中无规则的选择100个样本作为有标记的训练集,并且剩下的900个作为无标记的训练集。由于本实验对比的3个多示例多标签算法无法训练未标记的样本,因此每次随机抽取1 000个样本用作训练集,其余样本用作测试集。反复10次实验以计算平均值以及方差。实验使用周志华等提供的多示例多标签数据集,分为场景集和文本集[6],为了公平起见,算法均使用相同的样本集和测试集。第一部分为场景样本集,共有样本图像2 000个,数据集中的样本均被标记了一组类别标签。所有可能的类标签为沙漠、山脉、海洋、日落和树木,其中,属于一个以上的类(如海+日落)的样本的数目约占数据集的22%,许多组合类(如山+日落+树)约占0.75%,单个标签的样本数目约占77%。平均而言,每个示例都与1.24个类标签相关联。每幅图片通过SBN方法[16]用包含9个示例的示例包进行表示,每个示例为15维的特征向量。第二个样本集是文本样本集,这个样本集来源于被广泛研究的Reuters-21578[17]。该样本集分为7个类别标签,共2 000个样本文档。原始的数据集在删除标签集或主文本为空的文档后保留8 866了个文档,之后经过随机删除只有一个类标签的文档后,得到实验所用的含有2 000个样本文档的文本数据集。在该数据集中,每个文档平均所属于1.15±0.37个标签,属于多个标签的文档占比约为15%。通过使用滑动窗口[18]技术将文档表示为一组示例。每个包中包括一组243维的特征向量,每一个向量代表了这篇文档的某一个部分。每一个包最少包含2个示例,最多包含26个示例,平均每一个包中含有3.56±2.71个示例。本实验中使用的场景样本集和文本样本集,其结构特征如表1所示。

3.2 实验结果

本实验选取多示例多标签领域的5个评价指标[2]:Hamming loss、one-error、coverage、ranking loss和average precision。前4项评价指标的值越小,说明算法的分类效果越好;最后一项评价指标的值越大,说明分类效果越好。表2和表3分别显示了各个算法在两个集上的实验表现。表中“±”前面的值为实验进行十折交叉验证后,对5个评价指标的计算取值,“±”后面的值是计算得到的方差。

从表中可以看出,SE-MIMLSVM+算法前4项评价指标的值都是最小的,而average precision的值则是最大的,这说明改进算法在场景样本集和文本样本集上取得了优于其他多示例多标签算法的分类效果。

4 结论

本文讨论了基于退化策略并且使用SVM分类的多示例多标签算法E-MIMLSVM+。通过在E-MIMLSVM+算法中引入利用未标记样本学习并且求解速度较快的半监督支持向量机meanS3VM,对原始算法进行了改进。与其他多示例多标签算法相比,改进算法提高了分类准确率,增强了分类器的泛化能力。

参考文献

[1] 李斌,李丽娟。基于改进TSVM的未知网络应用识别算法[J]。电子技术应用,2016,42(9):95-98.

[2] ZHOU Z H,ZHANG M L,HUANG S J,et al.Multi-instance multi-label learning[J].Artificial Intelligence,2012,176(1):2291-2320.

[3] 张磊,殷梦婕,肖超恩,等。基于优化型支持向量机算法的硬件木马监测[J]。电子技术应用,2018,44(11):17-20.

[4] 张苗。基于多示例学习的图像检索算法研究[D]。合肥:中国科学技术大学,2017.

[5] READ J,PFAHRINGER B,HOLMES G,et al.Classifier chains for multi-label classification[J].Machine Learning,2011,85(3):333.

[6] ZHOU Z H,ZHANG M L.Multi-instance multi-label learning with application to scene classification[A].Advances in Neural Information Processing Systems 19[C].MIT Press,2007:1609-1616.

[7] LI Y X,JI S W,KUMAR S,et al.Drosophila gene expression pattern annotation through multi-instance multi-label learning[J].IEEE/ACM Transactions on Computational Biology and Bionformatics,2012,9(1):98-112.

[8] ZHANG M L,ZHOU Z H.M3MIML:a maximum margin method for multi-instance multi-label learning[C].Eighth IEEE International Conference on Data Mining.IEEE,2008:688-697.

[9] 周志华。机器学习[M]。北京:清华大学出版社,2016.

[10] EVGENIOU T,PONTIL M.Regularized multi-task learning[A].Tenth ACM Sigkdd International Conference on Knowledge Discovery & Data Mining[C].ACM,2004:109-117.

[11] ZHANG J,GHAHRAMANI Z,YANG Y.Flexible latent variable models for multi-task learning[J].Machine Learning,2008,73(3):221-242.

[12] EVGENIOU T,MICCHELLI C A,PONTIL M.Learning multiple tasks with Kernel methods[J].Machine Learning Research,2005,6(4):615-637.

[13] LI Y F,KWOK J T,ZHOU Z H.Semi-supervised learning using label mean[A].International Conference on Machine Learning[C].ACM,2009:633-640.

[14] 李宇峰。半监督支持向量机学习方法的研究[D]。南京:南京大学,2013.

[15] BOUTELL M R,LUO J,BROWN C.M.Learning multilabel scene classification[J].Pattern Recognition,2004,37(9):1757-1771.

[16] MARON O,RATAN A L.Multiple-instance learning for natural scene classification[A].Proceedings of the 15th International Conference on Machine Learning[C].Morgan Kaufmann Publishers Inc,1998:341-349.

[17] SEBASTIANI F.Machine learning in automated text categorization[J].Computer Science,2015,34(1):1-47.

[18] ANDREWS S,TSOCHANTARIDIS I,HOFMANN T.Support vector machines for multiple-instance learning[A].Advances in Neural Information Processing Systems[C].ResearchGate,2003:561-568.

-

机器学习算法的分类2023-04-18 2471

-

半监督学习代码库存在的问题与挑战2022-10-18 1894

-

一种基于伪标签半监督学习的小样本调制识别算法2022-02-10 1354

-

机器学习中的无监督学习应用在哪些领域2022-01-20 5482

-

密度峰值聚类算法实现LGG的半监督学习2021-03-11 897

-

半监督学习:比监督学习做的更好2020-12-08 1943

-

为什么半监督学习是机器学习的未来?2020-11-27 4433

-

最基础的半监督学习2020-11-02 3200

-

机器学习算法中有监督和无监督学习的区别2020-07-07 6399

-

聚焦 | 新技术“红”不过十年?半监督学习却成例外?2019-06-18 3008

-

谷歌:半监督学习其实正在悄然的进化2019-05-25 3422

-

如何用Python进行无监督学习2019-01-21 5028

-

基于半监督学习框架的识别算法2018-01-21 1018

-

基于半监督学习的跌倒检测系统设计_李仲年2017-03-19 967

全部0条评论

快来发表一下你的评论吧 !