机器学习的线性回归分析

电子说

描述

概述

线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。其表达形式为y = w’x+e,e为误差服从均值为0的正态分布。

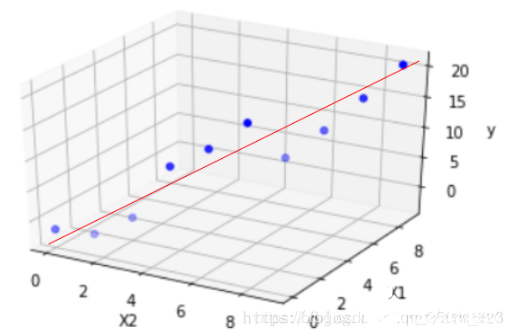

回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。

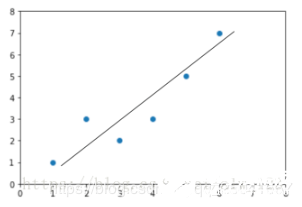

通过线性回归构造出来的函数一般称之为了线性回归模型。线性回归模型的函数一般写作为:

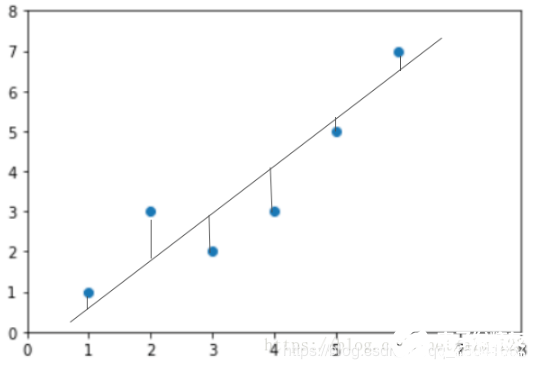

损失函数

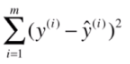

把每条小竖线的长度加起来就是预测值与真实值的差距。那每条小竖线的长度的加和怎么算?其实就是欧式距离加和,公式如下:

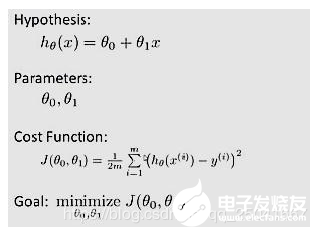

通过线性回归算法,我们可能会得到很多的线性回归模型,但是不同的模型对于数据的拟合或者是描述能力是不一样的。我们的目的最终是需要找到一个能够最精确地描述数据之间关系的线性回归模型。这是就需要用到代价函数。代价函数就是用来描述线性回归模型与正式数据之前的差异。如果完全没有差异,则说明此线性回归模型完全描述数据之前的关系。如果需要找到最佳拟合的线性回归模型,就需要使得对应的代价函数最小,相关的公式描述如下:

Hypothesis:表示的就是线性回归模型

Cost Function:代价函数

Goal:就是要求对应的代价函数最小

线性回归模型求解

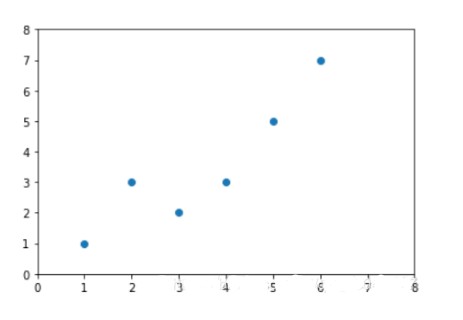

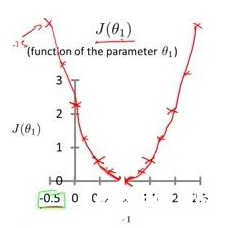

假设在线性回归模型中仅仅只存在一个函数,就是斜率参数。即theta-0是0。如果存在如下的数据:

图中对应的3个点分别为(1,1),(2,2),(3,3)那么很明显,最佳线性回归模型就是h(x)=x。如果通过实验证明呢?我们画出在theta-1处于不同值的代价函数。

线性回归模型的特点

① 建模速度快,不需要很复杂的计算,在数据量大的情况下依然运行速度很快。

② 可以根据系数给出每个变量的理解和解释。

③ 对异常值很敏感。

-

深入探讨线性回归与柏松回归2024-03-18 1328

-

机器学习回归模型相关重要知识点总结2022-11-10 1447

-

10大常用机器学习算法汇总2020-11-20 3184

-

机器学习实战之logistic回归2020-09-29 2907

-

TensorFlow实现简单线性回归2020-08-11 1898

-

斯坦福机器学习公开课笔记之单变量线性回归2020-06-11 3187

-

简单线性回归代码实现细节分析2020-05-22 1715

-

机器学习100天之多元线性回归2020-05-12 1432

-

你了解机器学习中的线性回归吗2020-02-24 2104

-

机器学习的回归分析和回归方法2020-01-19 4448

-

机器学习的回归任务2019-10-29 2423

-

如何帮你的回归问题选择最合适的机器学习算法2019-05-03 3305

-

单变量线性回归算法的符号定义和代价函数2019-03-08 1926

-

分享一个自己写的机器学习线性回归梯度下降算法2018-10-02 5119

全部0条评论

快来发表一下你的评论吧 !