完全通过光学,不要计算机也能构建个神经网络?

电子说

描述

完全通过光学,不要计算机也能构建个神经网络?港科大的研究团队提出了一种全光学神经网络,所有线性变换、激活函数通过光学模块就能实现。

在处理模式识别、风险管理以及其他同样复杂的任务时,最强大的计算机都无法与人脑匹敌。但是,近来光学神经网络取得的进展通过模拟人脑中神经元的反应方式缩小了计算机与人脑之间的差距。这种光学神经网络比 ML 中的网络能耗更低、运算更快,是未来大规模应用 AI 的坚实基础。

近日,来自香港科技大学的研究团队在《Optica》杂志上发表了一篇论文,详细描述了他们提出的双层全光学神经网络。这是一个功能完善的全光学神经网络(AONN),其中所使用的线性函数和非线性激活函数都是完全根据光学实现的。而且这种全光学神经网络还能扩展到更加复杂的神经网络架构,从而完成图像识别等更复杂的任务。

这个复杂的东西就是一个两层的全光学神经网络,它和机器学习中的两层全连接网络有点「类似」。

研究团队成员之一 Junwei Liu 表示:「我们提出的全光学神经网络能够以光速执行光学并行计算,并且耗能极少。这种大规模的全光学神经网络可应用于图像识别以及科学研究等诸多领域。」

港科大的全光学神经网络是什么

在传统混合光学的神经网络中,光学组件通常用于线性运算,而非线性激活函数通常使用电子的方式实现。这主要因为非线性光学元器件需要高功率的激光器,这在光学神经网络中是很难实现的。

为了克服这方面的问题,研究者使用具有电磁感应透明度的冷原子实现非线性函数。研究团队的 Shengwang Du 说:「这种光感应效应可以通过非常小功率的激光器实现,且该效应是基于非线性量子干涉的。因此这种效应可以将我们的系统扩展到量子神经网络,从而解决经典方法难以解决的问题。」

为了确认新方法的能力与可行性,研究者构建了一个双层全连接全光学神经网络,它的输入单元与输出单元数目分别是 16 与 2。研究者使用他们的全光学网络分类 Ising 模型(一种磁场的统计学模型),即 order 和 disorder 阶段两个类别。结果表明,全光学神经网络与一般基于计算机的神经网络一样准确。

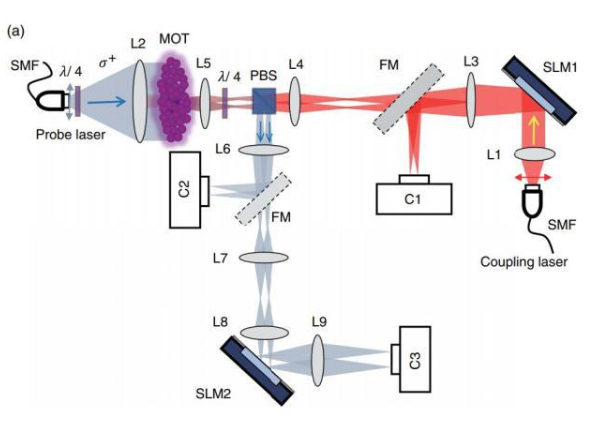

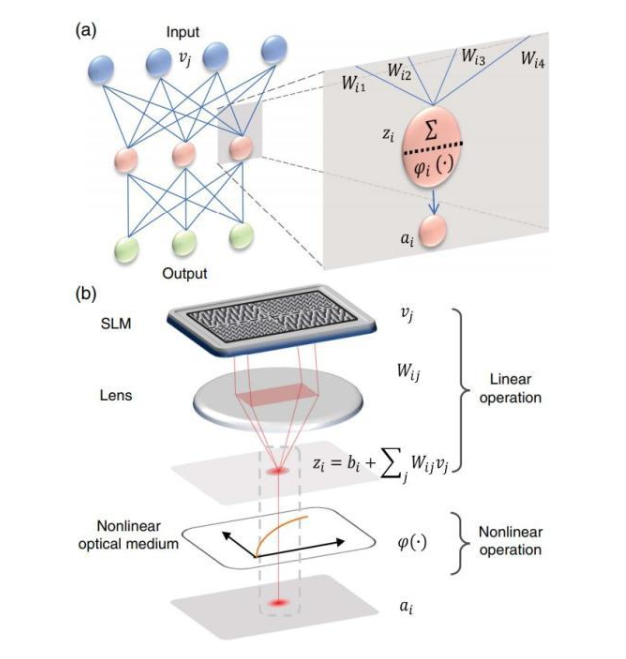

图 1:全连接网络的结构与全光学神经网络的一般结构。

如上 a 为机器学习中常见的全连接网络,b 则是香港科技大学研究者提出的全光学神经网络(AONN),它们都会进行非线性变换。与一般的 ONN 不同,AONN 没有复杂的电场神经元,AONN 所有的信都通过光学的方式进行编码。

非线性光学激活函数

这篇论文核心的突破就是采用了基于光学的非线性激活函数,因此整个网络才能称为「全」光学神经网络。那么什么是非线性光学激活函数?简单而言,它就是一种基于电磁感应透明的模块(electromagnetically induced transparency, EIT)完成的,我们只要知道 EIT 是一种原子跃迁之间的光量子干涉效应就行了。

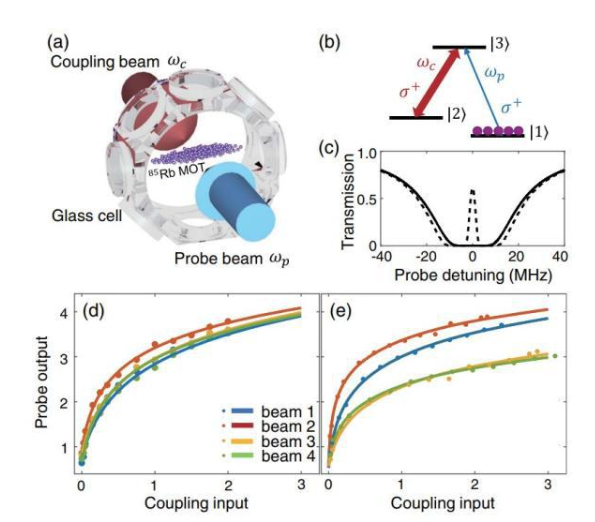

EIT 非线性光学激活函数由激光冷却的 85Rb 原子在 dark-line 二维磁光阱(MOT)中实现,如下图 3(a) 所示。图 3(b) 所示为原子能级,原子在基态|1》中制备。

在没有耦合光束的情况下,原子介质对共振探测光束是不透明的,它如图 3(c) 透射光谱中的实现所示最大程度地被原子吸收。

图 3:EIT 非线性光学激活函数的实现。

对「光学神经网络」的不懈追求

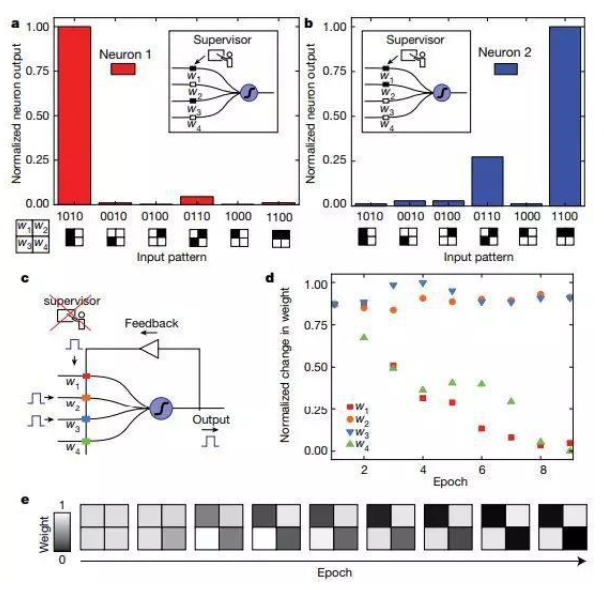

当然,香港科技大学的这个全光学神经网络并非研究者在该领域的唯一探索。今年 5 月份,在《Nature》的一篇论文中,德国的研究人员提出了一种在毫米级光子芯片上实现的、基于相变非线性材料的全光学脉冲神经网络。该网络内部没有光到电的转换,输入的数据被电子调制成不同的波长以注入网络,但之后所有数据都会停留在芯片上。利用集成相变材料来实现权重调制和神经元集成;它们位于两种微环谐振器上,具有突触或神经功能。

在不同工作波长情况下注入的未调制光接收到在相变材料中累积的神经元激活,之后将它们传递到网络下一层。即使没有芯片上光学增益(在这个过程中,一种介质将能量传递给通过它传输的光),这个设置也可能扩展至更大的网络。作者在其上实现了小规模的监督学习和无监督学习。

利用上述全光学神经元进行监督学习和无监督学习。a 和 b 表示两个神经元在不同输入模式下的输出;C:全光学神经元的无监督学习机制;d:重复显示「0110」模式时四个突触的权重随时间的变化。

香港科技大学的研究者在论文中也提到了这项研究,但他们指出,这两项研究存在根本差别。首先,德国这项研究中的系统是单层的,而本文中提出的是一个 16 个输入、2 个输出的双层全光学神经网络,还带有 4 个具有非线性光学激活函数的中间神经元。而且,港科大的研究者利用 EIT 量子干涉实现了非线性光学激活函数,这与那项研究的方法完全不同。

除了上述全光学神经网络,还有研究者尝试从局部入手,把神经网络的一部分替换为光学卷积层。

去年 8 月,斯坦福大学在《Nature》子刊《Scientific Reports》上发表论文,提出在 CNN 网络前端替换一个光学卷积层(opt-conv)的方案,可以在保持网络性能的同时显著降低能耗,并在 CIFAR-10 数据集的分类任务上验证了其结论。

光学卷积层也就是用光学器件实现的卷积层,其光学运算具备高带宽、高互联和并行处理特性,并能光速执行运算,功耗接近于零。该技术有望在低功耗机器学习领域得到进一步发掘。

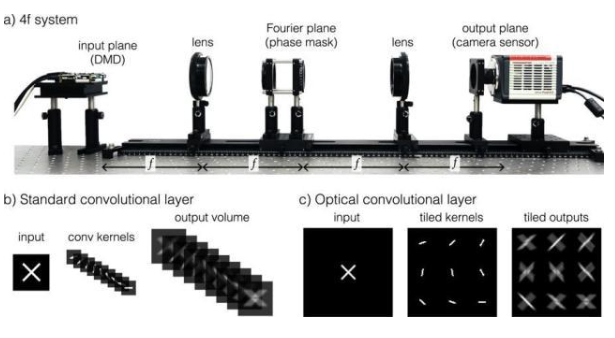

光学卷积层设计。(a)4f 系统图,可以通过在傅里叶平面上放置相位掩模来实现光学卷积层(opt-conv)。(b)数字卷积层的标准组成,包括输入图像、卷积核堆栈和相应的输出量。(c)opt-conv 层中的等效组成,核和输出以二维数组的形式平铺在平面,而不是堆叠在深度维数中。

此外,为了实现光速运算,加州大学洛杉矶分校(UCLA)的研究者甚至用 3D 打印打造出了固态的神经网络。该网络利用层级传播的光衍射来执行计算,实现了手写数字的图像识别,相关成果已发表在《science》杂志上。

这一想法看似新奇,其实也很自然。神经网络中执行的线性运算,恰好和光衍射的线性相互作用对应,神经元的权重、激活值概念也能和光的振幅、相位对应(可调)。此外,固态光衍射计算还具有能耗小、无发热、光速执行(尽管传统计算机电路中的电场传播也是光速的,但并未直接对应神经网络的计算过程)等优点。

当然,也有人对此提出质疑,认为这种固态的神经网络对安装精度和环境震动要求比较严格,可行性有待考证。

更复杂的光学神经网络

最后,研究者还计划扩展全光学的这种方法,从而构建具有复杂架构的大规模全光学深度神经网络,这些网络能用于更复杂的图像识别等任务。该论文的作者说:「尽管我们的工作是概念性验证,但它展示了全光学神经网络在未来人工智能中的可能性。下一代的 AI 硬件在本质上应该更快、更低能耗,从而高效支持复杂的 AI 应用。」

-

构建神经网络模型的常用方法 神经网络模型的常用算法介绍2023-08-28 1509

-

卷积神经网络模型发展及应用2022-08-02 13208

-

神经网络移植到STM32的方法2022-01-11 3154

-

如何构建神经网络?2021-07-12 1862

-

基于光学芯片的神经网络训练解析,不看肯定后悔2021-06-21 2943

-

通过迁移学习解决计算机视觉问题2020-10-31 2822

-

UCLA新型光学神经网络可立即识别物体2020-04-15 2384

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 3180

-

CV之YOLO:深度学习之计算机视觉神经网络tiny-yolo-5clessses训练自己的数据集全程记录2018-12-24 2743

-

非局部神经网络,打造未来神经网络基本组件2018-11-12 2736

-

AI知识科普 | 从无人相信到万人追捧的神经网络2018-06-05 3447

-

计算机真的能像人脑一样思考 关键在神经网络2016-12-08 1277

-

神经网络技术在计算机网络通信中的应用2016-07-20 878

全部0条评论

快来发表一下你的评论吧 !