安富利手势识别平台又进化了

描述

安富利手势识别平台又进化了,在树莓派上,安富利实现了摄像头和毫米波雷达融合的手势识别方案。摄像头负责识别静态手势,摄像头读取的图像,经过openCV和机器学习分类器后,完成手势识别,最后输出1,2,3,4 等结果。后期借助于TensorFlow架构将Hand Tracking GPU整合进融合平台。毫米波雷达负责动态手势的识别, 相对于摄像头,毫米波雷达可以更好的保护客户隐私,而且算法简单不需要GPU以及神经网络的支持,因此反应更快功耗更低。目前安富利借助于英飞凌BGT60TR13芯片,实现了挥手,旋转手势以及揉搓手指等6种手势识别。关于毫米波雷达的手势控制具体内容和演示视频可参考往期文章《利用毫米波完成精细化手势识别》。

硬件平台

摄像头负责采集图像,在树莓派上借助于Python开发环境,实现了手势提取和识别。利用摄像头完成手势识别,目前有很多架构和开源代码可以参考,目前比较火热甚至被玩坏的 Hand Tracking GPU,这款应用基于TensorFlow 目前已经开源,小伙伴们可以尽情的玩起来了。

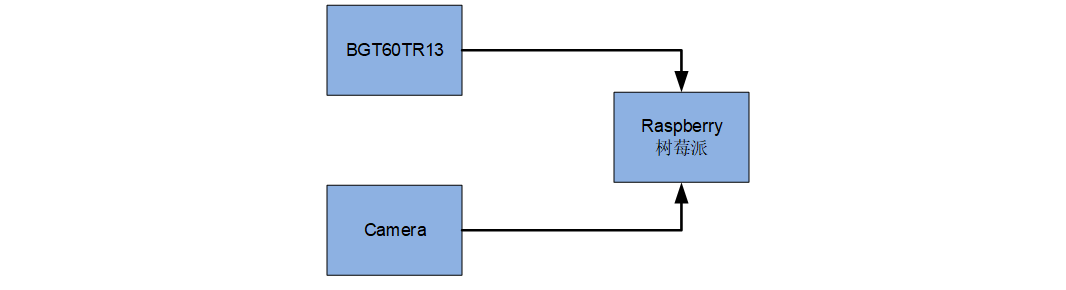

英飞凌60GHz雷达处理芯片BGT60TR13,5GHz的扫频带宽,在FMCW工作模式中,可以实现3cm的距离分辨率,可以识别精细的手势。安富利目前的手势识别算法运行在60GHz的毫米波雷达平台上,扫频带宽为3GHz,目前已经实现旋转,左右挥手,上下挥手以及揉搓手指等手势识别。树莓派作为中央处理器,接收来自摄像头和毫米波雷达的传感器数据,并完成手势识别并显示在显示屏上,方案如图 1所示。

图 1安富利手势识别平台

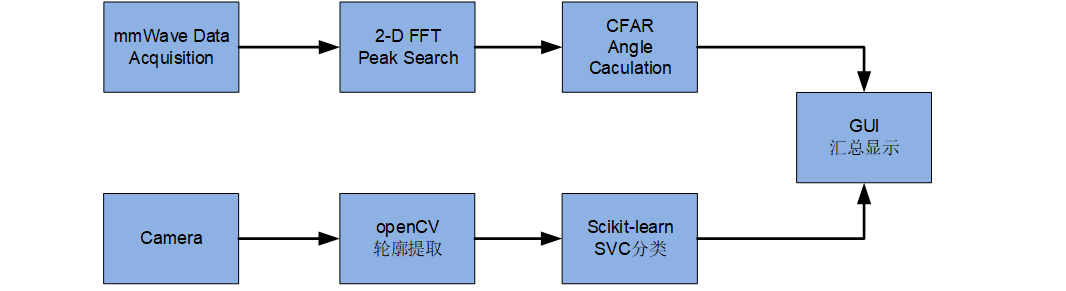

软件流程 安富利北京实验室目前已经完成一整套代码开发,方便客户做二次开发。具体功能如图 2所示,在毫米波雷达方向上信号流为2-D FFT变换, 基于硬件加速的峰值搜索,恒虚警算法筛选潜在目标,基于相差比较方法计算角度波达方向角,以及在SDK环境下的手势分类识别,最后将手势识别结果显示在GUI上。在摄像头方向上,借助于openCV完成摄像头采集,轮廓提取并借助于scikit-learn库函数中的SVC分类器完成手势分类。

图 2 软件功能框图

演示效果截图

在截图中,第一排显示的是基于摄像头的手势识别,简单演示了识别1,2,3,4,5。第二排,主要是演示了基于毫米波雷达的手势识别,能够识别左挥手,右挥手,顺时针旋转手势,逆时针旋转手势。以及包括揉搓手指的微多普勒手势,包括接近雷达和远离雷达。

全部0条评论

快来发表一下你的评论吧 !