AI可能带有性别偏见?Salesforce提出了减轻AI性别偏见的方法

电子说

描述

通过与弗吉尼亚大学的研究人员合作,Salesforce 提出了有助于减轻 AI 性别偏见的新方法。 通常情况下,研究人员需要为 AI 模型投喂许多单次来展开训练,但其中不可避免地会掺杂一些或隐性、或显性的性别偏见。 然后在执行语言翻译或其它预测任务的时候,这些 AI 也会沾染上一些不良习性。

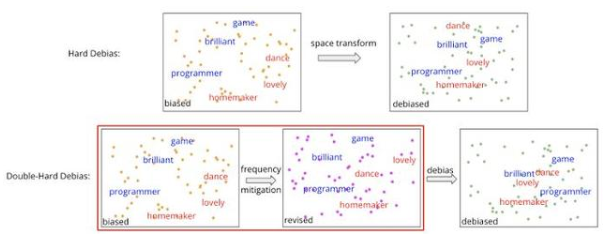

双硬去偏器示意

有鉴于此,研究团队尝试纠正某些规律性,比如大数据集中的单词频率,以使 AI 在推理前对嵌入的内容进行“纯化”,抛弃那些带有性别歧视的词汇。

这套方案可以捕获单词的语义、句法、以及同其它单词的关系,此前已被许多自然语言处理(NLP)方案所采用,但因不可避免的性别偏见而遭到批评。

先前补救方案是在后处理过程中引入几个步骤,以剔除与性别歧视相关的成分,但有效性受到了较大的限制,比如在去偏见操作后又被复原了。

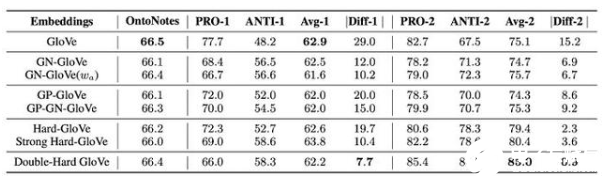

双硬去偏器基准测试成绩

为此,Salesforce 提出了名叫“双硬去偏”(Double-Hard Debias)的新方案,以将嵌入空间转换为表面上无性别的子空间。

然后在执行另一次消除偏见的操作之前,它会沿着这个维度去“投射”性别成分,以获取修改后的嵌入内容。为评估效果,研究人员针对 WinoBias 数据集开展了测试。

该数据集由赞成性别定型和反对性别定型的句子组成,性能差距反映了算法系统是如何在两个句子组上执行、并导致“性别偏见”的得分。

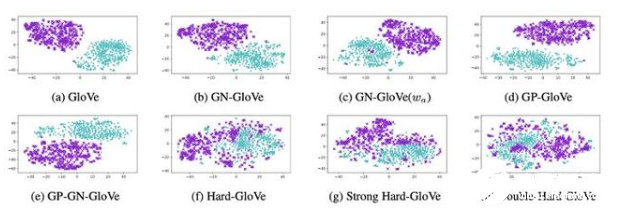

tSNE 嵌入投影

结果显示,在保留语义信息的同时,双硬去偏方案将使用 GloVe 算法获得的嵌入偏差得分,从 15 分砍半到了 7.7 分。此外在对嵌入进行建模的可视化(tSNE 投影)上,它也较其它方案的混合更加均匀。

即便如此,一些专家仍认为无法从词嵌入中完全消除偏见。比如慕尼黑工业大学的最近一项研究,就表明“没有天然中性的文本”。因为单词的语义内容,是始终与社会环境联系在一起的。

-

AI输出“偏见”,人类能否信任它的“三观”?2025-08-04 1238

-

性别偏见探索和缓解的中文数据集-CORGI-PM2023-02-10 1403

-

芯驰科技对打破创投圈性别偏见的看法2022-03-11 2697

-

Google遵循AI原则减少机器翻译的性别偏见2021-08-24 3548

-

消除人工智能模型偏见的方法2021-03-04 2721

-

如何消除对AI的偏见?2020-08-12 1445

-

Cloud AI提供免费消除性别偏见 将不再标识性别2020-03-20 989

-

如果没有正确实施 人工智能可能带来更多的偏见2019-05-06 943

-

IBM打造百万人脸数据 意图减少AI偏见与歧视问题2019-02-13 608

-

当你被AI歧视 如何解决这种偏见2018-06-11 2326

-

本应公平公正的 AI,却从数据中学会了人类的偏见2018-06-02 3493

-

基于情绪特征用户性别识别2017-11-25 570

-

那个涉嫌性别歧视被开除的谷歌工程师,到底吐槽了些什么?2017-08-15 3922

全部0条评论

快来发表一下你的评论吧 !