阐述未来智能趋势 自动机与神经网络

人工智能

描述

人类的智能主要包括归纳主义和逻辑演绎,这两大方面分别对应着人工智能中的联结主义和符号主义。人类对大量低级信号的处理(如视觉信号以及听觉信号)的感知处理都是下意识的,这便是基于大脑皮层神经网络的学习方法;而大量数学公式的建立与推导,定理的证明具有强烈的主观意识,是基于公里体系的符号演绎方法。

“1931年,天才数学家图灵提出了著名的图灵机模型,它奠定了人工智能的的基础。1942年,麦克洛克和皮茨提出了著名的人工神经网络模型,该模型一直沿用至今,它奠定了所有深度学习模型的基础。神经网络代表了一大类擅长并行计算的复杂系统,而图灵机则代表了另一类以穿行方式计算的复杂系统。计算机之父冯诺伊曼已经指出,图灵机和神经元本质上彼此等价,我们可以用图灵机模拟神经元,亦可使用神经元模拟图灵机。二者皆是图灵完备的。

联结主义的代表——神经网络

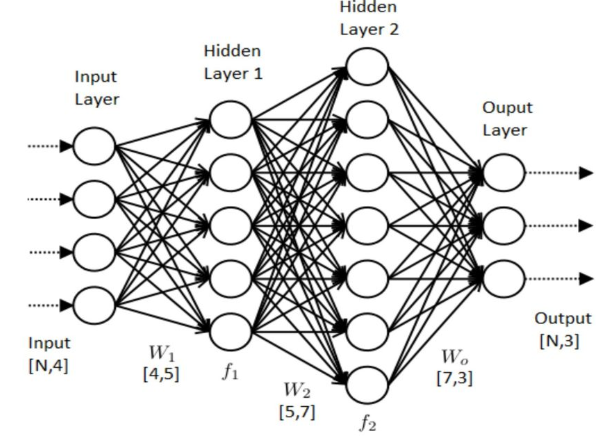

(带有两个隐层的人工神经网络)人工神经网络是一种借鉴了生物神经系统 神经网络系统的计算模型,神经网络由大量的人工神经元与神经元之间的突触组成。神经网络对输入的信号进行层级加工,将最初的输入信号进行特征提炼之后对特征进行组合学习。近几年来,随着算力和海量数据的积累,基于神经网络的人工智能技术已经取得了前所未有的突破:在图像识别领域最为先进的深度学习模型在某些模式识别领域取得的成果已然超过人类水平,使用深度对抗网络的模型可以生成及其仿真的图片。而在自然语言处理中,基于自注意力的transfomer模型更是将机器翻译[1],文本生成等任务带上了新的高度。另一方面,神经网络的生物学基础也得到了越来越多的支持,已有研究指出,基于卷机的神经网络工作原理与视神经系统具有高度相似性,而另一些对于脑科学的研究已经揭示出了大脑对视觉和听觉等信号的计算方式是通用的。这充分说明了以神经网络为框架的人工智能的可行性。

虽然基于深度学习的人工智能取得了巨大的进步,但当前神经网络面临着巨大的问题,这些问题已然导致神经网络即将走到其发展的瓶颈期。至今,还没有准确且统一的数学模型可以完全解释神经网络的工作原理。缺乏理论框架导致对神经网络研究缺乏目标性,神经网络的研究进展逐渐放缓。以至于当今对神经网络的研究大部分都集中在寻找更合适的超参数,或通过不同类型的神经网络之间的组合来换取微小的精确度提高。今年,何凯明团队实验并发表了论文[2]:使用随机连接构成的神经网络依然可以有效的工作,这些随机连接的神经网络取得的结果甚至可以超过一些经过人工精心设计的网络结构。不约而同的,谷歌大脑也在今年提出了不需要学习权重的神经网络[3]。这两篇论文都说明了必须寻找可解释的神经网络理论。

自动机理论

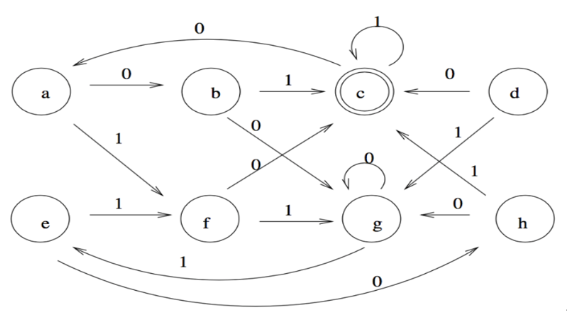

自动机是一种可以表示为数学模型的抽象计算机器,广义上,不管是人工神经网络还是图灵机这类的计算模型都属于自动机理论范畴。自动机可以用严格的数学语言描述:一般的有限状态定向自动机被定义为一个五元组 (Q, A, G, S, F)。 其中符号Q被称为自动机状态的集合,A表示可以被自动机接受的符号集合,G是一组状态转换函数,其中的函数定义了自动机在接受特定的符号时,自动机会由当前状态跳转到下一个状态。S被定义为自动机初始状态的集合,而F被定义为自动机最终状态的集合。给定输入之后,自动机会根据当前状态与状态转移函数进行自动计算。通过设计不同的状态和状态转换函数,可实现对不同的系统的模拟。

(具有8个状态的有限自动机)自动机的背后有着严格的数学以及逻辑理论作为依靠。早在上世纪,学者们便开始尝试设计各种不同的自动机模型来模拟智能,这些尝试取得了非常令人惊讶的结果。计算机之父冯诺伊曼于40年代左右设计了被称为元胞自动机的模型。元胞自动机是由一群简单的小型自动机构成,这些小型自动机具有非常少的状态以及简单的状态转换函数,其特点是小型自动机的状态转换函数的输入包括邻居自动机的状态,也就是说每一个小型自动机更新状态的时候会受到来自其邻居的影响。只要定义了自动机们的更新规则,元胞自动机便可不依靠外部力量自行完成演化。

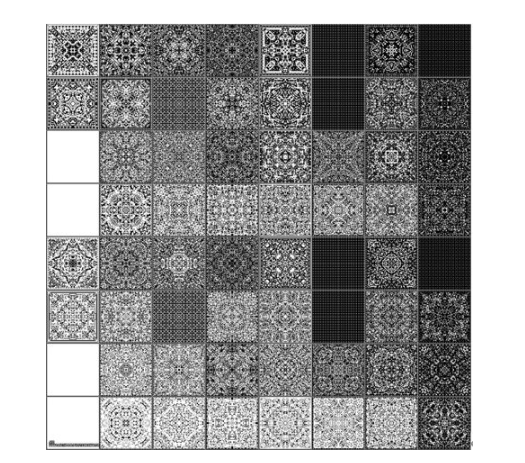

元胞自动机系统的动力学演化背后隐藏的信息极其巨大。基于不同规则的元胞自动机展现出来的行为多种多样,在冯诺伊曼之后对元胞自动机的研究揭示出了元胞自动机所能表示的系统远远超过我们的想象。Langton设计了一种可以通过改变一个全局参数来影响系统行为的元胞自动机。该全局参数如果过小,元胞自动机的行为便会非常简单。参数值过大,元胞自动机的演化便会进入混沌[4]。Langton发现,在该参数位于某个值附近的时候,元胞自动机的动力学演化会位于一种所谓的“混沌边缘”,此时系统展现出高度复杂但有序可循的模式。呈现出一种奇妙的自组织临界状态,无独有偶,今年来自巴西的物理学家通过分析多种动物的大脑,也找到了大脑处于这种临界状态的新证据。这也从从另外一个角度间接证明了元胞自动机可以模拟复杂的智力系统。

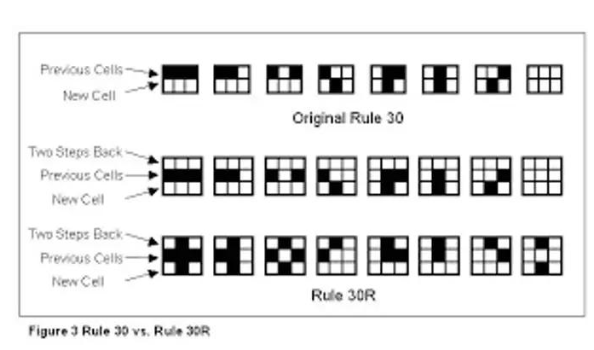

(元胞自动机状态转换规则示例)

(基于不同状态转换函数的元胞自动机演化结果)

(处在“混沌边缘”的元胞自动机)上世纪50年代,前苏联数学家Tsetlin提出了可进行学习的自动机[5],此种类型的自动机可以通过从学习数据中改变自身的状态转换函数的概率来对数据进行学习。并可以使用自身的状态来编码信息,不同于神经网络,这种自动机天然的具有对数据进行时序编码的特性,且其具有良好的可解释性。

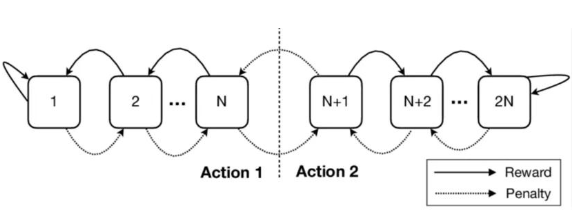

(Tsetlin学习自动机,其包含2N个状态与两个动作:惩罚与奖励,通过设计状态转移函数调节两个动作的行动概率,以此实现自Tsetlin提出学习自动机之后,人们逐渐意识到传统自动机与概率论结合组成的学习自动机亦可对智能系统进行模拟。目前人工智能领域的专业杂志上出现了越来越多的使用可学习的自动机进行智能任务的论文,并取得了令人惊讶的结果。来自挪威阿格德尔大学的学者提出了一种基于Tsetlin学习自动机,并结合布尔逻辑的新型智能模型[6],该模型由简单的Tsetlin学习自动机集群组成,使用布尔函数进行特征表达。该模型的训练速度以及内存占用率是当前的神经网络的数百分之一。

自动机在人工智能的潜力

自动机与传统神经网络的结合也可能是未来智能的趋势。自动机是形式语言的数学模型,任何计算定理的证明或逻辑推理都可用自动机描述。而当下神经网络在逻辑推理任务上的表现并不是很好,逻辑推理任务往往需要构建清晰的逻辑规则以及逻辑链,这恰恰是自动机语言所擅长的。今年,有团队实验了使用自动机来指导强化学习,将强化学习的子任务建模为自动机的状态,并结合时序逻辑来建模子任务的相关性以及完成的先后顺序,并以此规则来指导强化学习。不仅如此,来自马里博尔大学的研究者在今年12月(2019年)发表了最新论文[7]:通过使用元胞自动机可以将不同种类的分类器组合成多重分类器(MCS),经过适当规则设计的元胞自动机可以自主的将各种机器学习方法得出的不同分类器组合到MCS中。并通过元胞自动机强大的自组织能力将特定的分类问题分配到对应的可以解决该问题的分类器上。

综上,自动机与神经网路的结合展现出了巨大的潜力,一方面,自动机的背后有着严格的数学以及逻辑理论作为依靠,使其拥有良好的可解释性。另一方面,自动机对于逻辑推理的建模是天然的,而神经网络擅长对数据特征的提取,结合二者优势的模型便可看作联结主义与符号主义的结合。

未来的工作

1. 使用已发展的自动机理论来解释指导当前人工神经网络与强化学习的模型搭建,自动机理论已非常成熟,寻找当前神经网络理论与自动机理论的结合点可使神经网络的黑箱更加白化。极光无限正在研究将自动机与强化学习,渗透测试相结合,利用自动机的逻辑推断,自动学习顶级渗透测试工程师们的攻击路径和攻击模式,以达到全天候自动化渗透测试的目的。

2. 发掘并设计更多的自动机架构,融合到人工神经网络结构中。各发挥所长:如使用神经网络进行特征提取,使用自动机完成特征的组合与推断。亦如利用自动机的内部状态等信息进行辅助编码,赋予神经网络更强大的时序与记忆功能。

3. 设计专门的自动机网络,以达到甚至取代当前神经网络的目的。当前神经网络有很多弊端,比如可解释行,执行效率等,这些都可以通过自动机网络得到解决。但是自动机网络本身也有很多问题亟待解决,比如底层理论,训练方式等等,我们相信未来的人工智能有自动机网络的一席之地。

-

BP神经网络和人工神经网络的区别2024-07-10 3018

-

深度神经网络与基本神经网络的区别2024-07-04 2528

-

卷积神经网络模型发展及应用2022-08-02 13208

-

如何利用卷积神经网络去更好地控制巡线智能车呢2021-12-21 1802

-

基于BP神经网络的PID控制2021-09-07 2587

-

如何构建神经网络?2021-07-12 1862

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 3180

-

卷积神经网络如何使用2019-07-17 2745

-

【PYNQ-Z2试用体验】基于PYNQ的神经网络自动驾驶小车 - 项目规划2019-03-02 5012

-

神经网络解决方案让自动驾驶成为现实2017-12-21 8764

-

智能控制--第7章 典型神经网络2017-09-24 2047

-

自动机械设计2017-08-02 1566

-

未来的人工智能技术趋势是什么?2015-12-23 3445

全部0条评论

快来发表一下你的评论吧 !