谷歌向神经网络手写数字识别发起挑战,竟用量子计算识别

电子说

描述

用神经网络做 MNIST 手写数字识别是机器学习小白用来练手的入门项目,业内最佳准确率已经达到了 99.84%。但最近,谷歌向这个「古老」的数据集发起了一项新的挑战:用量子计算来进行识别,看看准确率能达到多少。

MNIST 对于机器学习研究者来说再熟悉不过了,它是一个由 Yann Lecun 等人创建的手写数字图像数据集,包含训练集和测试集,训练集包含 60000 个样本,测试集包含 10000 个样本(在 2019 年又增加了 50000 个测试集样本)。

在机器学习研究中,MNIST 手写数字图像数据集已经作为基准使用了二十余年,它可以说是所有机器学习研究者的入门必备。对于新兴方法的研究来说,从 MNIST 开始也是最合理的选择,2017 年 Geoffrey Hinton 提出的胶囊网络(Capsule Networks)也是这样做的。

目前,大部分深度学习模型在 MNIST 上的分类精度都超过了 95%。有时为了更直观地观察算法之间的差异,我们会使用图像内容更加复杂的 Fashion-MNIST 数据集。

在准确率已经如此之高的情况下,用神经网络向此数据集发起挑战已经没有多大意义。于是,谷歌索性换了一个思路:用量子计算技术来挑战一下,看看分类准确率能达到多少。

实验结果表明,用量子计算技术可以在 MNIST 数据集上至少实现 41.27% 的分类准确率,而之前的经典方法只能达到 21.27%。

为什么要这么做?

在现代科技中,量子力学和机器学习都发挥着重要作用,量子计算的 AI 应用这一新兴领域很有可能帮助许多学科实现重大突破。然而,目前大多数机器学习从业者对量子力学还没有透彻的了解,多数量子物理学家对机器学习的理解也非常有限。因此,找到一些二者都能理解的问题非常重要,这些问题既要包含简单且被广泛理解的机器学习思想,也要包含类似的量子力学思想。

基于以上考量,谷歌的研究者提出用简单的量子力学知识解决一种简单的机器学习问题——MNIST 手写数字分类。这有点类似于谷歌的 TensorFlow Playground。TensorFlow Playground 本质上就是一种教学辅助,目的是向大众阐明深度学习的关键概念。

研究细节

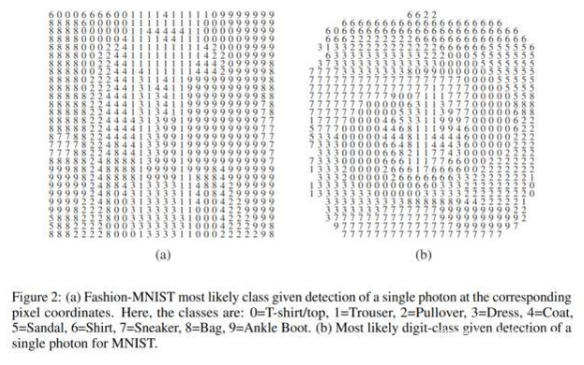

具体来说,研究者想要探究的是:在一个普通的图像分类问题中,如果你必须在通过一个 filter(可以显示来自测试集的示例图像)的第一个光量子(光子)之后做出决定,最高准确率能达到多少?在 MNIST 手写数字数据集上(28×28 像素),最佳经典方法是检测落在其中某个像素上的光子,然后使用在训练集上观察到的 per-pixel 概率(即光强度)分布来选择最有可能的数字类别。这需要将每个示例图像的亮度缩放到一个单位和(unit sum),以获得一个概率分布。在 MNIST 数据集上,上述经典方法可以实现 21.27% 的分类准确率,大大高于随机结果(10%)。每个像素最有可能的数字类别如下图 2(b)所示。

如果可以将学习到的转换应用到图像和检测器之间的光子的量子态,我们就能利用量子力学实现更高的准确率。分束器和移相器等无源线性光学器件(passive linear optical element)可以用来解决这一问题,它们可以产生一种全息图式的干涉图样。接下来,根据第一个光子落在哪一个区域来进行最大似然估计。这说明了一种量子原理:单个量子的概率振幅与自身发生干涉。此处没有必要同时用许多光子照亮一个场景来产生干涉。

从概念上讲,利用干涉来增强量子实验产生所需结果的可能性是所有量子计算的基本思想。这个问题与现代量子计算之间的主要区别在于,后者试图通过控制多个「纠缠」成分的量子态来执行计算,这些「纠缠」成分通常是耦合了两种状态的量子系统(被称作「量子比特」),通过由整个量子系统量子态的一部分所控制的「量子门」来实现。

因此,构建有多个量子比特的量子计算机需要精细地控制量子比特之间的相互作用。这通常需要将温度降至 0.1 开尔文(-273.05℃)来消除热噪声。

但是,在本文研究的这个问题中,量子态之间的转换可以在室温下使用常规光学器件来完成:绿色光子的能量为 2.5 eV(电子伏特),远高于典型的室温热辐射能量 kT ‘ 25 meV。但制造一种允许多个光子像在多比特量子计算机中一样交互的设备就非常具有挑战性了。

尽管如此,Knill、Laflamme 和 Milburn 等人在 2001 年设计了一种协议,使其在理论上可行。他们通过巧妙地利用辅助光子量子比特(ancillary photon qubit)、玻色统计和测量过程避免了使用保留相干性的非线性光学器件(可能无法通过实验实现)。在所有此类应用中,基本思想都是采用相干多光子量子态进行多个量子比特的计算。

在这个问题中,研究者只用了一个光子,唯一要处理的相关信息被编码在其波函数的空间部分(即偏振无关)。因此,当前的工作类似于由 Cerf 等人在 1998 年提出的「量子逻辑的光学模拟」,其中一个 N 量子比特的系统由一个光子的 2^N 个空间模式表示。目前相关的研究有用于实现各种算法的类似「量子计算的光学模拟」,包括(小)整数分解等,但仍未与机器学习关联起来。

本研究可以被归为量子不可扩展(non-scalable)架构上的机器学习方法范畴。或者,我们也可以将其视为一项最新研究 (Khoram et al. [2019]。) 的量子模拟。

研究者表示:「从概念上说,利用干涉来提高量子实验产生所需结果的可能性是量子计算领域的基本思想。」除了为量子和机器学习专家提供一个容易理解、上手的问题之外,这对于在更易访问的环境中进行测量过程的物理学教学(通常被称为波函数的坍缩)也有一定意义。

遇事不决,量子力学

研究者说,这项工作旨在展示简单的量子力学技术如何能够为解决 AI 问题提供新的思路。

在 MNIST 上,最经典的计算可以实现的是检测落在图像像素之一上的光子,并根据光的强度分布猜测数字,光的强度的分布是通过将每个图像的亮度重新缩放为单位和而获得的。

该研究的量子力学方法采用分束器、移相器和其他光学元件来创建类似全息图的推断图。光子所降落的推断模式区域可作为信息提供给图像分类,从而说明了不必同时用多个光子照射一个场景来产生干涉。

有人预测,量子计算将大大推动人工智能和机器学习领域的发展。去年 3 月,IBM、麻省理工学院和牛津大学在《自然》杂志发表了一篇文章,称随着量子计算机变得越来越强大,它们将能够执行特征映射,也就是将数据分解为非冗余特征。如此一来,研究者将可以开发出更高效的 AI,比如去识别传统计算机无法识别的数据模式。

在那篇《自然》杂志的文章中,作者们这样写道:「机器学习和量子计算是两种技术,每一种技术都有潜力改变彼此之前无法解决的难题。量子算法所提供的计算加速的核心要素是通过可控的纠缠和干涉来利用指数级的量子态空间。」

-

基于毫米波雷达的手势识别神经网络2024-05-23 3072

-

粒子群优化模糊神经网络在语音识别中的应用2010-05-06 2445

-

基于BP神经网络的手势识别系统2018-11-13 2143

-

【PYNQ-Z2申请】基于PYNQ-Z2的神经网络图形识别2019-01-09 2816

-

【PYNQ-Z2试用体验】神经网络基础知识2019-03-03 3845

-

【PYNQ-Z2试用体验】基于PYNQ-Z2的神经网络图形识别[结项]2019-03-18 7173

-

容差模拟电路软故障诊断的小波与量子神经网络方法设计2019-07-05 2654

-

【案例分享】ART神经网络与SOM神经网络2019-07-21 3180

-

可分离卷积神经网络在 Cortex-M 处理器上实现关键词识别2021-07-26 3717

-

神经网络模式识别源代码2008-01-02 750

-

人工神经网络手写数字识别系统的详细资料概述2019-05-27 1383

-

使用PyhonFluxJulia实现手写数字识别的神经网络入门教程2020-12-08 835

-

手写数字识别神经网络的实现(2)2023-06-23 1255

-

卷积神经网络如何识别图像2023-08-21 2645

-

神经网络在图像识别中的应用2024-07-01 1614

全部0条评论

快来发表一下你的评论吧 !