全球AI芯片公司有哪些?国外AI的芯片发展情况如何

电子说

描述

NPU(AI芯片)和GPU的亮点在于它们能够运行多个并行线程。NPU通过一些特殊的硬件级优化,比如为一些真正不同的处理核提供一些容易访问的缓存系统,将其提升到另一个层次。这些高容量内核比通常的“常规”处理器更简单,因为它们不需要执行多种类型的任务。

寒武纪在A股科创板上市,成为AI芯片第一股,就引起了业内的热议和关注。 根据相关的资料显示,目前中国IC设计企业已超过1500家。但AI芯片的公司却比较少,创企仅超过20家。在这些AI芯片企业中,寒武纪是最突出的,尤其是最近的IPO,科创上市第一天股票便一路飙升。那么AI芯片到底是什么,与我们普通的CPU有何区别呢? 从原理逻辑来看,AI处理器是一种特殊的芯片,它结合了人工智能技术和机器学习,使芯片的移动设备足够智能,可以模仿人类的大脑,用于优化深度学习AI的工作,也是使用多个具有特定功能的处理器的系统。而普通的芯片(普通cpu)则被封装在一个更小的芯片包中,设计用于支持移动应用程序,提供支持移动设备应用程序所需的所有系统功能。

大多数时候,各个大公司营销团队发现AI(人工智能)这个词非常“前位且华丽”,所以他们几乎把它捆绑到任何可能的商业用途中。因此,你肯定听说过“人工智能芯片”,其实它是NPU(神经处理单元)的重命名版本,这些是特殊类型的ASIC(专用集成电路),旨在移动市场中将机器学习广泛应用。 这些ASIC有一种特殊的架构设计,使它们能够更快地执行机器学习模型,而不是将数据卸载到服务器,然后等待它的响应。这种执行可能没有那么强大,但由于数据和处理中心之间的障碍更小,所以速度会更快。

NPU比普通的CPU有什么优势?

通俗来说,我们可以理解为NPU就是AI芯片,普通芯片就是CPU。 CPU在一般的负载环境中工作会很好,因为它有一个较高的IPC,可以通过许多串行执行。且CPU遵循的是冯诺依曼架构,其核心是存储程序、顺序执行。CPU的架构中需要大量的空间去放置存储单元(Cache)和控制单元(Control),相比之下计算单元只占据了很小的一部分,所以它在大规模并行计算能力上极受限制,而更擅长于逻辑控制。 NPU和GPU的亮点在于它们能够运行多个并行线程。NPU通过一些特殊的硬件级优化,比如为一些真正不同的处理核提供一些容易访问的缓存系统,将其提升到另一个层次。这些高容量内核比通常的“常规”处理器更简单,因为它们不需要执行多种类型的任务。这一整套的“优化”使得NPU更加高效,这就是为什么这么多的研发会投入到ASIC中的原因。 机器学习模型处理要求CPU、DSP、GPU和NPU同时同步,这是很多芯片处理单元在共同工作。但这也解释了为什么这样执行对于移动设备来说是“沉重的”。 NPU的优势之一在于,大部分时间集中在低精度的算法,新的数据流架构或内存计算能力。与GPU不同,它们更关注吞吐量而不是延迟。

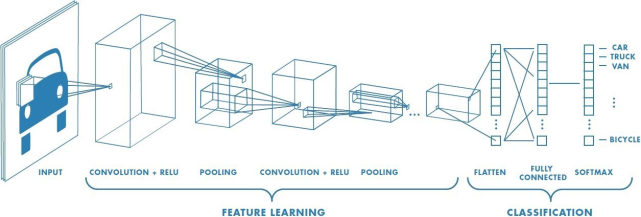

当然,AI算法是至关重要的,在图像识别等领域,常用的是CNN卷积网络,语音识别、自然语言处理等领域,主要是RNN,这是两类有区别的算法。但是,他们本质上,都是矩阵或vector的乘法、加法,然后配合一些除法、指数等算法。

另外,一个成熟的AI算法,针对卷积运算和加权求和的特定数学进行了优化。这个过程非常快。它就像一个没有图形硬件的GPU。对于AI芯片来说,如果确定了具体的目标尺寸,那么总的乘法加法计算次数是确定的。比如一万亿次, 就好比说,我用AI芯片跑程序,吃顿饭的功夫就就解决了,而CPU需要运行好几个礼拜,时间上的差距,没有任何一家商业公司会浪费时间。

全球AI芯片公司有哪些?

除了寒武纪,国内还有这些比较有名的AI芯片公司比特大陆,地平线,天数智芯,熠知电子,探境科技,燧原科技,海思,嘉楠科技等公司,都是经历了自2015年至现在的实际落地的检验期,才到现在境况。各个公司的产品也都是独特的,功耗、性能、应用场景都有自己的风格,可以在中国的广大的市场中占有一席之地。 中国AI芯片公司处于一个发展热潮中,那国外AI的芯片发展情况又如何呢?现在让我们来看看那些我们认为是人工智能芯片顶级开发者的公司,尽管没有任何特定的顺序——只是那些已经展示了他们的技术并且已经将其投入生产或者即将投入生产的公司。具体如下:

1. Alphabet(谷歌母公司) 谷歌的母公司督促着人工智能技术在多个领域的发展,包括云计算、数据中心、移动设备和台式电脑。可能最值得注意的是它的张量处理单元(Tensor Processing Unit),这是一款专门为谷歌的TensorFlow编程框架设计的ASIC,主要用于AI的两个分支机器学习和深度学习。 谷歌的Cloud TPU是应用于数据中心或云解决方案,其大小相当于一张信用卡, 但Edge TPU大小是小于一美分的硬币, 是专为某些特定的设备而设计的。尽管如此,更仔细观察这一市场的分析师说,谷歌的Edge TPU不太可能在短期内出现在该公司自己的智能手机和平板电脑上,而更有可能被用于更高端、企业和昂贵的机器和设备。

2. Apple 苹果多年来一直在开发自己arm芯片,最终可能会彻底停止使用英特尔(Intel)等供应商。苹果也基本上摆脱了与高通的纠缠,看起来确实决心要在未来的人工智能领域走自己的路。 该公司在最新款的iphone和ipad上使用了A13“仿生”芯片。该芯片使用了苹果的神经引擎,这是电路的一部分,第三方应用程序无法使用。A13仿生芯片比之前的版本更快,耗电更低。据报道,A14版本目前正在生产中,今年可能会出现在该公司更多的移动设备上。

3. ARM Arm (ArmHoldings)生产的芯片设计被包括苹果在内的所有领先技术制造商采用。作为一个芯片设计师,它不制造自己的芯片,这给了它某种优势,就像微软不制造自己的电脑一样。换句话说,Arm在市场上有着巨大的影响力。该公司目前正沿着三个主要方向开发人工智能芯片设计: Project Trillium,一种“超高效”、可扩展的新型处理器,目标是机器学习应用;机器学习处理器,这是不言而喻的; Arm NN是神经网络的缩写,它是一种用于处理TensorFlow的处理器,Caffe是一种深度学习框架,还有其他一些结构。

4. Intel (英特尔) 早在2016年,据华尔街日报报道,芯片巨头英特尔宣布收购初创公司NervanaSystems,英特尔将获得该公司的软件、云计算服务和硬件,从而使产品更好地适应人工智能的发展。但它的人工智能芯片系列,被称为“神经网络处理器”:人工神经网络模仿人类大脑的工作方式,通过经验和实例进行学习,这就是为什么你经常听到机器和深度学习系统需要“训练”。随着之前发布的Nervana,英特尔似乎将优先解决与自然语言过程和深度学习相关的问题。

5. Nvidia (英伟达) 在GPU市场中,我们提到过GPU处理人工智能任务的速度比CPU快得多,Nvidia看起来处于领先地位。同样,该公司似乎在新生的人工智能芯片市场获得了优势。这两项技术似乎是密切相关的,英伟达在GPU方面的进展有助于加速其人工智能芯片的开发。事实上,gpu似乎是Nvidia人工智能产品的支撑,而其芯片组可以被称为人工智能加速器。Jetson Xavier于2018年已经发布,该公司CEO黄仁勋在新闻发布会上表示:“这台小电脑,将成为未来机器人的大脑”。 深度学习似乎是英伟达感兴趣的主要领域。深度学习是一种更高层次的机器学习。你可以把机器学习看作是使用相对有限的数据集的短期学习,而深度学习使用在较长一段时间内收集的大量数据来返回结果,这些结果反过来被设计用来解决更深层次的、潜在的问题。

6. AMD(超微半导体) 和英伟达一样,AMD是另一家与显卡和GPU有着密切联系的芯片制造商,部分原因是过去几十年电脑游戏市场的增长,以及比特币矿业的增长。AMD提供硬件和软件解决方案,如EPYC cpu和Radeon Instinct gpu的机器学习和深度学习。Epyc是AMD为服务器(主要用于数据中心)提供的处理器名称,而Radeon则是一款主要面向游戏玩家的图形处理器。AMD提供的其他芯片包括Ryzen,也许还有更知名的Athlon。该公司在人工智能专用芯片的开发上似乎还处于相对早期的阶段,但鉴于其在GPU领域的相对实力,观察家们认为它将成为该市场的领导者之一。AMD已签约向美国能源部提供Epyc和Radeon系统,用于建造世界上最快、最强大的超级计算机之一,被称为“Frontier”。

7. Qualcomm (高通) 高通在智能手机热潮开始之初就通过与苹果的合作赚了一大笔钱,对于Apple停止购买其芯片的决定,高通可能觉得自己被冷落了。当然,高通本身在这个领域也不是什么小公司,而且考虑到未来,一直在进行一些重大投资。 去年,高通发布了一款新的“云人工智能芯片”,似乎将其与其在第五代电信网络(5G)方面的开发联系起来。这两项技术被认为是构建自动驾驶汽车和移动计算设备新生态系统的基础。分析师表示,高通在人工智能芯片领域算是后来者,但该公司在移动设备市场拥有丰富经验,这将有助于实现其“让设备上的人工智能无处不在”的目标。 当然,其他还有Samsung(三星), TSMC(台积电), Facebook(脸书), IBM, LG等大型国际公司也在研发自己得AI芯片,谁能先掌握最前沿的AI芯片,谁就能在新的经济上升潮流中分一杯羹。 各个大公司的市场部描绘给我们的现实与那些公司外的现实截然不同。尽管几十年的研究给了我们处理信息和分类输入的新方法,比以往任何时候都快,但我们购买的硬件中并没有真正的AI,因此哪家芯片公司能够抓住市场痛点 ,最先实现应用落地 ,就可以在人工智能芯片的赛道上取得较大优势。 目前全球人工智能产业依旧处在高速的发展 中 ,不同的行业分布为人工智能的应用提供了广阔的市场前景 ,商业化的社会需要人工智能的应用 ,AI芯片是实现算法的硬件基础 , 也是未来人工智能时代的战略制高点,全球的各大顶级公司会为此而一战。但由于目前 的 AI 算法往往都各具优劣,只有给它们设定一个合适的场景才能最好地发挥它们的作用,也希望AI可以今早进入我们普通人的视线中。 从产业发展来看 ,现在还是人工智能芯片的初级阶段,无论是科研方向还是商业的应用都有非比寻常的创新空间。在应用场景中,算法迭代的AI芯片向具备更高灵活性、适应性的通用智 能芯片发展,这是是技术发展的必然方向。更少的神经网络参数计算位宽 ,更多样的分布式存储器定制设计 ,更稀疏的大规模向量实现 ,复杂异构环境下更高的计算效率 ,更小的体积和更高的能量效率 ,计算和存储一体化将成为未来人工智能芯片的主要特征和发展趋势。

作者:腾讯新闻知识官、美国宾州州立大学硕士、芯片工程师 Zach小生

参考资料: 1.《2019年中国IC设计行业投资前景研究报告》 2. 人工智能芯片发展的现状及趋势【J】 科技导报

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片到AGI芯片2025-09-18 4850

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战2025-09-12 2968

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+内容总览2025-09-05 3357

-

AI芯片哪里买?芯广场 2024-05-31

-

AI芯片的诞生和发展背景 AI芯片发展的技术方向 AI芯片的发展趋势2023-08-16 5389

-

大把AI芯片公司,将倒在2023年?电子学习 2023-02-08

-

AI芯片格局最全分析 精选资料分享2021-07-23 2814

-

【免费直播】让AI芯片拥有最强大脑—AI芯片的操作系统设计介绍.2019-11-07 5257

-

AI芯片公司该如何在激烈的竞争中生存?2019-09-16 2538

-

AI芯片怎么分类?2019-08-13 4720

-

AI发展对芯片技术有什么影响?2019-08-12 3366

-

细数19大AI技术及其全球AI芯片公司2019-04-25 11597

-

中国企业的崛起!全球AI芯片Top24榜单7家中国公司上榜2018-05-07 4918

全部0条评论

快来发表一下你的评论吧 !