从硬件、软件、应用生态等多层面解读苹果在AR上的布局和战略

电子说

描述

在5G·AR(增强现实)技术应用高峰论坛上,VR陀螺主编案山子以“苹果在AR上的布局和战略解读”为主题发表了演讲。在演讲中,案山子对苹果AR眼镜形态发展作出了个人的分析:产品形态为以MicroLED+光波导为光学方案,加以3D空间声场音频和6DOF+眼动追踪的无线分体式手机AR;当MicroLED及全息显示成熟之后,未来,手势识别将加入感知互动方式中,产品形态主要为一体式AR眼镜。基于对苹果AR产业链布局结构、在AR/VR领域的投资收购、硬件的核心器件和感知交互、软件生态、内容以及应用生态的深度剖析,案山子总结苹果产品思维具有“优化整合、追求极致、自建生态”的特点。

以下是演讲实录。

案山子:

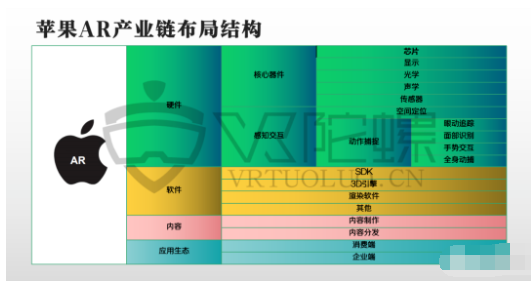

大家好,我是VR陀螺的主编案山子。苹果会有什么产品出来是大家关心的话题。从苹果现有的产业链布局来看,可以看到苹果从硬件、软件、内容、应用生态等各个层面都有它的布局。

苹果的AR产业链布局

从整体上看,核心器件包括芯片、显示光学声学、传感器,全部都已经有企业研发,甚至有产品出来;感知交互包括空间定位和动作捕捉,苹果都有了相应的应用。软件方面更多从工具上进行布局,包括SDK 3D引擎渲染软件,以及其他辅助性软件。内容制作上,苹果2017年推出ARKit,这样做的意义表现在了让原来手游、app开发者加入了AR开发阵容中来。中游的内容分发集中在app store,而下游的应用生态集中在消费端和企业端。其中值得注意的是,iPhone使用中的面部追踪和识别,现在目前推出的是人脸解锁,实际上同时应用了眼动追踪,如果眼睛不看向屏幕的话是不会解锁的。

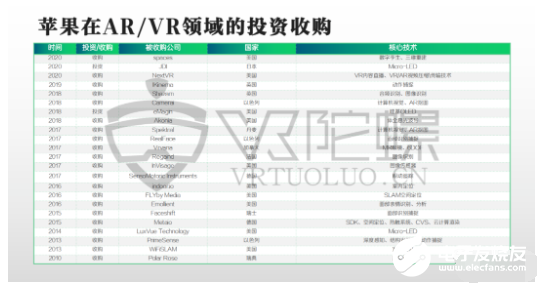

通过对苹果在AR/VR领域的投资收购的整体分析,直观上可以看到其实收购的并不多,大部分以收购形式进行都是底层公司。早些时候,从硬件底层来布局,比如2010收购面部识别硬件技术公司Polar Rose;到了近期,包括苹果前阵子收购的NextVR等公司,是属于内容端,收购的方向偏表层而且收购时间相对来说比较晚。

核心硬件技术:储备、收购和开发

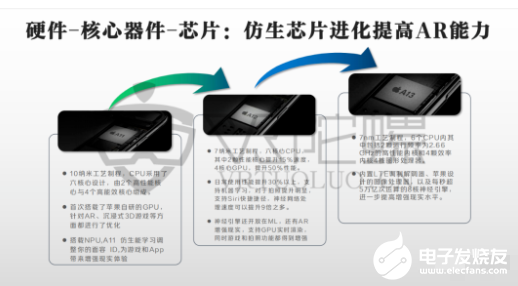

从硬件上来看,苹果在核心器件上主要推仿生芯片,今年是A11仿生芯片,并且首次在手机端实现了ARKit功能。ARKit最早只能实现平面识别,环境和空间感知没那么强,后来平面、侧面识别和肢体手势结合,可以实现人体骨骼动作,虽然没有光学动捕那么深度,但现在已经能够做到基础交互了。

另一个核心芯片包含了UWB超宽频芯片,这是一个无线传输技术,从A11开始采用。与蓝牙相比,传输速度快了几百倍(蓝牙只能1m/s)。高效传播速率、高精度定位、传输距离适中、低能耗是UWB超宽频芯片的优势,但使用者需对网络重新进行部署,并且需要使用专用的信号测量设备,劣势在于实现成本较高。

关于显示屏。苹果目前储备Micro-LED技术,其中有潜力的是全息波导光学方案,而且收购的大部分是Micro-LED的企业。但技术难题是Micro-LED还没有量产出来,全息眼镜基本没有量产的产品。说到屏幕的基本参数,从L-COS、DLP、硅基OLE,到Micro-LE,差异挺大的,可以看出Micro-LED优势明显,亮度上能达到100,000nit(全彩) 10,000,000nit(蓝/绿)的量级。

2018年收购的光波导企业AKONIA,是苹果在全息光波导上布局的一个重要企业。AKONIA的创始科学家都是贝尔实验室全息技术研发团队的核心成员,公司拥有原型设计和制造设备,以及200多项与全息系统和材料相关的专利。目前苹果获得美国专利局审批通过的光波导领域专利共有 5份;外媒和内媒等多方消息报道称苹果在与国内代工厂商试生产光波导镜片等。虽然专利很多,但并不能代表苹果完全生产出来,只能说明未来的技术路径将会沿着这个方向走。

在声学布局上,同步的视觉和听觉沉浸感是真正实现虚拟现实体验的关键。苹果的全景声效果采用了可追踪定位的空间声场技术,其Air pods产品融合追踪定位的空间声场技术,将为苹果未来的AR眼镜奠定音频技术基础,以保证全沉浸,并能够跨设备无缝切换,实现空间音频全景声效果。其中的技术复杂度完全不亚于一台iPhone手机。

在传感器方面,苹果于2013年收购了3D传感器Prime Sense。3D传感器用在人体动作捕捉、近距离的环境识别中,苹果的Animoji也是用到这个技术。收购图像传感器厂商InViage,是Ar/Vr布局的一环。今年的苹果发布会上,苹果ipad pro有搭载 iphone逐步搭载TOF传感器,不仅是简单的环境识别,而是有深度的识别,能够与虚拟物体进行交互,这对于实现混合现实很有利。

苹果的技术储备深厚,功能也逐渐上线了。眼动追踪技术已应用于Face ID,面部识别比较成熟,手势交互尚未落地使用,ARKit已支持动作捕捉功能。

软件:AR软件生态逐步完善

2017-2020年,ARKit软件在三年内的升级迭代,总体上保持着一年一个迭代的节奏。值得注意的是,在2017年时候推出SDK,18年就推出了.usdz文件格式和AR Quick Look模型预览工具。我们认为,.usdz是在AR时代定义AR文件格式的重要标志,像我们现在安卓app是.apk,ios是.ipa。2019年上线ARKit 3.0 Reality Kit(AR渲染平台)以及Real it y Composer(3D开发工具),帮助开发者更快建模。后续上线的Reality Converter(AR格式转换工具),也是帮助开发者更简单地进行AR开发。ARKit的功能无论是环境识别还是人脸识别等方面,都需要大量的数据以达到更精准识别的效果。

苹果AR软件技术生态,说明苹果的AR生产闭环已经形成了。App Clips或是AR眼镜的app形态。像我们现在的东西是越来越轻的,未来到云端已是个趋势,只是现在的5G或者5G手机还未普及。用这个技术的话让你无需下载完整的应用就能与之互动,程序容量十分小。而App Clips程序体量小,如果功耗很大的话对设备是一个负担,运算量小、可多渠道访问的App Clips,是AR眼镜的完美搭档。

苹果底层的链条布置完善,这两年开始有内容生态上的动作。收购VR/AR直播企业Next VR、收购虚拟现实初创公司Spaces、Apple TV+流媒体视频服务中增加VR/AR内容,在我们看来也是内容生态上重要的一步。

目前还没有ios AR app最新的数据。从这几年来看,App store的AR应用的量并不大,相比传统手游,有一定局限性,但最火的AR app《Pokémon GO》全球销量达30亿美元。陆续出现的Niantic大规模的融资、哈利波特IP的AR游戏、任天堂的马里奥AR,说明在赛道上的大家还蛮有兴趣的。除此之外,苹果在传统游戏市场的关注度增高,内容产品主要针对C端市场。

苹果的AR产品形态分析

苹果产品思维:优化整合、追求极致、自建生态。我们认为,特点一:无线。把AR眼镜作为与手机或类似iwatch手表的定位装置,计算单元有可能是独立的芯片。像目前部分AR眼镜通过可穿戴的芯片进行计算,虽然计算性能不算高,但是在前期并不要求AR眼镜实现非常酷炫的游戏效果,只要求其做到像手机在抬头显示时的显示效果,或者其他轻度的交互,可以让用户先体验到AR带来的不同的特性,或习惯新的交互方式。特点二:无接口。无线传输十分成熟,很大可能可以用在AR眼镜上,甚至可能在iPhone13之后会没有接口。目前无线充电、蓝牙耳机都已经很成熟了,按照苹果的风格来看,他们并不是使用最新的东西,而是把现有的、成熟的技术用在产品生态上,这样能带来成熟的体验,也能避免经常产生bug的情况。最后,苹果目前还是自建闭环生态。

眼镜形态的猜测,前期是分体式的(可穿戴式设备),当Micro-LED及全息显示成熟之后,会做一体式的产品形态。前期偏轻便一些的抬头显示,以后戴上眼镜后一抬头就能看到手机上面的东西,至少对人体健康有意义。

责编AJX

-

时钟软件层面和硬件层面的问题解释2021-11-29 1052

-

基于卷积神经网络多层面二阶特征融合模型2021-04-12 837

-

鸿蒙强势布局2021 库克对苹果做出战略布局2021-01-20 1886

-

2021年是苹果Mac设备的更新大年2021-01-18 4972

-

百度与重庆市政府共推进大数据融合创新发展,将展开多层面合作2019-08-28 2269

-

iPhoneX开售在即准备把手机AR发扬光大,苹果号召开发者共建AR生态2017-10-07 724

-

苹果的未来:不满足于做手机 还要布局智能家居2017-06-17 3310

-

深入浅出谈多层面板布线技巧2016-12-13 668

-

VR/AR生态链重塑各端格局——硬件/内容/软件平台与服务2016-05-12 3547

-

深入浅出谈多层面板布线技巧(1)——双面板2015-01-15 29405

-

苹果HomeKit如何牵动国内智能硬件格局?2015-01-07 3200

-

联想个人云战略转型的机遇与挑战(转载)2011-12-09 3415

-

2006 年微控制器五大趋势-外围篇(微控制器基本功效解读)2009-09-24 3134

全部0条评论

快来发表一下你的评论吧 !