近期必读的6篇ICLR 2021相关论文

描述

本期的关注焦点是NLP的6篇论文。

NLP

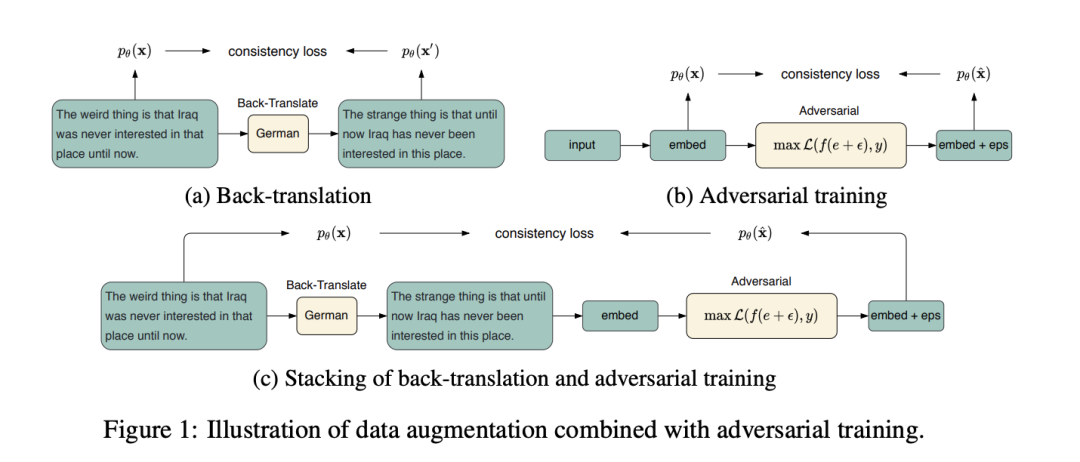

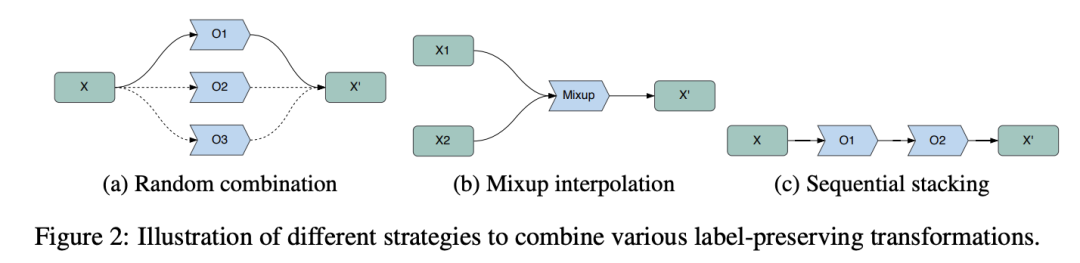

CoDA: Contrast-enhanced and Diversity-promoting Data Augmentation for Natural Language Understanding

本文设计了提出对当前在NLP领域下针对数据增广场景下如何生成更多高质量和更多样的数据及如何提升模型效果提出统一的模型,首先提出利用统一的组合策略对已有生成策略融合,另一方面借用对比思想,将生成的数据与训练中全局的数据做对比以更好提升训练质量。

论文链接:https://openreview.net/forum?id=Ozk9MrX1hvA

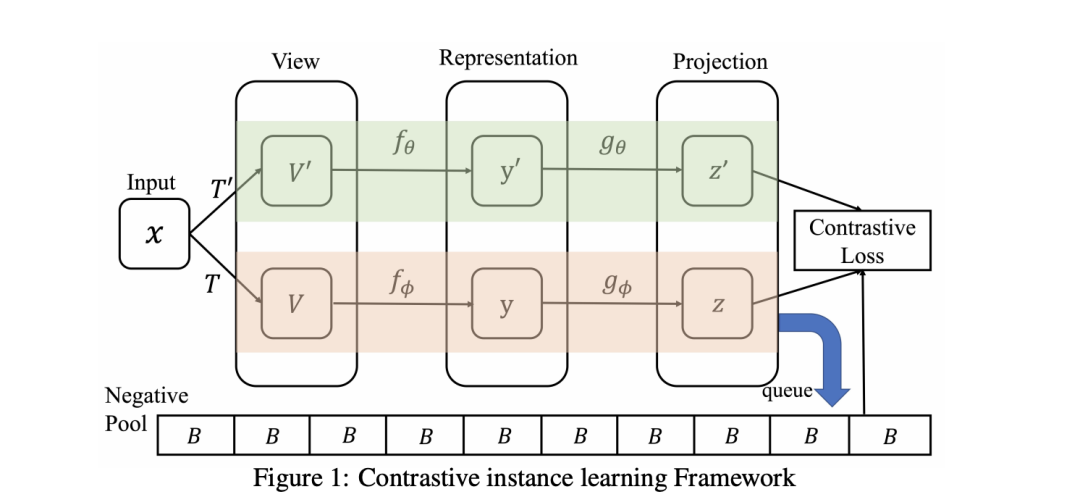

Contrastive Learning with Stronger Augmentations

文章指出现有的对比学习方法中,一些数据增强的操作可能会导致变换后的图像与原图的差异过大,强行让网络提取出相似的特征反而会减弱自监督学习的效果。作者在文中提出的解决方法是,将数据的增广操作划分为两大类,一类是不会显著改变图像视觉效果,叫做Weaker Augmentations;另一类是可能使图像发生非常大的变化的,叫做Strongerer Augmentations。在训练网络的时候,增加了一个新的损失函数,不是直接限制变换图像与原图的特征,而是通过优化原图与弱变换图像、弱变换图像与强变换图像之间的分布,达到特征学习的目的,消除上述的影响。

论文链接:https://openreview.net/forum?id=KJSC_AsN14

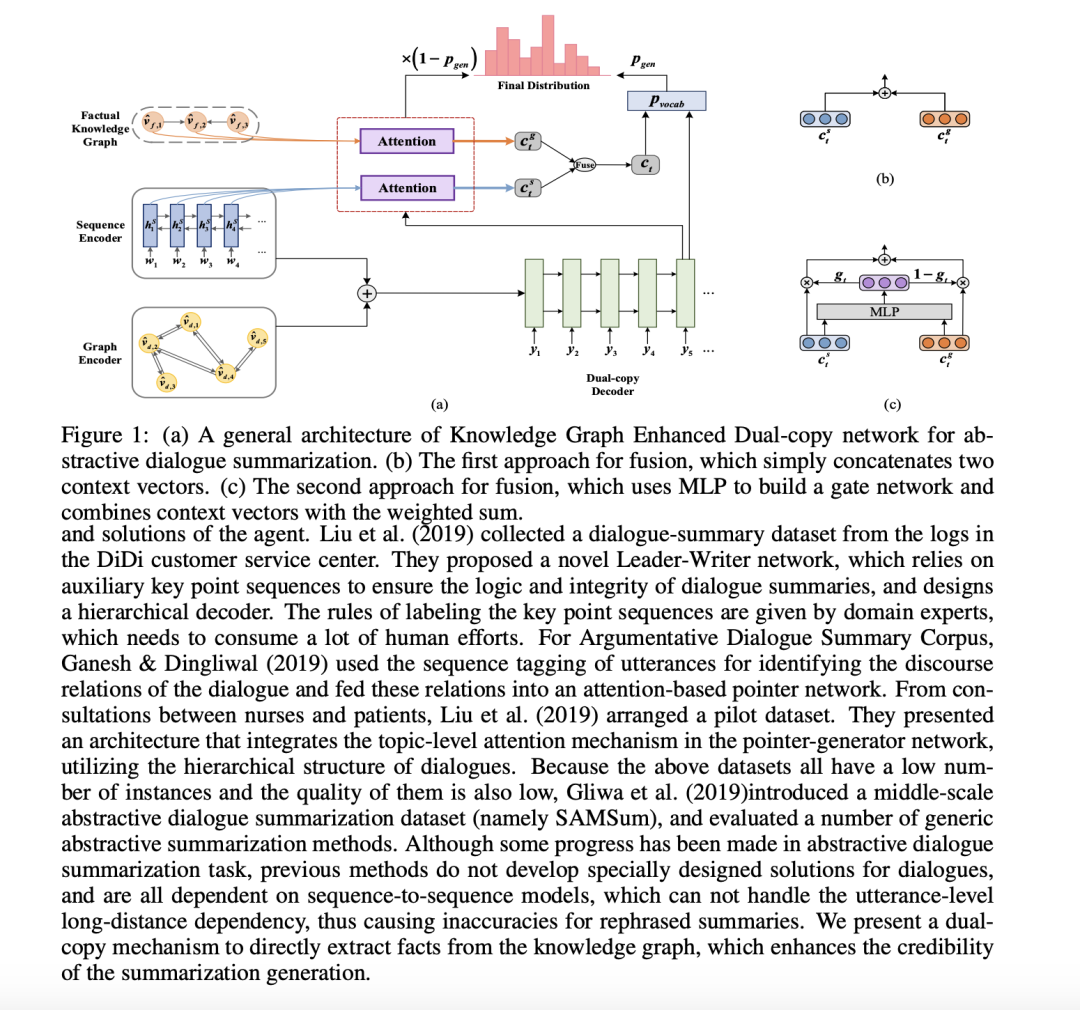

Improving Abstractive Dialogue Summarization with Conversational Structure and Factual Knowledge

在对话抽象摘要任务中,对长距离跨句关系进行捕获是必要的。此外,生成的摘要会受到虚假事实的影响。本文提出了一种知识图增强的双拷贝网络(KGEDC),它是一种基于会话结构和事实知识的抽象对话和化框架。采用序列编码器提取局部特征,用图编码器通过稀疏关系图自注意网络整合全局特征,相互补充。此外,在解码过程中还设计了一种双重复制机制,从原文本和事实中共同生成摘要。

论文链接:https://openreview.net/forum?id=uFk038O5wZ

CorDial: Coarse-to-fine Abstractive Dialogue Summarization with Controllable Granularity

本文提出一种由coarse-to-fine的对话抽象摘要生成策略,首先生成摘要草稿,然后生成最终摘要。本文也提出了控制最终摘要粒度的简单策略,可以通过预测和突出显示源文本中不同的文本跨度来自动控制给定对话生成的摘要语句的数量。

论文链接:https://openreview.net/forum?id=Uf_WNt41tUA

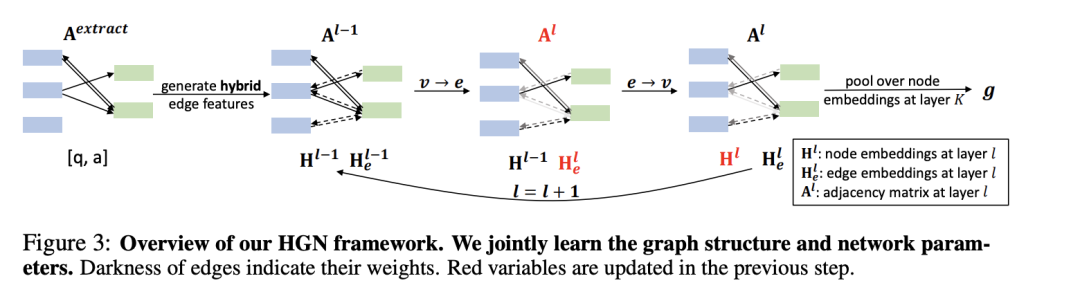

Learning Contextualized Knowledge Graph Structures for Commonsense Reasoning

为了解决外部知识图中缺少 facts 和上下文知识图中存在冗余 facts 的问题,本文提出了一种常识推理的神经符号框架 HGN。HGN 可以联合生成新边的特征,优化图结构,并学习图网络的参数,实现动态图推理。实验结果和用户研究证明了该模型的有效性。

论文链接:https://openreview.net/forum?id=lJuOUWlAC8i

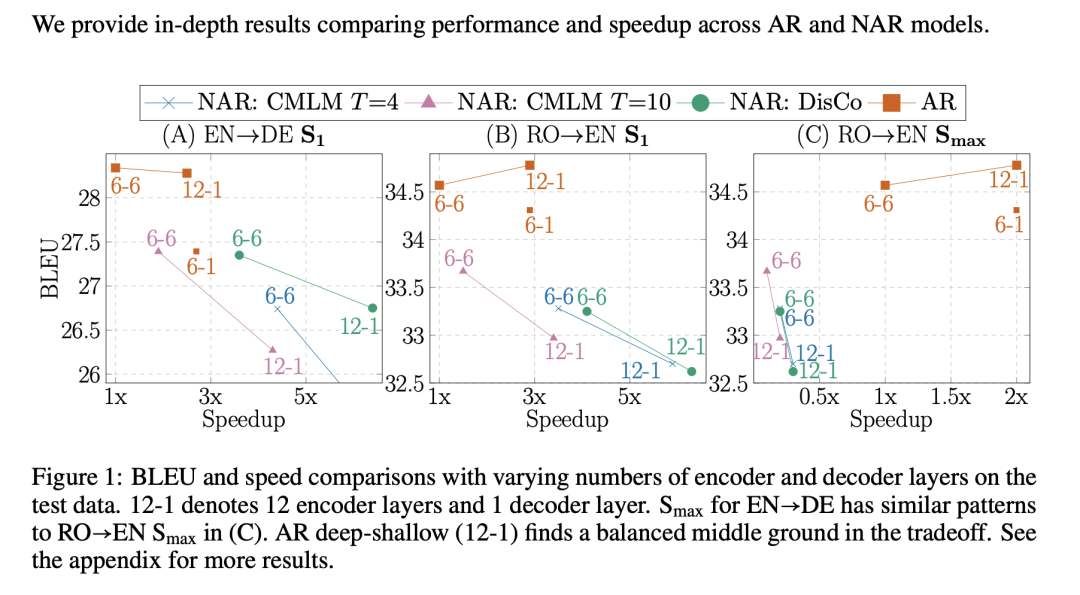

Deep Encoder, Shallow Decoder: Reevaluating Non-autoregressive Machine Translation

本文通过理论研究和实验证明,通过简单的层分配策略(深层编码器-浅层解码器)可以大大加快自回归神经机器翻译的速度。与强非自回归模型相比,深-浅自回归模型以近似的速度实现了翻译质量的显着提高。另外,深层编码器-浅层解码器的模型可以用于任何序列到序列任务,包括大规模预训练。

论文链接:https://openreview.net/forum?id=KpfasTaLUpq

责任编辑:xj

原文标题:【NLP】近期必读ICLR 2021相关论文

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

-

后摩智能四篇论文入选三大国际顶会2025-05-29 1151

-

后摩智能5篇论文入选国际顶会2025-02-19 1270

-

MLSys 2021论文分析32022-01-25 379

-

STM32相关的知识点2021-08-20 1211

-

ICLR 2021杰出论文奖出炉 让我们看看前八位优秀论文有哪些2021-04-13 4308

-

自监督学习与Transformer相关论文2020-11-02 3168

-

ICLR 2019在官网公布了最佳论文奖!2019-05-07 4947

-

STM32相关资料免费分享2016-11-17 6203

-

eZ430相关资料2016-08-18 721

-

OP37相关资料2016-08-09 1007

-

TCL767相关资料2016-02-19 479

-

labvIEW 8.2相关程序2012-12-19 2369

全部0条评论

快来发表一下你的评论吧 !