tensorflow的构建流程

电子说

描述

tensorflow的构建流程

tf.Graph() 表示实例化了一个类,一个用于 tensorflow 计算和表示用的数据流图,通俗来讲就是:在代码中添加的操作(画中的结点)和数据(画中的线条)都是画在纸上的“画”,而图就是呈现这些画的纸,你可以利用很多线程生成很多张图,但是默认图就只有一张。

例如有如下代码:

import tensorflow as tf

g = tf.Graph()

## add nodes to the graph

with g.as_default():

a = tf.constant(1, name=‘a’)

b = tf.constant(2, name=‘b’)

c = tf.constant(3, name=‘c’)

z = 2 * (a - b) + c

## launch the graph

with tf.Session(graph=g) as sess:

writer = tf.summary.FileWriter(“E://PycharmProjects//Graph”, g)

print(‘2*(a-b)+c =》 ’, sess.run(z))

打开cmd命令行,输入tensorboard --logdir=E:\PycharmProjects\Graph

回车后,打开google浏览器,输入得的的网址即可看到 我们生成的流程图了:

TensorFlow执行流程

TensorFlow的基础运算

在搞神经网络之前,先让我们把TensorFlow的基本运算,也就是加减乘除搞清楚。

首先,TensorFlow有几个概念需要进行明确:

1 图(Graph):用来表示计算任务,也就我们要做的一些操作。

2 会话(Session):建立会话,此时会生成一张空图;在会话中添加节点和边,形成一张图,一个会话可以有多个图,通过执行这些图得到结果。如果把每个图看做一个车床,那会话就是一个车间,里面有若干个车床,用来把数据生产成结果。

3 Tensor:用来表示数据,是我们的原料。

4 变量(Variable):用来记录一些数据和状态,是我们的容器。

5 feed和fetch:可以为任意的操作(arbitrary operation) 赋值或者从其中获取数据。相当于一些铲子,可以操作数据。

形象的比喻是:把会话看做车间,图看做车床,里面用Tensor做原料,变量做容器,feed和fetch做铲子,把数据加工成我们的结果。

2.1 创建图和运行图:

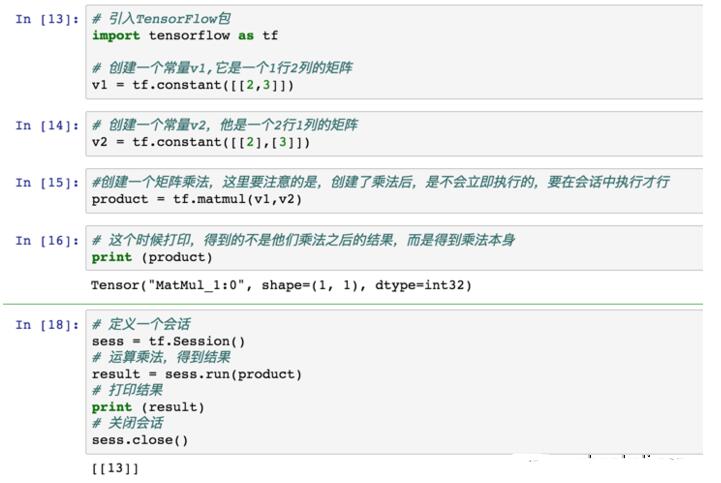

下面我们创建一个图,并在Session中执行它,不用担心看不懂,每句代码都会注释,只有有编程基础,都能OK:

上面就是用TensorFlow进行了一个最简单的矩阵乘法。

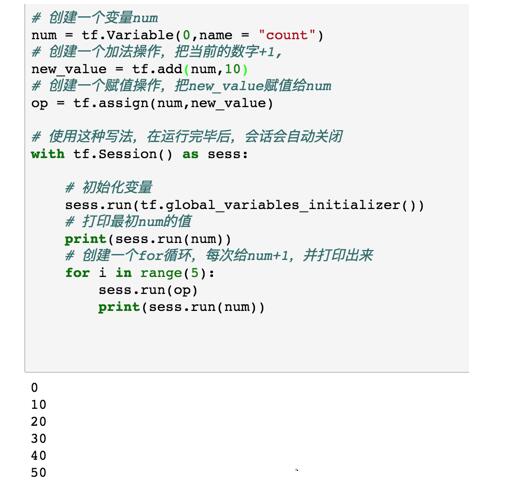

2.2 创建一个变量,并用for循环对变量进行赋值操作

可以看到,除了变量创建稍微麻烦一些和必须建立session来运行,其他的操作基本和普通Python一样。

2.3 通过feed设置placeholder的值

有的时候,我们会在声明变量的时候不赋值,计算的时候才进行赋值,这个时候feed就派上用场了。

责任编辑:YYX

- 相关推荐

- 热点推荐

- tensorflow

-

FlexBuild构建Debian 12,在“tflite_ethosu_delegate”上构建失败了怎么解决?2025-04-01 880

-

TensorFlow是什么?TensorFlow怎么用?2024-07-12 1996

-

keras模型转tensorflow session2024-07-05 1171

-

如何使用TensorFlow构建机器学习模型2024-01-08 1624

-

深度学习框架tensorflow介绍2023-08-17 3392

-

如何使用pycoral、tensorflow-lite和edgetpu构建核心最小图像?2023-06-05 740

-

使用TensorFlow和Artemis构建解决农村面临的问题设备2022-12-01 712

-

在Ubuntu 18.04 for Arm上运行的TensorFlow和PyTorch的Docker映像2022-10-14 3180

-

浅析为Windows on Arm设置Tensorflow的步骤2022-08-10 3566

-

TensorFlow Lite 构建的无人驾驶微型汽车2020-10-19 2902

-

TensorFlow XLA加速线性代数编译器2020-07-28 1975

-

TF之CNN:Tensorflow构建卷积神经网络CNN的嘻嘻哈哈事之详细攻略2018-12-19 3016

-

关于 TensorFlow2018-03-30 2528

全部0条评论

快来发表一下你的评论吧 !