无监督的多跳问答的可能性研究

描述

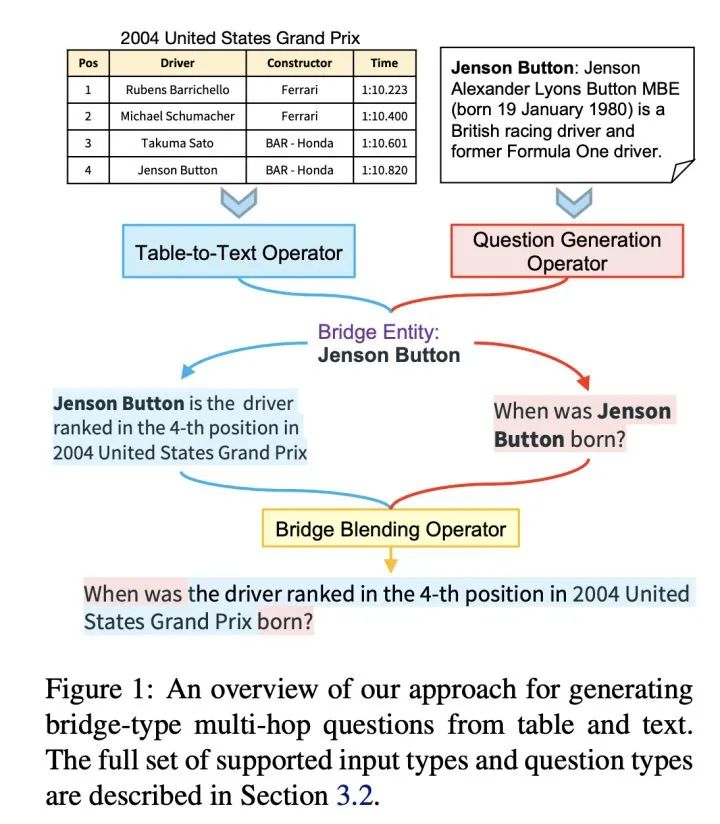

标注多跳问答(Multi-hop QA)数据集费时费力!本文首次研究了无监督的多跳问答的可能性,提出了MQG-QA,一种无监督的框架,从同构和异构数据源中自动生成多跳问答对。使用生成的数据预先训练QA系统将大大减少对人工标注训练数据的需求。

多跳问答(QA)训练数据的获取是非常耗时费力的。为了解决这个问题,我们探索了无监督的多跳QA问答对生成的问题,可以在没有标注的QA对场景下使用,非常的适合真实场景。

我们模型首先通过首先从每个数据源中选择或生成相关信息,然后将多个信息整合起来,形成一个多跳问题。我们发现,用我们模型产生的训练数据训练出来的模型,性能和完全监督模型之间的F1差距较小。这个现象是非常激动人心的,表明我们可以通过无监督预的构造数据来大大减少对人工标注的训练的需求。

下图是该方法的简易用法演示:

原文标题:【NAACL2021】初探无监督的多跳问答对

文章出处:【微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

责任编辑:haq

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

- 相关推荐

- 热点推荐

- 人工智能

-

如何用matlab进行gamma可能性分析?2019-02-23 2623

-

PSOC5LP与低通滤波器进行硬件连接的可能性有多大?2019-08-13 1559

-

存储级内存取代NAND闪存的可能性分析2021-01-05 2173

-

物联网的诸多工业可能性2022-11-14 603

-

基于多信道跳频的Ad Hoc网络MAC层协议研究2009-02-09 556

-

基于开源代码的多跳Mesh网络性能研究与优化2011-04-04 720

-

无线多跳网络中基于博弈论的协作激励机制研究_谢鲲2017-03-15 953

-

基于概率的无监督缺陷预测方法2017-11-21 937

-

金融机构正在研究数字加密货币交易行业的可能性2018-12-28 3478

-

机器学习算法中有监督和无监督学习的区别2020-07-07 6399

-

多跳问答任务:面向多跳问答的分层图网络2021-02-15 4611

-

广义可能性模糊时态计算树逻辑的模型检测2021-05-12 1102

-

创新充电桩设计:无线充电技术的可能性?2023-08-25 1183

-

AI如何对产品设计带来更多的可能性?2024-10-15 1261

全部0条评论

快来发表一下你的评论吧 !