如何透彻理解卷积的数据原理与机制

描述

作者以抛球实验为例讲解了许多卷积的数学原理和机制,并通过卷积来表述卷积神经网络。文章附有大量图片解释,帮助大家更容易理解。

抛球实验 -- Ball drop experiment

想象一下,我们把一个球从某个高度落到地面上,它只有一个运动维度。如果你把球落下,然后再从它的落点上方把它落下,球会走一段距离 的可能性有多大?

我们来分析一下: 第一次下落后,它将以概率 落在离起点一个单位的地方,其中是概率分布。现在,在第一次落下之后,我们把球捡起来,从它第一次落地点以上的另一个高度落下。球从新的起点滚动 个单位的概率是 ,如果它是从不同的高度落下的,那么 可能是不同的概率分布。

如果我们把第一次下落的结果固定下来,使我们知道球走了距离 ,对于球走的总距离 ,第二次下落时走的距离也固定为 ,即 。所以这种情况发生的概率简单来说就是 。。

我们用一个具体的离散例子来思考这个问题。我们希望总距离 为 3。如果它第一次滚动,,那么第二次必须滚动 ,才能达到我们的总距离 。这个概率是 。

然而,这并不是我们可以达到总距离3的唯一方法。球可以第一次滚1个单位,第二次滚2个单位。或者第一次滚0个单位,第二次滚3个单位。它可以是任何 和 ,只要他们加起来是 3。

为了求出小球到达总 的总概率,我们不能只考虑到达 的一种可能方式,而是考虑将 分成 和 的所有可能方式,并将每种方式的概率相加。

我们已经知道, 的每一种情况的概率简单来说就是 。所以,将 的每一个解求和,我们可以将总似然表示为。

和 的卷积,在 处被定义为。

如果我们把代入,我们得到。

为了使这一点更加具体,我们可以从球可能落地的位置来考虑。在第一次落地后,它将以概率 落在中间位置 。如果它落在 处,它落在 处的概率为 。

为了得到卷积,我们需要考虑所有的中间位置。

可视化卷积 -- Visualizing Convolutions

假设一个球落在离原点一定距离 的概率是。那么,它 从 处返回原点的的概率是。

如果我们知道球在第二次落地后落在 处,那么第一次的位置是 的概率是多少?

所以,前一个位置是 的概率是 。

每个中间位置球最终落在 处的概率。我们知道第一个落点把球放到中间位置 的概率是 。我们还知道,如果它落在 处,它在 处的概率是 。

将 的所有可能值相加,我们得到卷积结果。

通过移动下半部分,当分布对齐时,卷积达到峰值。

并且随着分布之间的交点越来越小而缩小。

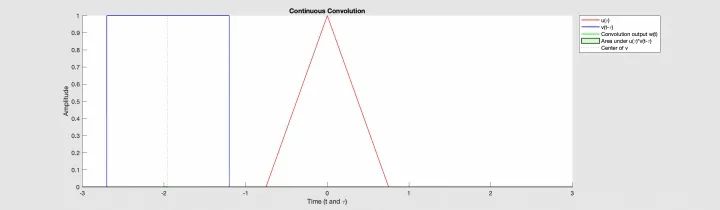

下图,我们能够直观地看到三角波与方波函数的卷积。

掌握了这个要点,很多概念变得更加直观。

在音频处理中有时会用到卷积。例如,人们可能会使用一个有两个尖峰,但其他地方都是零的函数来创建一个回声。当我们的双尖峰函数滑动时,一个尖峰首先击中一个时间点,将该信号添加到输出声音中,之后,另一个尖峰跟随,添加第二个延迟的副本。

高维卷积--Higher Dimensional Convolutions

卷积不仅仅适用于1维看空间,也适用于高维空间。

回顾开头的例子,落下的球。现在,当它落下时,它的位置不仅在一维中移动,而且在二维中移动。

和前面的卷积一样。

只是,现在 , , 和 都是向量。更明确地说,

标准定义:

就像一维卷积一样,我们可以把二维卷积看成是把一个函数滑动到另一个函数之上,进行乘法和加法。

卷积神经网络--Convolutional Neural Networks

那么,卷积与卷积神经网络的关系如何呢?

在一个1维卷积层中,输入 ,输出 。

从信号与系统的角度来描述,

是输入信号,是输出信号, 是系统,这个系统由 个神经元组成,可以用输入来描述输出。

也可以用神经网络的方式来描述

其中 是输入, 是权重。权重描述了神经元与输入的连接方式。

负的权重意味着输入会抑制神经元发射,而正的权重则鼓励它发射。

权重是神经元的心脏,控制着它的行为。如果说2个神经元是相同的,即它们的权重是相同的。

其中一个常见的应用是图像处理。我们可以把图像看作是二维函数。许多重要的图像变换都是卷积,你用一个非常小的局部函数(称为 “内核”)对图像函数进行卷积。

在上面的演示中,绿色部分类似于我们的 5x5x1 输入图像 。在卷积层的第一部分进行卷积操作的元素被称为Kernel/Filter, 用黄色表示。我们选择一个3x3x1矩阵作为Kernel。

Kernel 以一定的步伐向右移动,直到它解析出整行的宽度。接着,它以相同的步伐值跳到图像的开头(左边),并重复这个过程,直到遍历整个图像。

在多通道图像的情况下( 如RGB ),Kernel 的深度与输入图像的深度相同。Kernel 与图片 进行矩阵乘法,然后将所有结果与偏置相加,得到一个单通道卷积特征输出。

卷积操作的目的是从输入图像中提取高级特征,如边缘。传统上,卷积层可以捕捉低级特征,如边缘、颜色、梯度方向等。随着层数的增加,架构也可以捕捉高阶特征,让我们的神经网络对图像有更深刻的理解。

该卷积有两种结果--一种是卷积特征与输入相比维度减少,有效填充(Valide Padding)。另一种是维度增加或保持不变,相同填充(Same Padding)。

当我们将5x5x1的图像填充为6x6x1的图像,然后在其上应用3x3x1的核,我们发现卷积矩阵变成了5x5x1的尺寸。因此,我们将其命名为--相同填充(Same Padding)。

另一方面,如果我们在没有填充的情况下执行同样的操作,我们将得到一个具有内核(3x3x1)本身尺寸的矩阵--有效填充(Valide Padding)。

池化层 -- Pooling Layer

与卷积层类似,Pooling层负责减少卷积特征的空间大小。这是为了通过降低维度来降低处理数据所需的计算能力。此外,它还有助于提取旋转和位置不变的主导特征,从而保持模型的有效训练过程。下图表示在5x5卷积特征上的3x3池化。

有两种类型的池化。最大池化和平均池化。最大池化(Max Pooling)返回的是Kernel覆盖的图像部分的最大值。另一方面,平均池化(Average Pooling)返回Kernel覆盖的图像部分的所有值的平均值。

Max Pooling也是一种噪声抑制器。它完全丢弃了嘈杂的激活,并在降低维度的同时进行去噪。另一方面,Average Pooling只是作为噪声抑制机制进行维度降低。因此,我们可以说Max Pooling的性能比Average Pooling好很多。

卷积层和池化层,共同构成了卷积神经网络的第层。根据图像的复杂程度,可以增加这些层的数量,以便进一步捕捉低层次的细节,但代价是增加计算能力。

在经历了上述过程后,我们已经成功地使模型理解了特征。接下来,我们要将最终的输出结果进行扁平化处理,并将其馈送到普通的神经网络中,以达到分类的目的。

全连接层(FC层) —- Fully Connected Layer (FC Layer)

全连接层正在学习该空间中可能的非线性函数。

现在,我们已经将输入图像转换为适合多级感知器 (Multi-Level Perceptron) 的形式,我们将把图像扁平化(Flatten layer)为列向量。扁平化的输出被送入前馈神经网络,并在每次训练迭代中应用反向传播。在一系列的纪元中,该模型能够区分图像中的主导特征和某些低级特征,并使用Softmax分类方法对其进行分类。

总结 -- Conclusion

我们在这篇博文中介绍了很多数学机制,但我们获得的东西可能并不明显。卷积显然是概率论和计算机图形学中的一个有用工具,但是用卷积来表述卷积神经网络,我们获得了什么?

第一个好处是,我们有了一些非常强大的语言来描述神经网络的层。卷积大大简化了繁琐的计算工作。

其次,卷积非常容易实现。现存的许多库都提供了高效的卷积方法。

此外,卷积看起来是一个 操作,但使用一些相当深刻的数学见解,可以创建一个 的实现。

Tips:

我们想知道球第一次滚动 单位,第二次滚动 单位的概率。所以 。

卷积满足交换律,即 。

卷积满足结合律的,即,

编辑:jq

-

卷积神经网络通俗理解2023-08-17 3277

-

深度学习中的各种卷积原理解析2023-07-01 1139

-

简谈卷积—幽默笑话谈卷积2023-05-25 870

-

深入理解深度学习中的反(转置)卷积2022-02-07 636

-

理解中断机制2021-11-22 1012

-

对单片机透彻地理解2021-08-23 934

-

卷积神经网络数学的原理解析2021-02-17 2606

-

卷积神经网络中全连接层作用理解总结2020-01-30 21127

-

卷积神经网络的权值反向传播机制和MATLAB的实现方法2018-12-06 1662

-

如何使用numpy搭建一个卷积神经网络详细方法和程序概述2018-10-20 6571

-

CNN之卷积层2018-10-17 4316

-

对图像处理和卷积神经网络架构的案例分析和概念理解2017-11-15 11155

-

电容去耦原理(解释超透彻)!2012-08-02 69903

-

FFT与DFT计算时间的比较及圆周卷积代替线性卷积的有效性实2011-12-29 5185

全部0条评论

快来发表一下你的评论吧 !