超分辨率技术大热,能不能解决物联网刚需?

超分辨率技术大热,能不能解决物联网刚需?

描述

随着图形渲染技术和传感器的发展,我们在日常生活中接触到的分辨率已经从过去的720p、1080p提升至了4K、8K。然而这之前的图像、视频依然停留在原有的分辨率上,且对于图形性能不够的硬件来说,要渲染出4K以上的分辨率依然吃力,于是超分辨率技术就此应运而生。

超分辨率技术的不同技术路线

现有的超分辨率技术分为几种,比如基于插值的超分辨率技术、基于重构的超分辨率技术和基于深度学习的超分辨率技术等等。插值的方法主要基于图像插值技术,也就是图像缩放技术,利用已知的像素来插值计算出未知像素的值,最后利用常规的图像技术进行一定修复等等。这是最快捷的一种方法,但质量上就不好说了,锯齿和边缘处理不到位,可以说与理想的超分辨率相差甚远。

而深度学习的方法已经在机器视觉领域获得了良好的应用,所以基于该方法的超分辨率技术可谓成果颇丰,且重构效果远优于传统的方法。通过卷积神经网络获得的高分辨率图像,不仅纹理细节更加清晰,也在信噪比上达到了优秀的表现。

GPU厂商主推的超分辨率技术

由于超分辨率技术可以显著减少游戏场景中的图形压力,显著提高游戏帧率,目前应用最广的仍是GPU厂商。最先推出类似技术的是英伟达,其DLSS技术于2019年推出,只不过当时的1.0版本可谓一塌糊涂,甚至不如简单的图像插值技术。

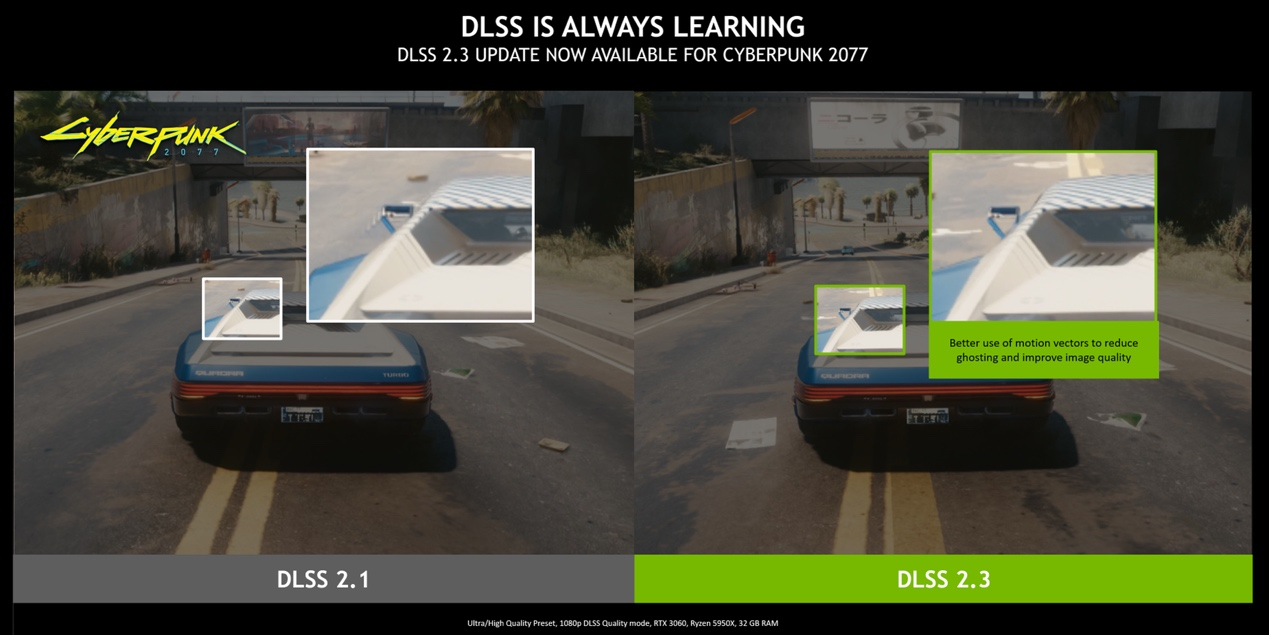

DLSS 2.1与2.3版本的对比 / 英伟达

2020年推出的2.0版本中,英伟达用上了自家GPU中的专用AI处理单元Tensor Core,并用到了时间抗锯齿升采样技术,而且新的AI不需要针对每个游戏进行训练也能集成这一技术。而且作为一项基于深度学习的技术,DLSS一直在不断完善,目前处于2.3版本的DLSS对运动拖影和粒子效果的渲染又有了极大的改善。正是在庞大的运算和训练下,DLSS无可厚非地成了当前效果最好的游戏超分辨率技术,但也将这一技术限制在了英伟达自家的GPU平台上。

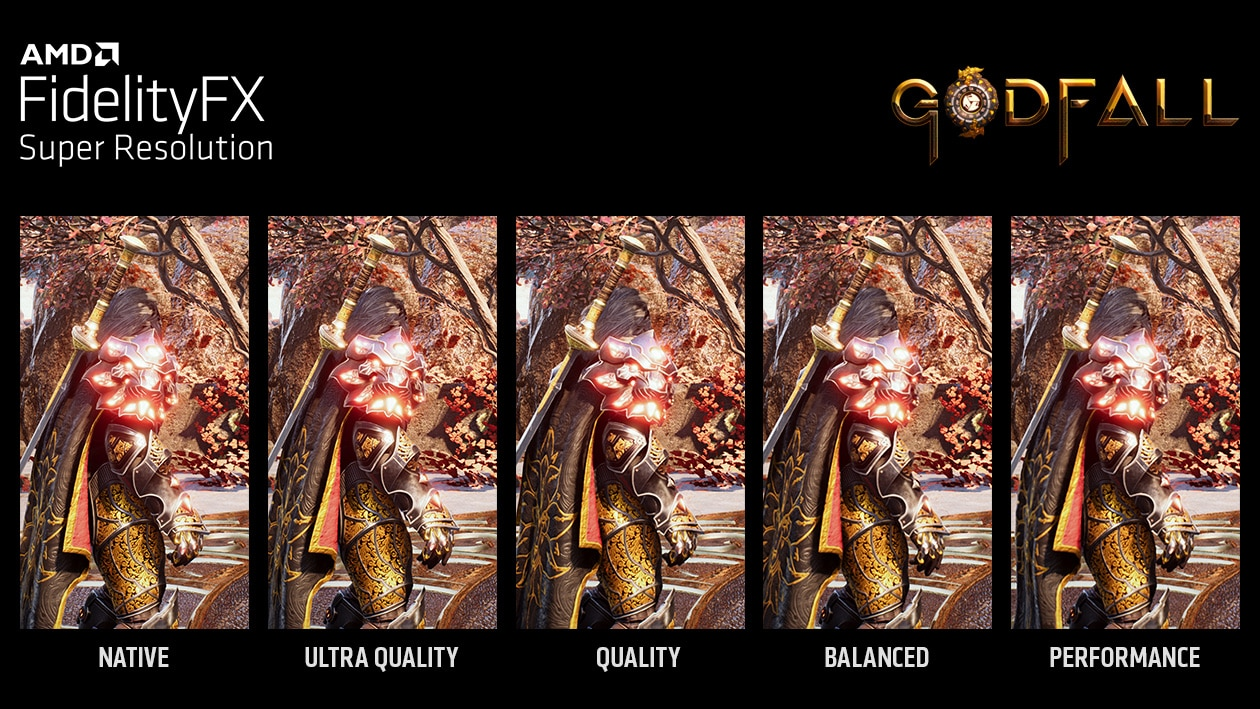

FSR在四种模式下的表现 / AMD

AMD为了与老黄相抗衡,也推出了对应的超分辨率技术FSR,与DLSS技术相比,FSR涉及到的计算工作就要少一大截了,毕竟不需要额外的计算单元。FSR作为一种后处理算法,主要还是利用空间算法对当前画面帧进行升级和增强,而无需任何的深度学习。虽然如此一来游戏的帧数有了显著提高,但在图形质量上仍然会看见不少模糊之处,尤其是在动态场景中,运动伪影的现象比较严重。但好在FSR技术无需特定的硬件,所以即便是竞争对手的GPU,也能充分利用这一技术。

据传,AMD即将在不久后的GDC上发布全新的FSR 2.0技术,这次AMD也效仿了英伟达,用上时间数据来进行升采样,更让人惊喜的是,即便如此,该技术依然无需任何独立机器学习硬件,这意味着FSR 2.0有很大几率成为DLSS的合格竞争对手。

物联网能不能搭上超分辨率技术这班车?

其实这两家即便在技术路线上有所差异,但标榜的都是提高游戏的帧数和图形质量,然而目前如此高效的超分辨率技术只能用于游戏上吗?反观一些物联网,尤其是工业物联网的应用,同样需要对较低分辨率的图片视频进行处理。低分辨率在一定程度上限制了信息传输的准确性,从而降低了传输效率。比如医学影像中,高分辨率的图像可以更准确地对疾病进行判断。但是以上三家所用到的超分辨率技术出于各种原因,目前还是只能用作游戏优化技术。

首先是因为实现方式的不同,在游戏里支持这样的超分辨率技术,其实是靠和图形渲染引擎的集成来实现的,而不是简单地对图像或视频进行处理。所以除非是用到了Unity或Unreal之类的图形引擎,比如工业场景中兴起的数字孪生系统等,是无法充分利用到这些技术的。

其次,这些技术对于硬件的算力同样存在一定的要求,这里提到的算力不只是图形算力,还有AI算力,如果是英伟达的DLSS技术的话,还需要特定的硬件才能实现。而目前物联网场景中的边缘设备往往没有很高的算力。即便在开始推行边缘AI的情况下,最多也只是对图像和视频做一些简单的处理,比如准确识别智能水表上的刻度等等。

这也不是说目前物联网没办法享受这样的超分辨率技术,但稍微可行的方案可能还是需要在云端实现。比如智能监控摄像头拍摄的视频,在存储至云端的同时,也可以同时进行AI超分辨率重建。

不过这种方案目前应该很难普及,一是考虑到这类云服务器的部署成本偏高,如果只是单通道传输还算好,而工业物联网场景中往往是数十条1080p视频流同时传输。二是到不少物联网应用讲究的依然是实时数据传输。就拿将智能监控摄像头作为宠物摄像头来说,这其中的需求就是实时观察宠物动向,而不是等待AI重构完后回传的视频。

好在边缘AI、深度学习模型已经在物联网领域唤起了关注,专注于传感器、MCU等硬件的厂商,都开始或多或少加入一定的AI/ML计算性能。未来边缘AI算力提升,超分辨率深度学习模型开销变小的前提下,物联网可以真正享受到超分辨率技术带来的好处。

-

物联网流量卡到底能不能用?2023-08-28 7913

-

单张图像超分辨率和立体图像超分辨率的相关工作2023-06-27 1884

-

指针能不能作为循环变量?2023-02-16 1595

-

什么是基于深度学习的超分辨率2022-05-24 3752

-

数据外补偿的深度网络超分辨率重建2017-12-15 1054

-

单幅模糊图像超分辨率盲重建2017-11-29 1037

-

基于稀疏编码和随机森林的超分辨率算法2017-11-01 1444

-

一种基于参考高分辨率图像的视频序列超分辨率复原算法2017-10-26 1256

-

使用改进的POCS算法的超分辨率图像复原2016-01-04 727

-

新手关于图像超分辨率的问题~2013-05-19 3346

-

序列图像超分辨率重建算法研究2012-03-08 1053

-

基于POCS算法的图像超分辨率重建2010-11-08 886

-

电池能不能修复?2009-11-23 1377

-

超分辨率图像重建方法研究2009-03-14 666

全部0条评论

快来发表一下你的评论吧 !