使用Neurorack音乐音频合成器创作智能音乐

描述

你喜欢合成器驱动的乐队,比如 Depche Mode 、 Erasure 或 Kraftwerk 吗?你想过在家里用合成器创作自己的音乐有多酷吗?如果在NVIDIA 的帮助下,这一过程能得到加强呢 Jetson 纳米 ?

最新的 Jetson 本月最佳项目 已经找到了一种方法来实现这一点,将 Eurorack synthesizer 与 Jetson 纳米结合起来,创造了 Neurorack 。这款音乐音频合成器是第一款将深度生成模型的强大功能与 Eurorack 机器的紧凑性相结合的产品。

“这个项目的目标是设计下一代乐器,为音乐家提供一种新的工具,同时增强音乐家的创造力。它提出了一种新的思考和创作音乐的方法,”这些应用程序开发人员指出,他们是人工创造智能和数据科学([about] and compose music ,” noted the app developers , who are members of Artificial Creative Intelligence and Data Science ( ACIDS )小组的成员,总部设在法国巴黎的 IRCAM 实验室。“我们深信人工智能可以用来实现这一目标。”

Neurorack 的实时功能依赖于 Jetson Nano 的处理能力和 尼农·戴夫的研究 制作训练模型,这些模型在计算和内存占用方面都很轻。

“我们最初的梦想是找到一种方法,将深度模型小型化,并允许它们嵌入嵌入式音频硬件和合成器中。由于我们对各种形式的合成器都充满热情,尤其是Eurorack,我们认为直接使用这种格式是有意义的,因为它更有趣Nano从一开始就是我们的首选…它让我们能够在不损失音质的情况下依赖深度模型,同时保持实时性限制,”Devis说。

开发商在接近该项目时有几个关键的设计考虑,包括:

音乐性:选择的生成模型可以产生不使用样本就无法合成的声音。

可控性:他们选择的界面方便且易于操作。

实时性:硬件的行为就像传统的合成器,并且同样具有反应性。

独立功能:无需电脑即可播放。

正如开发人员在他们的 NVIDIA 开发者论坛帖子 中提到的这个项目:“该模型基于一种改进的神经源滤波器架构,它允许基于描述符的打击声音实时合成。”

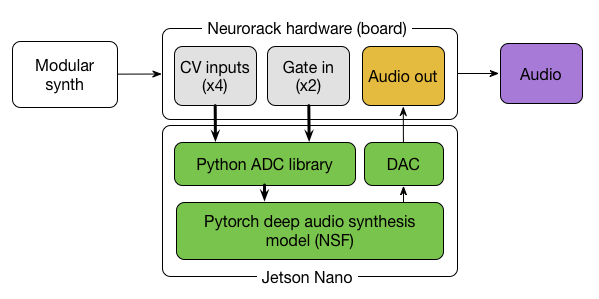

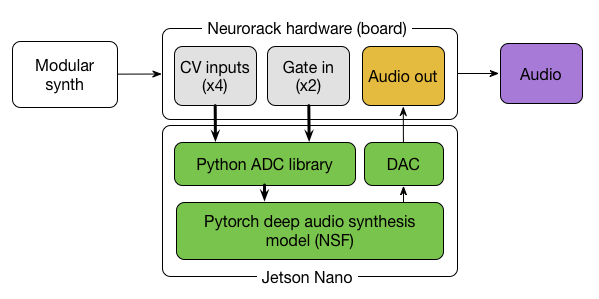

Neurorack 使用 PyTorch 深度音频合成模型(见图 1 )生成通常需要样本的声音,易于操作,不需要单独的计算机。

图 1 : diagram 显示模块的总体结构以及硬件和软件(绿色)组件之间的关系。

硬件具有四个控制电压( CV )输入和两个门(以及用于处理菜单的屏幕、旋转和按钮),它们都与特定的 Python 库通信。这些控件(以及模块本身)的行为高度依赖于嵌入的深层模型的类型。对于 Neurorack 的第一个版本,开发人员实现了一个基于描述符的冲击声音生成器,如他们的 GitHub 文档 中所述。

Eurorack 的硬件和软件是由 ACIS 团队的 Ninon Devis 、 Philippe Esling 和 Martin Vert 共同开发的。根据他们 网站 的说法, ACIDS “一心想通过开发创新的人工智能模型来模拟音乐创造力。”

项目代码和硬件设计是免费的、开源的,可在 GitHub repository 中获得。

该团队希望让音乐家和对人工智能/嵌入式计算感兴趣的人也能访问该项目。

“我们希望这个项目能引起两个社区的兴趣!现在复制这个项目有点技术性,但我们将致力于简化部署,希望能找到其他像我们这样奇怪的人,” Devis 说。“我们坚信,为音乐开发机器学习模型的一个关键方面将导致赋予创造性表达能力,即使对非专家也是如此。”

两名团队成员 Devis 和 Esling 使用他们开发的乐器组建了一支乐队。他们目前正在制作一部全长的真人秀,将以 Neurorack 为特色,并计划在今年 4 月的下一场 法国综合艺术节 中表演。

关于作者

Jason Black是 NVIDIA 的自主机器营销和通信高级经理。作为过去 25 年的作家和编辑,他喜欢在流行语背后寻找故事的核心。看到机器人 MIG 把他带到哪里,他很兴奋。

审核编辑:郭婷

-

敏捷合成器的技术原理和应用场景2025-02-20 671

-

如何制作一个音频合成器?2023-05-13 3404

-

使用 Arduino Nano 创建基于 DCO 的音频合成器2023-05-03 2859

-

如何创建基于DCO的音频合成器2023-04-13 1843

-

锁相环频率合成器是什么原理?2021-04-22 2572

-

人工智能和音乐的融合 是AI技术在音乐创作领域的新突破2019-12-16 6109

-

什么是频率合成器2019-08-19 5672

-

Mitch Altman是如何创建ArduTouch音乐合成器的?2018-11-29 4359

-

合成器2017-12-06 3522

-

苹果对其音乐创作app推送更新为iPhone、iPad和Mac设备提供新功能2017-01-19 934

-

Matlab的音乐合成器应用2012-04-16 1013

-

频率合成器,频率合成器原理及作用是什么?2010-03-23 15270

-

音乐合成器电路图2009-04-09 2003

全部0条评论

快来发表一下你的评论吧 !