EditGAN图像编辑框架将影响未来几代GAN的发展

描述

编辑猫、汽车甚至古董画照片的愿望,由于一种称为EditGAN的生成性对抗网络(GAN)模型,从未像现在这样容易实现。来自 NVIDIA,多伦多大学和 MIT 研究人员的工作建立了 DatasetGAN ,这是一种人工智能视觉模型,可以用最少16个人类注释的图像来训练,并像其他需要100X更多图像的方法一样有效地执行。EditGAN 利用了前一个模型的功能,允许用户使用简单的命令(如绘图)编辑或操作所需的图像,而不会影响原始图像质量。

什么是 EditGAN ?

根据 paper :“ EditGAN 是第一个 GAN 驱动的图像编辑框架,它同时提供非常高精度的编辑,只需要很少的带注释的训练数据(并且不依赖外部分类器),可以实时交互运行,允许对多个编辑进行简单的合成,并可处理真正的嵌入式、生成的图像,甚至是域外图像。”

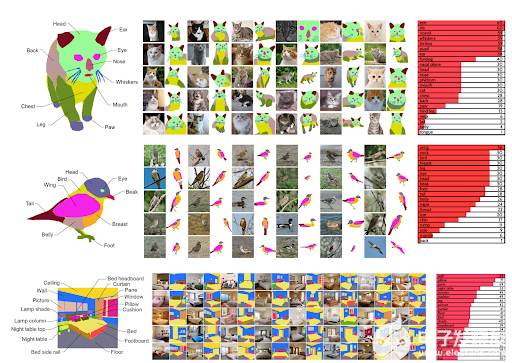

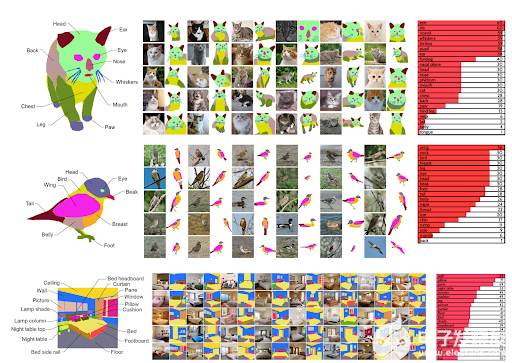

该模型学习特定数量的编辑向量,这些编辑向量可以交互地应用于图像。本质上,它形成了对图像及其内容的直观理解,用户可以利用这些信息进行特定的修改和编辑。该模型从相似的图像中学习,并识别图像中对象的不同组件和特定部分。用户可以利用它对不同子部分进行有针对性的修改,或在特定区域内进行编辑。由于模型的精确性,图像在用户设置的参数之外不会失真。

“该框架允许我们学习任意数量的编辑向量,然后可以以交互速率直接应用于其他图像。”研究人员在他们的研究中解释道。“我们的实验表明, EditGAN 可以以前所未有的细节和自由度处理图像,同时保持完整的图像质量。我们还可以轻松地组合多种编辑,并在 EditGAN 的训练数据之外执行合理的编辑。我们在各种图像类型上演示了 EditGAN ,并在数量上优于几种预处理的图像标准编辑基准任务的编辑方法。”

从增加微笑、改变别人看的方向、创造新的发型,或者给汽车一套更好的轮子,研究人员展示了模型的内在性,只需要很少的数据注释。用户可以根据所需的编辑绘制简单的草图或遮罩,并引导 AI 模型实现修改,例如更大的猫耳或更酷的汽车前灯。人工智能然后渲染图像,同时保持非常高的精度和原始图像的质量。之后,同样的编辑可以实时应用于其他图像。

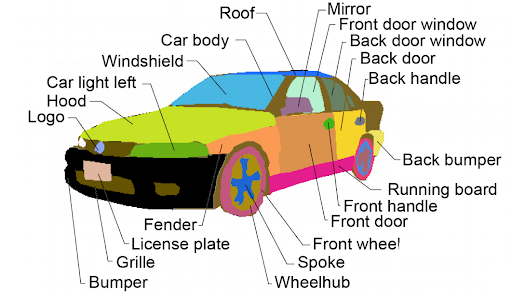

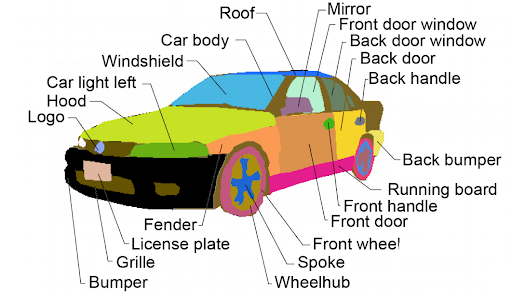

图 2 分配给图像不同部分的像素示例。人工智能可以识别不同的区域,并可以根据人工输入进行编辑。

这是怎么工作的?

Edigan 将图像的每个像素指定给一个类别,例如轮胎、挡风玻璃或车架。这些像素在人工智能潜在空间内控制,并基于用户的输入,用户可以轻松灵活地编辑这些类别。 Edigan 操纵 only 与所需更改相关的像素。人工智能根据训练模型时使用的其他图像知道每个像素代表什么,因此你无法尝试将猫耳朵添加到汽车中以获得准确的结果。但是,当在正确的模型中使用时, EditGAN 是一个非凡的工具,可以提供出色的图像编辑效果。

图 3 Edigan 可以训练各种各样的图像,从动物到环境,形成对其内容的详细理解。

EditGAN 的潜能

人工智能驱动的照片和图像编辑有可能简化摄影师和内容创作者的工作流程,并实现创新和数字艺术的新水平。 EditGAN 还使新手摄影师和编辑能够制作高质量的内容,以及偶尔的病毒性模因。

“这个人工智能可能会改变我们编辑照片的方式,也许最终会改变视频。它允许人们通过简单的文本命令拍摄图像并对其进行修改。如果你有一张汽车照片,你想让车轮更大,只需键入“ make wheels bigger ”,然后噗 – 这是一张完全真实的照片,上面是同一辆车轮更大的汽车。”—— Fortune magazine

EditGAN 将来也可能用于其他重要应用。例如, EditGAN 的编辑功能可用于创建具有特定特征的大型图像数据集。当针对不同的计算机视觉任务训练下游机器学习模型时,这种特定的数据集可能很有用。

此外, EditGAN 框架可能会影响未来几代 GAN 的发展。虽然当前版本的 EditGAN 侧重于图像编辑,但类似的方法也可能用于编辑 3D 形状和对象,这在为游戏、电影或 metaverse 创建虚拟 3D 内容时非常有用。

关于作者

Nathan Horrocks 是 NVIDIA Research 的内容营销经理。他重点强调了 NVIDIA 实验室在世界各地进行的惊人研究。

审核编辑:郭婷

-

第三代半导体材料氮化镓/GaN 未来发展及技术应用2019-04-13 5808

-

请问怎么取消文本编辑框中的显示内容?2019-05-27 1709

-

请问怎么清除编辑框内的内容2019-05-28 1237

-

如何实现在ucgui中点击edit编辑框将光标定位在edit编辑框?2019-07-12 1889

-

GAN Paint Studio后期图像处理工具实现了什么?2019-09-11 3158

-

编辑框读取反馈不出2019-10-21 1856

-

如何获取编辑框中的数字3.5?2019-11-08 1304

-

请问如何清除编辑框?2020-05-01 1431

-

图像生成对抗生成网络gan_GAN生成汽车图像 精选资料推荐2021-08-31 1124

-

文本图片编辑新范式:单个模型实现多文本引导图像编辑2023-01-10 1378

-

谷歌新作Dreamix:视频扩散模型是通用视频编辑器,效果惊艳!2023-02-09 2162

-

AI图像编辑技术DragGAN开源,拖动鼠标即可改变人物笑容2023-06-29 1614

-

生成式 AI 研究通过引导式图像结构控制为创作者赋能2023-07-24 1062

-

伯克利AI实验室开源图像编辑模型InstructPix2Pix,简化生成图像编辑并提供一致结果2023-08-28 1455

-

字节发布SeedEdit图像编辑模型2024-11-12 1097

全部0条评论

快来发表一下你的评论吧 !