如何为深度学习模型设计审计方案

描述

当您购买最后一辆车时,您是否检查了制造商的安全等级或质量保证。也许,像大多数消费者一样,你只是去试驾看看这辆车是否提供了你想要的所有特性和功能,从舒适的座椅到电子控制。

审计和质量保证是许多行业的规范。考虑汽车制造业,在汽车生产之前,在安全性、舒适性、网络化等方面进行严格的测试,然后再将其部署到最终用户。基于此,我们提出了一个问题:“我们如何为深度学习模型设计一个类似动机的审计方案?”

人工智能在现实世界的应用中获得了广泛的成功。当前的人工智能模型尤其是深度神经网络,不需要对所需行为类型的精确说明。相反,它们需要大量的数据集用于培训,或者需要设计一个必须随时间优化的奖励函数。

虽然这种形式的隐式监督提供了灵活性,但它通常会导致算法针对人类设计者不希望的行为进行优化。在许多情况下,它还会导致灾难性后果和安全关键应用程序的故障,如自动驾驶和医疗保健。

由于这些模型很容易失败,特别是在域转移的情况下,因此在部署之前知道它们 MIG ht 失败的时间非常重要。随着深度学习研究越来越与现实世界的应用相结合,我们必须提出正式审核深度学习模型的方案。

语义一致的单元测试

审计中最大的挑战之一是理解如何获得对最终用户直接有用的人类可解释规范。我们通过一系列语义一致的单元测试解决了这个问题。每个单元测试验证输入空间中受控和语义对齐的变化(例如,在人脸识别中,相对于相机的角度)是否满足预定义规范(例如,精度超过 95% )。

我们通过直接验证生成模型的可解释潜在空间中的语义对齐变化来执行这些单元测试。我们的框架 AuditAI 弥补了软件系统可解释形式验证和深度神经网络可伸缩性之间的差距。

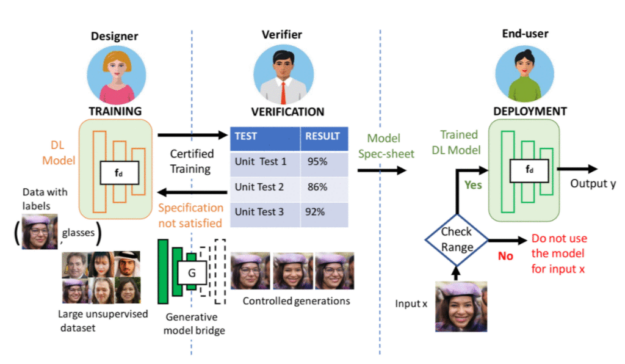

图 1 。 AI 从项目到部署的一般机器学习过程。

考虑一个典型的机器学习生产流水线三方:部署模型的最终用户、验证者和模型设计器。验证器在验证设计者的模型是否满足最终用户的需求方面起着关键作用。例如,单元测试 1 可以验证当人脸角度在d度范围内时,给定的人脸分类模型是否保持 95% 以上的准确性。单元测试 2 可以检查模型在何种照明条件下的准确度超过 86% 。验证之后,最终用户可以使用验证过的规范来确定在部署期间是否使用经过培训的 DL 模型。

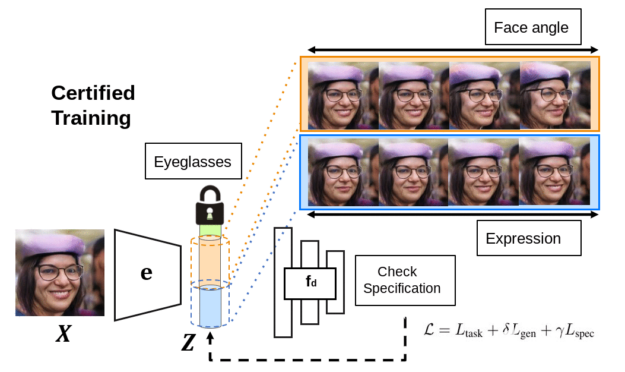

图 2 。 Deep networks 接受认证培训,以确保可能满足单元测试。

经验证的部署

为了验证深层网络的语义一致性,我们使用生成模型将其连接起来,这样它们共享相同的潜在空间和将输入投射到潜在代码的相同编码器。除了验证单元测试是否满足要求外,我们还可以执行认证培训,以确保单元测试可能首先满足要求。该框架具有吸引人的理论性质,我们在本文中展示了如何保证验证者能够生成验证是真是假的证明。有关更多信息,请参阅语义规范[LINK]下的审核 AI 模型以验证部署。

与 AuditAI 相比,基于像素的扰动的神经网络验证和认证训练涵盖的潜在空间语义变化范围要小得多。为了进行定量比较,对于相同的验证误差,我们将像素绑定到潜在空间,并将其与 AuditAI 的潜在空间绑定进行比较。我们表明,在相同的验证误差下, AuditAI 可以容忍比基于像素的对应项(通过 L2 范数测量)大 20% 左右的潜在变化。对于实现和实验,我们使用 NVIDIA V100 GPU s 和 Python 以及 PyTorch 库。

我们展示了与潜在空间中受控变化相对应的生成输出的定性结果。顶行显示 AuditAI 的可视化,底行显示 ImageNet 上 hen 类图像、肺炎胸部 X 射线图像和不同微笑程度的人脸的像素扰动可视化。从可视化中可以明显看出,更广泛的潜在变化对应于生成的输出中更广泛的语义变化。

今后的工作

在本文中,我们开发了一个深度学习( DL )模型审计框架。越来越多的人开始关注 DL 模型中的固有偏见,这些模型部署在广泛的环境中,并且有多篇关于部署前审核 DL 模型的必要性的新闻文章。我们的框架将这个审计问题形式化,我们认为这是在部署期间提高 DL 模型的安全性和道德使用的一个步骤。

AuditAI 的局限性之一是其可解释性受到内置生成模型的限制。虽然在生成模型方面已经取得了令人振奋的进展,但我们认为,在培训和部署过程中,整合领域专业知识以减少潜在的数据集偏差和人为错误非常重要。

目前, AuditAI 没有将人类领域专家直接集成到审计管道中。它间接地使用领域专业知识来管理用于创建生成模型的数据集。纳入前者将是今后工作的一个重要

关于作者

Homanga Bharadhwaj 是卡内基梅隆大学计算机科学学院机器人研究所的博士生。他以前是多伦多大学和向量研究所的 MSC 学生,也是 IIT 坎普尔的一名本科生。这篇文章所涉及的工作是在 Homanga 在 NVIDIA 实习研究期间完成的。

Animesh Garg 是多伦多大学计算机科学助理教授 CVK3 NVIDIA 的资深研究科学家,也是向量研究所的一名教员。他在加州大学伯克利分校获得博士学位,是斯坦福人工智能实验室的博士后。他致力于广义自治的算法基础,使基于人工智能的机器人能够与人类一起工作。他的工作在机器人学和机器学习领域获得了多项研究奖。

审核编辑:郭婷

-

中软国际审计大模型创新驱动智领未来2025-09-28 915

-

AI大模型与深度学习的关系2024-10-23 3716

-

深度学习中的模型权重2024-07-04 5480

-

深度学习的模型优化与调试方法2024-07-01 2499

-

一文读懂何为深度学习12023-02-22 862

-

什么是深度学习?使用FPGA进行深度学习的好处?2023-02-17 2028

-

大模型为什么是深度学习的未来?2023-02-16 2808

-

移植深度学习算法模型到海思AI芯片2022-01-26 1460

-

深度学习模型是如何创建的?2021-10-27 2290

-

labview调用深度学习tensorflow模型非常简单,附上源码和模型2021-06-03 39839

-

深度模型中的优化与学习课件下载2021-04-07 1172

-

labview测试tensorflow深度学习SSD模型识别物体2020-08-16 3401

全部0条评论

快来发表一下你的评论吧 !