一种革命性的新型模拟技术

描述

笔者最近从Mark Reiten(SST授权部门的副总裁)处了解到该公司的SuperFlash memBrain技术,这是一种革命性的新型模拟技术,用于执行当今人工智能(AL)、机器学习(ML)和深度学习(DL)算法中的矩阵运算。

SuperFlash memBrain是一种神经形态多层次非易失性内存(non-volatile memory,简称NVM)解决方案,使用SST的标准SuperFlash存储单元,为AI、ML和DL应用提供内存计算架构。SuperFlash存储单元已在多个半导体工厂投入生产。

据维基百科介绍,“神经工程,也被称为神经计算,是使用包含电子模拟电路的超大规模集成系统来模拟神经系统中存在的神经生物结构。神经计算机/芯片是使用物理人工神经元(由硅制成)进行计算的设备。”

众所周知,人类大脑是由神经元细胞形成的,神经元通过突触相互交流。一个典型的闪存单元基于一个浮动栅晶体管,可以用来表示数字0或1;相比之下,一个SuperFlash memBrain记忆体可以用来表示256个不同的值,用于代表人工神经网络(artificial neural network ,简称ANN)中与“突触”相关的“权重”。

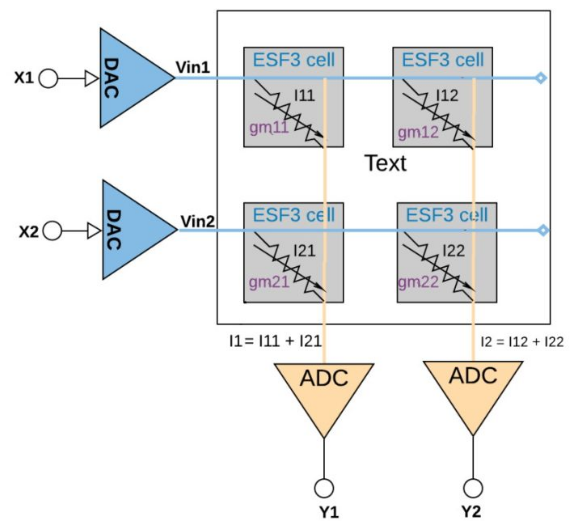

AI / ML / DL应用使用了大量的矩阵乘法运算,这些运算本身使用了乘积(MAC)运算。考虑一个2×2数组的简单例子,包含四个基本单元:

我们可以把SuperFlash memBrain记忆体想象成一个可编程的电阻。根据欧姆定律,V = IR,所以I(流过电池的电流)= V/R。电阻(R)的倒数是电导(G);即G = 1/R。这意味着I = V * G(乘法运算)。此外,同一列中每个单元的电流是累加的(加法运算)。因此,每个记忆体可以被认为是执行突触的功能,每一列可以被认为是执行神经元的功能。

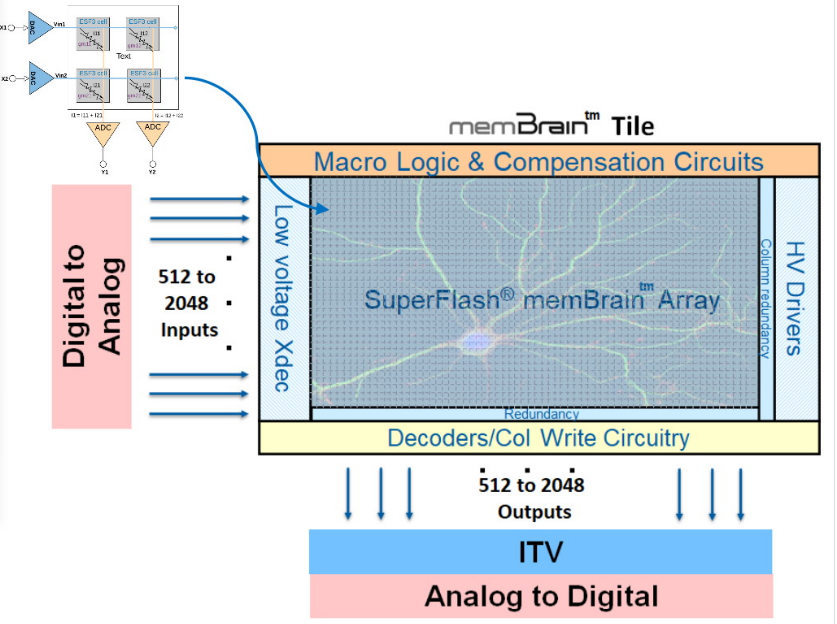

该层次结构再往上一层是memBrain块,它是包含上述记忆体的一大数组,并对输入和输出进行适当信号调节。

与标准的数字嵌入式Flash存储器相比,该阵列的输入和输出范围要宽得多。权重首先作为电导值存储在memBrain数组中,当被灌入输入电压时,SuperFlash memBrain单元既存储权重,同时执行乘法操作,产生的电流相累加,数百万个MAC操作可以同时执行。需要注意的关键点是,其性能和功耗比优化的数字解决方案要好几个数量级。

SST的这一技术令人振奋的原因在于,SoC设备可以在设计中以IP形式使用SuperFlash memBrain。根据Microchip今年早些时候发布的新闻稿,一家名为WITINMEM的公司已经将SuperFlash memBrain技术整合到超低功耗的SoC中,充分利用这种内存计算技术进行神经网络处理,包括语音识别、声纹识别、深度语音降噪、场景检测和健康状态监测等。

审核编辑 :李倩

-

长电科技推出了一项革命性的高精度热阻测试与仿真模拟验证技术2024-03-08 1499

-

分享一种CameraCube新型图像传感技术2021-06-08 2506

-

革命性的VR全景技术2020-03-15 2638

-

英特尔计划推出一款革命性的模拟芯片2019-11-06 845

-

什么是革命性MU-MIMO算法?2019-08-15 3028

-

MIT开发出一种为软体机器人设计的新型模拟器2019-07-10 1886

-

革命性的太赫兹单像素成像重建技术,填补太赫兹盲点2019-04-22 4752

-

革命性的笔HeatVanish,写出来的字加热就会消失2016-12-17 3050

-

恩智浦发布革命性简单易用的LPC800.pdf2016-09-19 1387

-

一种新型模糊PID控制器在伺服系统的应用2016-04-06 702

-

“革命性”电池技术:用声音给手机充电2014-08-25 1121

-

革命性LED驱动方案2013-07-19 3241

-

电路板设计的革命性技术:并行设计法2009-12-26 712

-

一种新型的基于LabView设计的脉压模拟器2009-12-01 1119

全部0条评论

快来发表一下你的评论吧 !