浅谈XR扩展现实的概念和定义

描述

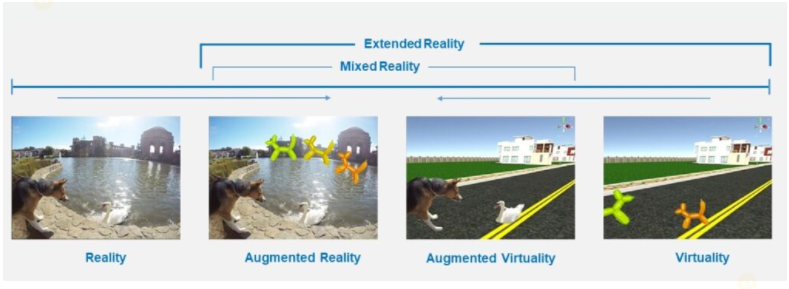

Paul Milgram 在 1994 年定义了著名的现实-虚拟连续体 [1]。它一方面解释了物理世界与另一方面完整的数字或计算机生成环境之间的过渡。但是,从技术的角度来看,引入了一个新的总称,称为扩展现实 (XR),通常称为 XR。它是用于虚拟现实 (VR)、增强现实 (AR) 和混合现实 (MR) 以及沉浸式技术可能创造的未来现实的总称。XR 涵盖了真实和虚拟环境的全部范围。在图 1 中,Reality-Virtual Continuum 被新的总括术语扩展。如图所示,出现了一个鲜为人知的术语,称为增强虚拟性。该术语涉及一种方法,其中现实(例如用户的手)出现在虚拟世界中。

图 1 – XR扩展现实方案

一、XR扩展现实的概念和定义:

按照最常见的术语,XR扩展现实的三个主要场景定义如下。

增强现实 (AR): 通过将虚拟空间的数字内容与现实世界混合,使用虚拟元素增强对真实环境的感知。Pokémon Go 和 Snapchat 过滤器是智能手机或平板电脑使用的此类技术的常见示例。AR 也广泛应用于工业领域,工人可以戴上 AR 眼镜在装配、维护或培训期间获得支持。

增强虚拟 (AV) 使用真实元素增强对虚拟环境的感知。现实世界的这些元素通常被实时捕获并注入到虚拟环境中。注入到虚拟环境中的用户身体的捕获是旨在提高体现感的 AV 的一个众所周知的示例。

虚拟现实 (VR) 应用程序使用耳机让用户完全沉浸在计算机模拟的现实中。这些耳机产生逼真的图像和声音,使用两种感官来创建交互式虚拟世界。

混合现实 (MR) 该定义包括 AR 和 AV。它融合了真实世界和虚拟世界以创建复杂的环境,物理和数字元素可以实时交互。它被定义为真实和虚拟环境之间的连续统一体,但不包括两者。

二、XR扩展现实系统

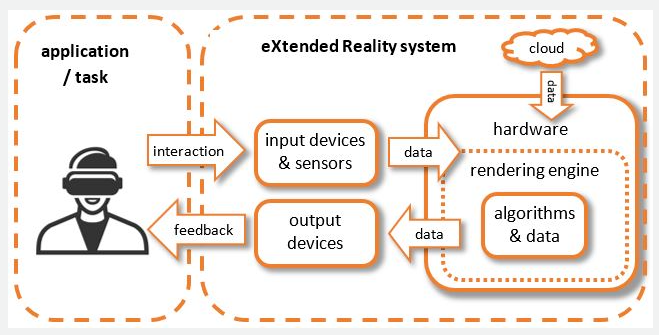

图 2 显示了扩展现实系统的简化示意图。

图 2:XR扩展现实系统的主要组件

应用程序(Application):在左侧,用户正在使用 XR 应用程序执行任务。最新的XR4ALL 景观报告提供了所有相关领域的完整概述,涵盖广告、文化遗产、教育和培训、工业 4.0、健康和医学、安全、新闻、社交 VR 和旅游。

交互(Interaction):用户与场景交互,他/她的交互被一系列输入设备和传感器捕获,可以是视觉、音频、运动和许多其他类型。

处理和渲染(Processing and rendering):获取的数据作为 XR 硬件的输入,在渲染引擎中执行进一步的必要处理。例如,渲染正确的视点或触发与场景的期望交互。在同一份报告中,给出了主要算法和方法的概述。但是,渲染引擎不仅使用捕获的数据,还使用来自其他来源的附加数据,例如边缘云服务器或设备本身可用的 3D 数据。

反馈(Feedback):然后将渲染的场景反馈给用户,让他/她感知场景。这是通过各种方式实现的,例如 XR 耳机或其他类型的显示器和其他感官刺激。

[1] P. Milgram, H. Takemura, A. Utsumi, and F. Kishino, “Augmented Reality: A class of displays on the reality-virtuality continuum”, Proc. SPIE vol. 2351, Telemanipulator and Telepresence Technologies, pp. 2351–34, 1994.

[2] Ronald T. Azuma, “A Survey of Augmented Reality”, Presence: Teleoperators and Virtual Environments, vol. 6, issue 4, pp. 355-385, 1997.

-

XR与AR和VR的区别是什么2024-07-08 10464

-

XR与AR和VR的区别 如何使用人工智能开发更小、更轻的扩展现实眼镜2024-07-05 19865

-

增强现实和扩展现实的区别2023-08-12 3347

-

扩展现实(XR)技术的潜在应用领域——下篇2022-12-17 738

-

扩展现实(XR)技术的潜在应用领域——上篇2022-12-15 3158

-

XR虚拟现实技术的实际应用-下篇2022-10-26 2358

-

浅谈塑造XR未来的三大趋势2022-06-20 3498

-

扩展现实技术的定义、发展历程及未来趋势2022-06-13 4328

-

骁龙XR2平台扩展现实打开新「视」界大门 AI+5G造就无界体验2022-05-18 4149

-

XR(扩展现实)市场可穿戴设备的整体计算解决方案2022-03-29 12633

-

影视娱乐制作商AED Display宣布开展XR(扩展现实)服务2020-09-01 3659

-

如何看待未来的扩展现实XR2020-08-02 1612

-

高通发布全球首款支持5G的扩展现实参考设计 可实现完整的端到端无界XR2020-02-26 2530

-

关于扩展现实专用平台—骁龙XR1的性能评测2018-05-31 6230

全部0条评论

快来发表一下你的评论吧 !