PCI Express在机架中的作用越来越大

描述

PCIe 真的能与以太网和 IB 竞争并取胜吗?工程师应该从了解 PCIe、以太网和 IB 共存的地方以及为什么 PCIe 准备进军其他两个领域中受益。

InfiniBand (IB) 最初被设想为一种统一结构,以取代大多数其他数据中心互连。虽然它没有实现这一目标,但它已经作为一种高速集群互连变得流行,取代了之前一直在使用的专有解决方案。

与 PCI Express (PCIe) 非常相似,IB 自推出以来已经经历了许多不同的速度。初始速度称为单数据速率 (SDR),与 PCIe Gen1 的有效数据速率相同,约为每秒 2 吉比特 (Gbps)。此后,它已增强为 4 Gbps 的双倍数据速率 (DDR)、8 Gbps 的四倍数据速率 (QDR),现在通过 14 数据速率 (FDR) 增强功能提高到 13.64 Gbps。

QDR 在单通道的数据速率方面最接近 PCIe Gen3,并且具有相似的带宽和延迟,基于 PCIe 的结构将能够以相同的数据速率提供与 IB 解决方案相似的性能。除了提供相同级别的性能外,PCIe 还能够使用 IB 不提供的标准单根 I/O 虚拟化 (SR-IOV) 硬件和软件驱动程序提供 I/O 设备共享。IB 主要是一种高速集群技术,因此基于 PCIe 的结构可以实现类似 IB QDR 的性能,并降低等效 IB 解决方案的系统成本和功耗。

当前架构

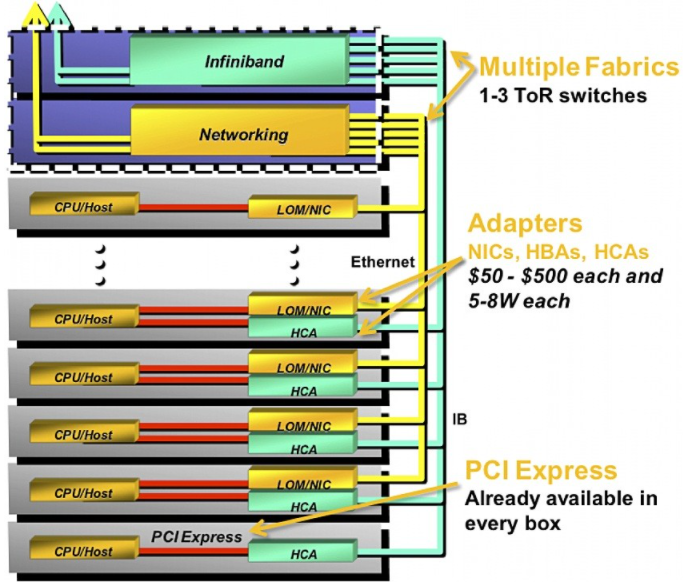

当前大量部署的传统系统有几种需要支持的互连技术。如图 1 所示,除了光纤通道 (FC) 等其他结构外,IB 和以太网还可以作为单个系统中的互连。

图 1:此处显示的是采用 PCI Express、InfiniBand (IB) 和以太网互连技术的传统系统。

这种架构有几个限制:

存在多种 I/O 互连技术

I/O端点利用率低

由于需要多个 I/O 端点而导致高功耗和系统成本

I/O 在构建时固定,以后无法灵活更改

管理软件必须处理具有开销的多个 I/O 协议

使用多种 I/O 互连技术会增加延迟、成本、电路板空间和功耗。如果所有端点都在 100% 的时间内被使用,那么这种架构会有些用处,但是它们通常未被充分利用,这意味着有限的利用率会产生昂贵的开销。延迟增加是因为处理器的原生 PCIe 接口需要转换为多种协议。但是,设计人员可以通过利用相同的本地 PCIe 接口来聚合所有端点来减少此类延迟。

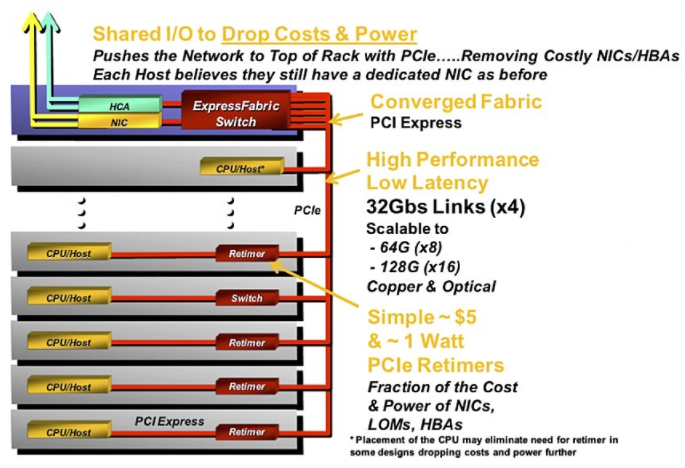

显然,共享 I/O 端点是解决这些限制的方法(图 2)。这一概念吸引了系统设计人员,因为它降低了成本和功耗,提高了性能和利用率,并简化了设计。共享 I/O 的其他优点是:

随着 I/O 速度的提高,唯一需要的额外投资就是更换 I/O 适配卡。在早期部署中,当同一卡上存在多种 I/O 技术时,设计人员必须重新设计整个系统,而在共享 I/O 模型中,当需要升级时,他们可以简单地用新卡替换现有卡。一种特定的 I/O 技术。

由于不需要在同一张卡上存在多个 I/O 端点,设计人员可以制造更小的卡以进一步降低成本和功耗,或者选择保留现有的外形尺寸并通过添加多个 CPU、内存和/ 或通过消除多个 I/O 端点节省的空间中的其他端点。

设计人员可以减少纵横交错系统的电缆数量。随着多种互连技术的出现,需要不同(和多条)电缆来实现带宽和开销协议。然而,随着设计的简化和 I/O 互连技术的范围扩大,系统正常运行所需的电缆数量也减少了,从而消除了设计的复杂性并节省了成本。

图 2:将 PCI Express (PCIe) 用于共享 I/O 的 I/O 系统降低了成本、提高了性能并简化了设计。

在 PCIe 交换机中实现共享 I/O 是图 2 中描绘的架构的关键推动力。SR-IOV 技术在硬件中实现 I/O 虚拟化以提高性能,并利用基于硬件的安全性和 Quality-of-单个物理服务器中的服务 (QoS) 功能。SR-IOV 还允许在同一服务器上运行的多个客户操作系统 (OS) 共享 I/O。

PCIe 通过允许将所有 I/O 适配器(例如,基于 10 Gb 以太网 (GbE)、FC 或 IB)移到服务器外部,提供了一种简化的方法来实现这一点。借助提供虚拟化支持的 PCIe 交换结构,每个适配器可以在多个服务器之间共享,同时为每个服务器提供一个逻辑适配器。服务器或每台服务器上的虚拟机 (VM) 继续可以直接访问共享适配器上它们自己的一组硬件资源。产生的虚拟化允许更好的可扩展性,因为 I/O 和服务器可以相互独立地扩展。这种虚拟化通过避免过度配置服务器或 I/O 资源来降低成本和电力需求。

除了共享 I/O 实现之外,基于 PCIe 的结构增强了基本的 PCIe 功能,包括远程 DMA (RDMA),通过直接从主机应用程序内存复制信息来提供非常低延迟的主机到主机传输,而无需主 CPU 的参与,从而释放 CPU 用于更重要的处理功能。

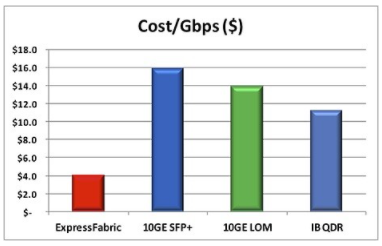

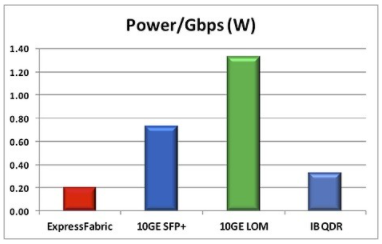

表 1 提供了 PCIe、10 GbE 和 QDR IB 成本比较的高级概述,而表 2 提供了三种互连技术的功率比较。

表 1:与 10 Gb 以太网 (GbE) 和四倍数据速率 (QDR) InfiniBand (IB) 替代方案相比,PCI Express (PCIe) I/O 共享互连架构可节省 50% 以上的成本。

表 2:与 10 Gb 以太网 (GbE) 和四倍数据速率 (QDR) InfiniBand (IB) 替代方案相比,PCI Express (PCIe) I/O 共享互连架构可节省 50% 以上的功耗。

表 1 中的价格估算基于广泛的行业调查,并假设定价会根据架顶式交换机和适配器的数量、可用性和供应商关系而有所不同。这两个表提供了一个框架,用于了解使用 PCIe 进行 I/O 共享的成本和节能,主要是通过消除适配器。

切换到 PCIe

由于多种原因,PCIe 已经主导了主流互连市场:通用可扩展性、高吞吐速度、低开销和广泛部署。PCIe 可以针对不同的带宽要求进行线性扩展,从服务器主板上的 x1 连接到用于高速存储的 x2 连接,再到用于背板的 x4 和 x8 连接,以及用于图形应用程序的 x16 连接。PCIe Gen3 每条链路的双向 8 Gbps 不仅能够支持共享 I/O 和集群,这反过来又为系统设计人员提供了一种无与伦比的工具来优化设计效率,就像 PCIe 的简单、低开销协议一样。最后,PCIe 是一种真正无处不在的技术,几乎系统中的每个设备都至少有一个 PCIe 连接。

本文重点介绍了 PCIe、10 GbE 和 IB QDR 之间的各种比较,特别是在成本和功率要求方面,但建议还考虑这三个行业标准之间的其他技术区别。尽管如此,由于 PCIe 几乎在所有处理器上都是原生的,因此设计人员可以通过消除在 CPU 和 PCIe 开关之间使用额外组件的需要而受益于更低的延迟;使用新一代 CPU,PCIe 开关可以直接放置在 CPU 之外,从而降低延迟和组件成本。

审核编辑:郭婷

-

绝对值编码器用于定位,单方向旋转,位置偏差越来越大是什么原因?2024-01-09 4166

-

LM324调零调好后,改变输入的时候,输出的偏差越来越大,怎么解决?2024-08-28 548

-

为什么PCB文件越来越大?2017-05-08 11053

-

我的四轴调pid幅度越来越大该怎么办?2019-04-04 3108

-

电子设备在汽车中的影响越来越大2019-07-26 2811

-

matlab串口接收数据实时画图延迟为什么越来越大?2020-03-18 5300

-

Vmware虚拟机里的Ubuntu硬盘空间越来越大怎么解决2022-11-22 1676

-

电感不是随频率的变大越来越大吗?2023-04-21 1728

-

电动汽车和混合动力汽车在全球市场中占据越来越大的份额2019-06-11 1526

-

智能音箱厂商们的野心越来越大 市场战争不断加剧2019-11-21 757

-

为什么手机运行内存越来越大?12G到底有没有必要2019-12-21 28990

-

存储需求越来越大,SSD能否取代机械硬盘2020-05-07 1491

-

目前LED显示屏市场变得越来越大,应用越来越广泛2020-08-25 1081

-

光纤滑环的应用需求越来越大2022-05-07 801

-

倒装芯片,挑战越来越大2023-05-23 1295

全部0条评论

快来发表一下你的评论吧 !