CNN结构基本情况

描述

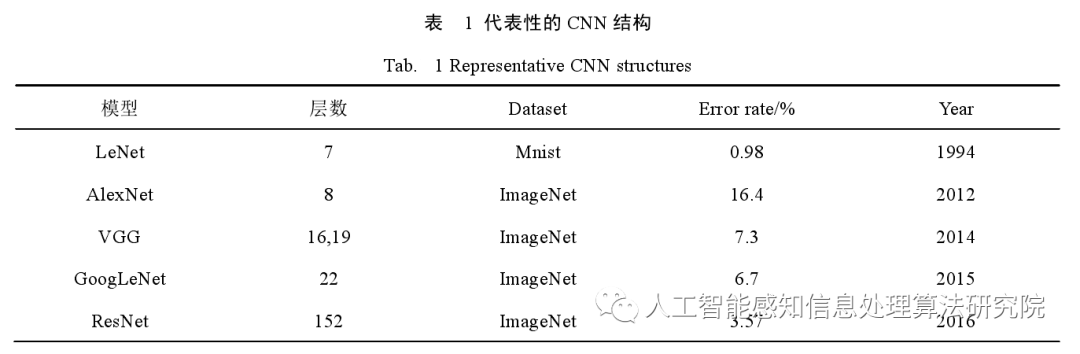

深度学习是机器学习算法研究中新开辟的研究方向,在图像领域的应用是最开始的尝试。近年以来,计算机视觉领域和 CNN 网络结构的不断更新发展,出现了一批代表性的深度卷积神经网络。本章节主要介绍目标检测算法 YOLO 系列借鉴了设计思想的这些框架,分别是:Le Net、Alex Net、VGG、Goog Le Net和 Res Net。表 1 所示,介绍了代表性的 CNN 结构基本情况。

1 LeNet

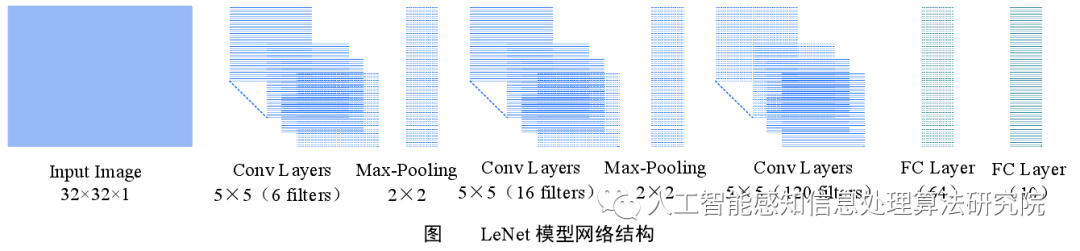

LeNet 卷积神经网络是由深度学习三巨头之一的 Yan Le Cun于 1994 年提出来的。其对构建的 MNIST手写字符数据集进行分类。LeNet 的提出确立了 CNN 的基本网络架构。如下图所示,Le Net 通过输入32 ×32 字符矩阵经过卷积层、下采样层、全连接层进行图像的分类识别。但因为当时硬件技术的局限性和训练数据的不丰富性,Le Net 模型的运算效果并不是特别突出,但此特征网络的提出,为后续 Alex Net 的出现提供了重要的参考。

2 Alex Net

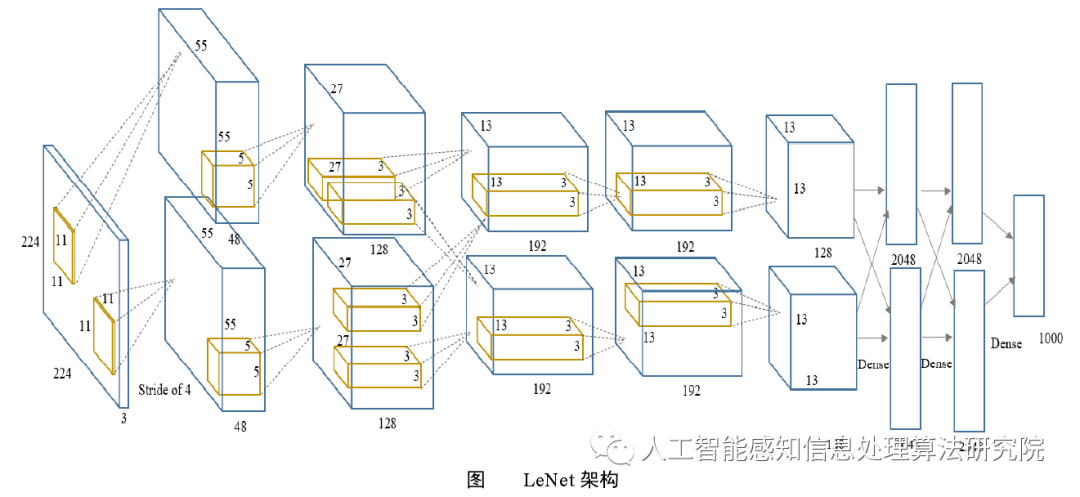

Alex Net的出现,标志着深度卷积神经网络开启了创新的新时代。之前由于硬件技术的局限性,CNN的学习能力、图像分类能力有限,而在 2012 年提出的卷积神经网络 Alex Net 采用了两个 GPU(NVIDIA GTX 580)来训练模型,然后将两个 GPU 上的特征图进行合并,采用的数据集是 Image Net(1500 多万个标记的图像,2.2万个类别),并在2012 ILSVRC大赛以优异的性能在计算机视觉领域展现了自己的实力。如图下图所示,Alex Net 的网络结构包括 5 层卷积、3 层池化和 3 层全连接,特征提取能力得到了提高,对大规模的数据集有更好的拟合能力。并且,在训练阶段,通过在模型随机的添加几个转换单元来确保网络具有较好的鲁棒性。其结构创新的要点为:

(1)使用 Re LU 作为非线性激活函数,减少梯度消失现象,提高收敛率,减少训练时间。

(2)使用大尺寸卷积核(5×5和11×11),提高网络感受野。 (3)加入 Drop Out 层抑制过拟合。 (4)使用数据增强技术,对图像进行训练时,随机的添加平移缩放、裁剪旋转、翻转或增减亮度等操作,产生一系列和输入图像相似但又不相同的数据,从而扩充了训练的数据集。

3 VGG

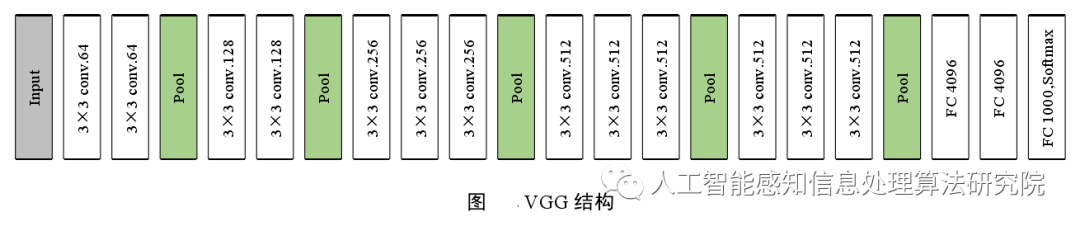

VGG(Visual Geometry Group)多层网络模型,比 Alex Net 和 Zef Net 的深度多了 19 层,验证了在网络结构上增加深度可以直接影响模型性能。VGG 有两种结构,分为 VGG16 和 VGG19,这二者的区别只在于网路深度不同。VGG 的设计思想是增加网络深度,改用小尺寸的卷积核。如下图所示,具体操作为:采用 3 个3×3 卷积核来替换 Alex Net 中的 7×7 卷积核,采用 2 个3×3 卷积核替换5×5卷积核,这样的设计可以在保证具有相同感受野的前提下,增加网络深度,提升模型效果,且改用小的3×3 Filters 可减少模型参数量和运算量,可以更好地保留图像特征信息。具体的改进优点总结为以下几点:

(1)采用3×3 小滤波器替换大尺寸卷积核

(2)替换卷积核后,卷积层的感受野相同

(3)每层卷积操作后通过 Re LU 激活函数和批处理梯度下降训练

(4)验证了增加网络深度,可以提升模型性能 虽然,VGG 在 2014 年因其更深的网络结构和计算低复杂度的优势,使其在图像分类和定位问题上取得了很好地成绩,但它使用了 1.4 亿个参数,计算量很大,这是它的不足之处。

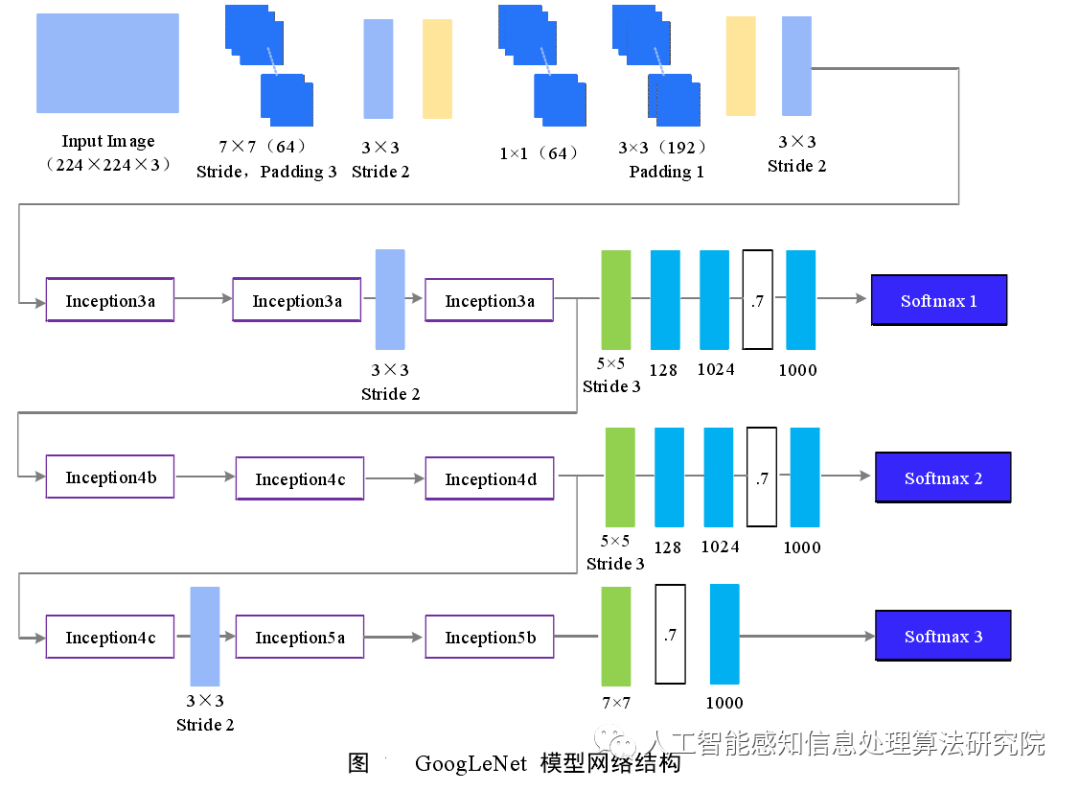

4 Goog Le Net

Goog Le Net是由 Google 提出的,获得了 Image Net 大赛冠军。其架构设计的核心是在保证高水准的精确性 Inception 的目标前提下,降低模型的计算成本。与 VGG 相比,Goog Le Net 是一个网络深度为 22 层的卷积神经网络,它不以传统 CNN 卷积层的串联堆叠为架构基础,而是创新的提出了 Inception 结构,用NIN(Networkin-Network)替换普通卷积层。如下图所示,该结构包含了 5×5 、 3×3 、1×1 滤波器,以便于在不同空间分辨率范围内捕捉通道信息和空间特征,添加一个1×1滤波器,作为 Bottle Neck ,来提高网络的效率,提升模型学习特征的能力。使用平均池化层代替全连接层,将 7×7×1024 的体积降到了 1×1×1024 ,减少了大量的参数。此外,Goog Le Net 还提出了辅助分类器 Soft Max,以加快收敛速度。但 Goog Le Net 也有短板,其表征堵塞会减少下一层的特征空间,反过来又可能会丢失有用的特征。

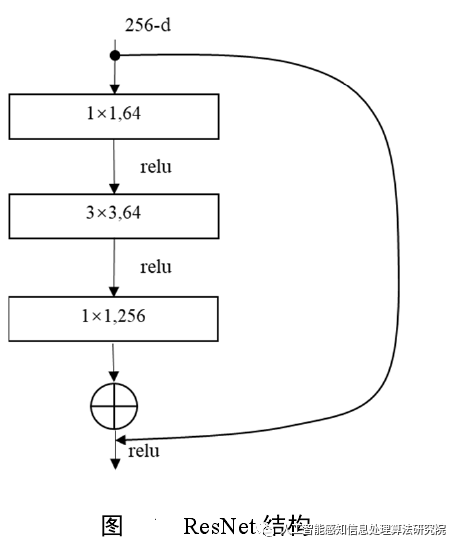

5 Res Net

Res Net(Residual Network)残差网络是 Kaiming He提出来的,并在 2015 ILSVRC 大赛以 3.57%的错误率获得了冠军。在之前的网络中,当模型深度不够,其网络识别能力不强,但当网络堆叠(Plain Network)很深的时候,网络梯度消失和梯度弥散现象明显,导致模型的运算效果却不升反降。因此,鉴于此深层网络的退化问题,Res Net 设计了一个不存在梯度消失问题的超深度网络。Res Net 根据层数的不同,从 18 层到 1202 层,有多种类型。以 Res Net50 为例,它由 49 个卷积层和 1 个全连接层组成,如下图所示。这种简单的加法并不会给网络增加额外的参数和计算量,同时却可以大大增加模型的训练速度、提高训练效果,并且当模型的层数加深时,这个简单的结构能够很好的解决退化问题。Res Net 提出了短径连接,当网络性能已达到最优,继续加深网络,残差映射将被设置为 0,只剩下恒等映射,加速网络收敛,这样就可以使得网络一直处于最优状态了,网络的性能也就不会随着深度增加而降低了。

审核编辑 :李倩

-

深度神经网络模型cnn的基本概念、结构及原理2024-07-02 12202

-

cnn卷积神经网络原理 cnn卷积神经网络的特点是什么2023-08-21 2479

-

一文详解CNN2023-08-18 1099

-

PyTorch教程-14.8。基于区域的 CNN (R-CNN)2023-06-05 1283

-

如何将DS_CNN_S.pb转换为ds_cnn_s.tflite?2023-04-19 456

-

HBM的基本情况2022-07-08 19082

-

如何在嵌入式平台实现CNN2021-12-09 2144

-

从2020年4季度看整车和电池的基本情况2021-01-26 1851

-

2020年车市的基本情况概览2021-01-18 2322

-

大家是怎么压榨CNN模型的2019-05-29 1341

-

TF之CNN:CNN实现mnist数据集预测2018-12-19 3009

-

基于优化CNN结构的交通标志识别算法2017-12-06 1080

-

CNN结构演化进程2017-11-15 3053

全部0条评论

快来发表一下你的评论吧 !