多传感器融合在自动驾驶中扮演的角色

描述

智能网联汽车,与自动驾驶有什么关系?

自动驾驶核心在于车,那智能网联系统又是什么呢?智能网联的载体也是车,但核心是需要连接的网络。一个是汽车内部的传感器和智能控制系统构成的一张网络,另一个是所有汽车连接、共享的网络。网联就是将一台车置身到一张大的网络之中,去交换重要的信息,比如位置、路线、速度等信息。智能网联系统的发展目标就是通过汽车内部传感器和控制系统的设计优化能够改善汽车的安全性和舒适性,使汽车更加人性化,当然终极目标是在实现无人驾驶。

上次说到自动驾驶汽车三大核心辅助系统:环境感知系统、决策与规划系统和控制与执行系统,这也是智能网联汽车车辆本身必须解决的三大关键技术问题。

环境感知系统在智能网联系统里面扮演什么角色?

什么是环境感知技术,主要包含哪些内容?

环境感知主要包括三个方面:传感器、感知和定位。传感器包括摄像头、毫米波雷达、激光雷达以及超声波,不同传感器被安置在车辆上,分别发挥着采集数据,识别颜色、测量距离等作用。

智能汽车要想采用传感器获得的数据去实现智能驾驶,通过传感器获得的数据必须经过(感知)算法处理,汇算成数据结果,实现车、路、人等信息交换,使车辆能够自动分析车辆行驶的安全还是危险状态,让车辆能够按照人的意愿实现智能驾驶,最终替代人来做出决策和无人驾驶目标。

那这里就会有个关键技术问题,不同传感器发挥的作用不同,多个传感器扫描到数据如何形成一个完整的物体图像数据呢?

——多传感器融合技术

摄像头的作用主要是识别物体颜色,但会受阴雨天气的影响;毫米波雷达能够弥补摄像头受阴雨天影响的弊端,能够识别距离比较远的障碍物,比如行人、路障等,但是不能够识别障碍物的具体形状;激光雷达可以弥补毫米波雷达不能识别障碍物具体形状的缺点;超声波雷主要识别车身的近距离障碍物,应用在车辆泊车过程中比较多。要想融合不同传感器的收集到外界数据为控制器执行决策提供依据,就需要经过多传感器融合算法处理形成全景感知。

什么是多传感器融合(融合算法处理),主要有哪些融合算法?

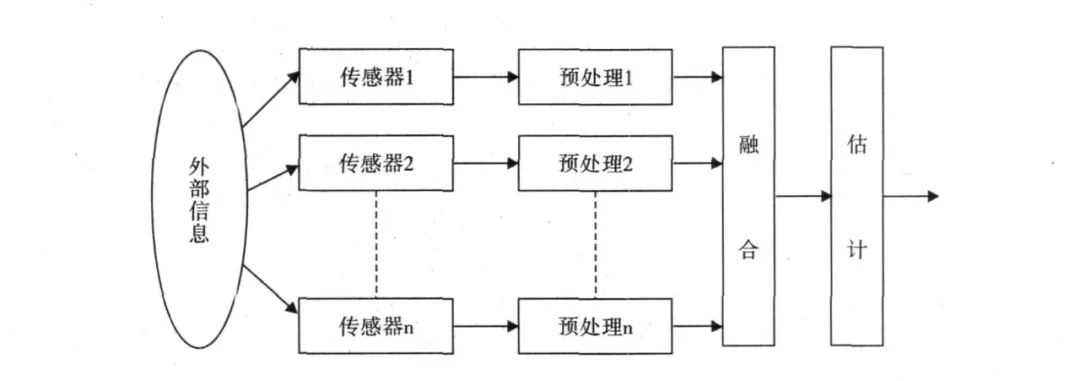

多传感器融合基本原理就像人脑综合处理信息的过程一样,将各种传感器进行多层次、多空间的信息互补和优化组合处理,最终产生对观测环境的一致性解释。在这个过程中要充分利用多源数据进行合理支配与使用,而信息融合的最终目标则是基于各传感器获得的分离观测信息,通过对信息多级别、多方面组合导出更多有用信息。这不仅是利用了多个传感器相互协同操作的优势,而且也综合处理了其它信息源的数据来提高整个传感器系统的智能化。

多传感器数据融合概念最早应用于军事领域,近年来随着自动驾驶的发展,各种雷达运用于车辆做目标的检测。因为不同的传感器都存在数据准确性的问题,那么最终融合的数据该如何判定?比如激光雷达报告前车距离是5m,毫米波雷达报告前车距离是5.5m,摄像头判定前车距离是4m,最终中央处理器该如何判断。那就需要一套多数据融合的算法来解决这个问题。

多传感器融合的常用方法分为两大类:随机和人工智能。AI类主要是模糊逻辑推理和人工神经网络方法;随机类方法主要有贝叶斯滤波、卡尔曼滤波等算法。目前汽车融合感知主要采用随机类融合算法。

自动驾驶汽车融合感知算法课程主要采用卡尔曼滤波算法,利用线性系统状态方程,通过系统输入输出观测数据,对系统状态进行最优估计的算法,它是目前解决绝大部分问题都是最优、效率最高的的方法。

多传感器需要进行融合算法处理,企业相应就会需要融合感知类的算法工程师去解决多传感器融合的问题,融合感知类的绝大多数的岗位要求都是需要能够掌握多种传感器的工作原理及信号的数据特征,能够掌握融合算法进行软件开发以及传感器标定算法能力以及点云数据处理、深度学习检测算法等等。

环境感知的的第三部分内容——定位(slam)

Slam叫做同步定位和制图,是假设场景是静态情况下通过摄像机的运动来获取图像序列并得到场景3-D结构的设计,这是计算机视觉的重要任务,摄像机获得的数据经过算法处理也就是视觉slam。

环境感知定位方法除了视觉slam,还有激光雷达slam、GPS/IMU和高精地图。这些传感器获得的数据都是需要经过算法的处理才能形成数据结果为自动驾驶决策提供位置信息依据。

所以想要从事环境感知方向的工作,不仅可以选择融合感知算法岗位,还可以选择slam方向。选择转岗感知算法类工作也是个不错的选择,专业热门,薪资高,当然入门学习相比运动控制算法工程师课程需要一定的高等数学基础,课程难度中等。

多传感器融合算法,目前不仅仅应用在自动驾驶领域,还应用在机器人领域,对于就业来说是个一大的契机。

审核编辑:郭婷

-

未来已来,多传感器融合感知是自动驾驶破局的关键2024-04-11 2201

-

FPGA在自动驾驶领域有哪些应用?2024-07-29 8174

-

自动驾驶真的会来吗?2016-07-21 14086

-

自动驾驶的到来2017-06-08 7305

-

自动驾驶系列报告大放送了涉及传感器,芯片,执行控制等2019-08-09 3522

-

自动驾驶汽车中传感器的分析2020-05-14 3470

-

这些自动驾驶传感器,你了解多少?2020-05-18 2859

-

汽车传感器融合系统浅析2020-07-31 3029

-

汽车传感器融合系统介绍2020-08-03 1652

-

传感器融合在自动驾驶领域的应用2019-07-27 2382

-

雷达传感器在自动驾驶技术中扮演重要角色2022-04-07 1956

-

传感器融合技术在自动驾驶中的应用2022-06-14 3228

-

自动驾驶汽车的未来趋势:集中式传感器融合2022-11-16 3195

-

自动驾驶“加速”,车载红外热像仪在多传感器融合中的应用2022-08-18 1740

-

多传感器融合在自动驾驶中的应用趋势探究2024-12-05 2135

全部0条评论

快来发表一下你的评论吧 !