衍射极限、MTF与分辨率的分析与介绍

描述

关于衍射极限、MTF以及像素大小的几个问题:

1、已知一个光学系统的F数、光波长,那它的像素大小到达一个什么水平时,算是充分利用了光学系统的分辨率?换句话说,像素最小做到多大合适?

2、镜头设计时一般以lp/mm作为分辨率的指标来衡量MTF,那是否这个值越好,镜头就越好呢?

3、为什么1000多万像素的手机,分辨率反而不如几百万像素的相机?

一、衍射极限与艾里斑

一个理想的光点,通过镜头成像后,哪怕镜头没有任何像差,它也会变成一个光斑。光斑大小与F数有关,F数越小,光斑越小。而更深入一点,就得有一些光学的基础才能理解了,这是由于衍射引起的。简单说来,一个理想的物点发出的光,它的空间频谱是1,就是在各个空间频率均匀分布。而我们用镜头去成像,没办法把所有方向的光收集起来,只能收集镜头大小(严格的说,应该是入瞳大小)对应的这部分。这就不可避免造成了信息的丢失。这也就是衍射的本质。

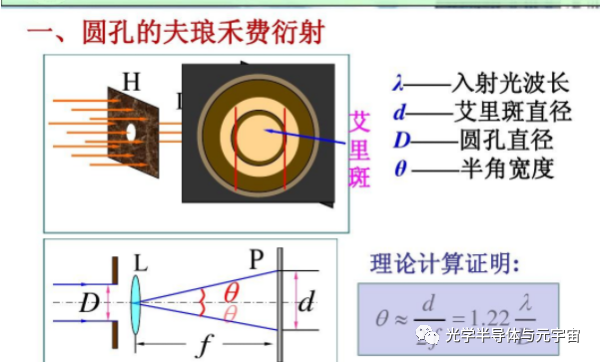

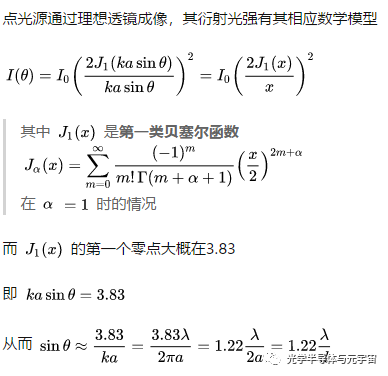

光学镜片的轮廓一般是圆形,而圆孔夫琅禾费衍射的光强分布与[J1(x)/x]^2成正比,J1(x)是一阶贝塞尔函数,x=πDsinθ/λ,J1(x)有无数个零点,前三个为3.832,7.016,10.173。光斑的一级暗环对应J1(x)的第一个零点3.832,即2πsinθ/λ=3.832,也就是sinθ=1.22λ/D时,出现了一级暗环。相应地,后续的每个零点都对应相应的二级暗环,三级暗环……,暗环和暗环之间还有亮环,但能量迅速衰减。一般我们常说的艾里斑,就是中心最亮的这个光斑,即从中心到一级暗环的这个范围。因此也就有了每提艾里斑必提到的1.22λF的这个公式,对照上面的一级暗环角度公式,我们看到/D被换成了F数,二者之间相差一个焦距f。

二、MTF与线对lp/mm

我们知道由于衍射和像差的存在,一个理想的光点,经过光学系统成像以后,将变成一个光斑,这是这个光学系统的点扩散函数h(t)。从空域的角度来看,一幅图像经过光学系统成像以后,由于像差和衍射的存在,肯定会退化,退化成什么样呢?就是每个点都变成了一个光斑,整幅图像就是理想图像与点扩散函数h(t)的卷积。卷积这个变换有点复杂,不太直观,于是人们就想到从频域的角度来考虑问题。因为空域的卷积对应频域的乘积。一幅图像,经过光学系统成像以后,它的频谱变化为在原来的基础上乘了一个函数H(w),H(w)是点扩散函数h(t)的傅里叶变换。H(w)就是传递函数,分为幅值和相位两部分,代表了各个频率的成分,经过光学系统以后,分别受到了不同程度的衰减和相位变化。幅值部分它影响条纹对比度的衰减,而相位部分代表条纹的移动。一般来说,我们只关注成像清晰度,这时幅值传递函数影响比相位传递函数大得多,所以我们只考虑幅值传递函数,就是我们通常说的MTF。

MTF是一个频率域的概念,代表不同频率成分对比度的衰减。就是说你去看一个单一频率的正弦条纹,理想情况下它是黑白条纹相间,反差很好;但实际上由于光学系统的像差和衍射的影响,每个点都会影响它相邻的区域,反差(对比度)会下降。条纹越密,对比度下降越厉害。而衡量这个疏密程度的单位,就是lp/mm,也就是我们常说的每毫米线对。代表每mm范围内,有几个明暗相间的正弦条纹。实际中为了方便,一般用明暗矩形条纹代替正弦条纹,一名一暗两个矩形条纹构成了一个线对。我们测试一个光学系统的MTF,就是测试对不同疏密(lp/mm为单位)的条纹的对比度衰减。为了方便比较,lp/mm通常是指像平面上的线对数。

三、离散采样、像素与线对

像质退化不仅发生在光学系统成像的过程中,还发生在将光学像变成数字化图像的过程中。现代数字设备的图像传感器无非就是CCD和CMOS两种。像素大小和间距都会造成像质的下降。整个系统的MTF是光学系统的MTF与传感器的MTF的乘积。

首先,像素大小会造成对比度的下降。因为一个像素产生的电信号是与它面积范围内光强的平均值成正比的。这就好比在原始连续光学图像上用一个均值滤波器做了一次卷积。这种均值卷积核造成的对比度下降比艾里斑的影响还有过之而无不及。

其次,像素和像素之间的间距形成了离散采样。一幅连续的光学图像,它本来有无穷多个点,现在用一些离散的像素值来表示,难免会造成信息的丢失。Shannon采样定理告诉我们,对于频率为f 的信号,我们至少要用2f的频率来采样,才能把它恢复出来。从前面的叙述,我们知道,空间频率一般是用每毫米线对数来表示的。一个线对就是一个周期,我们至少需要两个像素来采样它。因此,如果一个镜头,它最高可以分辨n lp/mm频率的条纹,那么我们必须保证每毫米有2n个像素才行,这样才能充分利用镜头的分辨能力;反过来,如果我们每mm只有n个像素,那么镜头分辨率做到n/2 lp/mm就可以了,再做高没意义,在离散采样的过程会丢失掉这些高频信息。

四、艾里斑、线对与MTF

是时候把艾里斑和MTF联系起来了。我们来看一看艾里斑对对比度的衰减能达到什么程度。

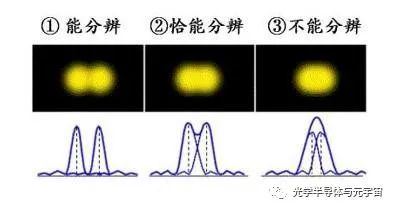

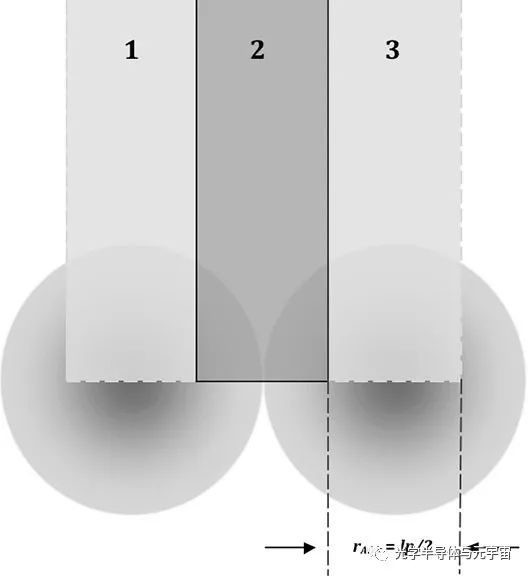

首先来看最经典的一个情形——瑞利判据。瑞利判据是说,当两个相邻的艾里斑距离为其半径时,这两个艾里斑勉强能够分辨出来。

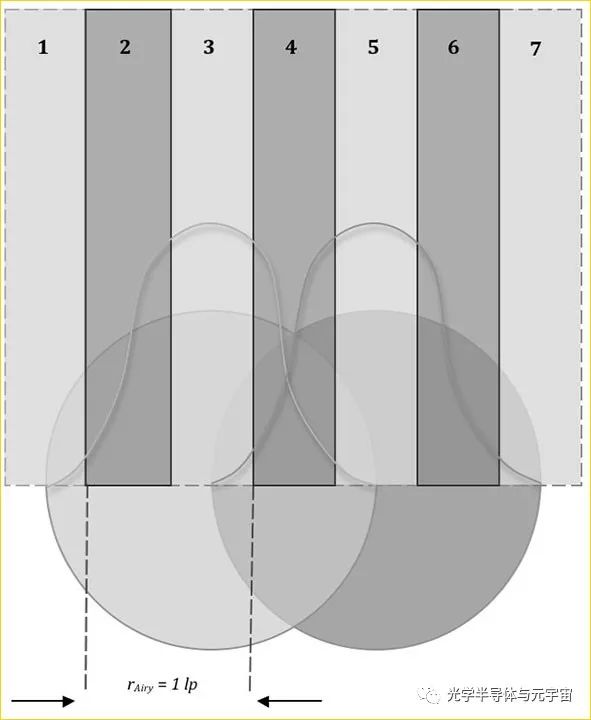

我们看到,从一个艾里斑的中心3到另一个艾里斑的中心5,依次经历了一个从最亮到最暗再到最亮的过程。因此,一个线对(两个像素)的宽度等于艾里斑的半径大小。当然由于它们是这么密,实际上暗部和亮部没差多少,MTF非常差,只有0.09。在这个频率往上,系统是衍射受限的。哪怕没有任何像差,MTF都很差,细节几乎不可分辨。

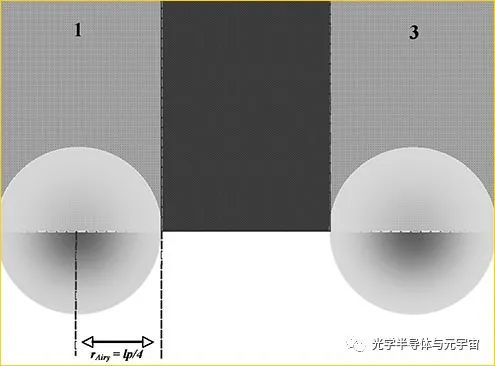

好,我们不要太贪心,条纹太密的话MTF很差,没有意义。我们将空间频率减小一半,让一个线对宽带等于艾里斑直径的大小

可以看到条纹变宽了以后,对比度明显提高了不少(MTF约有50%左右) 频率继续减半,让一个线对宽带等于两个艾里斑直径大小

这个时候,对比度已经很好了(MTF~0.8)。可以说,在这个空间频率之下,系统已经不再是衍射受限了,影响像质的主要是光学系统的像差,只要像差控制得够好,接近理想光学系统,那么MTF可以做得很好。

至此我们可以来回答一下第一个问题。对于一个F数为2.8的镜头,假设我们用555nm的黄绿光来成像,像素大小做到多少合适呢?我们取线对宽度等于艾里斑的直径大小作为依据,此时只考虑衍射的话,MTF约有0.5,也还算可以了。一个线对对应两个像素,那么一个像素大小就相当于艾里斑的半径,也就是1.22λF,算出来约为1.9微米。如果固定传感器大小的话,那么它的像素数就是有上限的。到达一个限度,再增加像素数,就会导致像素小于1.9微米,再增加的像素已经提供不了新的信息了。具体表现,就是我们经常看手机拍的图片时会有的感觉,虽然像素很多,但只能在一个缩放比例以下去看,放大到原始大小来看,像素和像素之间是模糊的,没有细节。

五、线对越多,MTF越高,镜头就越好吗?

现在来说说第二个问题吧。假设有两个镜头,一个到30lp/mm时,MTF就降到了0.5;而另一个直到60 lp/mm时,MTF才降到0.5。那可不可以说后一个镜头好呢?

首先我们来想一下,什么是好镜头呢?从纯技术角度说,就是拍同样的景物,看到的细节比较多的那个镜头比较好喽。那这样看来是不是上面说的后一个镜头比较好呢,因为它MTF好,细节比较多嘛。但我们别忘了还有另一个前提,“拍同样的景物”。是啊,后一个镜头在像面上是能分辨更多的条纹。但如果它视场比较小呢,为了看到同样大小的景物,它就得距离远一点,把景物缩小到感光芯片的范围内。这样一来,换算到物方,谁能看清更多的细节还真不好说。

我们再来说得具体一点吧。假设那个30线对的镜头是一个全幅单反上的,全幅单反的CCD大小为36*24mm,我们假设它的像素大小是1000/30/2=16微米,这样它刚好能充分利用镜头的分辨能力。1mm长度上就有60个像素,那我们的像素数就是36*60*24*60=3.1e6,310万像素;而另一个镜头呢,它是一个手机的镜头模组,我们假设感光CMOS和iPhone5S这么大吧,网上查到它的大小是1/3",大概是4.89*3.67mm。同样假设像素大小刚好够用,1mm长度上120个像素(看了前面的文章,你应该明白再来更多的像素也没有用,镜头分辨力有限),那么它的像素数是4.89*3.67*120*120=0.26e6,26万!!想象一下,比如有一幅画,你用单反去拍(配上前面那个镜头哦),使之刚刚好充满视场,那这幅画会被分成310万个像素;同样的一幅画,你用手机去拍呢,只有26万个像素点。你说谁能看到的细节更多呢?

所以我们可以得出结论了:看一个镜头好不好,不能光看数字,多少线对时MTF是多少,得结合应用场合来看。当然如果两个镜头都用在同样规格的感光芯片上,在同样的线对MTF越高当然就越好了。

六、感光芯片的像素数

你可能不服气,前面两个镜头,MTF曲线都是你随口编的,最后算出来iPhone5S只需要26万像素就够了,简直贻笑大方。实际手机用的镜头,MTF能分辨的线对,比你这个高多了,否则5S为何还要做到8MP(3264*2448)。嗯,好,我们严谨一点,用真实的iPhone5S的数据来计算点东西。

网上查到的iPhone5S数据如下:

镜头:5片塑料镜片,F2.2,焦距4.12mm

感光芯片:大小4.89*3.67mm,像素大小1.5微米,像素数3264*2448。

首先:3264*1.5e-3=4.896,2448*1.5e-3=3.672,和感光芯片大小一致。

镜头的MTF数据查不到,我们就按像素大小来,我们假设镜头保证不拖后腿。那就是1000/2/1.5=333lp/mm。看吧,前面编的数据果然胡扯,和实际情况相差太大了。别急,前面本来就是为了方便比较,随便举的一个例子嘛。我们从另一个角度看,iPhone5S的镜头能分辨到333线对,而一般单反镜头呢,你去看测评报告,都是30lp啊。如果说iPhone5S的5个塑料镜片就比光学厂家辛苦设计的单反镜头好,谁也不信吧。是不是再次证明了前面的那个结论呢。

放眼当今手机界,iPhone5S才800万像素,太少了,简直比山寨机都不如啊。试试帮它把像素数提高点吧。要提高像素数,有两个办法,一个是维持像素大小不变,直接增加像素。这样的话感光芯片大小就会增加,同时镜头大小也有随之增加,整个CMOS模组体积就要变大,不划算。另一个办法就是维持感光芯片大小不变,减小像素尺寸。那样其实对镜头的分辨能力要求就更高了,5片塑料片可能不够。不,我们假设镜头足够好,你尽管减小像素尺寸就行了。像素大小最小能做到1.22λF,假设λ=550nm,那像素大小就是:1.48微米!!!看了iPhone5S已经尽力了。

另外,现在的手机,为了像素做小,F数都做得比较小。这就对镜头像差提出了很高的要求。所以有时光看F数,只计算衍射带来的像质退化是远远不够的。只能说从F数计算出来的最大像素数是一个上限,实际上还应该要打不少折扣的。

审核编辑:郭婷

-

【科普】如何看红外热像仪的分辨率是多少?2018-02-08 7978

-

请问24位的分辨率是否是所有ADC的极限?2018-12-24 5997

-

基于小波多分辨率分析的信号滤波研究2009-04-06 633

-

什么是视频分辨率2009-04-25 7963

-

什么是分辨率2009-05-24 1368

-

打印机分辨率/输出分辨率2009-12-23 3961

-

什么是屏幕分辨率2010-01-23 3805

-

快速设定分辨率2016-04-28 668

-

基于图像超分辨率SR极限学习机ELM的人脸识别2017-12-25 1851

-

分辨率的峰值分辨率和有效分辨率概念2021-10-19 4741

-

如何有效匹配镜头分辨率和相机分辨率?2023-01-07 3805

-

大视场超分辨率高速成像的优势分析2023-08-18 989

-

浅谈相机的图像分辨率2024-01-09 4050

-

镜头分辨率简述2024-01-15 1865

-

光学系统的 MTF 与分辨率之间有什么关系?2024-01-16 3751

全部0条评论

快来发表一下你的评论吧 !