为AI端点应用选择合适的闪存

人工智能

描述

每个人都会同意高质量、高可靠性和低延迟的闪存对于 AI 芯片和应用程序的重要性。为不同的应用找到性能、功耗、安全性、可靠性和高效率之间的适当平衡至关重要。成本虽然很重要,但不应该是最重要的考虑因素。

2016 年 3 月,谷歌的 AlphaGo 在围棋比赛中以 4:1 的优势战胜了 来自韩国的名誉9段棋手李世石,创造了历史。围棋起源于3000多年前的中国,是一种高度复杂的游戏,需要多层战略思维。随后,谷歌的AlphaStar在2018年底的《星际争霸II》中与两位世界顶级游戏玩家较量,最终以两场5:0的比分击败了对手。虽然早在 1997 年,IBM 开发的计算机程序“深蓝”就击败了当时的国际象棋大师加里·卡斯帕罗夫,但考虑到国际象棋的难度远低于围棋,AlphaGo 的胜利在某种程度上被称为“ AI时代的真正到来。

人工智能的起源

从 1955 年到 1956 年,达特茅斯学院的助理教授约翰麦卡锡被公认为人工智能之父。哈佛大学的 Marvin Minsky、IBM 的 Claude Shannon 和美国贝尔实验室的 Nathaniel Rochester 共同创造了人工智能 (AI) 的概念,他说:“如果机器可以使用不同的语言来形成抽象或概念,那么现在就可以解决各种问题为人类保留,并通过自主学习提高自己,我们称之为人工智能。”

牛津词典将人工智能定义为“能够执行通常需要人类智能的任务的计算机系统的理论和开发,例如视觉感知、语音识别、决策和语言之间的翻译。”

随着系统的发展,人工智能技术将应用于更多的物联网应用,如传感、智能手机、网络搜索、人脸或车牌识别、智能电表、工业控制和自动驾驶。

在自动驾驶领域,美国已经进行了 4 级测试(这被认为是完全自动驾驶,尽管人类驾驶员仍然可以请求控制)。5级(真正的自动驾驶,汽车完成所有驾驶,没有驾驶舱)自动驾驶指日可待,我们不仅要依靠交通法规,还要依靠人工智能算法的开发人员来确保车辆和行人的安全。

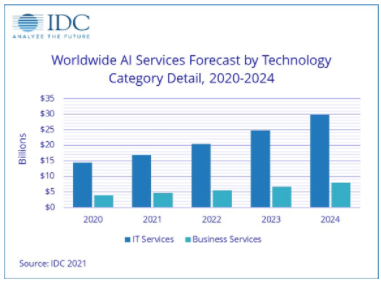

据国际数据公司(IDC)统计,预计到2024年,全球人工智能服务占比将上升至18.4%,市值约为378亿美元。这包括针对定制平台的定制应用程序和相关支持和服务,例如深度学习架构、卷积神经网络(一类人工神经网络,最常用于分析视觉图像)和人工智能相关芯片(CPU、GPU、FPGA ,TPU,ASIC)仅举几例。

IDC 还预测,全球数据存储量将从 2018 年的 33ZB 飙升至 2025 年的 175ZB,其中超过 50% 将来自物联网设备。

考虑到到 2025 年全球将部署约 140 亿台 IoT 设备,我们显着增加云中的计算单元数量和计算能力以应对海量数据增长不是最重要的吗?

好吧,简短的回答是否定的。它没有考虑从端点到云端的数据传输链中的带宽和延迟等真正挑战,这就是“边缘计算”如此迅速兴起的原因。

无需增加带宽和服务器数量即可应对物联网设备的快速增长。最好将应用程序移动到端点设备,这样就无需将所有数据发送到云端进行处理、传输、存储和分析。例如,在工业自动化应用中,数据存储距离影响效率——5G移动设备制造商如果不加强端点人工智能和改革计算存储架构,可能会遇到严重的电池寿命问题。

安全是另一个重要问题,尤其是在万物互联 (IoE) 时代,机密信息、数据泄露或黑客事件屡见不鲜。在边缘进行计算可以最大限度地减少数据在“云-管道-端点”路径中传输的次数,在这种情况下,在确保数据和网络安全的同时降低功耗和系统总拥有成本。

比较人工智能芯片

AI技术分为两类;训练和推理。训练由 CPU、GPU 和 TPU 在云端执行,以不断增加用于构建数据模型的数据库资源。推理依赖于训练好的数据模型,更适合完成边缘设备和特定应用。它通常由ASIC和FPGA芯片处理。

人工智能相关芯片包括 CPU、GPU、FPGA、TPU 和 ASIC。为了了解这些芯片之间的比较,这里重点比较了 5 个关键因素。这些是:

计算

灵活性

兼容性,

力量

成本。

- 中央处理器

CPU开发的计算能力强,软硬件兼容性首屈一指。但是由于冯诺依曼架构的限制,数据需要在内存和处理器之间来回传输。与其他解决方案相比,这限制了平均处理速度以及在功耗和成本方面推动自身发展的能力。

- 图形处理器

由于采用了计算统一设备架构,例如英伟达的 GPU 可以主观地读取内存位置并通过共享虚拟内存来提高计算能力。平均计算能力超过 CPU 数百甚至数千倍。

GPU 发展起来具有良好的软硬件兼容性,但在功耗和成本效率方面需要改进。对硬件(例如额外的冷却系统)的投资对于减少任何热量问题也至关重要。

- ASIC

ASIC 芯片专为特定应用而设计。它们的计算能力、整体功耗和成本效率可以在验证和调整后进行优化。

- FPGA

FPGA的软硬件兼容性值得称道,即使整体计算能力、成本效率和功耗都不是最好的。对于开发者来说,从 FPGA 开始开发 AI 芯片仍然是一个好主意。

突破冯诺依曼建筑的界限

被传统计算设备广泛采用的冯诺依曼架构并没有将计算和存储分开,而是更侧重于计算。处理器和内存之间无休止的数据传输消耗了大约 80% 的时间和功率。学术界已经提出了许多不同的方法来解决这个问题——通过光互连和 2.5D/3D 堆叠实现高带宽数据通信。通过增加高速缓存层的数量和接近数据的存储(例如高密度片上存储)来减少内存访问延迟和功耗。

但是人脑中的计算和存储有什么区别吗?我们是否使用左半球进行计算而右半球用于存储?明显不是。人脑的计算和存储在同一个地方进行,无需数据迁移。

那么,学术界和工业界都渴望找到一种类似于人脑结构的新架构,能够将计算和存储有机地结合起来,也就不足为奇了。解决方案是“计算存储设备”,直接使用存储单元进行计算,或者将计算单元分类,使它们对应不同的存储单元——最大限度地减少数据迁移带来的功耗。

存储行业的一些制造商已经探索了不同的选择。例如,非易失性存储器(NVM)存储数模转换器产生的模拟信号并输出计算能力。同时,输入电压和输出电流在NVM中起到可变电阻的作用,模拟电流信号通过模数转换器转换为数字信号。这样就完成了从数字信号输入到数字信号输出的转换过程。这种做法最大的优势是可以充分利用成熟的20/28nm CMOS工艺,而不是像CPU/GPU那样追求昂贵的7nm/5nm先进工艺。

随着成本和功耗的降低,延迟得到了显着改善,这对于无人机、智能机器人、自动驾驶、安防监控等应用至关重要。

一般来说,端点推理过程的计算复杂度较低,涉及的任务相对固定。硬件加速功能对通用性要求不高,无需频繁更改架构。这更适合内存计算的实现。相关统计显示,2017年之前,人工智能无论是训练还是参考,都是在云端完成的;但到 2023 年,边缘端设备/芯片上的 AI 参考将占据一半以上的市场份额,总计 20-300 亿美元。对于 IC 制造商来说,这是一个巨大的市场。

人工智能需要什么样的闪存?

每个人都会同意高质量、高可靠性和低延迟的闪存对于 AI 芯片和应用程序的重要性。为不同的应用找到性能、功耗、安全性、可靠性和高效率之间的适当平衡至关重要。成本虽然很重要,但不应该是最重要的考虑因素。

审核编辑:郭婷

-

如何选择合适的AI云平台2024-10-14 785

-

怎样选择合适的MOSFET2024-10-01 959

-

为您的应用选择合适的数字电位计2023-11-23 346

-

为正确的工作选择合适的稳压器:组件选择2023-02-21 2880

-

为你的应用选择合适的PMBus负载点 (POL) 解决方案2022-11-04 575

-

为AI端点应用选择合适的闪存2022-10-25 548

-

为应用选择合适的射频放大器指南2022-04-14 7616

-

请问怎么为ADC选择合适的缓冲放大器?2021-04-21 2233

-

如何为系统选择合适的NAND闪存2021-02-22 2358

-

平面分割应如何选择合适的方法?2019-05-20 3321

-

怎么为电机控制应用选择合适检测电阻2019-05-17 2086

-

灵活地为汽车选择合适的闪存解决方案2017-09-28 11406

-

为开关电源选择合适的电感2016-09-13 732

全部0条评论

快来发表一下你的评论吧 !